OpenCV中矩阵的归一化

原帖地址:http://windrocblog.sinaapp.com/?p=486

图像处理中,图片像素点单通道值一般是[0-255]的unsigned char类型,将其转化到[0,1]之间,更方便计算,这就需要用到矩阵的归一化运算。

今天,写程序中需要对某矩阵归一化,用OpenCV的cv::normalize函数,遇到很严重的问题,最后发现,normalize的原矩阵必须是单通道(src.channel==1),函数执行完,结果矩阵的大小和类型与原矩阵相同。无论之前是否初始化结果矩阵,最后的结果都与原矩阵类型相同。

函数原型:

void normalize(const InputArray src, OutputArray dst, double alpha=1, double beta=0,

int normType=NORM_L2, int rtype=-1, InputArray mask=noArray())

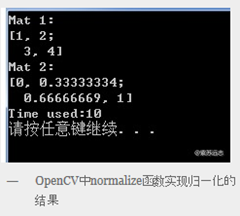

当用于归一化时,normType应该为cv::NORM_MINMAX,alpha为归一化后的最大值,beta为归一化后的最小值。参看下面的例子:

cv::Mat mat1=Mat(2,2,CV_32FC1);

mat1.at<float>(0,0) = 1.0f;

mat1.at<float>(0,1) = 2.0f;

mat1.at<float>(1,0) = 3.0f;

mat1.at<float>(1,1) = 4.0f;

// 对于这种小矩阵,还有更简单的赋值方式,找时间再改

cout<<"Mat 1:"<<endl;

cout<<mat1<<endl;

normalize(mat1,mat1,1.0,0.0,NORM_MINMAX);

cout<<"Mat 2:"<<endl;

cout<<mat1<<endl;

显示的结果如下图所示:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 单元测试从入门到精通

· 上周热点回顾(3.3-3.9)

· Vue3状态管理终极指南:Pinia保姆级教程