寒假打卡4

今天配置了ssh免密登录以及xsync分发脚本,并且配置了集群以及群起集群。

群起:

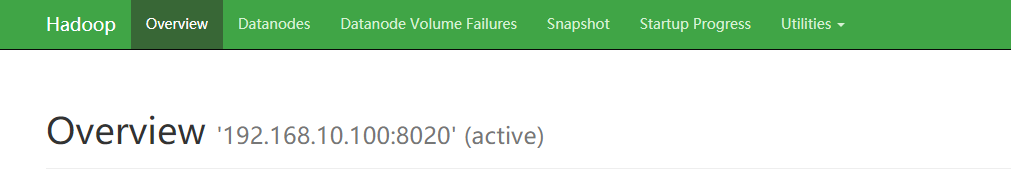

我的三台虚拟机分别为192.168.10.100,192.168.10.102,192.168.10.103

192.168.10.100:sbin/start-dfs.sh

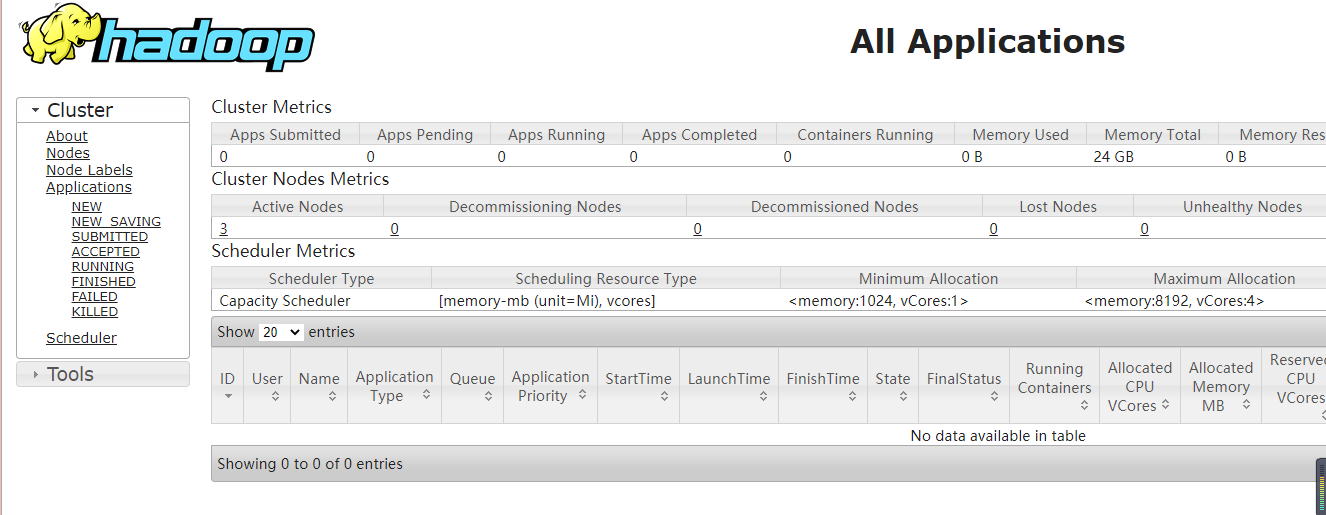

192.168.10.102:sbin/start-yarn.sh

以上两条语句需在hadoop目录下运行

同时也通过终端上传了文件到hadoop上

创建文件夹:hadoop fs -mkdir /input

上传语句:hadoop fs -put wcinput/word.txt /input

hdfs数据存储目录:/opt/module/hadoop-3.1.3/data/dfs/data/current/BP-2033209374-192.168.10.100-1645262148166/current/finalized/subdir0/subdir0

查看命令:cat

执行wordcount程序:hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output

浙公网安备 33010602011771号

浙公网安备 33010602011771号