【一周聚焦】联邦学习 10.9-10.16

近期的联邦学习做了如下内容:

大模型

目前大模型是绝对的研究风口,而FL中为了降低传输开销的网络压缩技术也是可以服务于LLM的高效传输的。

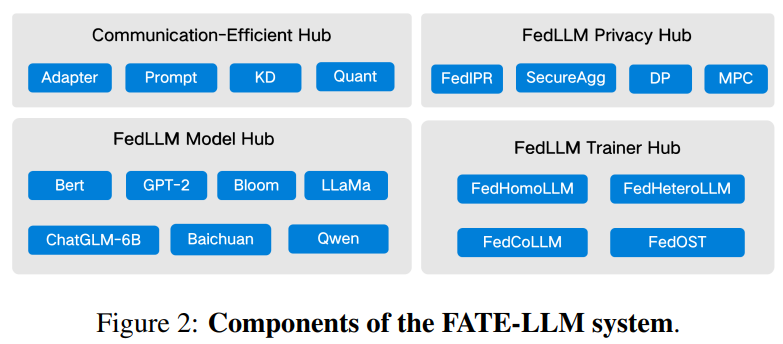

港科大+微众银行,10月16,FATE-LLM: A Industrial Grade Federated Learning Framework for Large Language Models

杨强团队一直在推FATE这个联邦学习框架,现在踩着大模型的风口在做基于微调的大模型。唯一的亮点就是各种常见方法真的集成得很全面,包括communication-efficient,LLM模型及训练方法、privacy部分都有照顾到,是比较大的工作量。

当然整个实验还是处于比较初级的阶段,比如实验上,只有2个用户参与联邦学习,FL的迭代轮次也只有5次。这导致训练效果只比单独用户用本地训练好一些,比不过数据集中式的训练。

这个方向比较大的问题还是在于当前数据分配情况是否满足需求。本地的计算能力如果不足的话可以用云计算来代替,甚至在云上汇总。但是对于不同用户上相差极大的数据,LLM的鲁棒性是否真的够用,是需要进一步看的。

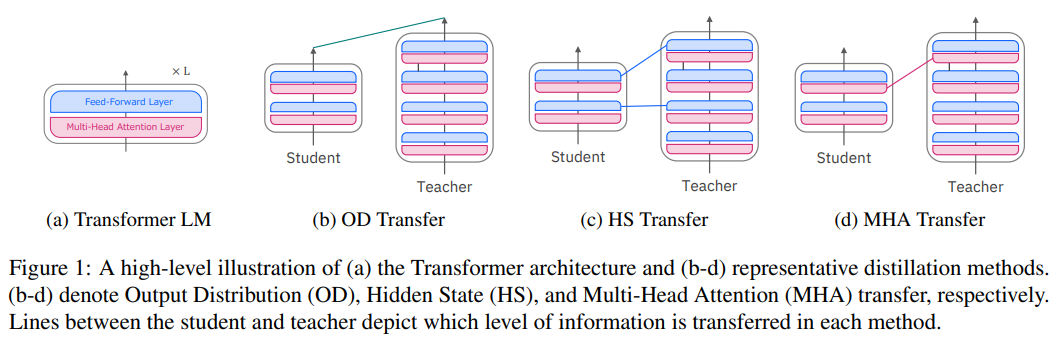

IBM,10月13日,A Comparative Analysis of Task-Agnostic Distillation Methods for Compressing Transformer Language Models

其实这个不完全属于FL,主要对比了在大模型做知识提取的时候,不同方法的效果如何。

Bosch AI中心,10月9日,TEXT-DRIVEN PROMPT GENERATION FOR VISION-LANGUAGE MODELS IN FEDERATED LEARNING

这种应该是FL+LLM的比较正确的研究思路,而不仅仅是应用。逐渐聚焦的思路是,Visual-Language Model Prompt Learning→Federated Learning with Visual-Language Models

Prompt learning的含义:找到合适的prompt来指导大模型的训练。

为什么要有prompt:用于解决训练样本不足的问题,相当于在LLM的训练过程中就把目标任务囊括进去了。比如要做句子的分类问题,可以直接用监督学习来做,但是需要大量的标签样本。需要大量的样本的一个原因是,训练的时候用了mask作为token进行预训练,但是下游任务并没有这个token,导致需要大量数据来填平这个gap。那如果能在下游任务中引入mask这个token就好了,而通过prompt来实现就是一种方法。通过设计prompt,将需要判决的标签作为预训练时mask的内容,这样就能在训练过程中学到判决的知识。

个性化

西电,10月13,PAGE: Equilibrate Personalization and Generalization in

Federated Learning

将用户个性化与服务器泛化性的博弈建模为MDP问题,用强化学习求解,学习准确度从 35.20%提升到了39.91%。实验用的还是大模型与大数据集。

浙公网安备 33010602011771号

浙公网安备 33010602011771号