使用python制作大数据词云

1 from wordcloud import WordCloud 2 import PIL.Image as image 3 import numpy as np 4 import jieba 5 6 7 # 分词 8 def trans_CN(text): 9 # 接收分词的字符串 10 word_list = jieba.cut(text) 11 # 分词后在单独个体之间加上空格 12 result = " ".join(word_list) 13 return result 14 15 16 with open(r'C:\Users\SAMSUNG\Desktop\101.txt',encoding='UTF-8') as fp:#填写你的文本文件地址 17 text = fp.read() 18 # print(text) 19 # 将读取的中文文档进行分词 20 text = trans_CN(text) 21 mask = np.array(image.open(r'C:\Users\SAMSUNG\Desktop\131422.jpg'))#放入想要生成的图片模板 22 wordcloud = WordCloud( 23 background_color='#FFFFFF', # 指定背景颜色,这里用的是颜色代码 24 # 添加遮罩层 25 mask=mask, 26 # 生成中文字的字体,必须要加,不然看不到中文 27 font_path="C:\Windows\Fonts\STXINGKA.TTF" 28 ).generate(text) 29 image_produce = wordcloud.to_image() 30 image_produce.show() 31 wordcloud.to_file('lyxb6.jpg') # 保存到图片默认保存到python文件目录下,不保存的话生成的图没有办法另存为哦。

导入的模板图:

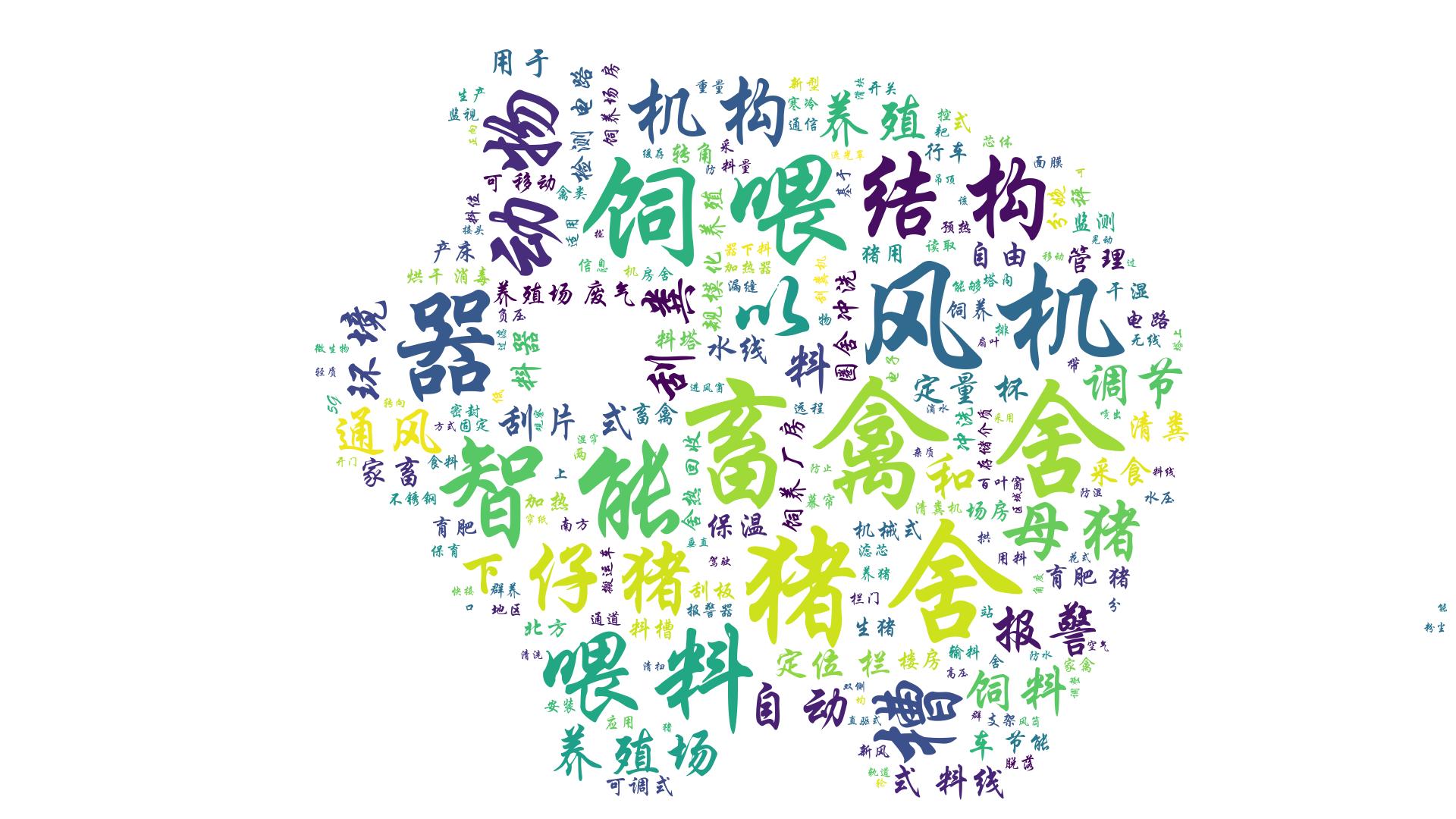

效果:

再整理文本的时候需要根据特定的词语筛查删掉一些不关键的词语:比如 一个、系统、装置、设备、的、这些不能体现你要分析的数据的名词,以及谓语。这样你的图会更有观赏性。

浙公网安备 33010602011771号

浙公网安备 33010602011771号