docker容器虚拟化与网络

虚拟化网络

Network Namespace 是 Linux 内核提供的功能,是实现网络虚拟化的重要功能,它能创建多个隔离的网络空间,它们有独自网络栈信息。不管是虚拟机还是容器,运行的时候仿佛自己都在独立的网络中。而且不同Network Namespace的资源相互不可见,彼此之间无法通信。

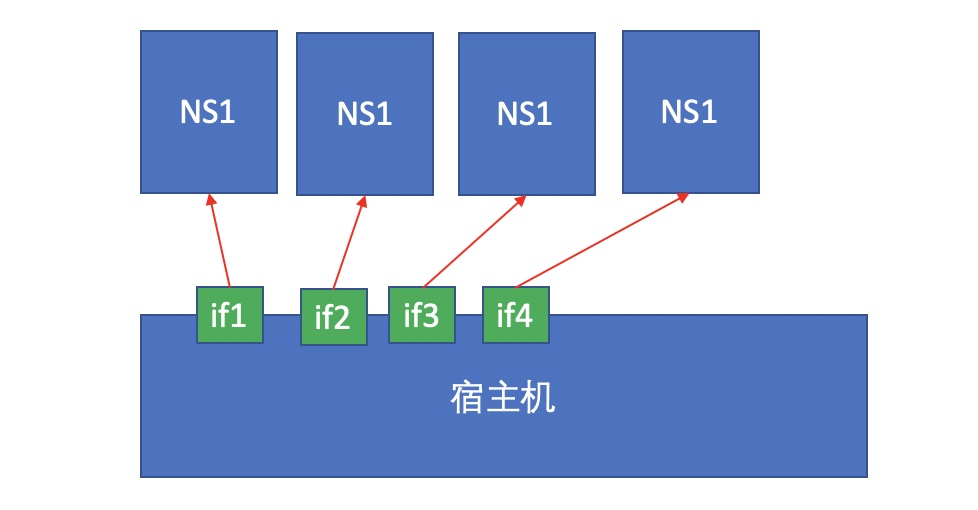

假如我们的物理机有4块物理网卡,我们要创建4个名称空间,而这些设备是可以单独关联至某个单独的名称空间使用的

如上图所示,把第一块网卡分配给第一个名称空间,第二块分给第二个名称空间,第三块分给第三个名称空间,第四块分给第四个名称空间。此时其它名称空间都是看不见当前所在名称空间的,因为一个设备只能属于一个名称空间。

这种方式使得每一个名称空间都能配置IP地址,并且与外部网络直接通信,因为它们使用的是物理网卡。

但如果我们所拥有的名称空间数量超过物理网卡数量呢?此时我们可以使用虚拟网卡设备,用纯软件的方式来模拟一组设备来使用。Linux内核级支持2种级别设备的模拟,一种是二层设备,一种是三层设备。

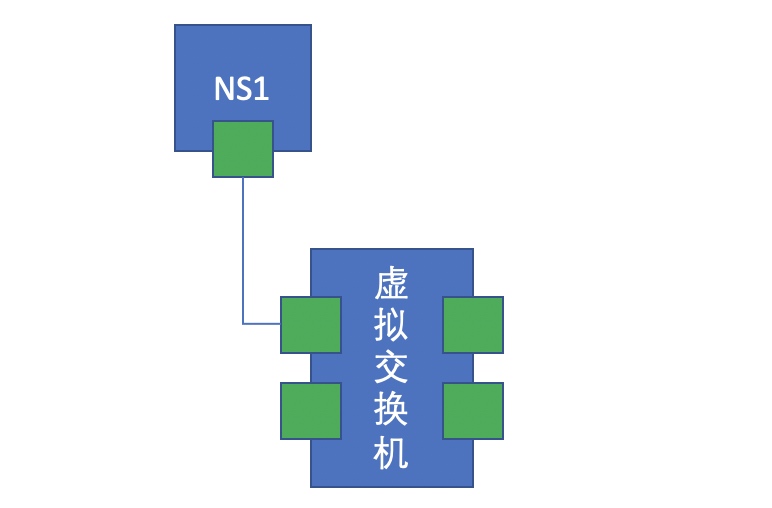

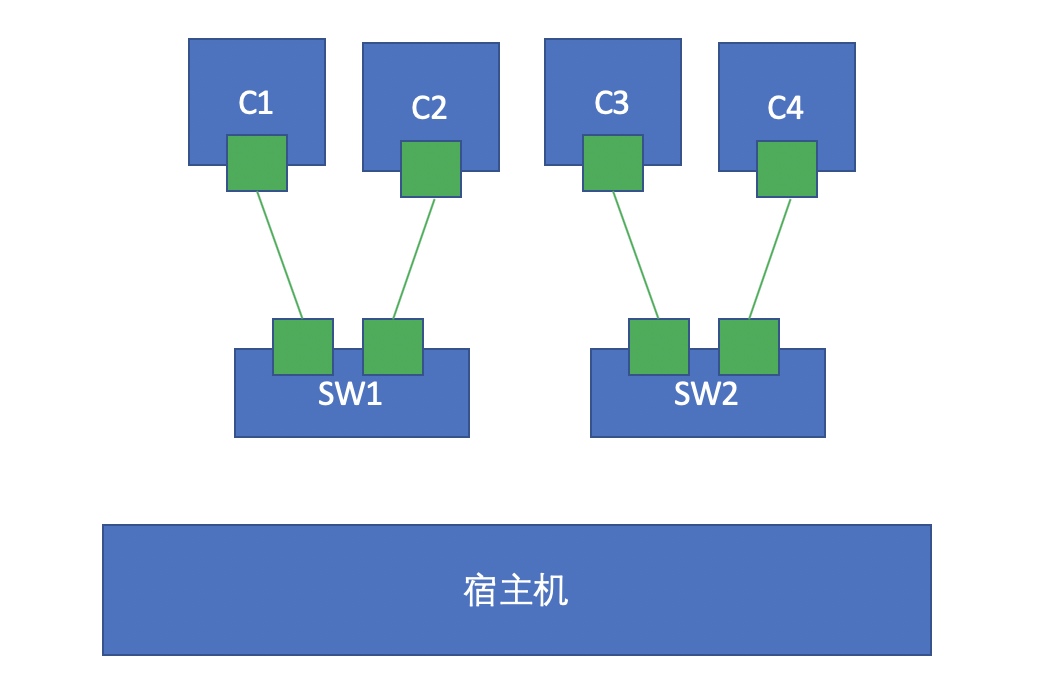

Linux内核模拟的二层设备,每个网络接口设备是成对出现的,可以模拟为一根网线的两端,其中一端模拟主机的虚拟网卡,另一端模拟虚拟交换机,就相当于让一个主机连到一个交换机上去。Linux内核原生支持二层虚拟网桥设备,即用软件虚拟交换机的功能。如下图所示:

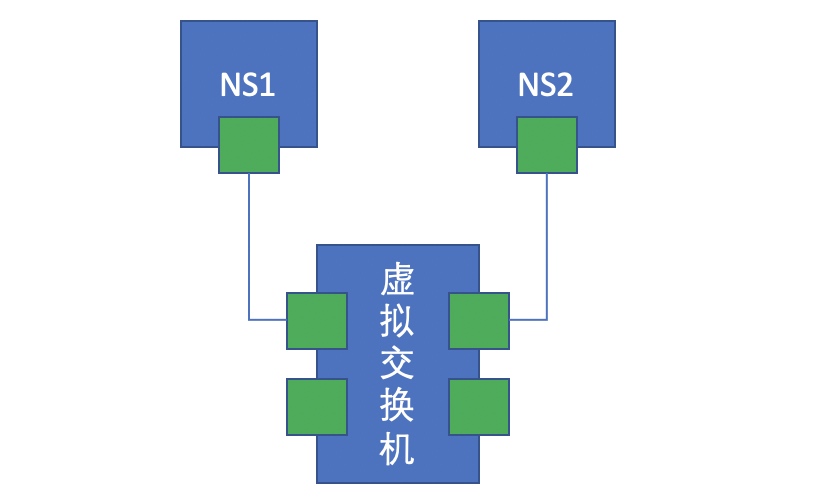

那么此时如果再有一个名称空间,它有创建了一对虚拟网卡,一端连接名称空间,一端连接虚拟交换机,此时就相当于两个名称空间连接到了同一个交换机网络中,此时如果两个名称空间的网卡地址配置在同一网段,那么很显然他们之间是可以互相通信的。

如下图所示:

从网络通信的物理设备到网卡都是用纯软件的方式来实现,这种实现方式就叫做虚拟化网络。

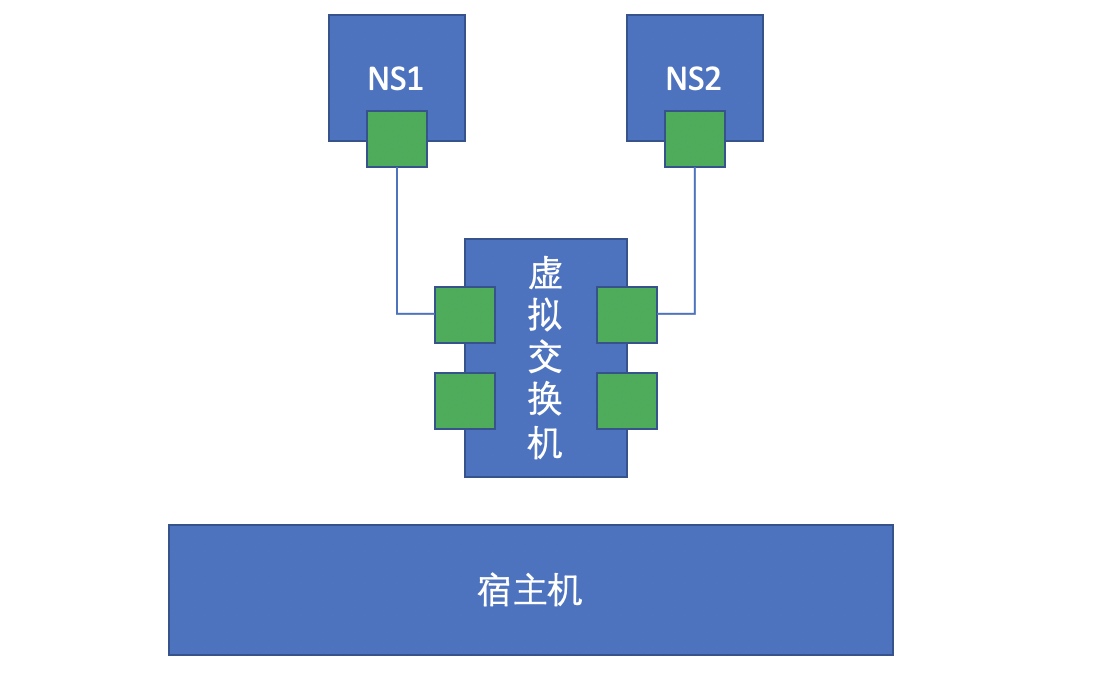

单节点容器间通信

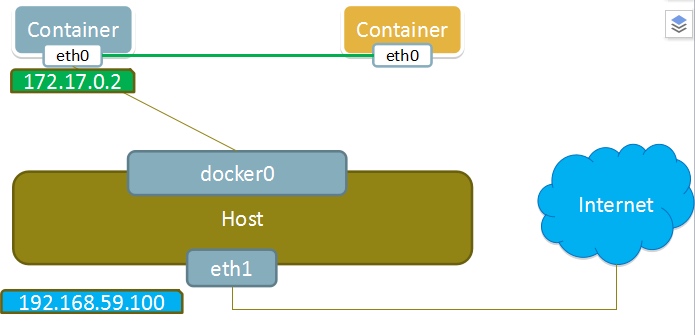

如果在同一个物理机上的两个容器想通信,我们的办法就是在这台主机上建立一个虚拟交换机,而后让两个容器各自用纯软件的方式创建一对虚拟网卡,一半在容器上,一半在虚拟交换机上,从而实现通信。如下图所示:

[root@Raygussie ~]# docker run -it --rm busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

4: eth0@if5: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue //容器网卡为IF5

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

//启动另一个终端查看IP

[root@Raygussie ~]# ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

。。。。。。

vetheb91702@if4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default //主机里的为if4

//因为4和5是一对,所以在真机上能ping通

[root@Raygussie ~]# ping 172.17.0.2

PING 172.17.0.2 (172.17.0.2) 56(84) bytes of data.

64 bytes from 172.17.0.2: icmp_seq=1 ttl=64 time=0.066 ms

64 bytes from 172.17.0.2: icmp_seq=2 ttl=64 time=0.046 ms

64 bytes from 172.17.0.2: icmp_seq=3 ttl=64 time=0.086 ms

64 bytes from 172.17.0.2: icmp_seq=4 ttl=64 time=0.085 ms

64 bytes from 172.17.0.2: icmp_seq=5 ttl=64 time=0.085 ms

64 bytes from 172.17.0.2: icmp_seq=6 ttl=64 time=0.087 ms

^C

--- 172.17.0.2 ping statistics ---

6 packets transmitted, 6 received, 0% packet loss, time 108ms

rtt min/avg/max/mdev = 0.046/0.075/0.087/0.018 ms

[root@Raygussie ~]#

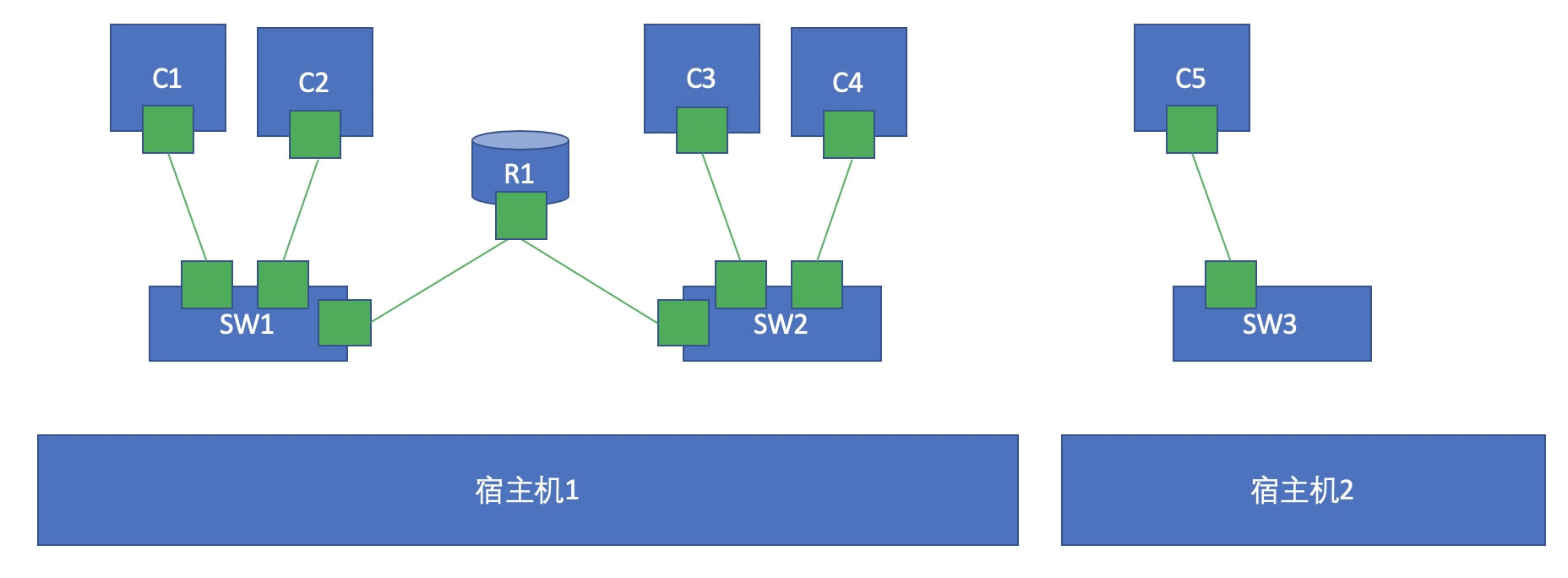

这就是单节点上两个容器间的通信方式。单节点上两个容器之间的通信也有一些复杂情况,比如我们期望构建的容器要跨交换机通信呢?

我们做两个虚拟交换机,两个交换机上各自连接不同的容器,如上图所示,此时如果要C1和C3通信又该如何实现呢?其实我们可以通过名称空间创建一对网卡,一端连SW1,另一端连SW2,这样一来两个交换机就连起来了,照理说这样一来C1和C3这两个处于不同交换机的容器就可以实现通信了,但是这样一来又存在另一个问题,那就是如果C1和C3在不同网络呢?如果不在同一网络我们就必须要通过路由转发才能使其通信,也就是我们得在两台交换机之间加一个路由器,其实Linux内核本身就是支持路由转发的,只需要我们将路由转发功能打开即可。此时我们可以再启动一个容器,这个容器里面就跑一个内核,并将其转发功能打开,这样一来就模拟了一台路由器,通过这台路由器来实现路由转发。

不同节点容器间通信

//另起一个终端,网卡为if7

[root@Raygussie ~]# docker run -it --rm busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

6: eth0@if7: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:03 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.3/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

//第二个终端生成了一个if6

[root@Raygussie ~]# ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens160: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP group default qlen 1000

link/ether 00:0c:29:d4:5d:1d brd ff:ff:ff:ff:ff:ff

inet 192.168.186.130/24 brd 192.168.186.255 scope global dynamic noprefixroute ens160

valid_lft 951sec preferred_lft 951sec

inet6 fe80::9102:9b4e:7d85:d875/64 scope link noprefixroute

valid_lft forever preferred_lft forever

3: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default

link/ether 02:42:be:f9:51:96 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:beff:fef9:5196/64 scope link

valid_lft forever preferred_lft forever

5: vetheb91702@if4: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default

link/ether 92:35:8b:b6:66:fe brd ff:ff:ff:ff:ff:ff link-netnsid 0

inet6 fe80::9035:8bff:feb6:66fe/64 scope link

valid_lft forever preferred_lft forever

//生成了if6

7: vethef87b1f@if6: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue master docker0 state UP group default

link/ether 26:00:df:19:a2:7f brd ff:ff:ff:ff:ff:ff link-netnsid 1

inet6 fe80::2400:dfff:fe19:a27f/64 scope link

valid_lft forever preferred_lft forever

//创建了新容器,就自动生成一对临时网卡,一个在容器里,一个在真机里

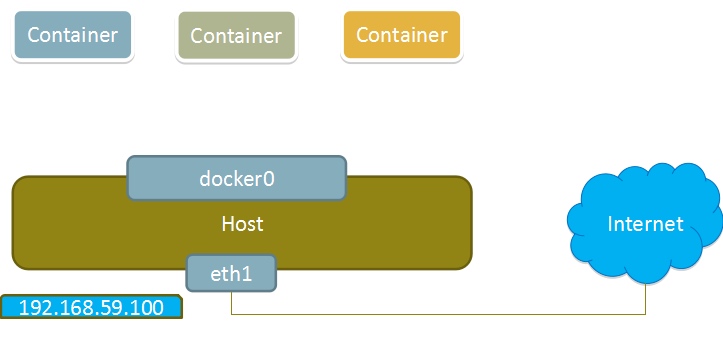

如上图所示,此时如果C1要与C5进行通信又该如何实现呢?如果我们采用桥接的方式,很容易产生广播风暴,因此,在大规模的虚拟机或容器的场景中,使用桥接的方式无疑是自取灭亡,所以我们不应该使用桥接的方式来实现通信。

如果一来,我们既不能桥接,又需要与外部来实现通信,那就只能使用NAT技术了。通过DNAT将容器的端口暴露到宿主机上,通过访问宿主机的端口来实现访问容器内部的目的,而在请求端我们需要做SNAT将数据包通过宿主机的真实网卡转发出去。但这样做的话,因为要进行两次NAT转换,所以效率会比较低。

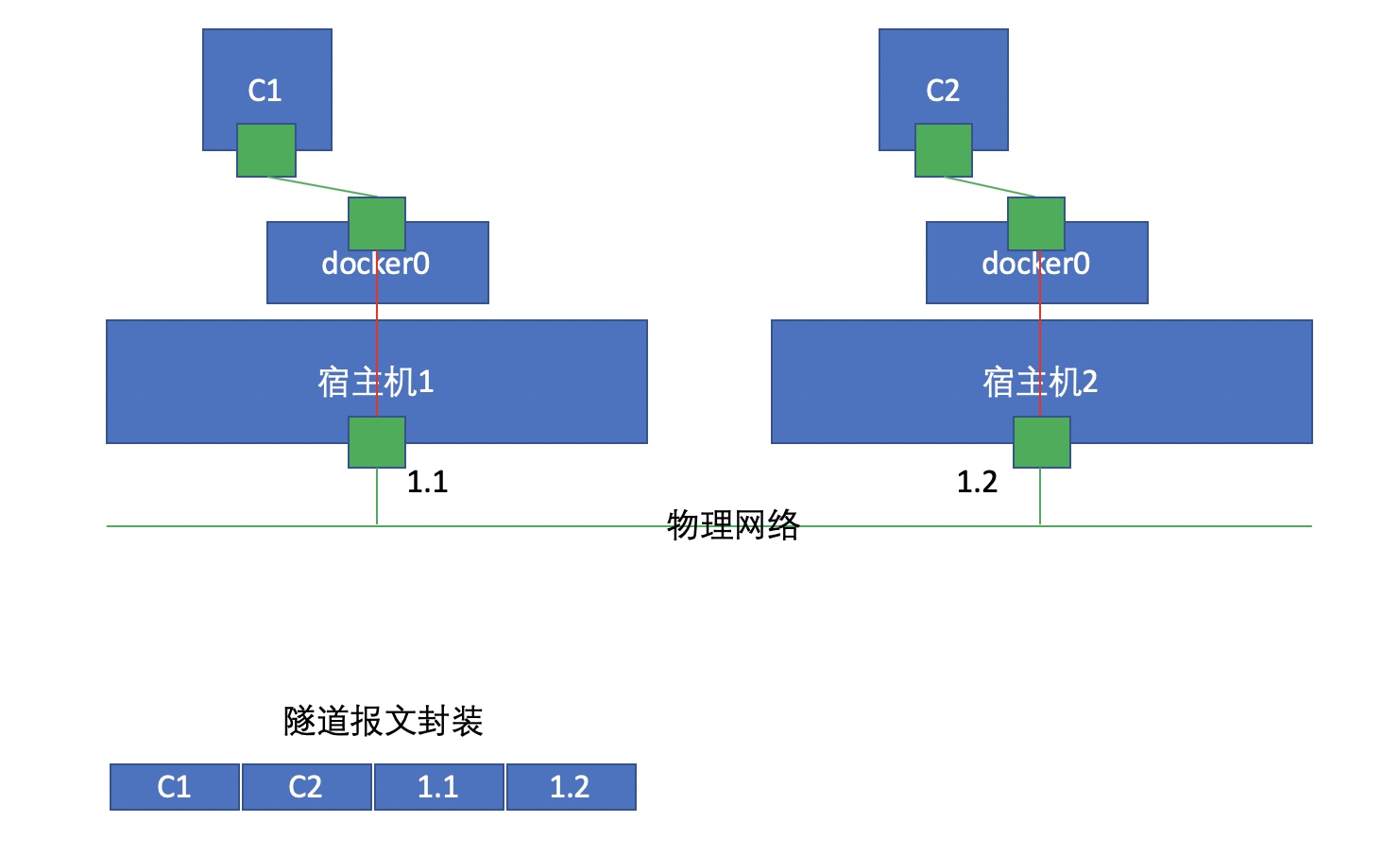

此时我们可以采用一种叫做Overlay Network(叠加网络)的技术来实现不同节点间容器的相互通信功能。

[root@Raygussie ~]# ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens160: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq state UP group default qlen 1000

link/ether 00:0c:29:d4:5d:1d brd ff:ff:ff:ff:ff:ff

inet 192.168.186.130/24 brd 192.168.186.255 scope global dynamic noprefixroute ens160

valid_lft 1284sec preferred_lft 1284sec

inet6 fe80::9102:9b4e:7d85:d875/64 scope link noprefixroute

valid_lft forever preferred_lft forever

//docker0网桥自容器启动就一直存在,容器关闭后都一直存在

3: docker0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default

link/ether 02:42:be:f9:51:96 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:beff:fef9:5196/64 scope link

valid_lft forever preferred_lft forever

Overlay Network会将报文进行隧道转发,也就是在报文发出去之前要为其添加一个IP首部,也就是上图的1.1和1.2这部分,这里的1.1是源,1.2是目标,当宿主机2收到报文后解封装发现要找的目标容器是C2,于是把包转发给C2。

docker容器网络

Docker在安装后自动提供3种网络,可以使用docker network ls命令查看

[root@Raygussie ~]# docker network ls

NETWORK ID NAME DRIVER SCOPE

fca305fef9a8 bridge bridge local

e0efc35096d6 host host local

86656db36f8f none null local

Docker使用Linux桥接,在宿主机虚拟一个Docker容器网桥(docker0),Docker启动一个容器时会根据Docker网桥的网段分配给容器一个IP地址,称为Container-IP,同时Docker网桥是每个容器的默认网关。因为在同一宿主机内的容器都接入同一个网桥,这样容器之间就能够通过容器的Container-IP直接通信。

//两个容器与真机的网关相同

[root@Raygussie ~]# docker run -it --rm busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

8: eth0@if9: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

——————————————————————————————————————————————————————————————————

[root@Raygussie ~]# docker run -it --rm busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

10: eth0@if11: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:03 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.3/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ # route -n

Kernel IP routing table

Destination Gateway Genmask Flags Metric Ref Use Iface

0.0.0.0 172.17.0.1 0.0.0.0 UG 0 0 0 eth0

172.17.0.0 0.0.0.0 255.255.0.0 U 0 0 0 eth0

/ #

//容器就能ping通另一个容器与真机

[root@Raygussie ~]# docker run -it --rm busybox

/ # ping 172.17.0.1

PING 172.17.0.1 (172.17.0.1): 56 data bytes

64 bytes from 172.17.0.1: seq=0 ttl=64 time=0.120 ms

64 bytes from 172.17.0.1: seq=1 ttl=64 time=0.068 ms

64 bytes from 172.17.0.1: seq=2 ttl=64 time=0.147 ms

^C

--- 172.17.0.1 ping statistics ---

3 packets transmitted, 3 packets received, 0% packet loss

round-trip min/avg/max = 0.068/0.111/0.147 ms

/ # ping 172.17.0.2

PING 172.17.0.2 (172.17.0.2): 56 data bytes

64 bytes from 172.17.0.2: seq=0 ttl=64 time=0.118 ms

64 bytes from 172.17.0.2: seq=1 ttl=64 time=0.146 ms

64 bytes from 172.17.0.2: seq=2 ttl=64 time=0.138 ms

^C

--- 172.17.0.2 ping statistics ---

3 packets transmitted, 3 packets received, 0% packet loss

round-trip min/avg/max = 0.118/0.134/0.146 ms

/ #

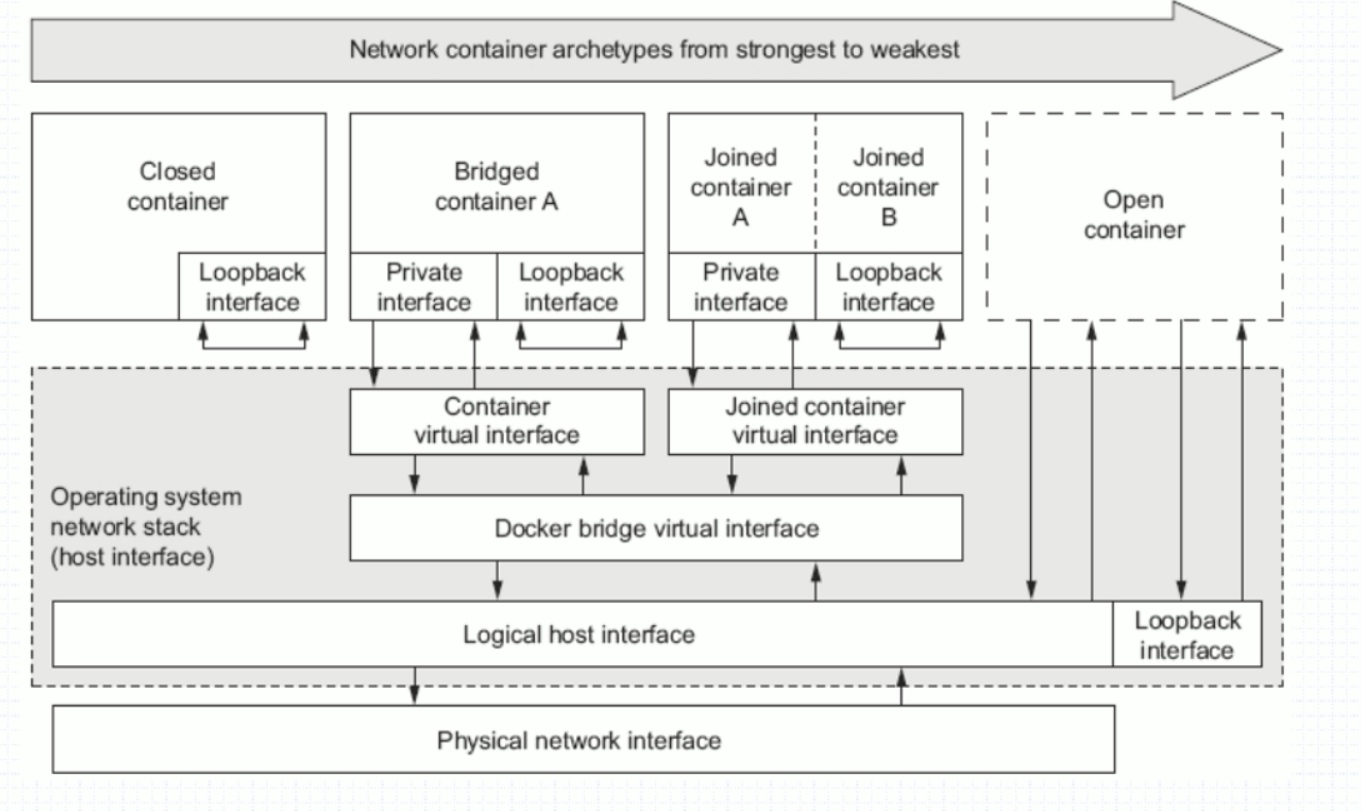

docker的4种网络模式

| 网络模式 | 配置 | 说明 |

| host | --network host | 容器和宿主机共享Network namespace |

| container | --network container:NAME_OR_ID | 容器和另外一个容器共享Network namespace |

| none | --network none | 容器有独立的Network namespace, 但并没有对其进行任何网络设置, 如分配veth pair 和网桥连接,配置IP等 |

| bridge | --network bridge | 默认模式 |

- none模式

//该模式不存在IP地址

[root@Raygussie ~]# docker run -it --rm --network none busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

/ #

- host/桥接模式

在没用IP地址的环境里作业比较安全,可以隔离

//与主机有着同样的网络命名空间

[root@Raygussie ~]# docker run -it --rm --network host busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

inet6 ::1/128 scope host

valid_lft forever preferred_lft forever

2: ens160: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc mq qlen 1000

link/ether 00:0c:29:d4:5d:1d brd ff:ff:ff:ff:ff:ff

inet 192.168.186.130/24 brd 192.168.186.255 scope global dynamic ens160

valid_lft 1399sec preferred_lft 1399sec

inet6 fe80::9102:9b4e:7d85:d875/64 scope link

valid_lft forever preferred_lft forever

3: docker0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue

link/ether 02:42:69:4c:25:bd brd ff:ff:ff:ff:ff:ff

inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0

valid_lft forever preferred_lft forever

inet6 fe80::42:69ff:fe4c:25bd/64 scope link

valid_lft forever preferred_lft forever

5: veth6c0d0a4@if4: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue master docker0

link/ether 46:45:95:c4:fe:ba brd ff:ff:ff:ff:ff:ff

inet6 fe80::4445:95ff:fec4:feba/64 scope link

valid_lft forever preferred_lft forever

/ #

- container/容器模式

//与容器共用同一个ip

[root@Raygussie ~]# docker run -it --rm busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

4: eth0@if5: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

[root@Raygussie ~]# docker run -it --rm --network container:6df542a19912 busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

4: eth0@if5: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ #

bridge模式

当Docker进程启动时,会在主机上创建一个名为docker0的虚拟网桥,此主机上启动的Docker容器会连接到这个虚拟网桥上。虚拟网桥的工作方式和物理交换机类似,这样主机上的所有容器就通过交换机连在了一个二层网络中。

从docker0子网中分配一个IP给容器使用,并设置docker0的IP地址为容器的默认网关。在主机上创建一对虚拟网卡veth pair设备,Docker将veth pair设备的一端放在新创建的容器中,并命名为eth0(容器的网卡),另一端放在主机中,以vethxxx这样类似的名字命名,并将这个网络设备加入到docker0网桥中。可以通过brctl show命令查看。

//除了brctl show命令来查看还可以通过nmcli dev命令查看

[root@Raygussie ~]# nmcli dev

DEVICE TYPE STATE CONNECTION

ens160 ethernet connected ens160

docker0 bridge connected docker0

lo loopback unmanaged --

[root@Raygussie ~]#

bridge模式是docker的默认网络模式,不写--network参数,就是bridge模式。使用docker run -p时,docker实际是在iptables做了DNAT规则,实现端口转发功能。可以使用iptables -t nat -vnL查看。

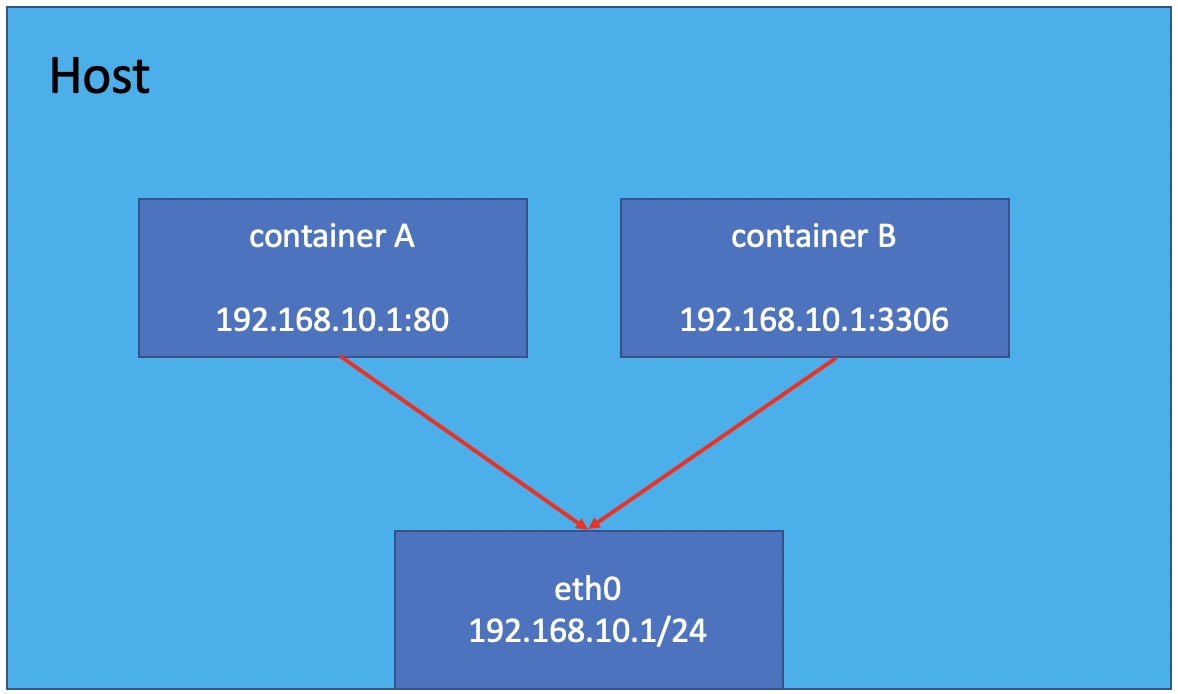

bridge模式如下图所示:

假设上图的docker2中运行了一个nginx,大家来想几个问题:

- 同主机间两个容器间是否可以直接通信?比如在docker1上能不能直接访问到docker2的nginx站点?

//首先开启httpd容器

[root@Raygussie ~]# docker run -it --rm httpd

AH00558: httpd: Could not reliably determine the server's fully qualified domain name, using 172.17.0.3. Set the 'ServerName' directive globally to suppress this message

AH00558: httpd: Could not reliably determine the server's fully qualified domain name, using 172.17.0.3. Set the 'ServerName' directive globally to suppress this message

[Mon Mar 01 10:19:48.200905 2021] [mpm_event:notice] [pid 1:tid 139987976778880] AH00489: Apache/2.4.46 (Unix) configured -- resuming normal operations

[Mon Mar 01 10:19:48.245118 2021] [core:notice] [pid 1:tid 139987976778880] AH00094: Command line: 'httpd -D FOREGROUND'

//去另一个终端查看

[root@Raygussie ~]# docker ps

CONTAINER ID IMAGE COMMAND CREATED STATUS PORTS NAMES

715c5033dad6 httpd "httpd-foreground" 27 seconds ago Up 17 seconds 80/tcp gracious_yonath

f09032e25c27 busybox "sh" 3 minutes ago Up 3 minutes angry_varahamihira

//查看其IP地址

[root@Raygussie ~]# docker inspect 715c5033dad6

。。。。。。

Gateway": "172.17.0.1",

"IPAddress": "172.17.0.3",

"IPPrefixLen": 16,

"IPv6Gateway": "",

"GlobalIPv6Address": "",

"GlobalIPv6PrefixLen": 0,

"MacAddress": "02:42:ac:11:00:03",

"DriverOpts": null

//去另一个终端的容器测试是否连接成功

[root@Raygussie ~]# docker run -it --rm busybox

/ # ip a

1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue qlen 1000

link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00

inet 127.0.0.1/8 scope host lo

valid_lft forever preferred_lft forever

6: eth0@if7: <BROADCAST,MULTICAST,UP,LOWER_UP,M-DOWN> mtu 1500 qdisc noqueue

link/ether 02:42:ac:11:00:02 brd ff:ff:ff:ff:ff:ff

inet 172.17.0.2/16 brd 172.17.255.255 scope global eth0

valid_lft forever preferred_lft forever

/ # wget -O - 172.17.0.3

Connecting to 172.17.0.3 (172.17.0.3:80)

writing to stdout

<html><body><h1>It works!</h1></body></html>

- 100% |*************************************| 45 0:00:00 ETA

written to stdout

/ # exit

[root@Raygussie ~]#

[root@Raygussie ~]# curl 172.17.0.3

<html><body><h1>It works!</h1></body></html>

//由此可得同主机间两个容器间是可以直接通信

- 在宿主机上能否直接访问到docker2的nginx站点?

//可以直接访问,同网关

[root@Raygussie ~]# curl 172.17.0.3

<html><body><h1>It works!</h1></body></html>

- 在另一台主机上如何访问node1上的这个nginx站点呢?DNAT发布?

不能访问,要做桥接

在docker2容器里的80端口绑定到当前虚拟主机的网卡上,再由相同网关的虚拟机与真机连接成功就可以间接访问到容器

Docker网桥是宿主机虚拟出来的,并不是真实存在的网络设备,外部网络是无法寻址到的,这也意味着外部网络无法通过直接Container-IP访问到容器。如果容器希望外部访问能够访问到,可以通过映射容器端口到宿主主机(端口映射),即docker run创建容器时候通过 -p 或 -P 参数来启用,访问容器的时候就通过[宿主机IP]:[容器端口]访问容器。

container模式

这个模式指定新创建的容器和已经存在的一个容器共享一个 Network Namespace,而不是和宿主机共享。新创建的容器不会创建自己的网卡,配置自己的 IP,而是和一个指定的容器共享 IP、端口范围等。同样,两个容器除了网络方面,其他的如文件系统、进程列表等还是隔离的。两个容器的进程可以通过 lo 网卡设备通信。

container模式如下图所示:

host模式

如果启动容器的时候使用host模式,那么这个容器将不会获得一个独立的Network Namespace,而是和宿主机共用一个Network Namespace。容器将不会虚拟出自己的网卡,配置自己的IP等,而是使用宿主机的IP和端口。但是,容器的其他方面,如文件系统、进程列表等还是和宿主机隔离的。

使用host模式的容器可以直接使用宿主机的IP地址与外界通信,容器内部的服务端口也可以使用宿主机的端口,不需要进行NAT,host最大的优势就是网络性能比较好,但是docker host上已经使用的端口就不能再用了,网络的隔离性不好。

Host模式如下图所示:

none模式

使用none模式,Docker容器拥有自己的Network Namespace,但是,并不为Docker容器进行任何网络配置。也就是说,这个Docker容器没有网卡、IP、路由等信息。需要我们自己为Docker容器添加网卡、配置IP等。

这种网络模式下容器只有lo回环网络,没有其他网卡。none模式可以在容器创建时通过--network none来指定。这种类型的网络没有办法联网,封闭的网络能很好的保证容器的安全性。

应用场景:

- 启动一个容器处理数据,比如转换数据格式

- 一些后台的计算和处理任务

none模式如下图所示:

查看bridge网络的详细配置

[root@Raygussie ~]# docker network inspect bridge

[

{

"Name": "bridge",

"Id": "5dd119878c1002571fba056d7b9f0ffadeca9db66dd9efc4925d378e6b80861c",

"Created": "2021-03-01T17:35:55.393082439+08:00",

"Scope": "local",

"Driver": "bridge",

"EnableIPv6": false,

"IPAM": {

"Driver": "default",

"Options": null,

"Config": [

{

"Subnet": "172.17.0.0/16",

"Gateway": "172.17.0.1"

}

]

},

"Internal": false,

"Attachable": false,

"Ingress": false,

"ConfigFrom": {

"Network": ""

},

"ConfigOnly": false,

"Containers": {

"715c5033dad66988f437ec5b716d669b2b7fa408bdc8105ab8b8662a5bfc2be7": {

"Name": "gracious_yonath",

"EndpointID": "dd3f970cb568ad04fe17eee12f5ec67843a47e655375364eac43e3aa139de23f",

"MacAddress": "02:42:ac:11:00:03",

"IPv4Address": "172.17.0.3/16",

"IPv6Address": ""

}

},

"Options": {

"com.docker.network.bridge.default_bridge": "true",

"com.docker.network.bridge.enable_icc": "true",

"com.docker.network.bridge.enable_ip_masquerade": "true",

"com.docker.network.bridge.host_binding_ipv4": "0.0.0.0",

"com.docker.network.bridge.name": "docker0",

"com.docker.network.driver.mtu": "1500"

},

"Labels": {}

}

]

[root@Raygussie ~]#