AlexNet: ImageNet Classification with Deep Convolutional Neural Networks

局部响应归一化(Local Response Normalization, LRN):

LRN,局部响应归一化。在神经学科中,有一个叫横向抑制(lateral inhibition)的概念,这种抑制的作用就是阻止兴奋神经元向邻近神经元传播其动作趋势,从而减少兴奋神经元的邻近神经元的激活程度。借鉴了这一生物现象(其实我们全部东西都是借鉴生物的,不是?),我们使用LRN层来对激活函数的输出数据进行横向抑制,在为激活函数收拾残局的同时,LRN还凸显了该区域的一个峰值 —— 这个峰值特征就是我们想要的特征。

使用ReLU 后,会发现激活函数之后的值没有了tanh、sigmoid函数那样有一个值域区间

特别是ReLU,它无限制的激活使得我们更需要LRN来到数据进行归一化。在大规模的数据中,我们大多情况下更看重被凸显的高频特征。因此,用LRN对数据的峰值进行催化而对其周围进行抑制,何乐不为。

归一化还有助于快速收敛。

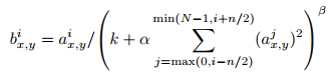

通过把神经元的各个参数代入下面的式子,对参数进行计算操作,然后产生新的值。

浙公网安备 33010602011771号

浙公网安备 33010602011771号