LDA终极分析

http://www.cnblogs.com/pinard/p/6867828.html

http://www.52nlp.cn/lda-math-mcmc-和-gibbs-sampling2

http://www.52nlp.cn/lda-math-mcmc-和-gibbs-sampling1

相当于pai(i)P(i->j) = pai (j) P(j->i)

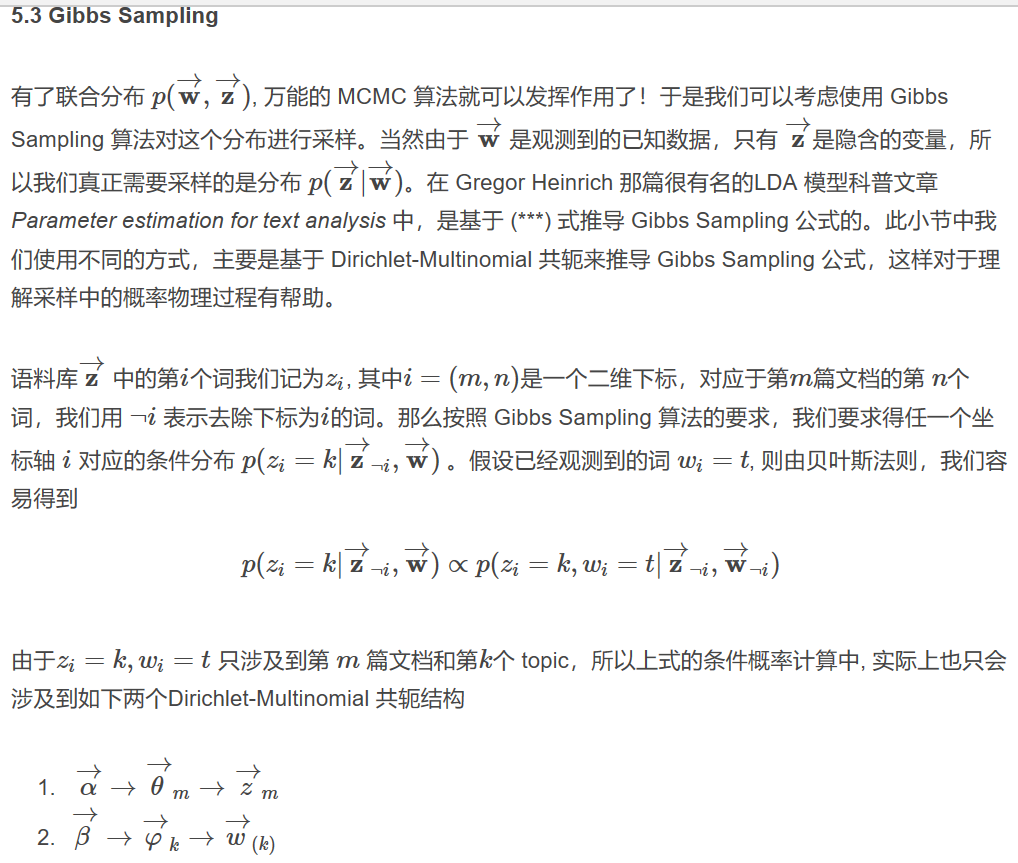

在LDA中i,j都是三维的,m,n,k表示第k篇文章的第n个词汇属于第k个主题;

因为我们实际相求的是m&n&k这个最终的联合分布采样,直到Gibbs采样收敛到一个状态,就是最终的状态,我们取k就是最终的对应主题

所以为了求解LDA,我们需要求出p(K/M,N)的概率密度,这个就是转移矩阵,而拥有转移矩阵后,我们刚开始随机初始化每个词的主题,

最终根据转移矩阵收敛的P才是最终的。

浙公网安备 33010602011771号

浙公网安备 33010602011771号