【原】Coursera—Andrew Ng机器学习—Week 3 习题—Logistic Regression 逻辑回归

课上习题

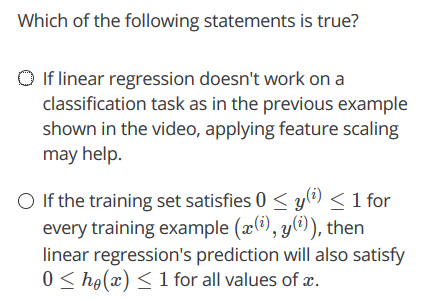

【1】线性回归

Answer: D

A 特征缩放不起作用,B for all 不对,C zero error不对

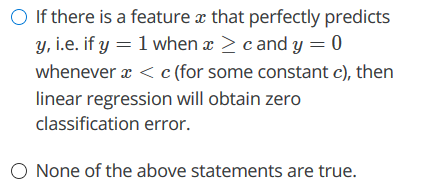

【2】概率

Answer:A

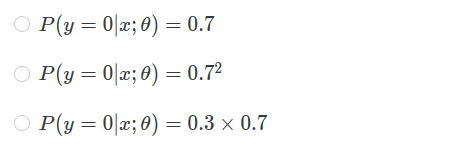

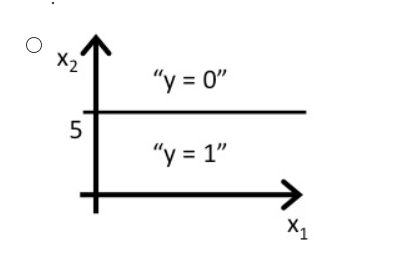

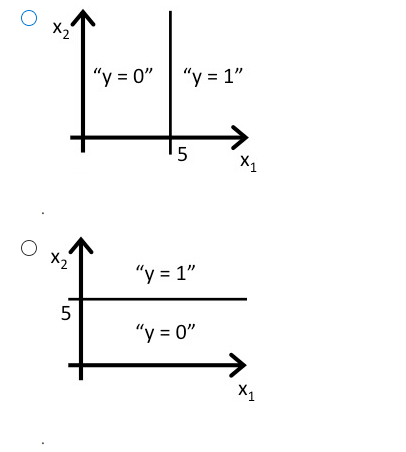

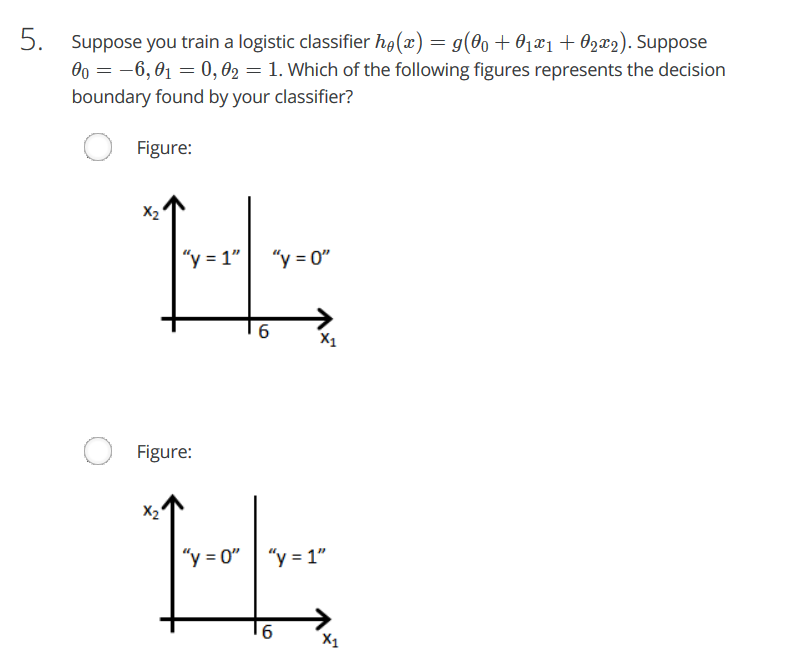

【3】预测图形

Answer:A

5 - x1 ≥ 0时,y = 1。即x1 ≤ 5时,y = 1

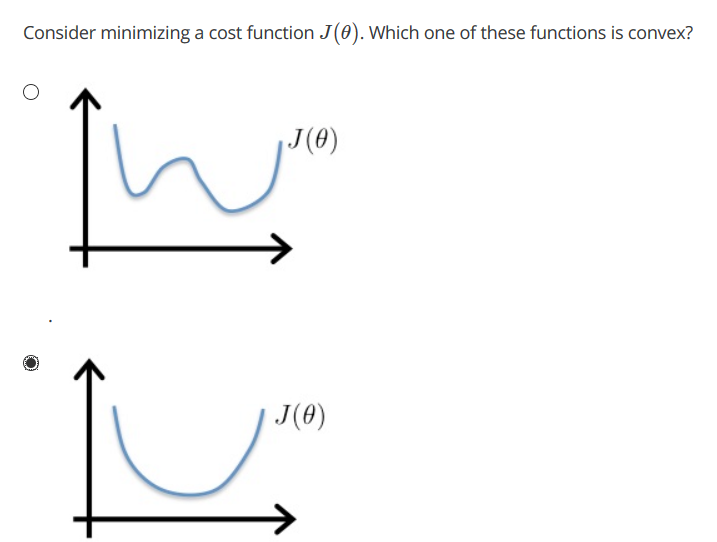

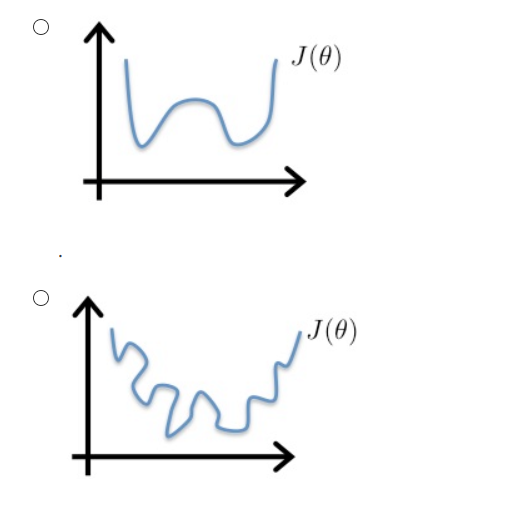

【4】凸函数

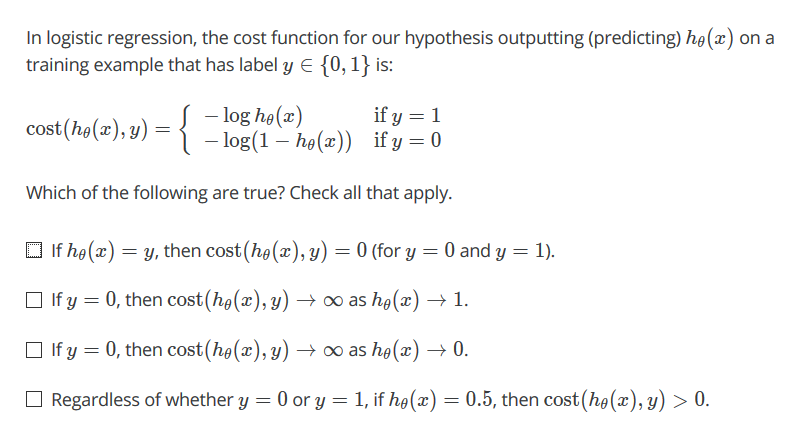

【5】代价函数

Answer:ABD

任何情况下都是 预测对时 cost为0,反之为正无穷

【6】代价函数

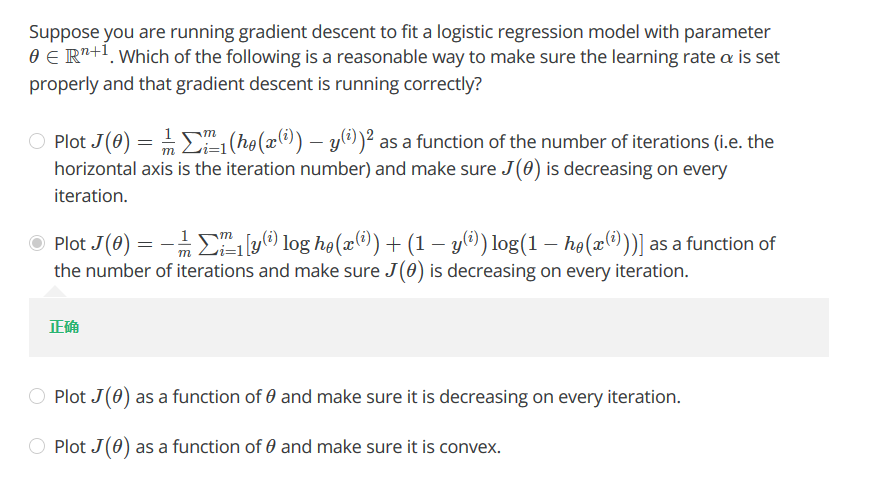

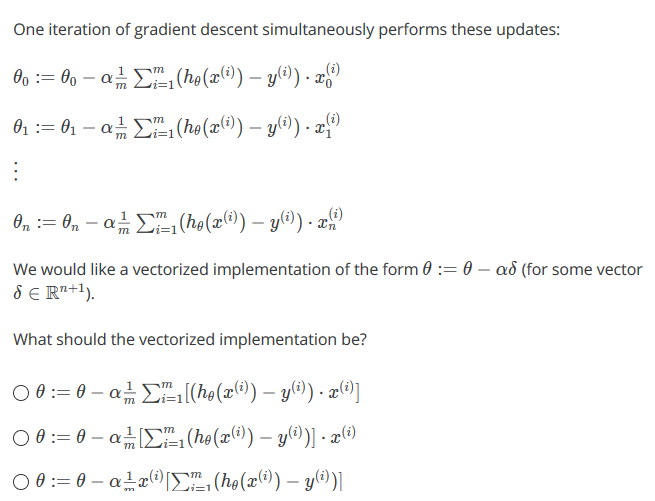

【7】向量化

Answer:A

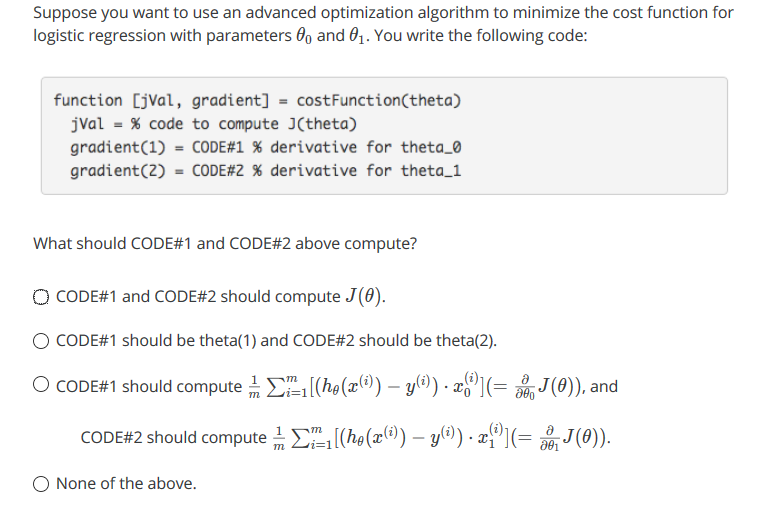

【8】高级优化算法

Answer:C

【9】多分类

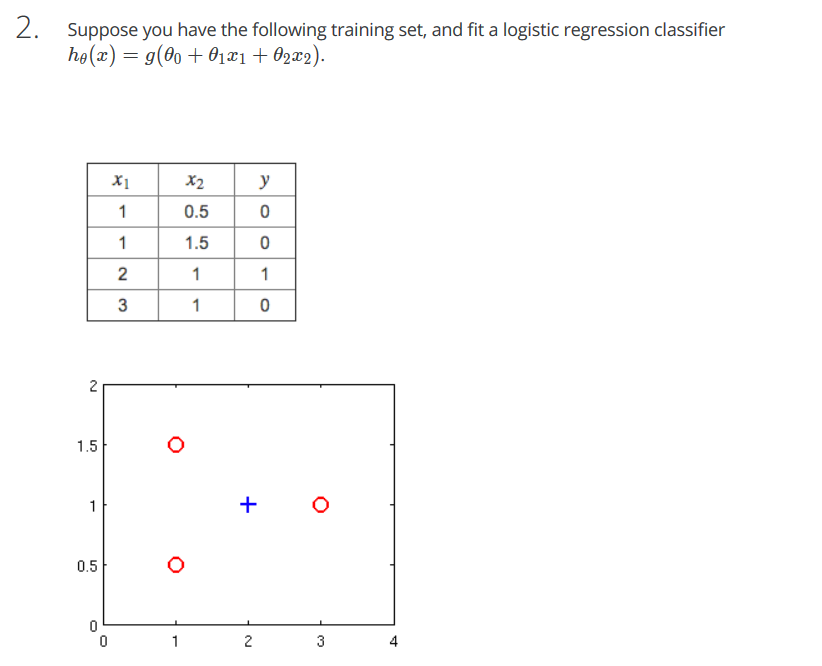

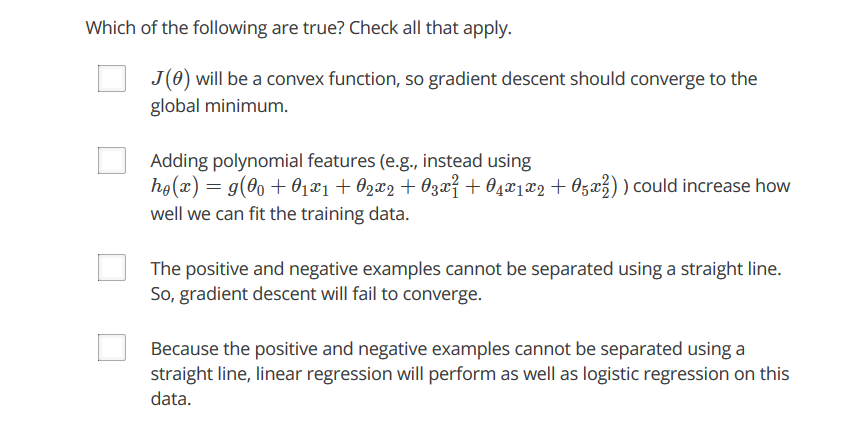

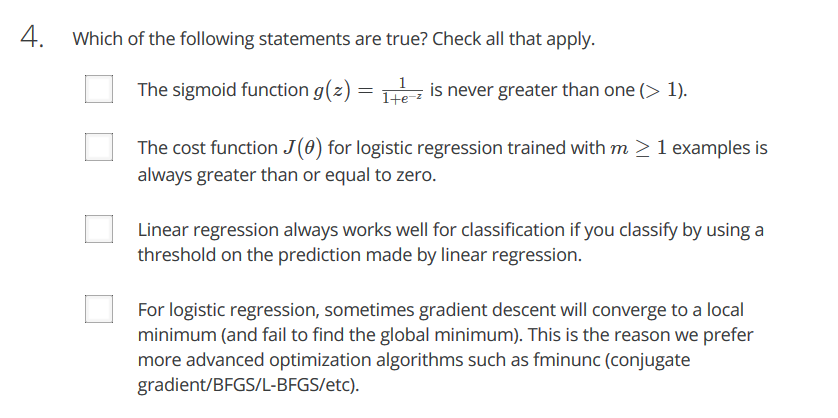

测验

AB

Answer:BE

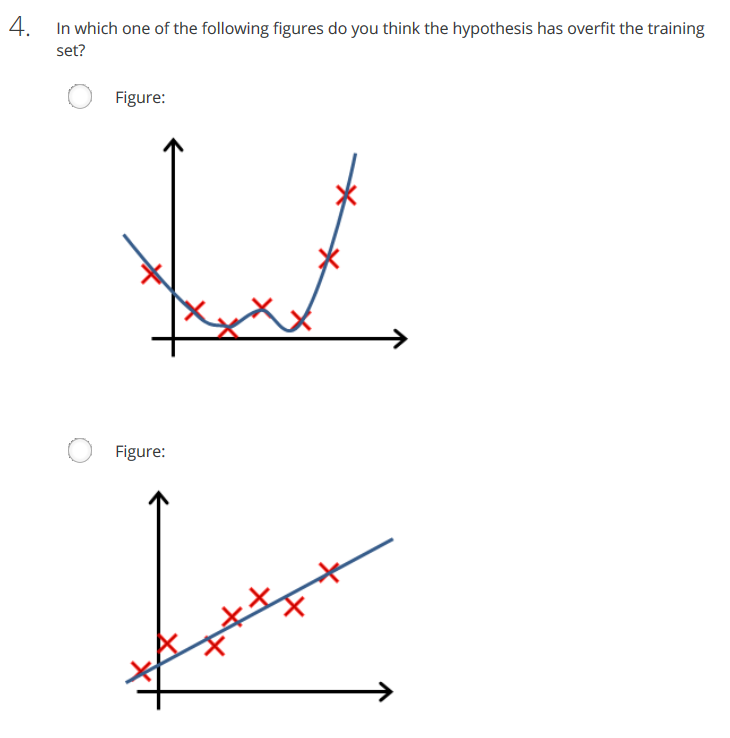

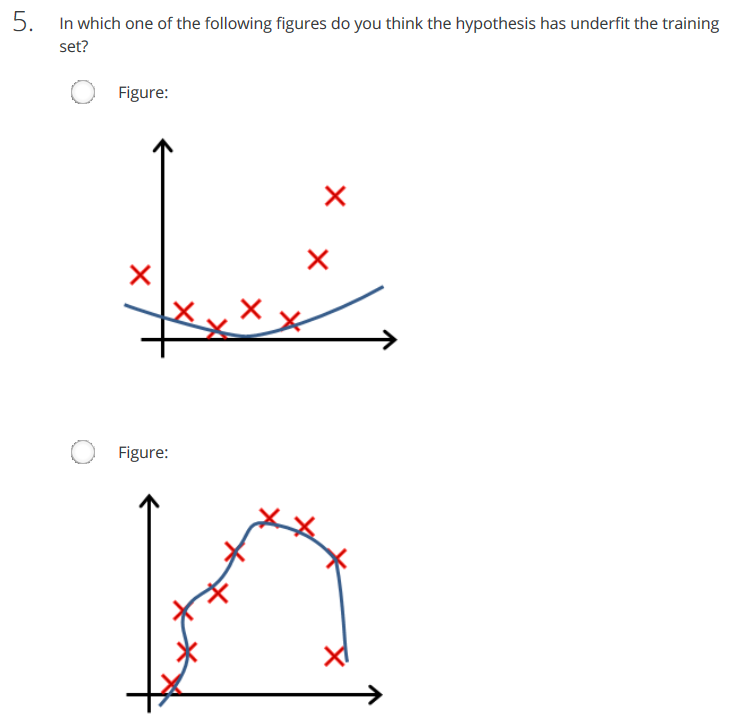

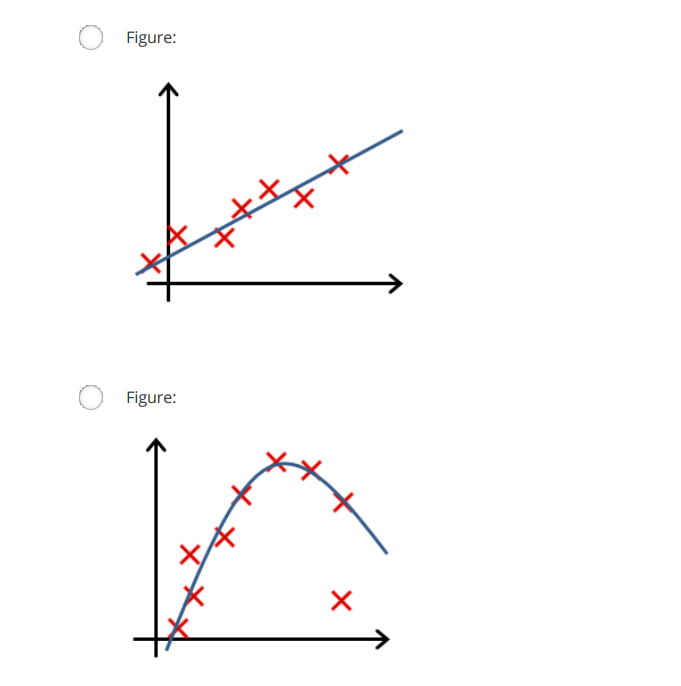

当有一个feature时是一条直线,当有两个feature时一条曲线,有更多的feature时是一条弯七弯八的曲线 。当feature越来越多时,曲线越来越拟合,即损失函数越来越小

A 逻辑回归没有局部最优

B 当增加feature时,拟合的更好. 正确

C 拟合不好但还是会收敛

D 线性回归

E 直线不会完全拟合这几个数据。找到最佳的θ,但是J(θ)会大于0。 正确

F 和B相反,错误

G 0< hθ(x(i)) <1 不可能大于1。 错误

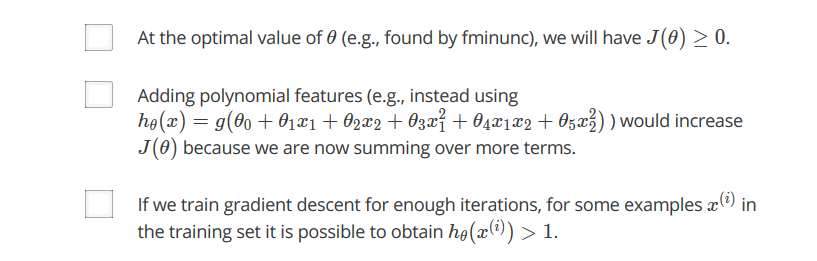

Answer: BCE

AD是线性回归

F少了一个下标 j

Answer:AB

C 线性回归用于分类不好使

D 逻辑回归是凸函数 没有局部最优解的情况。

Answer:D

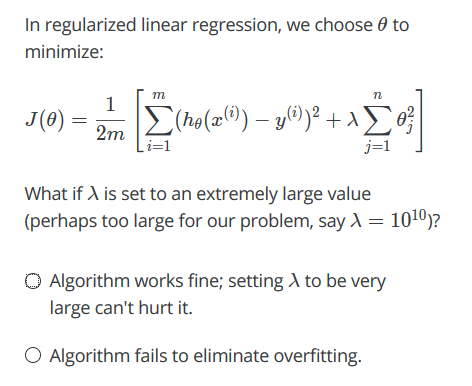

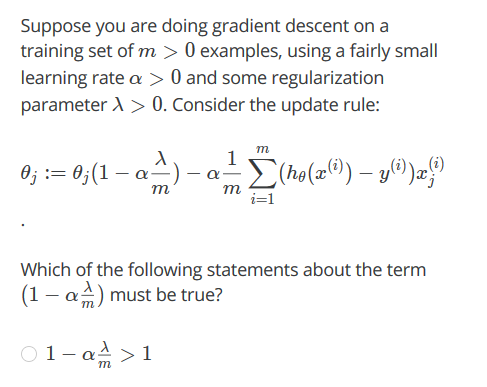

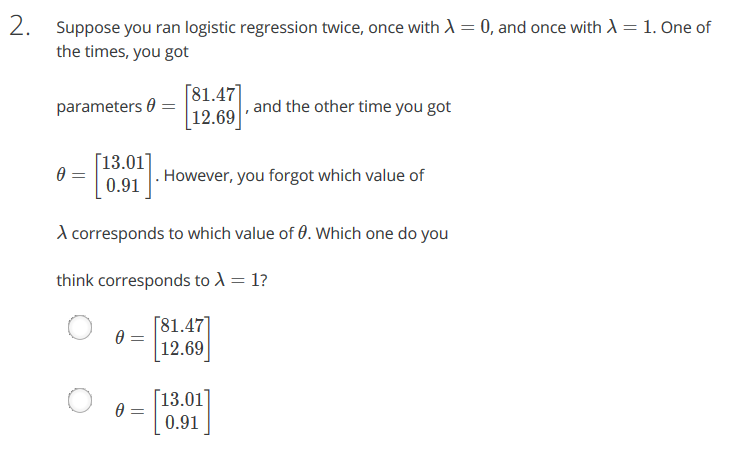

【1】regularization

Answer:C

【2】

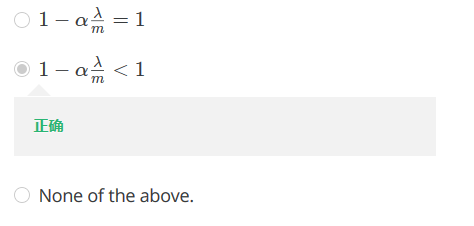

【3】

Answer:A

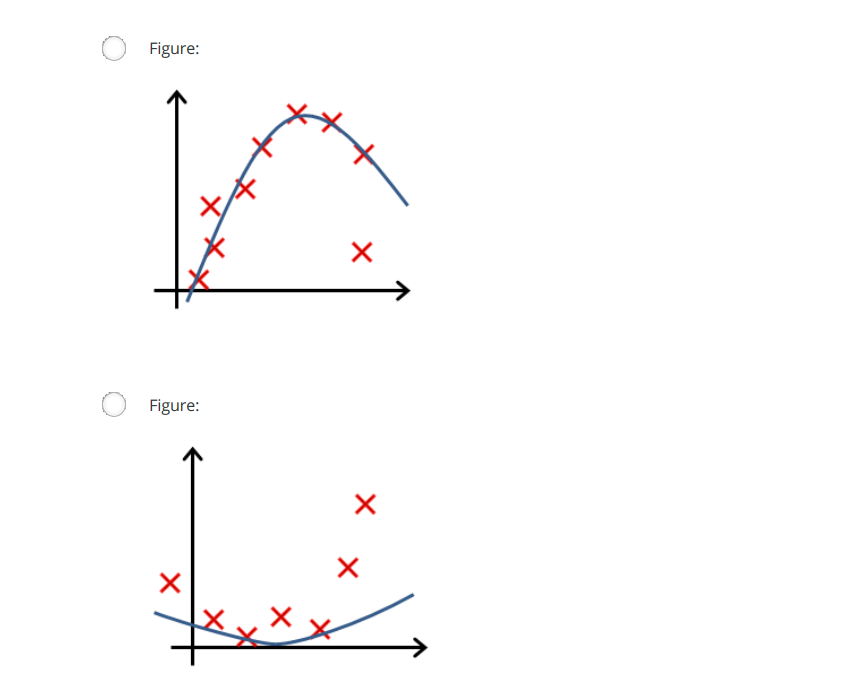

A :新加的feature会提高 train set的拟合度

B :more features能够更好的 fit 训练集,同时也容易导致overfit,是more likely而不是 prevent. 不正确

C,D:将正则化方法加入模型并不是每次都能取得好的效果,如果取得太大的化就会导致欠拟合. 这样不论对 traing set 还是 examples都不好. 不正确

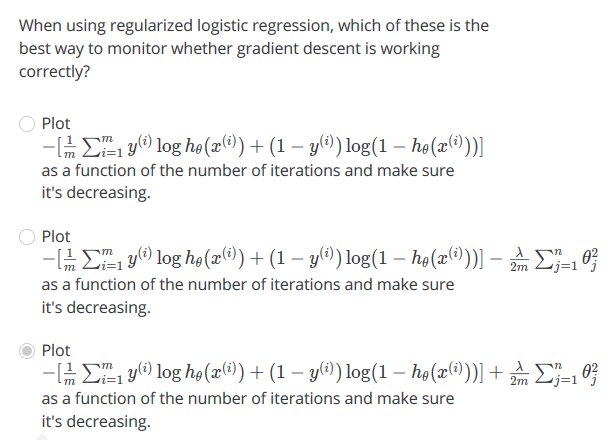

Answer:B

逻辑回归中,由于λ的加入 参数Θ会变小

Answer:C

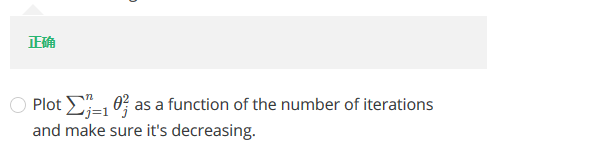

Answer: A

Answer:A