基于Harris角点的多视角图像全景拼接算法matlab仿真

1.算法运行效果图预览

2.算法运行软件版本

matlab2022a

3.算法理论概述

基于Harris角点的多视角图像全景拼接算法是一种在计算机视觉和图像处理领域中广泛应用的算法,用于将来自不同视角的多个图像拼接成一个全景图像。该算法主要依赖于特征点检测和图像配准技术,Harris角点检测是其中的关键步骤之一。

3.1 Harris角点检测

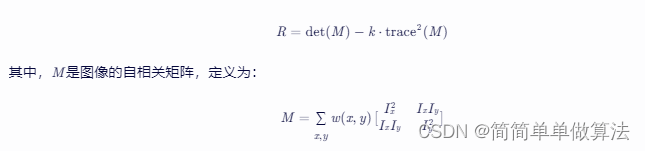

Harris角点检测是一种基于图像局部自相关函数变化的角点检测方法。对于图像I(x,y),在每个像素点(x,y)处定义一个窗口,计算窗口内像素的灰度变化。Harris角点检测通过计算角点响应函数R来确定角点的位置:

Ix和Iy分别是图像在x和y方向的梯度,w(x,y)是一个窗口函数,通常使用高斯函数。det(M)表示矩阵M的行列式,trace(M)表示矩阵M的迹,k是一个经验常数,通常取值为0.04~0.06。

Harris角点检测通过计算每个像素点的角点响应函数R,并设置合适的阈值来筛选出角点。这些角点将作为后续图像配准和拼接的基础。

3.2 图像配准

图像配准是将不同视角下的图像对齐的过程。在基于Harris角点的多视角图像全景拼接算法中,图像配准主要通过特征点匹配来实现。

特征点提取:使用Harris角点检测算法从每个图像中提取出角点作为特征点。

特征点描述:对每个特征点周围的图像区域进行描述,生成特征描述符。常用的特征描述符有SIFT、SURF等。

特征点匹配:通过比较特征描述符之间的相似度,找到不同图像之间匹配的特征点对。常用的特征点匹配算法有暴力匹配、FLANN匹配等。

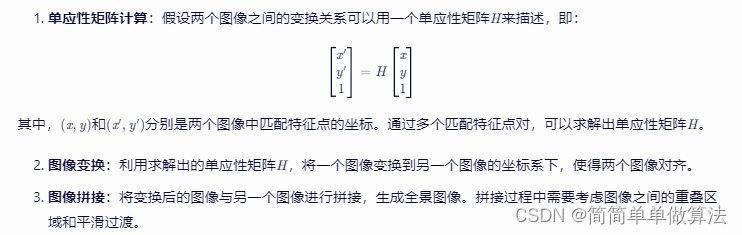

3.3 图像变换和拼接

在找到匹配的特征点对后,需要通过图像变换将不同视角下的图像对齐到同一个坐标系下,然后进行拼接。

3.4 全景图像优化

拼接后的全景图像可能存在一些拼接缝和畸变,需要进行优化处理。

拼接缝消除:通过图像融合技术,将拼接缝附近的像素进行平滑过渡,消除拼接缝。

畸变校正:根据相机的畸变模型,对全景图像进行畸变校正,提高图像质量。

4.部分核心程序

function [ImageB] = func_stitch(ImageA, ImageB)

% 获取ImageA和ImageB的尺寸

RR1 = size(ImageA,1);

CC1 = size(ImageA,2);

RR2 = size(ImageB,1);

CC2 = size(ImageB,2);

%角点检测

jiaodian_imageB = corner_detector(ImageB);

%提取角点

[xh,yh,~] = anms(jiaodian_imageB, 300);

%对提取的角点计算特征描述子

[Pcorner] = feat_desc_geoblur(ImageB, xh, yh);

%角点检测

jiaodian_imageA = corner_detector(ImageA);

%提取角点

[xh2, yh2, ~] = anms(jiaodian_imageA, 300);

%对提取的角点计算特征描述子

[Pcorner2] = feat_desc_geoblur(ImageA, xh2, yh2);

% 对两张图像的特征描述子进行匹配

[Pmatch] = feat_match(Pcorner2, Pcorner);

% 提取匹配成功的点

X_mh1 = xh2(Pmatch ~= -1);

Y_mh1 = yh2(Pmatch ~= -1);

X_mh2 = xh(Pmatch(Pmatch ~= -1));

Y_mh2 = yh(Pmatch(Pmatch ~= -1));

% 剔除误匹配点

[H, ~] = ransac_est_homography(X_mh1, Y_mh1, X_mh2, Y_mh2, 10);

% 计算两张图像到各自边界的距离

ImageA_dist = dist2border(ImageA);

ImageB_dist = dist2border(ImageB);

% 计算img_i四个角的映射坐标

ul = H*[1 1 1]';

ul = ul/ul(end);

ur = H*[CC1, 1, 1]';

ur = ur/ur(end);

bl = H*[1, RR1, 1]';

bl = bl/bl(end);

br = H*[CC1, RR1, 1]';

br = br/br(end);

% 根据映射坐标确定需要填充的边界

Edge_up = 0;

Edge_L = 0;

Edge_dw = 0;

Edge_R = 0;

if max(br(1),ur(1)) > CC2

Edge_R = round(max(br(1),ur(1))-CC2+30);

ImageB = padarray(ImageB, [0, Edge_R], 'post');

end

if max(br(2), bl(2)) > RR2

Edge_dw = round(max(br(2), bl(2))-RR2+30);

ImageB = padarray(ImageB, [Edge_dw, 0], 'post');

end

if min(ul(1), bl(1)) <= 0

Edge_L = round(-min(ul(1), bl(1))+30);

ImageB = padarray(ImageB, [0, Edge_L], 'pre');

end

if min(ul(2), ur(2)) <= 0

Edge_up = round(-min(ul(2), ur(2)) + 30);

ImageB = padarray(ImageB, [Edge_up, 0], 'pre');

end

% 计算单应性矩阵的逆

H_inv = inv(H);

% 创建一个网格,用于映射img_b上的每个像素到img_i上的坐标

[yh, xh] = meshgrid(round(Edge_up+min(ul(2), ur(2))):round(Edge_up+max(bl(2), br(2))), round(Edge_L+min(ul(1), bl(1))):round(Edge_L+max(br(1),ur(1))));

yh = yh(:);

xh = xh(:);

xy = H_inv*[xh - Edge_L, yh - Edge_up, ones(size(xh,1),1)]';

xh2 = int64(xy(1,:)'./xy(3,:)'); yh2 = int64(xy(2,:)'./xy(3,:)');

................................................................................

end

浙公网安备 33010602011771号

浙公网安备 33010602011771号