06Embedding简介

embedding:用一个数值向量表示一个对象的方法,主要用以表示对象之间的关系

重要性:

1.将高维稀疏特征转为低维稠密特征。

2.融合大量有价值的信息,表达能力强。

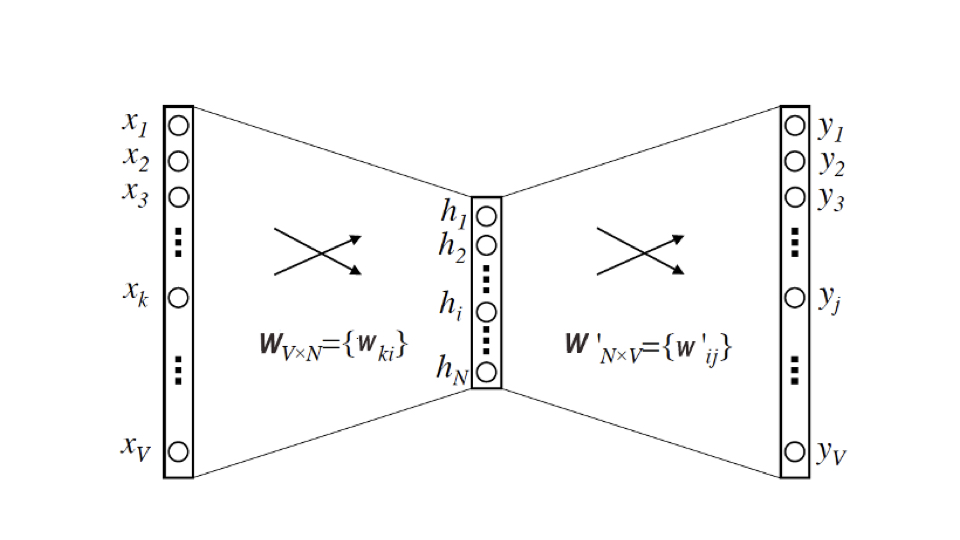

以下为word2vector的模型结构(输入词的 one-hot编码,拟合该词的muti-hot编码,利用反向传播,激活函数是softmax,其中输入到隐藏层的Wvn就是我们需要的embedding):

item2vec:利用序列数据把对象表达出来,利用word2vec即可获得embedding,我们可获得item的相似性和重要特征 。

重点回顾:

在我们通过 Word2vec 训练得到词向量,或者通过 Item2vec 得到物品向量之后,我们应该用什么方法计算他们的相似性呢?你知道几种计算相似性的方法?

1.利用距离:

1)欧氏距离,n维空间中两点真实距离。

2)曼哈顿距离,坐标轴距之和。

3)闵可夫斯基距离

2.夹角余弦

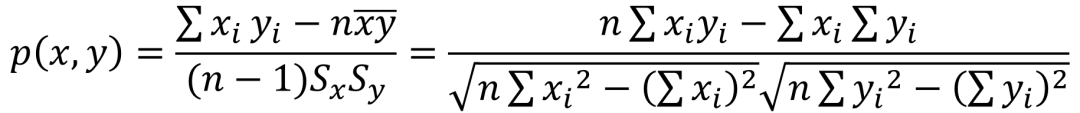

3.(皮尔逊)相关性系数,定距向量间的紧密程度:

4.集合观点下的相似度

浙公网安备 33010602011771号

浙公网安备 33010602011771号