Docker 搭建简单 LVS

LVS简介

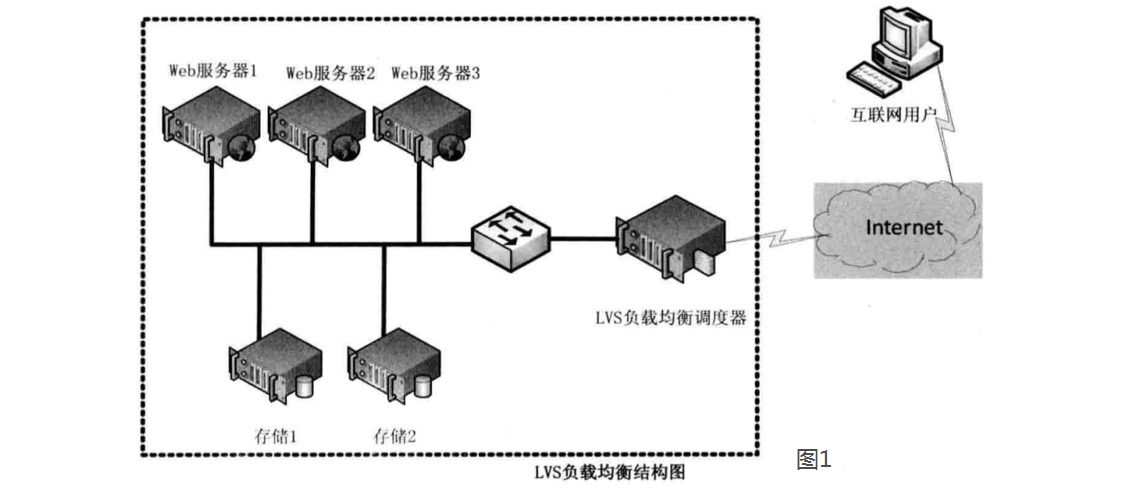

LVS(Linux Virtual Server)即Linux虚拟服务器,是由章文嵩博士主导的开源负载均衡项目,目前LVS已经被集成到Linux内核模块中。该项目在Linux内核中实现了基于IP的数据请求负载均衡调度方案,其体系结构如图1所示,终端互联网用户从外部访问公司的外部负载均衡服务器,终端用户的Web请求会发送给LVS调度器,调度器根据自己预设的算法决定将该请求发送给后端的某台Web服务器,比如,轮询算法可以将外部的请求平均分发给后端的所有服务器,终端用户访问LVS调度器虽然会被转发到后端真实的服务器,但如果真实服务器连接的是相同的存储,提供的服务也是相同的服务,最终用户不管是访问哪台真实服务器,得到的服务内容都是一样的,整个集群对用户而言都是透明的。最后根据LVS工作模式的不同,真实服务器会选择不同的方式将用户需要的数据发送到终端用户,LVS工作模式分为NAT模式、TUN模式、以及DR模式。

三种工作模式的解析

基于NAT的LVS模式负载均衡

NAT(Network Address Translation)即网络地址转换,其作用是通过数据报头的修改,使得位于企业内部的私有IP地址可以访问外网,以及外部用用户可以访问位于公司内部的私有IP主机。VS/NAT工作模式拓扑结构如图2所示,LVS负载调度器可以使用两块网卡配置不同的IP地址,eth0设置为私钥IP与内部网络通过交换设备相互连接,eth1设备为外网IP与外部网络联通。

第一步,用户通过互联网DNS服务器解析到公司负载均衡设备上面的外网地址,相对于真实服务器而言,LVS外网IP又称VIP(Virtual IP Address),用户通过访问VIP,即可连接后端的真实服务器(Real Server),而这一切对用户而言都是透明的,用户以为自己访问的就是真实服务器,但他并不知道自己访问的VIP仅仅是一个调度器,也不清楚后端的真实服务器到底在哪里、有多少真实服务器。

第二步,用户将请求发送至124.126.147.168,此时LVS将根据预设的算法选择后端的一台真实服务器(192.168.0.1~192.168.0.3),将数据请求包转发给真实服务器,并且在转发之前LVS会修改数据包中的目标地址以及目标端口,目标地址与目标端口将被修改为选出的真实服务器IP地址以及相应的端口。

第三步,真实的服务器将响应数据包返回给LVS调度器,调度器在得到响应的数据包后会将源地址和源端口修改为VIP及调度器相应的端口,修改完成后,由调度器将响应数据包发送回终端用户,另外,由于LVS调度器有一个连接Hash表,该表中会记录连接请求及转发信息,当同一个连接的下一个数据包发送给调度器时,从该Hash表中可以直接找到之前的连接记录,并根据记录信息选出相同的真实服务器及端口信息。

基于TUN的LVS负载均衡

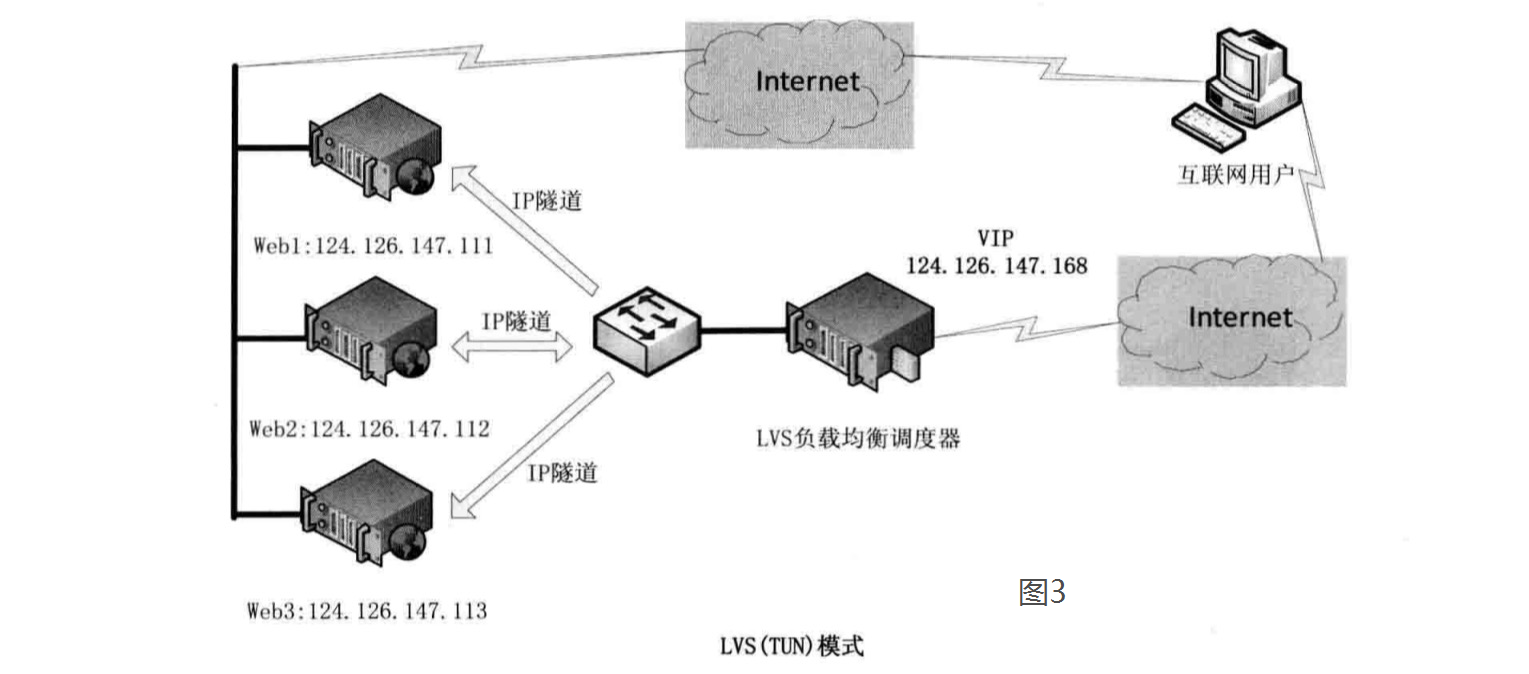

在LVS(NAT)模式的集群环境中,由于所有的数据请求及响应的数据包都需要经过LVS调度器转发,如果后端服务器的数量大于10台,则调度器就会成为整个集群环境的瓶颈。我们知道,数据请求包往往远小于响应数据包的大小。因为响应数据包中包含有客户需要的具体数据,所以LVS(TUN)的思路就是将请求与响应数据分离,让调度器仅处理数据请求,而让真实服务器响应数据包直接返回给客户端。VS/TUN工作模式拓扑结构如图3所示。其中,IP隧道(IP tunning)是一种数据包封装技术,它可以将原始数据包封装并添加新的包头(内容包括新的源地址及端口、目标地址及端口),从而实现将一个目标为调度器的VIP地址的数据包封装,通过隧道转发给后端的真实服务器(Real Server),通过将客户端发往调度器的原始数据包封装,并在其基础上添加新的数据包头(修改目标地址为调度器选择出来的真实服务器的IP地址及对应端口),LVS(TUN)模式要求真实服务器可以直接与外部网络连接,真实服务器在收到请求数据包后直接给客户端主机响应数据。

基于DR的LVS负载均衡

在LVS(TUN)模式下,由于需要在LVS调度器与真实服务器之间创建隧道连接,这同样会增加服务器的负担。与LVS(TUN)类似,DR模式也叫直接路由模式,其体系结构如图4所示,该模式中LVS依然仅承担数据的入站请求以及根据算法选出合理的真实服务器,最终由后端真实服务器负责将响应数据包发送返回给客户端。与隧道模式不同的是,直接路由模式(DR模式)要求调度器与后端服务器必须在同一个局域网内,VIP地址需要在调度器与后端所有的服务器间共享,因为最终的真实服务器给客户端回应数据包时需要设置源IP为VIP地址,目标IP为客户端IP,这样客户端访问的是调度器的VIP地址,回应的源地址也依然是该VIP地址(真实服务器上的VIP),客户端是感觉不到后端服务器存在的。由于多台计算机都设置了同样一个VIP地址,所以在直接路由模式中要求调度器的VIP地址是对外可见的,客户端需要将请求数据包发送到调度器主机,而所有的真实服务器的VIP地址必须配置在Non-ARP的网络设备上,也就是该网络设备并不会向外广播自己的MAC及对应的IP地址,真实服务器的VIP对外界是不可见的,但真实服务器却可以接受目标地址VIP的网络请求,并在回应数据包时将源地址设置为该VIP地址。调度器根据算法在选出真实服务器后,在不修改数据报文的情况下,将数据帧的MAC地址修改为选出的真实服务器的MAC地址,通过交换机将该数据帧发给真实服务器。整个过程中,真实服务器的VIP不需要对外界可见。

首先为了能够使用 IPVS 内核模块,我们将在宿主机中安装 ipvsadm,并尝试能否使用:

sudo apt-get update # 更新源 sudo apt-get install ipvsadm # 安装 ipvsadm 工具 sudo ipvsadm -L # 尝试使用 ipvsadm

使用 docker 创建所需 container,使用以下命令创建

docker run --privileged --name=RealServer1 -tdi ubuntu

docker run --privileged --name=RealServer2 -tdi ubuntu

RealServer 部署 Nginx 来提供 Web 服务,RealServer1 和 RealServer2 操作步骤相同,此处以 RealServer1 为示

docker attach RealServer1 apt-get update apt-get install vim -y apt-get install nginx -y service nginx start

#RealServer1 container 环境 sudo vi /var/www/html/index.nginx-debian.html(不同的安装方式路径不同) 修改默认页面移区分2台服务器

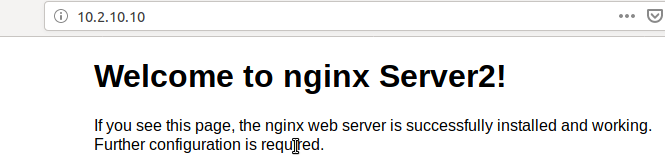

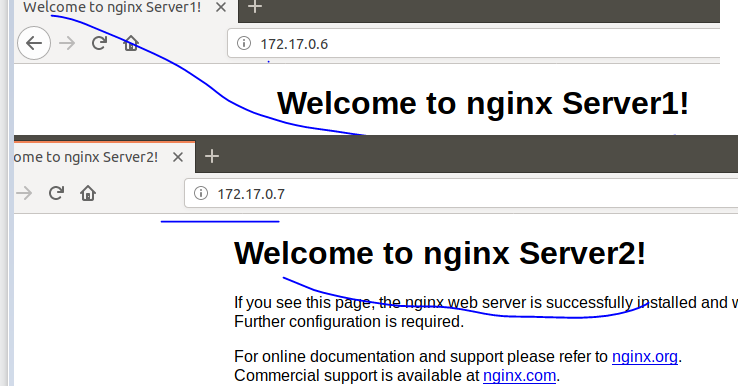

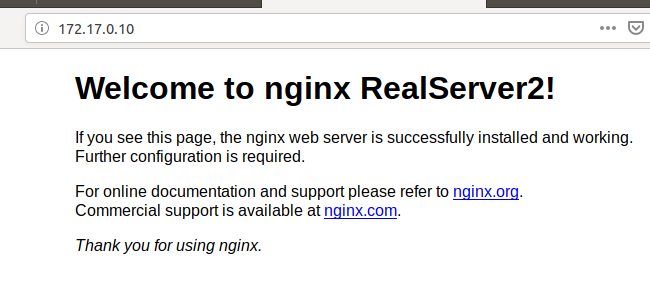

至此我们完成两台 Web 服务器的配置,我们可以打开宿主机 firefox 浏览器,地址栏分别输入两个 IP 地址,来检验我们的配置成功:

LoadBalancer(宿主) 的对外 IP 地址为 VIP,即 VIP 地址为 10.2.10.10( 10.2.10.10 是虚拟出来的,我的外网是10.2.0.xx ),开启 LoadBalancer 的内核路由转发

echo '1' | sudo tee /proc/sys/net/ipv4/ip_forward cat /proc/sys/net/ipv4/ip_forward #1 1 说明此机器已开启内核路由转发

.使用 ipvsadm 添加 ipvs 规则。定义集群服务:

sudo ipvsadm -A -t 10.2.10.10:80 -s rr #定义集群服务 sudo ipvsadm -a -t 10.2.10.10:80 -r 172.17.0.6 -m #添加 RealServer1 sudo ipvsadm -a -t 10.2.10.10:80 -r 172.17.0.7 -m #添加 RealServer2 sudo ipvsadm -l #查看 ipvs 定义的规则 # 添加集群服务 -A:添加一个新的集群服务 -t: 使用 TCP 协议 -s: 指定负载均衡调度算法 rr:轮询算法(LVS 实现了 8 种调度算法) 192.168.100.5:8888 定义集群服务的 IP 地址(VIP) 和端口 # 添加 Real Server 规则 -a:添加一个新的 RealServer 规则 -t:tcp 协议 -r:指定 RealServer IP 地址 -m:定义为 NAT 上面命令添加了两个服务器 RealServer1 和 RealServer2

测试结果(如果强制刷新没有变化 就把对应的nginx关闭再看看)

LVS/DR 的搭建

由于我实在同一个环境里面测试,所以现在需要删除上面的东西

sudo ipvsadm -C #清除 ipvsadm 的规则

docker stop RealServer1

docker stop RealServer2

docker rm RealServer1

docker rm RealServer2

通过 docker 创建三个 container 来模拟服务器池中的成员

docker run --privileged --name=LoadBalancer -tid ubuntu docker run --privileged --name=RealServer1 -tid ubuntu docker run --privileged --name=RealServer2 -tid ubuntu

配置两台 RealServer 的环境,已RealServer1为例

docker attach RealServer1 apt-get update apt install net-tools apt-get install vim -y apt-get install nginx -y #vi /usr/share/nginx/html/index.html vi /var/www/html/index.nginx-debian.html service nginx start

修改内核参数,抑制 arp,以 RealServer1 为例,登录 container,执行下列命令:

# 设置只回答目标IP地址是来访网络接口本地地址的ARP查询请求 echo "1" > /proc/sys/net/ipv4/conf/lo/arp_ignore echo "1" > /proc/sys/net/ipv4/conf/all/arp_ignore # 为了保险自己可以查看一下是否成功修改 cat /proc/sys/net/ipv4/conf/lo/arp_ignore # 设置对查询目标使用最适当的本地地址.在此模式下将忽略这个IP数据包的源地址并尝试选择与能与该地址通信的本地地址.首要是选择所有的网络接口的子网中外出访问子网中包含该目标IP地址的本地地址. 如果没有合适的地址被发现,将选择当前的发送网络接口或其他的有可能接受到该ARP回应的网络接口来进行发送. echo "2" > /proc/sys/net/ipv4/conf/lo/arp_announce echo "2" > /proc/sys/net/ipv4/conf/all/arp_announce # 使得上面的配置立即生效 sysctl -p

创建网卡别名与添加路由

只有目的 IP 是本机器中的一员时才会做相应的处理,所以需要添加网卡别名(172.17.0.10是虚拟出来,和我docker容器的ip是通一段 2个server的docker ip是172.17.0.6/7):

apt-get install network-manager # 配置虚拟IP ifconfig lo:0 172.17.0.10 broadcast 172.17.0.10 netmask 255.255.255.255 up #172.17.0 和docker0 相同网段 # 添加路由,因为本就是相同的网段所以可以不添加该路由 route add -host 172.17.0.10 dev lo:0 service network-manager restart

配置一台 LoadBalancer 环境:

docker attach LoadBalancer apt-get update apt install net-tools apt-get install ipvsadm ifconfig eth0:0 172.17.0.10:80 netmask 255.255.255.0 up ipvsadm -A -t 172.17.0.10:80 -s rr # 定义集群服务 ipvsadm -a -t 172.17.0.10:80 -r 172.17.0.6 -g # 添加 RealServer1 ipvsadm -a -t 172.17.0.10:80 -r 172.17.0.7 -g # 添加 RealServer2 ipvsadm -l # 查看 ipvs 定义的规则 #-g:定义为 DR 模式

测试结果(如果强制刷新没有变化 就把对应的nginx关闭再看看)

参考:

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· Linux系列:如何用heaptrack跟踪.NET程序的非托管内存泄露

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构