hdfs会出现的一些问题

实训的第一篇博客献给坑了我的hdfs……

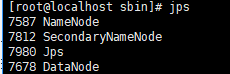

由于电脑的原因,突然花屏,虚拟机来不及挂起。之后发现50070端口进不去,查看jps进程发现没有namenode

先用stop-all.sh命令再start还是不可以

通过查阅资料发现只能格式化namenode,有的解决方法提到由于节点默认配置在linux的临时目录tmp中,所以要修改配置文件core-site.xml

增加节点hadoop.tmp.dir

<property>

<name>hadoop.tmp.dir</name>

<value>/hadoop/tmp</value>

</property>

其中value值的目录根据自己指定

但是当时配置的时候配过了……所以就很纠结不知道为什么

目前认为是由于没有关闭集群就直接关闭了服务器,但是还没有进行验证(不想再经历一次了,一共15天的实训都第8天了出问题我的小心脏受不了啊),之后安个虚拟机重新配一下再看吧……

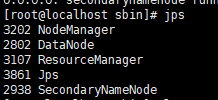

之后用hadoop namenode -format命令进行格式化namenode,之后重新启动hdfs,查看进程发现……datanode起不来了

造成可以增加文件、增加目录却不可以写文件

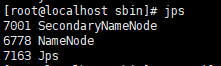

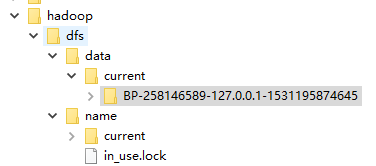

最后的解决办法是 删除hadoop.tmp.dir节点配置的目录下的 data下的version,删除那个文件。重启,最后终于都能启动。

data下的version,删除那个文件。重启,最后终于都能启动。