Linux 下spark安装

一.安装前提:

1.java环境(jdk1.8)

2.scala环境(2.0)

3.python 环境(3.5) :注如果使用pyspark的话,这个才是必须的。

二、spark安装

在官网下载安装包:http://spark.apache.org/downloads.html

创建并进入目录:/usr/software/spark目录下

cd /usr/software/spark wget https://www.apache.org/dyn/closer.lua/spark/spark-2.2.0/spark-2.2.0-bin-hadoop2.7.tgz

解压安装包:

tar -xf spark-***-bin-hadoop**.tgz(对应着你下载的版本号)

更新profile文件:

sudo vi ~/etc/profile

在profile文件中配置spark的环境变量

#SET SPARK_HOME export SPARK_HOME=/usr/software/spark/spark-2.2.0-bin-hadoop2.7 export PATH=$SPARK_HOME/bin:$PATH

注:路径 SPARK_HOME=/usr/software/spark/spark-2.2.0-bin-hadoop2.7 中的

spark-2.2.0-bin-hadoop2.7 是解压后的目录

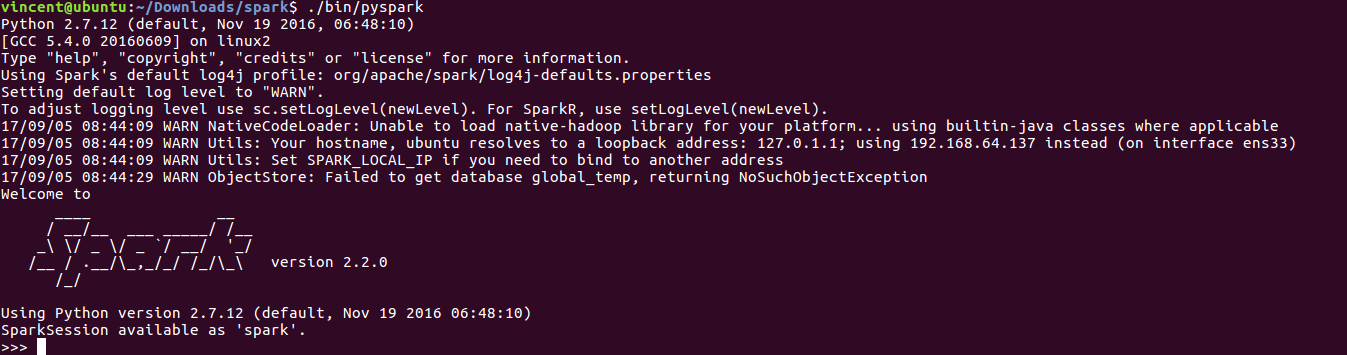

三、运行pyspark

进入spark安装位置, 然后进入spark中的 bin 文件夹

cd /usr/software/spark/spark-2.2.0-bin-hadoop2.7 /bin pyspark

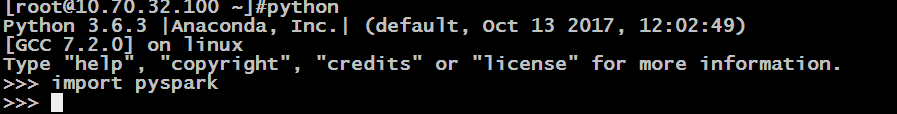

若是想用python程序直接启动pyspark的话,需要在/etc/profile文件中配置如下:

# python can call pyspark directly export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/pyspark:$SPARK_HOME/python/lib/py4j-0.10.4-src.zip:$PYTHONPATH

此时已配置好。

四:注意事项

自己当时安装时,出现了一个java.notfoundclass的异常,这个是配置问题。导致无法启动pyspark。

解决方法:

在/etc/host文件中绑定主机名和主机地址

主机名:127.0.0.1

主机地址:10.70.31.100 root@xxx后的XXX

问题的解决地址 :https://stackoverflow.com/questions/23353477/trouble-installing-pyspark