2017.11.15 hashmap的工作原理

参考来自:http://blog.csdn.net/jeffleo/article/details/54946424

一 hashMap的基本概念

1.HashMap的定义

public class HashMap<K,V> extends AbstractMap<K,V> implements Map<K,V>, Cloneable, Serializable

HashMap继承自AbstractMap,AbstractMap是Map接口的骨干实现,AbstractMap中实现了Map中最重要最常用和方法。而在这里仍然实现Map结构,没有什么作用,应该是为了让map的层次结构更加清晰。

2.HashMap的成员变量

1 int DEFAULT_INITIAL_CAPACITY = 16:默认的初始容量为16 2 int MAXIMUM_CAPACITY = 1 << 30:最大的容量为 2 ^ 30 3 float DEFAULT_LOAD_FACTOR = 0.75f:默认的加载因子为 0.75f 4 Entry<K,V>[] table:Entry类型的数组,HashMap用这个来维护内部的数据结构,它的长度由容量决定 5 int size:HashMap的大小 6 int threshold:HashMap的极限容量,扩容临界点(容量和加载因子的乘积)

3.HashMap的构造函数

1 public HashMap():构造一个具有默认初始容量 (16) 和默认加载因子 (0.75) 的空 HashMap 2 public HashMap(int initialCapacity):构造一个带指定初始容量和默认加载因子 (0.75) 的空 HashMap 3 public HashMap(int initialCapacity, float loadFactor):构造一个带指定初始容量和加载因子的空 HashMap 4 public HashMap(Map< ? extends K, ? extends V> m):构造一个映射关系与指定 Map 相同的新 HashMap

HashMap 的实例有两个参数影响其性能:初始容量和加载因子。

初始容量:哈希表在创建时的容量,实际上就是Entry< K,V>[] table的容量。

加载因子 :是哈希表在其容量自动增加之前可以达到多满的一种尺度。它衡量的是一个散列表的空间的使用程度,加载因子越大表示散列表的装填程度越高,反之愈小。对于使用链表法的散列表来说,查找一个元素的平均时间是O(1+a),因此如果加载因子越大,对空间的利用更充分,然而后果是查找效率的降低;如果负载因子太小,那么散列表的数据将过于稀疏,对空间造成严重浪费。系统默认负载因子为0.75,一般情况下我们是无需修改的。

当哈希表中的条目数超出了加载因子与当前容量的乘积时,则要对该哈希表进行 rehash 操作(即重建内部数据结构),从而哈希表将具有大约两倍的桶数。

二 HashMap的数据结构

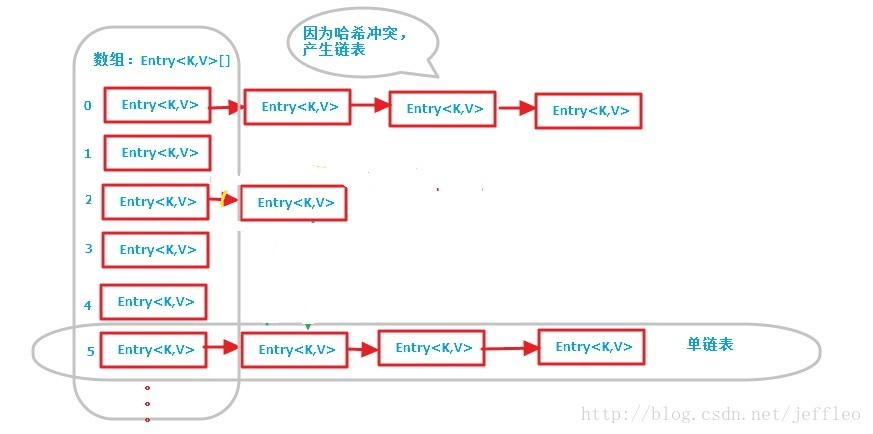

1. 数据结构的图示

从上图我们可以看出HashMap底层实现还是数组,只是数组的每一项都是一条链。其中参数initialCapacity就代表了该数组的长度。

2.HashMap构造函数的源码

1 public HashMap(int initialCapacity, float loadFactor) { 2 //容量不能小于0 3 if (initialCapacity < 0) 4 throw new IllegalArgumentException("Illegal initial capacity: " + initialCapacity); 5 //容量不能超出最大容量 6 if (initialCapacity > MAXIMUM_CAPACITY) 7 initialCapacity = MAXIMUM_CAPACITY; 8 //加载因子不能<=0 或者 为非数字 9 if (loadFactor <= 0 || Float.isNaN(loadFactor)) 10 throw new IllegalArgumentException("Illegal load factor: " + 11 loadFactor); 12 13 //计算出大于初始容量的最小2的n次方作为哈希表table的长度,下面会说明为什么要这样 14 int capacity = 1; 15 while (capacity < initialCapacity) 16 capacity <<= 1; 17 18 this.loadFactor = loadFactor; 19 //设置HashMap的容量极限,当HashMap的容量达到该极限时就会进行扩容操作 20 threshold = (int)Math.min(capacity * loadFactor, MAXIMUM_CAPACITY + 1); 21 //创建Entry数组 22 table = new Entry[capacity]; 23 useAltHashing = sun.misc.VM.isBooted() && 24 (capacity >= Holder.ALTERNATIVE_HASHING_THRESHOLD); 25 init(); 26 }

可以看到,这个构造函数主要做的事情就是:

1 对传入的容量和加载因子进行判断处理 2 设置HashMap的容量极限 3 计算出大于初始容量的最小2的n次方作为哈希表table的长度,然后用该长度创建Entry数组(table),这个是最核心的。

这里用到了Entry数组。

Entry是HashMap的一个内部类,它也是维护着一个key-value映射关系,除了key和value,还有next引用(该引用指向当前table位置的链表),hash值(用来确定每一个Entry链表在table中位置)。

Entry的内部实现如下:

1 static class Entry<K,V> implements Map.Entry<K,V> { 2 final K key; 3 V value; 4 Entry<K,V> next; 5 int hash; 6 7 /** 8 * Creates new entry. 9 */ 10 Entry(int h, K k, V v, Entry<K,V> n) { 11 value = v; 12 next = n; 13 key = k; 14 hash = h; 15 } 16 }

三 HashMap的存储实现put(k,v)

1.过程概述

1 传入key和value,判断key是否为null,如果为null,则调用putForNullKey,以null作为key存储到哈希表中; 2 然后计算key的hash值,根据hash值搜索在哈希表table中的索引位置。

3 若当前索引位置不为null,则对该位置的Entry链表进行遍历。

如果链中存在该key,则用传入的value覆盖掉旧的value,同时把旧的value返回,结束; 4 否则调用addEntry,用key-value创建一个新的节点,并把该节点插入到该索引对应的链表的头部。

2.源码解读

1 public V put(K key, V value) { 2 //如果key为空的情况 3 if (key == null) 4 return putForNullKey(value); 5 //计算key的hash值 6 int hash = hash(key); 7 //计算该hash值在table中的下标,即计算bucketIndex 8 int i = indexFor(hash, table.length); 9 //对table[i]存放的链表进行遍历 10 for (Entry<K,V> e = table[i]; e != null; e = e.next) { 11 Object k; 12 //判断该条链上是否有hash值相同的(key相同) 13 //若存在相同,则直接覆盖value,返回旧value 14 if (e.hash == hash && ((k = e.key) == key || key.equals(k))) { 15 V oldValue = e.value; 16 e.value = value; 17 e.recordAccess(this); 18 return oldValue; 19 } 20 } 21 22 //修改次数+1 23 modCount++; 24 //把当前key,value添加到table[i]的链表中 25 addEntry(hash, key, value, i); 26 return null; 27 } 28 }

(1) 如果为null,则调用putForNullKey:这就是为什么HashMap可以用null作为键的原因。

1 private V putForNullKey(V value) { 2 //查找链表中是否有null键 3 for (Entry<K,V> e = table[0]; e != null; e = e.next) { 4 if (e.key == null) { 5 V oldValue = e.value; 6 e.value = value; 7 e.recordAccess(this); 8 return oldValue; 9 } 10 } 11 modCount++; 12 //如果链中查找不到,则把该null键插入 13 addEntry(0, null, value, 0); 14 return null; 15 }

(2)如果链中存在该key,则用传入的value覆盖掉旧的value,同时把旧的value返回:这就是为什么HashMap不能有两个相同的key的原因。

HashMap中,首先计算key的hash值,然后通过hash值获得bucketIndex。

1 final int hash(Object k) { 2 int h = 0; 3 if (useAltHashing) { 4 if (k instanceof String) { 5 return sun.misc.Hashing.stringHash32((String) k); 6 } 7 h = hashSeed; 8 } 9 10 h ^= k.hashCode(); 11 h ^= (h >>> 20) ^ (h >>> 12); 12 return h ^ (h >>> 7) ^ (h >>> 4); 13 }

1 static int indexFor(int h, int length) { 2 return h & (length-1); 3 }

对于HashMap的table而言,数据分布需要均匀(最好每项都只有一个元素,这样就可以直接找到),不能太紧也不能太松,太紧会导致查询速度慢,太松则浪费空间。计算hash值后,怎么才能保证table元素分布均与呢?

可以采用取模的方式。但是由于取模的消耗较大,HashMap是通过&运算符(按位与操作)来实现的:h & (length-1)。在构造函数中存在:capacity <<= 1,这样做总是能够保证HashMap的底层数组长度为2的n次方。当length为2的n次方时,h&(length - 1)就相当于对length取模,而且速度比直接取模快得多。即等价不等效。

所以说当length = 2^n时,不同的hash值发生碰撞的概率比较小,这样就会使得数据在table数组中分布较均匀,查询速度也较快。

在获得bucketIndex之后,调用addEntry将key-value插入到该索引的联表中。首先取得bucketIndex位置的Entry头结点,并创建新节点,把该新节点插入到链表中的头部,该新节点的next指针指向原来的头结点 。

其中addEntry:

1 void addEntry(int hash, K key, V value, int bucketIndex) { 2 //如果size大于极限容量,将要进行重建内部数据结构操作,之后的容量是原来的两倍,并且重新设置hash值和hash值在table中的索引值 3 if ((size >= threshold) && (null != table[bucketIndex])) { 4 resize(2 * table.length); 5 hash = (null != key) ? hash(key) : 0; 6 bucketIndex = indexFor(hash, table.length); 7 } 8 //真正创建Entry节点的操作 9 createEntry(hash, key, value, bucketIndex); 10 }

1 void createEntry(int hash, K key, V value, int bucketIndex) { 2 Entry<K,V> e = table[bucketIndex]; 3 table[bucketIndex] = new Entry<>(hash, key, value, e); 4 size++; 5 }

系统总是将新的Entry对象添加到bucketIndex处。如果bucketIndex处已经有了对象,那么新添加的Entry对象将指向原有的Entry对象,形成一条Entry链,但是若bucketIndex处没有Entry对象,也就是e==null,那么新添加的Entry对象指向null,也就不会产生Entry链了。

(3)扩容问题

threshold是容器的容量极限,size是HashMap中键值对的数量,也就是node的数量。当不断添加key-value,size大于了容量极限threshold时,会发生扩容。扩容发生在resize方法中,也就是扩大数组(桶)的数量,如何扩容参考:http://blog.csdn.net/jeffleo/article/details/63684953

threshold = (int)Math.min(capacity * loadFactor, MAXIMUM_CAPACITY + 1);

四 HashMap的读取实现get(key, value)

1.过程概述

1 调用hash(key)求得key的hash值。

2 然后调用indexFor(hash)求得hash值对应的table的索引位置。

3 然后遍历索引位置的链表,如果存在key,则把key对应的Entry返回,否则返回null。

2.源码解读

1 public V get(Object key) { 2 //如果key为null,求null键 3 if (key == null) 4 return getForNullKey(); 5 // 用该key求得entry 6 Entry<K,V> entry = getEntry(key); 7 8 return null == entry ? null : entry.getValue(); 9 } 10 11 final Entry<K,V> getEntry(Object key) { 12 int hash = (key == null) ? 0 : hash(key); 13 for (Entry<K,V> e = table[indexFor(hash, table.length)]; e != null; e = e.next) { 16 Object k; 17 if (e.hash == hash &&((k = e.key) == key || (key != null && key.equals(k)))) 19 return e; 20 } 21 return null; 22 }

五 HashMap键的遍历

HashMap遍历时,按哈希表的每一个索引的链表从上往下遍历,由于HashMap的存储规则,最晚添加的节点都有可能在第一个索引的链表中,这就造成了HashMap的遍历时无序的。

1 private abstract class HashIterator<E> implements Iterator<E> { 2 Entry<K,V> next; // next entry to return 3 int expectedModCount; // For fast-fail 4 int index; // current slot 5 Entry<K,V> current; // current entry 6 7 //当调用keySet().iterator()时,调用此代码 8 HashIterator() { 9 expectedModCount = modCount; 10 if (size > 0) { // advance to first entry 11 Entry[] t = table; 12 //从哈希表数组从上到下,查找第一个不为null的节点,并把next引用指向该节点 13 while (index < t.length && (next = t[index++]) == null); 15 } 16 } 17 18 public final boolean hasNext() { 19 return next != null; 20 } 21 22 //当调用next时,会调用此代码 23 final Entry<K,V> nextEntry() { 24 if (modCount != expectedModCount) 25 throw new ConcurrentModificationException(); 26 Entry<K,V> e = next; 27 if (e == null) 28 throw new NoSuchElementException(); 29 30 //如果当前节点的下一个节点为null,从节点处罚往下查找哈希表,找到第一个不为null的节点 31 if ((next = e.next) == null) { 32 Entry[] t = table; 33 while (index < t.length && (next = t[index++]) == null); 35 } 36 current = e; 37 return e; 38 } 39 40 public void remove() { 41 if (current == null) 42 throw new IllegalStateException(); 43 if (modCount != expectedModCount) 44 throw new ConcurrentModificationException(); 45 Object k = current.key; 46 current = null; 47 HashMap.this.removeEntryForKey(k); 48 expectedModCount = modCount; 49 } 50 }

浙公网安备 33010602011771号

浙公网安备 33010602011771号