摘要:

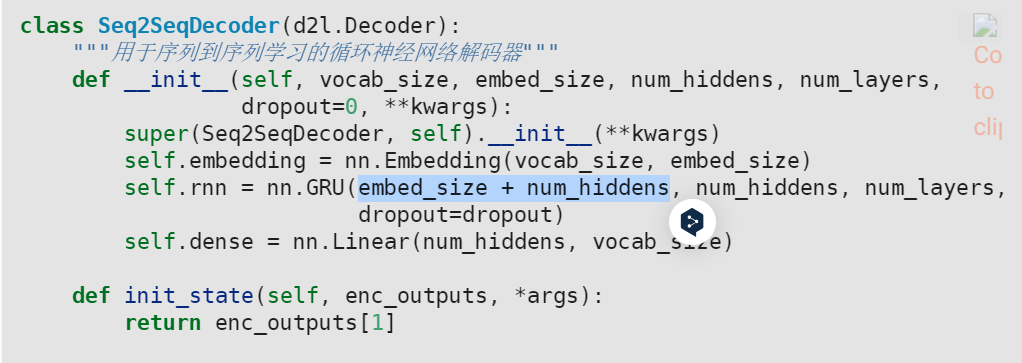

## 问题来源 【d2l】9.7 序列到序列学习