HIVE UDF 加密加密函数

一、AES算法

AES(Advanced Encryption Standard)即高级加密标准,是一种对称加密算法,被广泛应用于数据加密和保护领域。AES算法使用的密钥长度为128位、192位或256位,比DES算法的密钥长度更长,安全性更高

二、自定义UDF加解密函数

利用AES算法自定义UDF函数,实现在Hive中数据的加密解密功能

三、代码实现

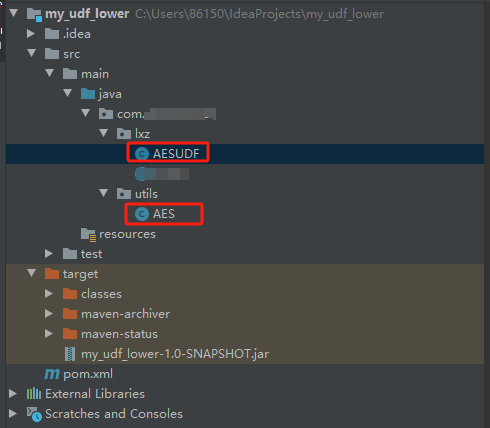

1)MAVEN项目架构

2)POM依赖

<dependency>

<groupId>org.apache.hive</groupId>

<artifactId>hive-exec</artifactId>

<version>3.1.3</version>

</dependency>

3)创建utils工具类

import sun.misc.BASE64Decoder; import sun.misc.BASE64Encoder; import javax.crypto.*; import javax.crypto.spec.SecretKeySpec; import java.io.IOException; import java.nio.charset.StandardCharsets; import java.security.InvalidKeyException; import java.security.NoSuchAlgorithmException; import java.security.SecureRandom; public class AES { public static final String ENCODE_RULES = "8DFC34B0B7C98EFA0A299A6C3FFFBD9D"; /* * 加密 * 1.构造密钥生成器 * 2.根据ecnodeRules规则初始化密钥生成器 * 3.产生密钥 * 4.创建和初始化密码器 * 5.内容加密 * 6.返回字符串 */ public static String AESEncode(String encodeRules,String content){ try { //1.构造密钥生成器,指定为AES算法,不区分大小写 KeyGenerator keygen=KeyGenerator.getInstance("AES"); //2.根据ecnodeRules规则初始化密钥生成器 //生成一个128位的随机源,根据传入的字节数组 SecureRandom random = SecureRandom.getInstance("SHA1PRNG"); random.setSeed(encodeRules.getBytes()); keygen.init(128, random); //3.产生原始对称密钥 SecretKey original_key=keygen.generateKey(); //4.获得原始对称密钥的字节数组 byte [] raw=original_key.getEncoded(); //5.根据字节数组生成AES密钥 SecretKey key=new SecretKeySpec(raw, "AES"); //6.根据指定算法AES自成密码器 Cipher cipher=Cipher.getInstance("AES"); //7.初始化密码器,第一个参数为加密(Encrypt_mode)或者解密解密(Decrypt_mode)操作,第二个参数为使用的KEY cipher.init(Cipher.ENCRYPT_MODE, key); //8.获取加密内容的字节数组(这里要设置为utf-8)不然内容中如果有中文和英文混合中文就会解密为乱码 byte [] byte_encode=content.getBytes(StandardCharsets.UTF_8); //9.根据密码器的初始化方式--加密:将数据加密 byte [] byte_AES=cipher.doFinal(byte_encode); //10.将加密后的数据转换为字符串 //这里用Base64Encoder中会找不到包 //解决办法: //在项目的Build path中先移除JRE System Library,再添加库JRE System Library,重新编译后就一切正常了。 //11.将字符串返回 return new BASE64Encoder().encode(byte_AES); } catch (BadPaddingException e) { e.printStackTrace(); } catch (NoSuchPaddingException e) { e.printStackTrace(); } catch (NoSuchAlgorithmException e) { e.printStackTrace(); } catch (IllegalBlockSizeException e) { e.printStackTrace(); } catch (InvalidKeyException e) { e.printStackTrace(); } //如果有错就返加nulll return null; } /* * 解密 * 解密过程: * 1.同加密1-4步 * 2.将加密后的字符串反纺成byte[]数组 * 3.将加密内容解密 */ public static String AESDncode(String encodeRules,String content){ try { //1.构造密钥生成器,指定为AES算法,不区分大小写 KeyGenerator keygen=KeyGenerator.getInstance("AES"); //2.根据ecnodeRules规则初始化密钥生成器 //生成一个128位的随机源,根据传入的字节数组 SecureRandom random = SecureRandom.getInstance("SHA1PRNG"); random.setSeed(encodeRules.getBytes()); keygen.init(128, random); //3.产生原始对称密钥 SecretKey original_key=keygen.generateKey(); //4.获得原始对称密钥的字节数组 byte [] raw=original_key.getEncoded(); //5.根据字节数组生成AES密钥 SecretKey key=new SecretKeySpec(raw, "AES"); //6.根据指定算法AES自成密码器 Cipher cipher=Cipher.getInstance("AES"); //7.初始化密码器,第一个参数为加密(Encrypt_mode)或者解密(Decrypt_mode)操作,第二个参数为使用的KEY cipher.init(Cipher.DECRYPT_MODE, key); //8.将加密并编码后的内容解码成字节数组 byte [] byte_content= new BASE64Decoder().decodeBuffer(content); /* * 解密 */ byte [] byte_decode=cipher.doFinal(byte_content); return new String(byte_decode, StandardCharsets.UTF_8); } catch (Exception e) { e.printStackTrace(); } //如果有错就返加nulll return null; } }

4)创建UDF

import com.utils.AES; import org.apache.hadoop.hive.ql.exec.UDF; public class AESUDF extends UDF { String password = "8DFC34B0B7C98EFA0A299A6C3FFFBD9D"; public String evaluate(String type, String content) throws Exception { if (content == null) return null; if (!type.equals("encode") && !type.equals("decode")) { throw new Exception("Parmeter one is needed encode/decode"); } if (type.equals("encode")) { //进行加密 return AES.AESEncode(password, content); } else { //进行解密 return AES.AESDncode(password, content); } } // public static void main(String[] args) throws Exception { // AESUDF ase = new AESUDF(); // System.out.println(ase.evaluate("encode", "hello world")); // System.out.println(ase.evaluate("decode","uW6YH6mvckQxBATpfJbMnw==")); // } }

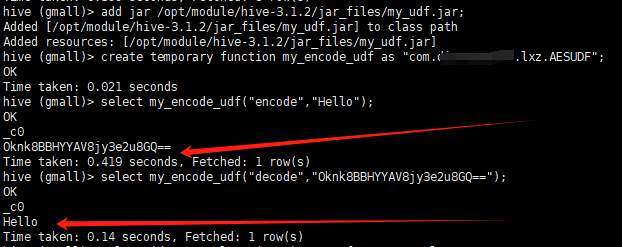

5)打包并上传到服务器进行测试

5.1)启动hadoop、hive并把jar上传到 /opt/module/hive-3.1.2/jar_files/my_udf.jar;

5.2)在hive中进行临时函数注册 add jar /opt/module/hive-3.1.2/jar_files/my_udf.jar;

5.3)创建临时函数名称并绑定java class; create temporary function my_encode_udf as "com.lxz.AESUDF";

5.4)进行测试

不要为了追逐,而忘记当初的样子。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 分享一个免费、快速、无限量使用的满血 DeepSeek R1 模型,支持深度思考和联网搜索!

· 基于 Docker 搭建 FRP 内网穿透开源项目(很简单哒)

· ollama系列01:轻松3步本地部署deepseek,普通电脑可用

· 按钮权限的设计及实现

· 25岁的心里话