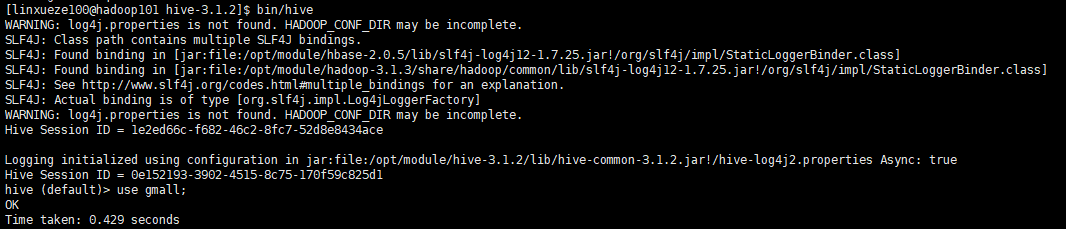

hive执行是报错WARNING: log4j.properties is not found.

一、原因是找不到log4文件了,和hadoop上的连接断了。这时候想创建外表的时候就会报错。

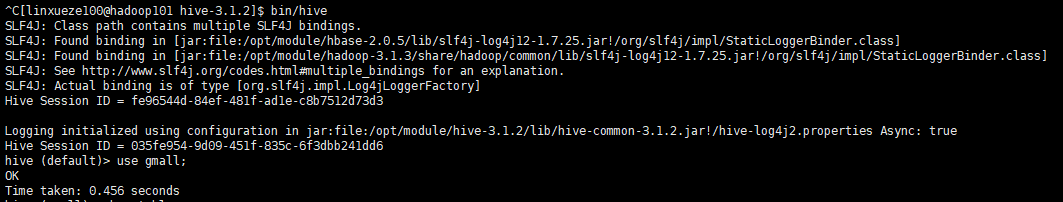

1.启动hive时报错 (刚启动hive2服务的时候,立刻登录是不通过的,需要等一会)

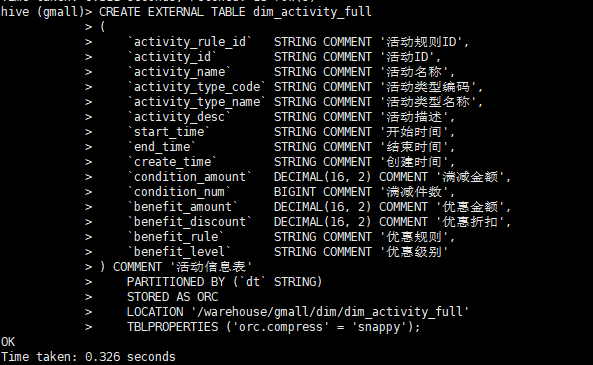

2.建表时不通过。

二、问题遇到的前景回顾。

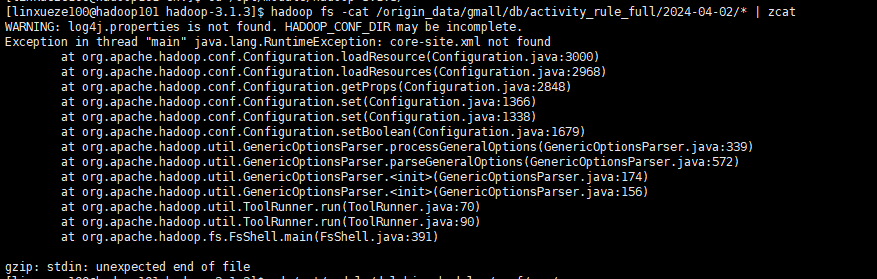

之前一直好好的,是安装dolphinscheduler后,突然就怪起来了。先是hadoop fs -cat命令不通过,这个时候的报错就已经指向HADOOP_CONF_DIR了。那就意味着出问题的可能有下面几个方向

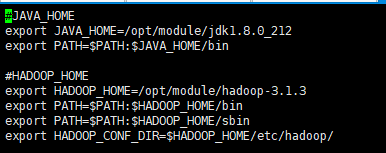

1. 环境变量 /etc/profile.d/my_env.sh

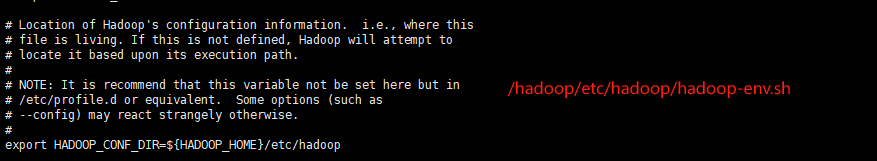

2.hadoop配置文件 /hadoop-3.1.3/etc/hadoop/hadoop-env.sh

这里资料说先执行下 echo $HADOOP_CONF_DIR 看看出不出来东西,没出来就是没指向,要去检查三个文件 hadoop_env.sh、yarn_env.sh、mapreduce_env.sh都加上‘export $HADOOP_CONF_DIR=/hadoop-3.1.3/etc/hadoop'

但是我只是在hadoop-env.sh里打开修改了这个参数。

3.hadoop目录下确实log4.properties文件。这个时候就去$HADOOP_HOME目录下自己 vi 一个log4 文件 内容如下 (不过个人觉得跟这个没关系,总觉得不是hadoop的问题,应该是hive的问题)

# Set root logger level to ERROR and its only appender to A1. log4j.rootLogger=ERROR, A1 # A1 is set to be a ConsoleAppender. log4j.appender.A1=org.apache.log4j.ConsoleAppender # A1 uses PatternLayout. log4j.appender.A1.layout=org.apache.log4j.PatternLayout log4j.appender.A1.layout.ConversionPattern=%-4r [%t] %-5p %c %x - %m%n

三、修复

以上几点都做完后,关闭hive2服务,重启hadoop 和yarn服务,在此进入hive客户端,就好了。

没有在显示WARNING了。hive建表也通过了。

不要为了追逐,而忘记当初的样子。