《机器学习基石》第4节课学习笔记

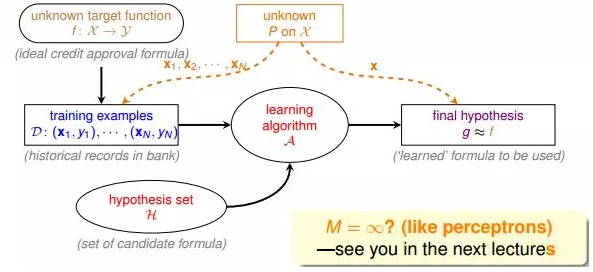

第4节课 Feasibility of Learning

- 本节课主要学习了机器学习的可行性,讨论问题是否可以使用机器学习来解决。引用了许多事例,还引用了概率论的知识。有一些专业名词,像Hoeffding's inequality,PAC,引用到的两个值Ein(h)和Eout(h),还有Bad Data的情况。在这次的学习中,我对于Hoeffding's inequality 的式子理解起来有点费力,需要加强学习。

1. NFL准则:没有免费的午餐。

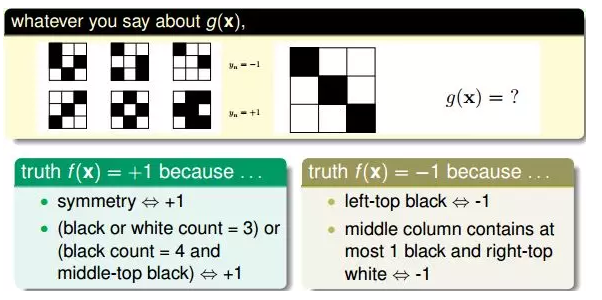

下图中不同的理解有不同的分类准则和答案。比如说我认为黑色格和白色格的分布,分布对称的是1,不对称的是-1,那么根据这一理解,g(x)=1;

但换种理解方法,第一个格是黑色的是-1,是白色的是1,那么g(x)=-1。

明显看出,理解不一样,g(x)的答案不一样。

这个例子告诉我们,我们想要在D以外的数据中更接近目标函数似乎是做不到的,只能保证对D有很好的分类结果。机器学习的这种特性被称为没有免费午餐(No Free Lunch)定理。NFL定理表明没有一个学习算法可以在任何领域总是产生最准确的学习器。不管采用何种学习算法,至少存在一个目标函数,能够使得随机猜测算法是更好的算法。平常所说的一个学习算法比另一个算法更“优越”,效果更好,只是针对特定的问题,特定的先验信息,数据的分布,训练样本的数目,代价或奖励函数等。

- 解决这一问题需要做出合理的假设。

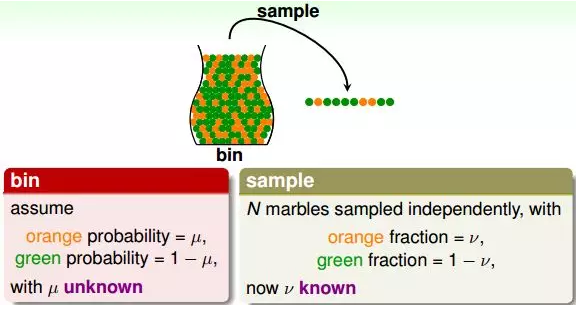

2. 罐子选小球理论。用到了概率论和统计。

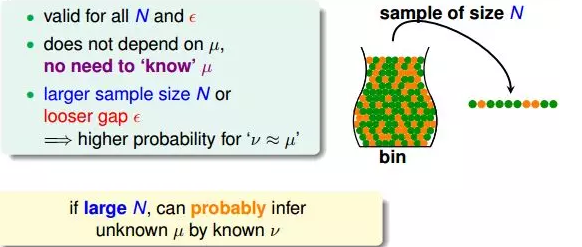

如果有一个装有很多(数量很大数不过来)橙色球和绿色球的罐子,能不能推断橙色球的比例u?统计学上的做法是,从罐子中随机取出N个球,作为样本,计算这N个球中橙色球的比例v,那么就估计出罐子中橙色球的比例约为v。

但是这种随机抽取的做法能否说明罐子里橙色球的比例一定是v呢?答案是否定的。但是从概率的角度来说,样本中的v很有可能接近我们未知的u。下面是从数学推导的角度来看v与u是否相近。

样本概率v和总体概率u:

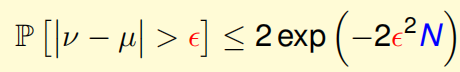

已知u是罐子里橙色球的比例,v是N个抽取的样本中橙色球的比例。当N足够大的时候,v接近于u。这就是Hoeffding's inequality(难点):

Hoeffding不等式说明当N很大的时候,v与u相差不会很大,它们之间的差值被限定在ϵ之内。我们把结论v=u称为probably approximately correct(PAC)。

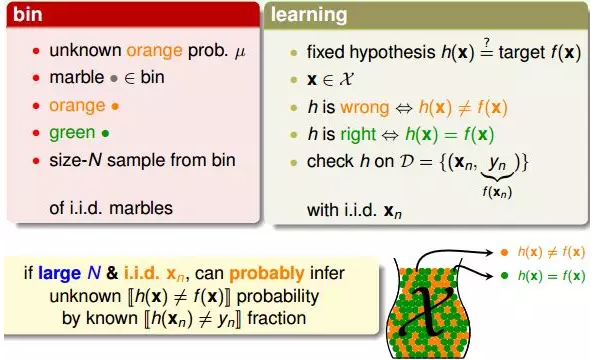

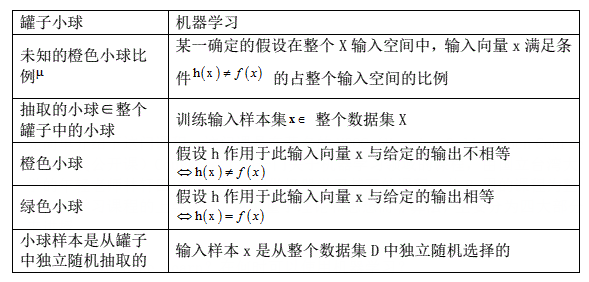

3.罐子理论与学习问题的联系

对于一个固定的假设h,我们需要验证它的错误率;然后根据验证结果选择最好的。

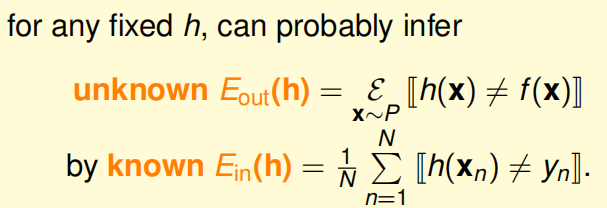

这里我们引入两个值Ein(h)和Eout(h)。Ein(h)表示在抽样样本中,h(x)与yn不相等的概率;Eout(h)表示实际所有样本中,h(x)与f(x)不相等的概率是多少。

同样,它的Hoeffding’s inequality可以表示为:

![]()

该不等式表明,Ein(h)=Eout(h)也是PAC的。如果Ein(h)≈Eout(h),Ein(h)很小,那么就能推断出Eout(h)很小,也就是说在该数据分布P下,h与f非常接近,机器学习的模型比较准确。

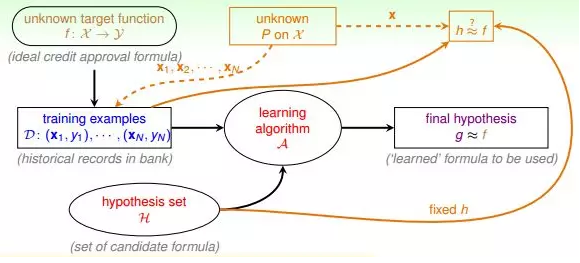

一般地,h如果是固定的,N很大的时候,Ein(h)≈Eout(h),但是并不意味着g≈f。因为h是固定的,不能保证Ein(h)足够小,即使Ein(h)≈Eout(h),也可能使Eout(h)偏大。所以,一般会通过演算法A,选择最好的h,使Ein(h)足够小,从而保证Eout(h)很小。固定的h,使用新数据进行测试,验证其错误率是多少。

4.实际情况中有下面的问题:

上图如果抽到的样本全是绿色球,并不能说明总体全是绿色球;同理扔硬币如果扔了好几次全是正面,并不能说明正面的概率大。

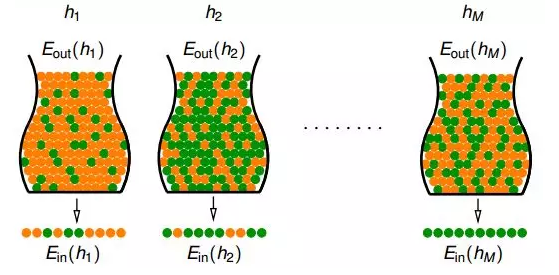

当罐子数目很多或者抛硬币的人数很多的时候,可能引发Bad Sample,Bad Sample就是Ein和Eout差别很大,即选择过多带来的负面影响,选择过多会恶化不好的情形。

根据许多次抽样的到的不同的数据集D,Hoeffding’s inequality保证了大多数的D都是比较好的情形(即对于某个h,保证Ein≈Eout),但是也有可能出现Bad Data,即Ein和Eout差别很大的数据集D,这是小概率事件。

根据Hoeffding’s inequality,Bad Data的上界可以表示为连级(union bound)的形式:

其中,M是hypothesis的个数,当N足够大,发生BAD sample的概率就非常小。

所以,如果hypothesis的个数M是有限的,N足够大,那么通过演算法A任意选择一个矩g,都有Ein≈Eout成立;同时,如果找到一个矩g,使Ein≈0,PAC就能保证Eout≈0。至此,就证明了机器学习是可行的。