《机器学习基石》第2节课学习笔记

第2节课 Learning to Answer Yes/No

- 本节课主要学习了二分类法和感知机Perceptron模型,视频中推导了课程的第一个机器学习算法:Perceptron Learning Algorithm(PLA)。这一部分明显对比出和第一节课的不同,这一部分开始更加深入机器学习的核心,算法很重要(我需要先理解一遍理论知识,学习完《机器学习基石》理论的东西,就要开始逐一探索学习每个算法的流程及代码,多动手实践和思考)

2.1 Perceptron Hypothesis Set(模型的选择)

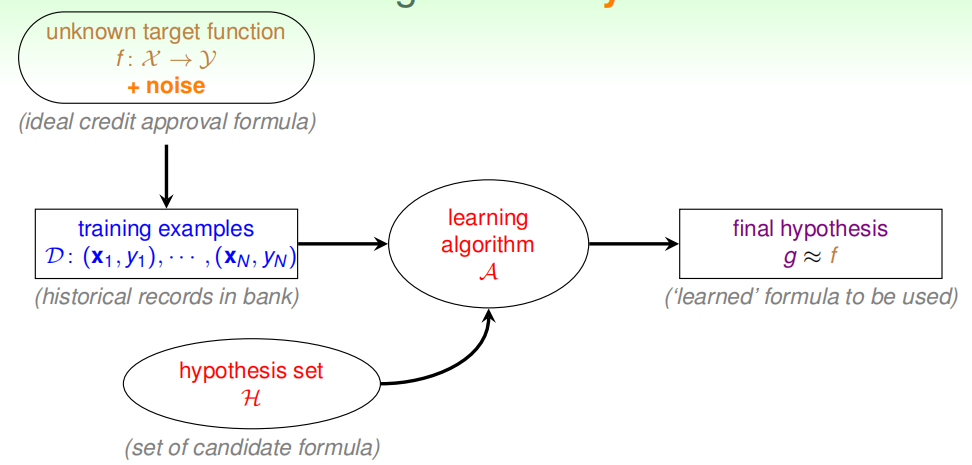

(1)开始用了这样一个例子:某银行要根据用户的年龄、性别、年收入等情况来判断是否给该用户发信用卡。现在有训练样本D,即之前用户的信息和是否发了信用卡。这是一个经典的机器学习问题,要根据D,通过A,在H中选择最好的h,得到g,接近目标函数f,也就是根据过去的数据进行分析,从而建立是否给用户发信用卡的模型。银行用这个模型对以后用户进行判断:发信用卡(+1),不发信用卡(-1)。在这里用到了二分类法。

在这一过程中,模型选择特别重要,即Hypothesis Set。选择什么样的模型,这个会很大程度上会影响机器学习的效果和表现。

(2)一个常用模型:感知机(Perceptron)。(这一部分很重要,下面会引出感知器算法)

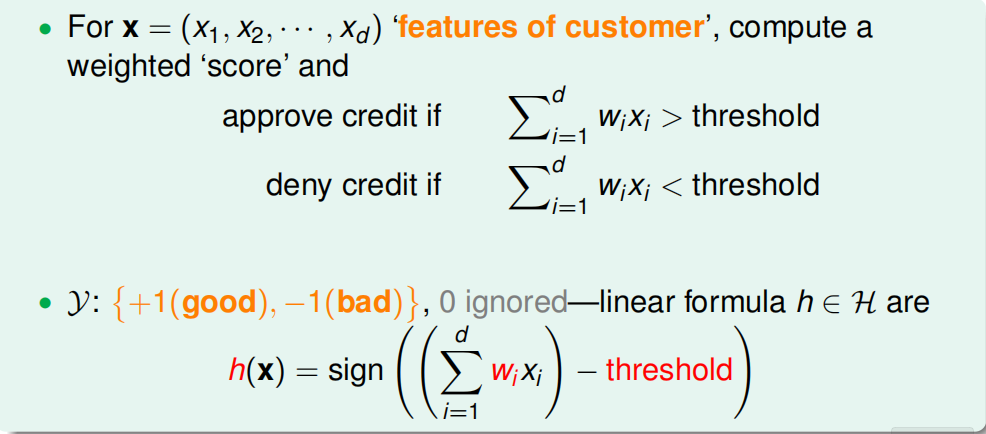

用刚才的银行发信用卡的例子,把用户的个人信息作为特征向量x,令总共有d个特征,每个特征赋予不同的权重w,表示该特征对输出(是否发信用卡)的影响有多大。那所有特征的加权和的值与一个设定的阈值threshold进行比较:大于这个阈值,输出为+1,即发信用卡;小于这个阈值,输出为-1,即不发信用卡。这里对于阈值的理解就好比考试中60分及格,而所有特征的加权值的值好比答对题所获得的分数相加起来,最终判断是否及格。

感知机模型,就是当特征加权和与阈值的差大于或等于0,则输出h(x)=1;当特征加权和与阈值的差小于0,则输出h(x)=-1,而我们的目的就是计算出所有权值w和阈值threshold。

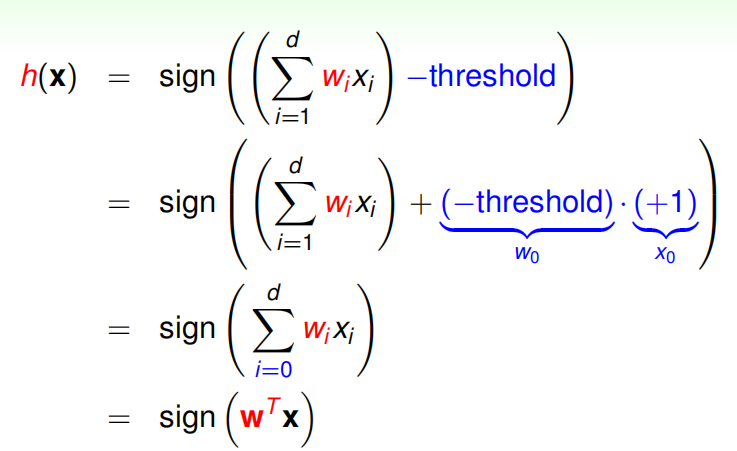

为了计算方便,通常我们将阈值threshold当做w0,引入一个x0=1的量与w0相乘,这样就把threshold也转变成了权值w0,简化了计算。h(x)的表达式做如下变换:

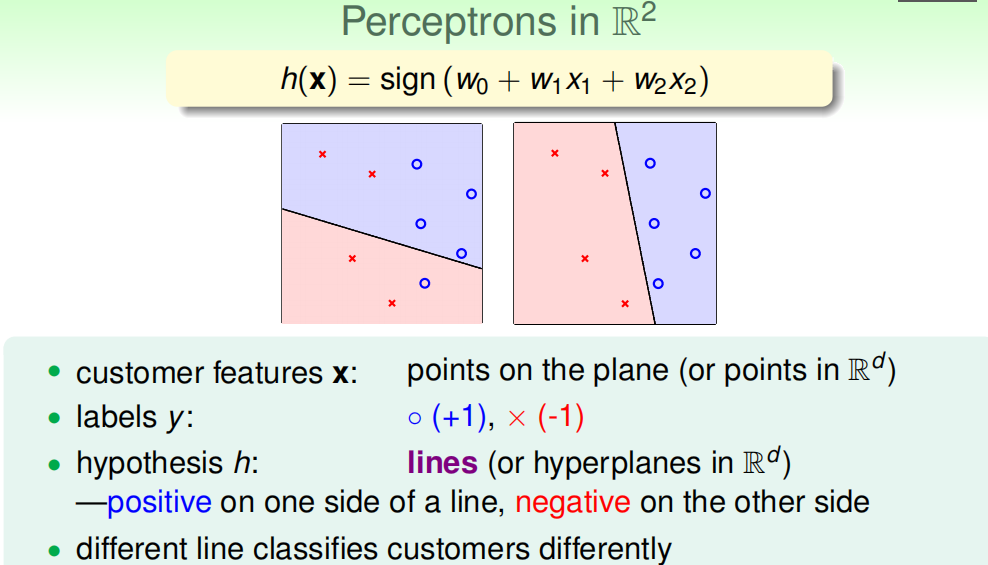

为了更清晰地说明感知机模型,我们假设Perceptrons在二维平面上,即h(x)=sign(w0+w1x1+w2x2)。其中,w0+w1x1+w2x2=0是平面上一条分类直线,直线一侧是正类(+1),直线另一侧是负类(-1)。权重w不同,对应于平面上不同的直线。

那么,我们所说的Perceptron,在这个模型上就是一条直线,称之为linear(binary) classifiers。我们要根据需要选择最好的一条线。

2.2 Perceptron Learning Algorithm(PLA)(很重要的一个算法)

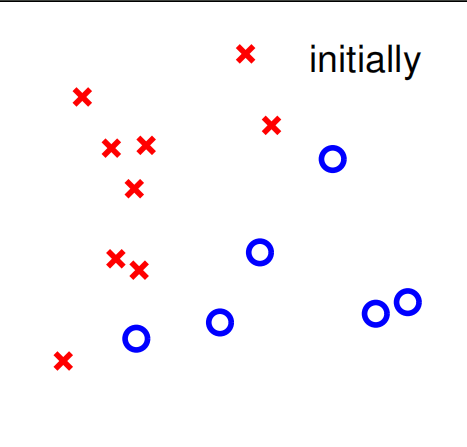

这部分学到了如何设计一个演算法A,来选择一个最好的直线,能将平面上所有的正类和负类完全分开,也就是找到最好的g,使g≈f。

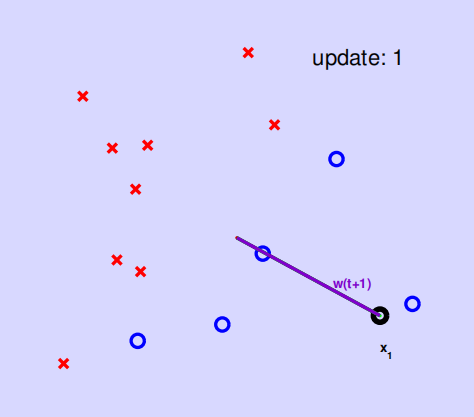

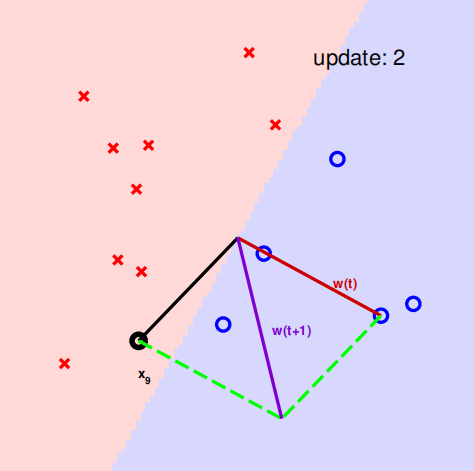

这个过程用到逐点修正的思想,步骤是首先在平面上随意取一条直线,看看哪些点分类错误。然后开始对第一个错误点就行修正,即变换直线的位置,使这个错误点变成分类正确的点。接着,再对第二个、第三个等所有的错误分类点就行直线纠正,直到所有的点都完全分类正确了,就得到了最好的直线。这种“逐步修正”,就是PLA思想所在。可以形象的称为知错能改法。

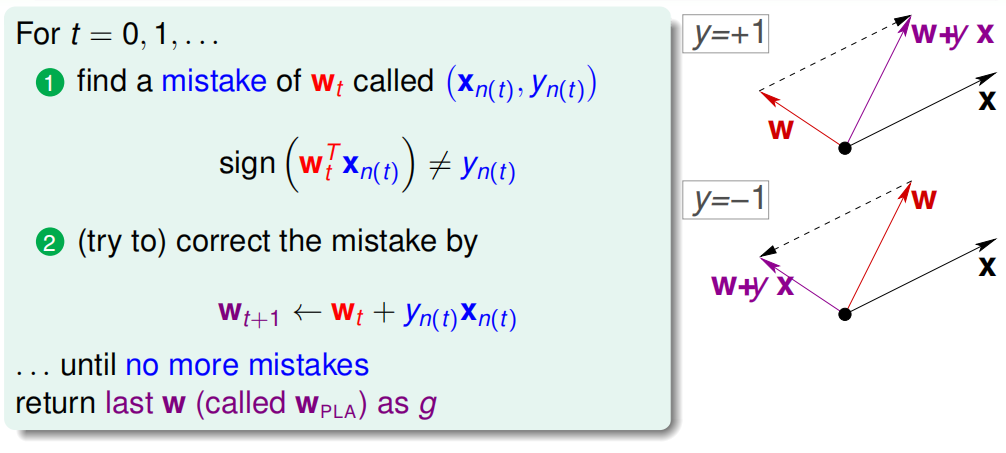

(1)PLA的操作过程:

①首先随机选择一条直线进行分类。然后找到第一个分类错误的点,如果这个点表示正类,被误分为负类,即wTtxn(t)<0,那表示w和x夹角大于90度,其中w是直线的法向量。所以需要让其夹角小于90度,使其得到修正。

②同理,如果是误分为正类的点,即wTtxn(t)>0,那表示w和x夹角小于90度,其中w是直线的法向量。所以需要让其夹角大于90度,使其得到修正。

我认为关键就是找线,调整夹角,做法向量这几点。

③按照这种思想,遇到个错误点就进行修正,不断迭代。要注意一点:每次修正直线,可能使之前分类正确的点变成错误点,这是可能发生的。但是没关系,不断迭代,不断修正,最终会将所有点完全正确分类(PLA前提是线性可分的)。这种做法的思想是“知错能改”。

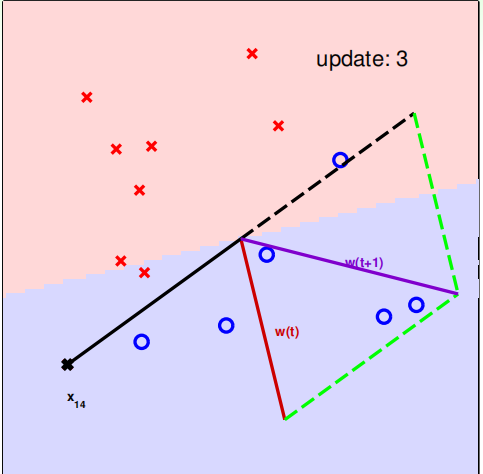

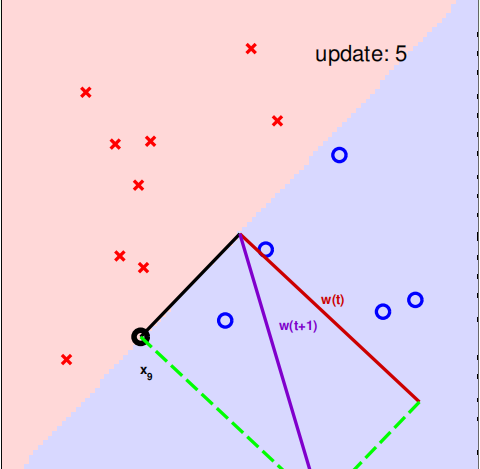

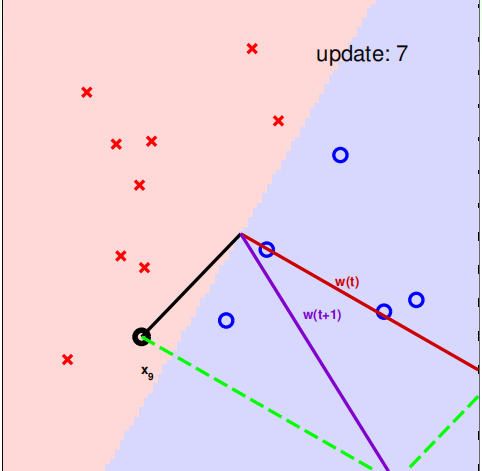

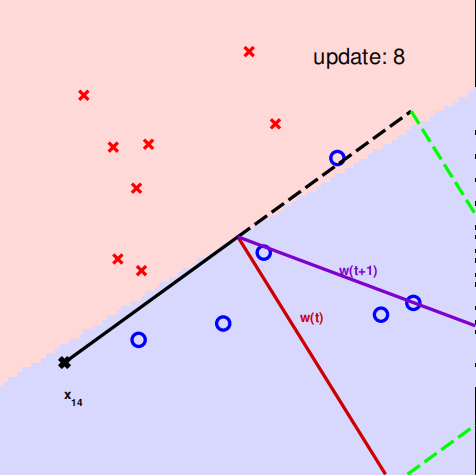

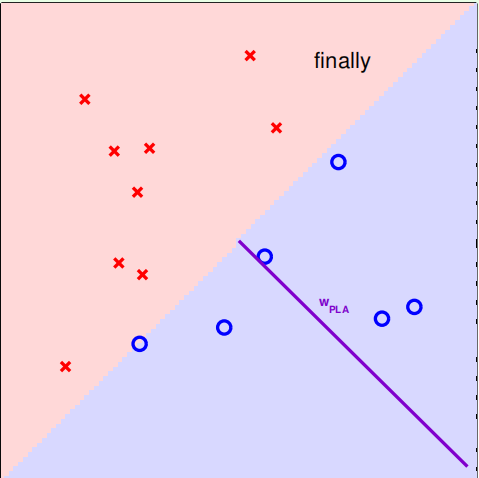

下面用图解的形式来介绍PLA的修正过程:

2.3 Guarantee of PLA(算法的要满足的条件)

考虑到PLA什么时候可以停止,是不是一定要线性可分。

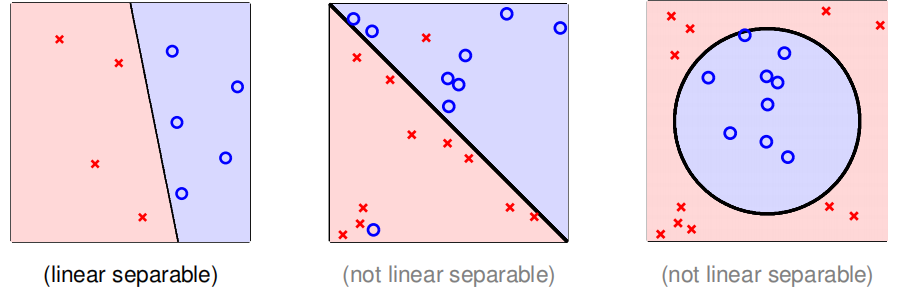

根据PLA的定义,当找到一条直线,能将所有平面上的点都分类正确,那么PLA就停止了。要达到这个终止条件,就必须保证D是线性可分(linear separable)。如果是非线性可分的,那么,PLA就不会停止。

以下部分有点不理解:

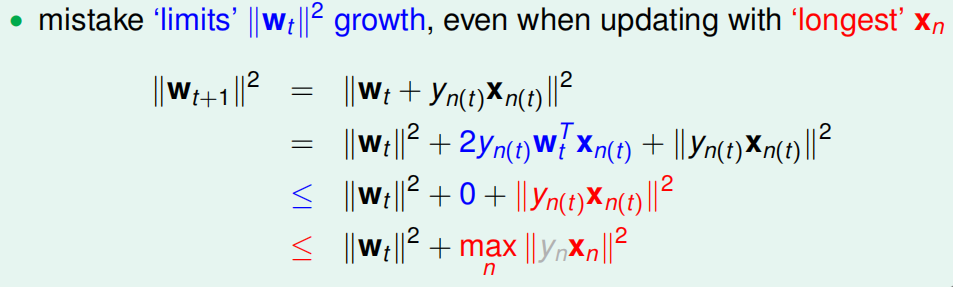

对于线性可分的情况,如果有这样一条直线,能够将正类和负类完全分开,令这时候的目标权重为wf,则对每个点,必然满足yn=sign(wTfxn),即对任一点:

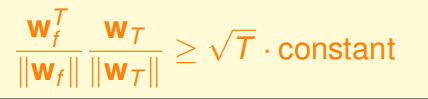

如果令初始权值w0=0,那么经过T次错误修正后,有如下结论:

2.4 Non-Separable Data

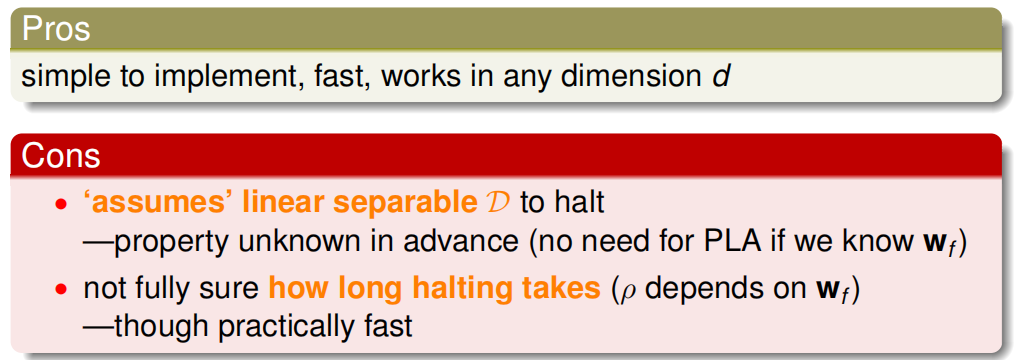

上一部分证明了线性可分的情况下,PLA是可以停下来并正确分类的,但对于非线性可分的情况,PLA不一定会停下来。所以,PLA虽然实现简单,但也有缺点:

对于非线性可分的情况,我们可以把它当成是数据集D中掺杂了一下noise,事实上,大多数情况下我们遇到的D,都或多或少地掺杂了noise。这时,机器学习流程是这样的:

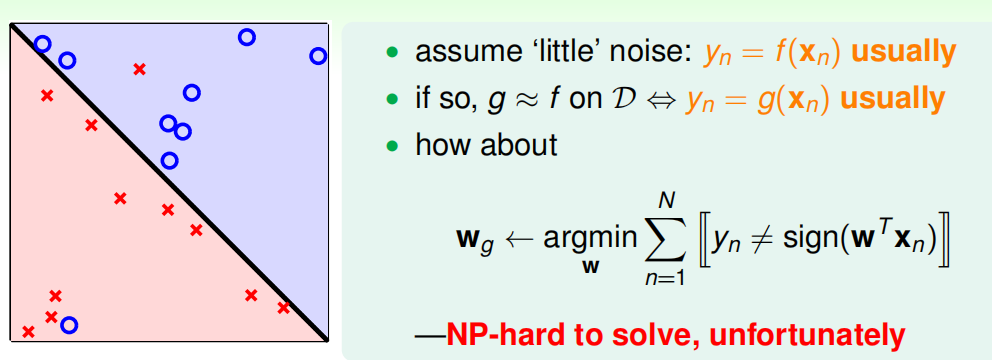

在非线性情况下,我们可以把条件放松,即不苛求每个点都分类正确,而是容忍有错误点,取错误点的个数最少时的权重w:

事实证明,上面的解是NP-hard问题,难以求解。然而,我们可以对在线性可分类型中表现很好的PLA做个修改,把它应用到非线性可分类型中,获得近似最好的g。

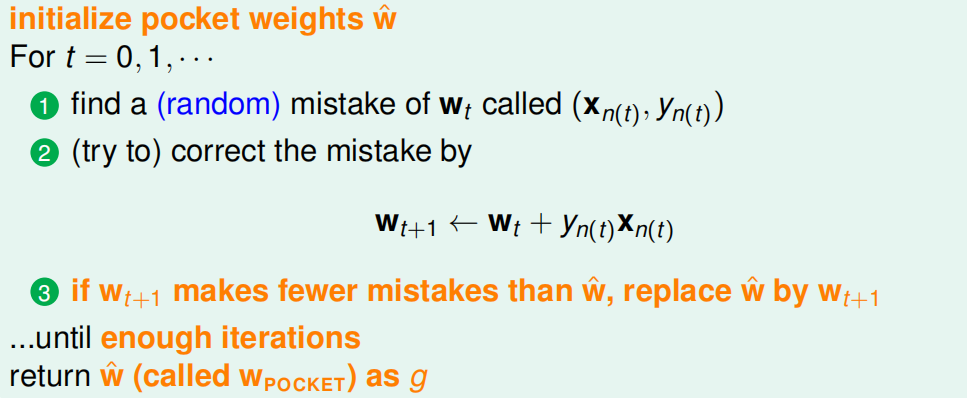

修改后的PLA称为Packet Algorithm。它的算法流程与PLA基本类似,首先初始化权重w0,计算出在这条初始化的直线中,分类错误点的个数。然后对错误点进行修正,更新w,得到一条新的直线,在计算其对应的分类错误的点的个数,并与之前错误点个数比较,取个数较小的直线作为我们当前选择的分类直线。之后,再经过n次迭代,不断比较当前分类错误点个数与之前最少的错误点个数比较,选择最小的值保存。直到迭代次数完成后,选取个数最少的直线对应的w,即为我们最终想要得到的权重值。