Spark-寒假-实验4

1.spark-shell 交互式编程

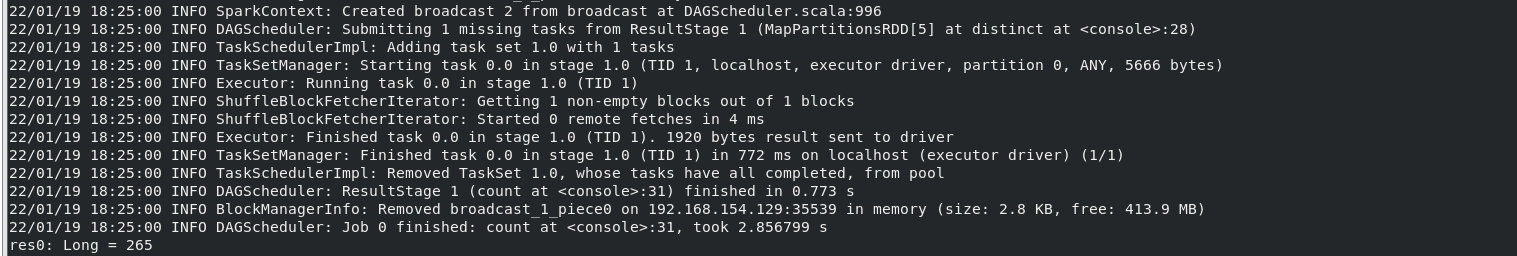

(1)该系总共有多少学生;

执行命令:

结果:

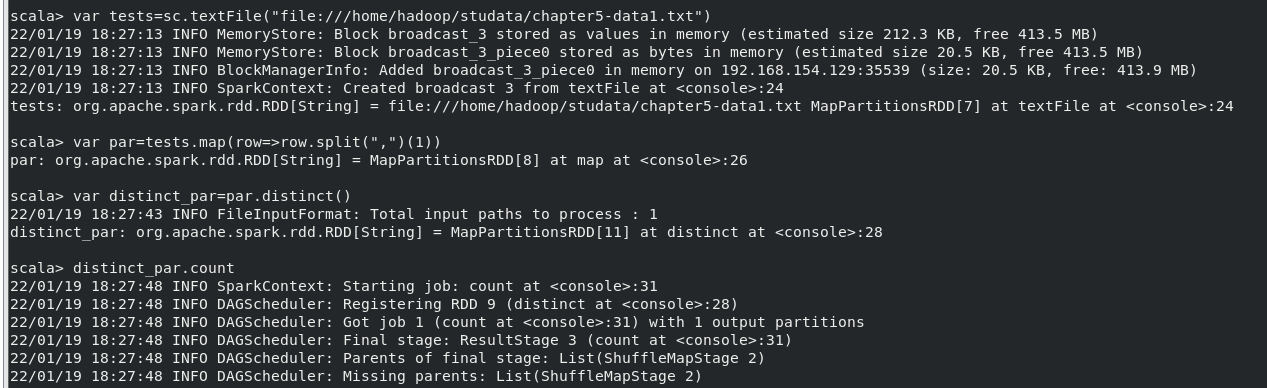

(2)该系共开设来多少门课程;

执行命令:

结果:

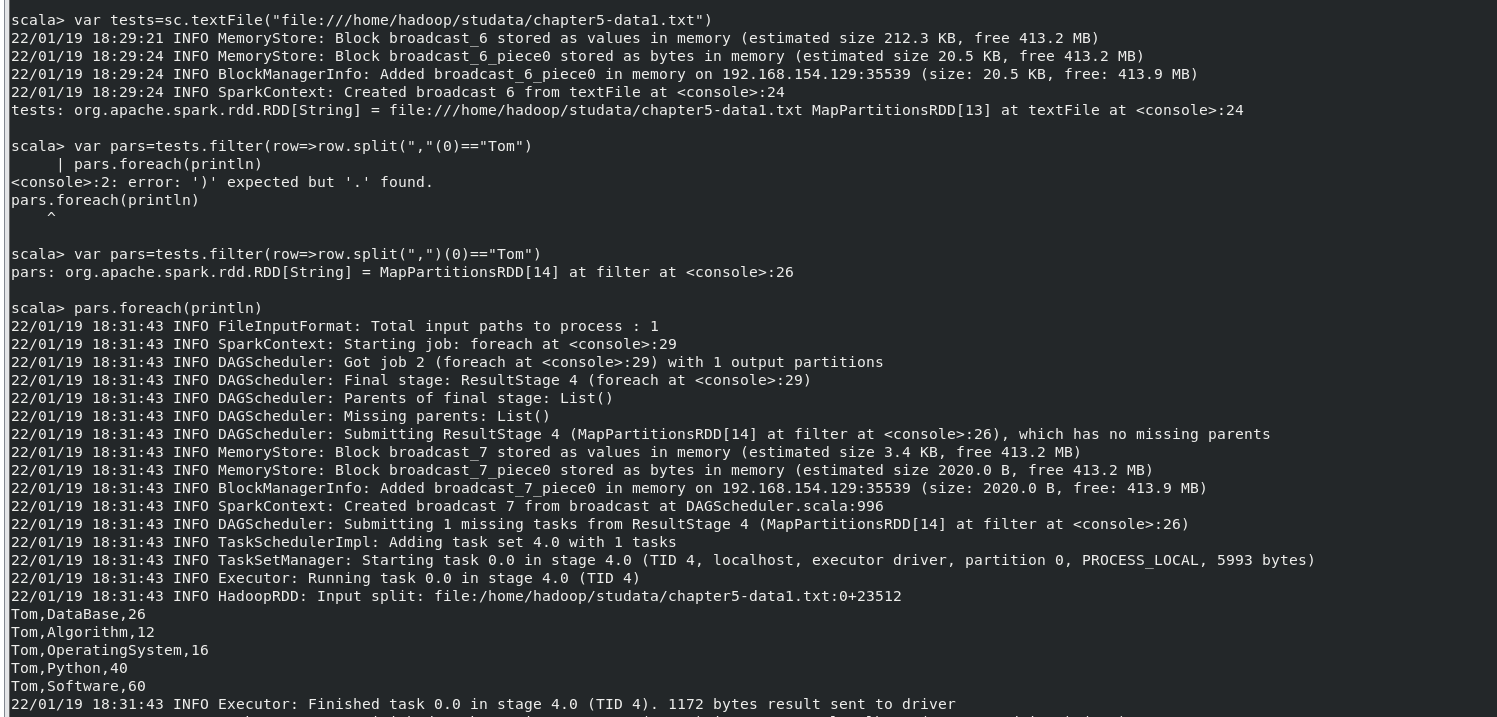

(3)Tom 同学的总成绩平均分是多少;

执行命令:

结果:

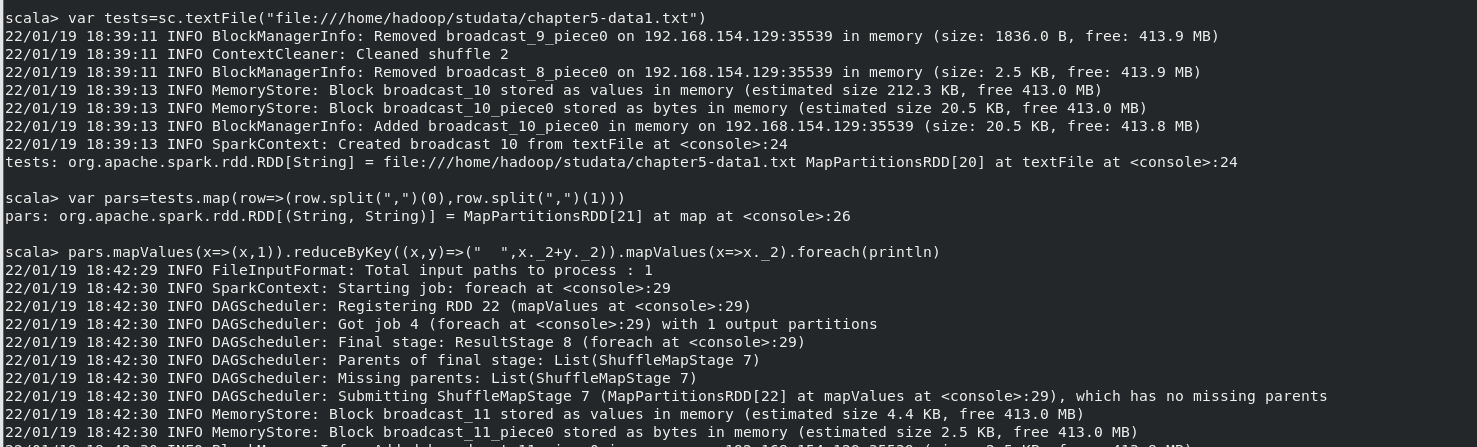

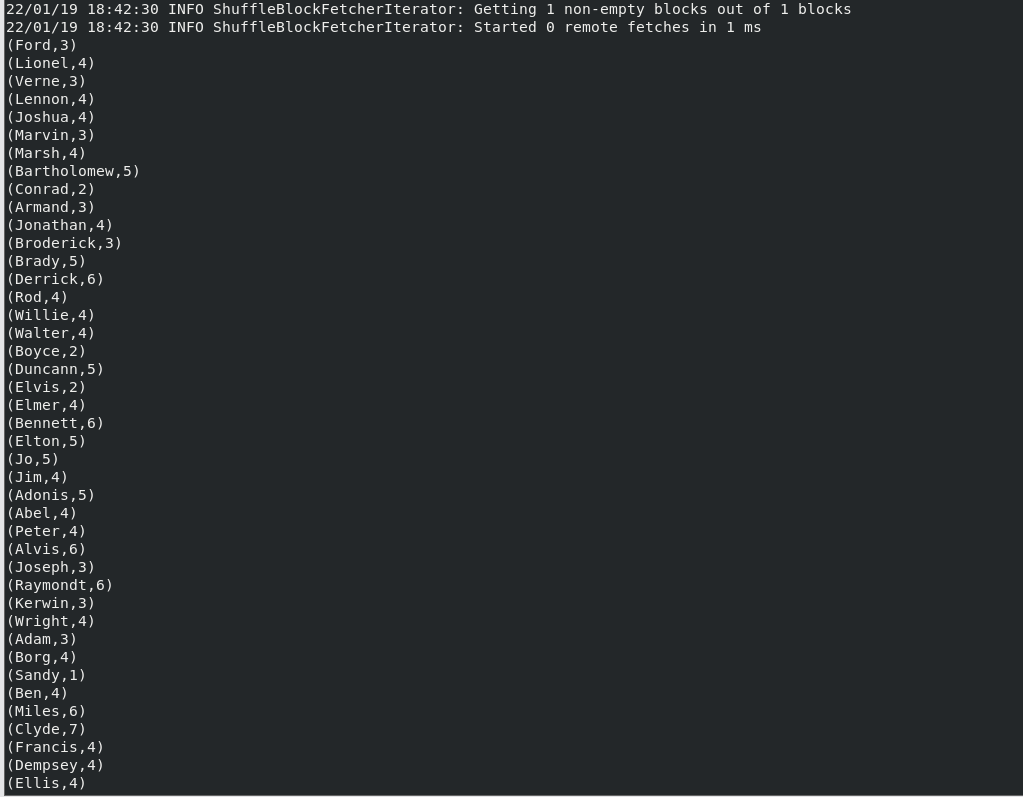

(4)求每名同学的选修的课程门数;

执行命令:

结果(此处仅为部分结果,结果共265项):

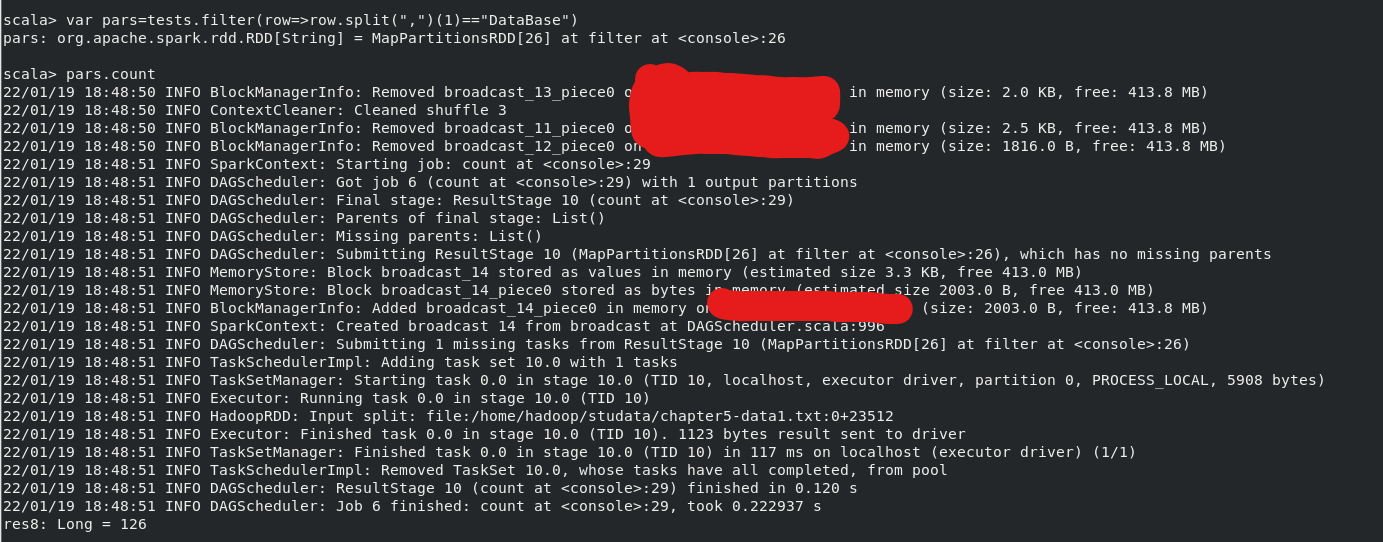

(5)该系 DataBase 课程共有多少人选修;

执行命令(结果最后一行):

(6)各门课程的平均分是多少;

执行命令:

结果:

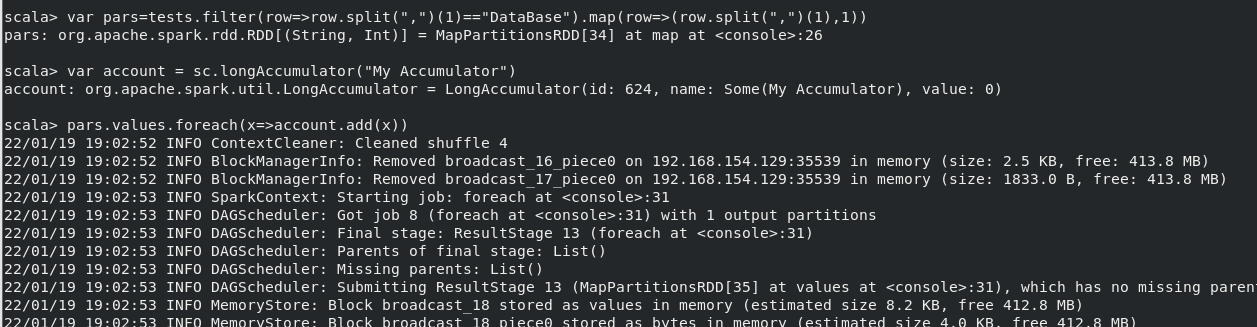

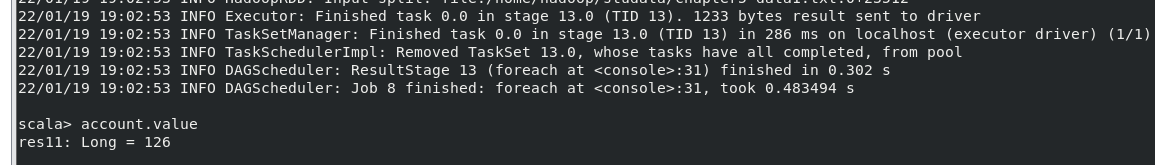

(7)使用累加器计算共有多少人选了 DataBase 这门课。

执行命令:

结果:

2.编写独立应用程序实现数据去重

对于两个输入文件 A 和 B,编写 Spark 独立应用程序,对两个文件进行合并,并剔除其 中重复的内容,得到一个新文件 C。下面是输入文件和输出文件的一个样例,供参考。 输入文件 A 的样例如下:

20170101 x

20170102 y

20170103 x

20170104 y

20170105 z

20170106 z

输入文件 B 的样例如下:

20170101 y

20170102 y

20170103 x

20170104 z

20170105 y

根据输入的文件 A 和 B 合并得到的输出文件 C 的样例如下:

20170101 x

20170101 y

20170102 y

20170103 x

20170104 y

20170104 z

20170105 y

20170105 z

20170106 z

创建项目:

remdup.scala

simple.sbt

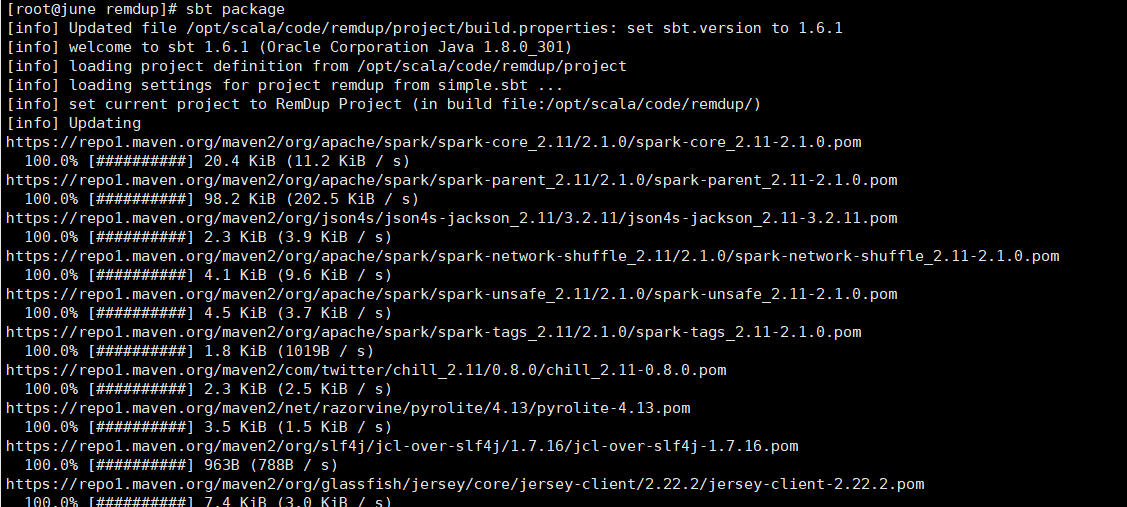

打包项目(sbt的安装请看Spark-寒假-实验3):

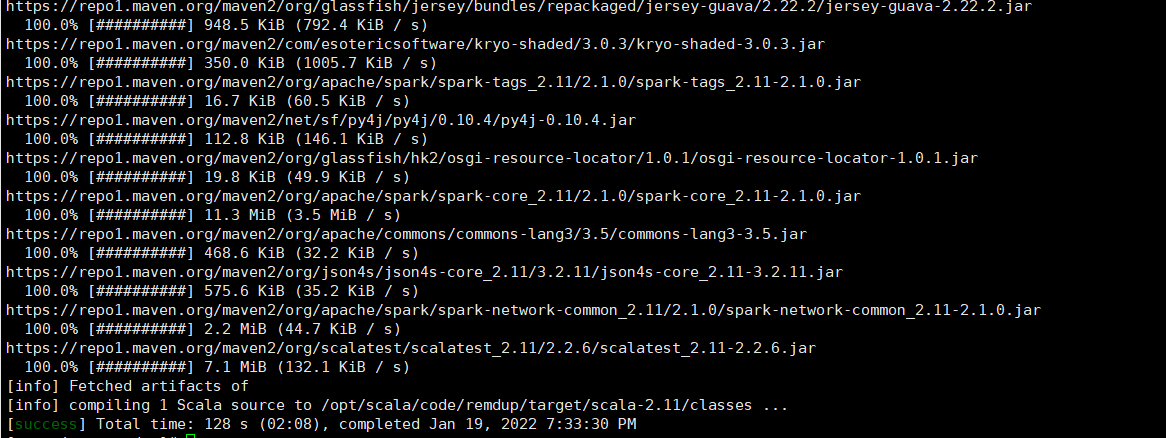

运行jar包:

运行结果:

3.编写独立应用程序实现求平均值问题

创建项目流程同上:

程序代码如下:

average.scala

simple.sbt

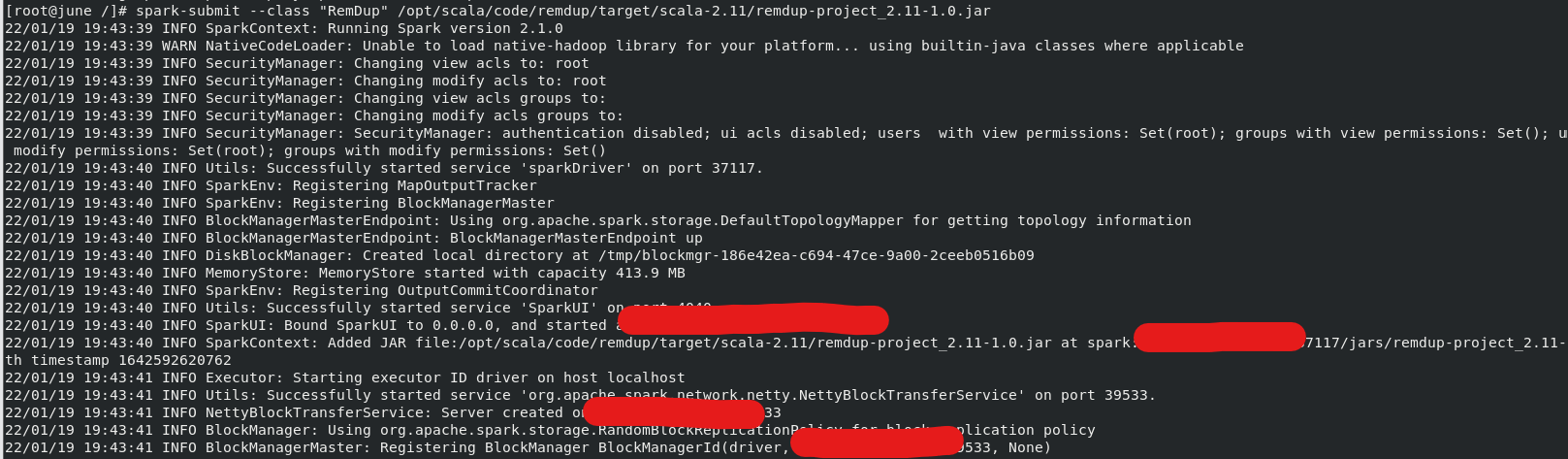

打包项目:

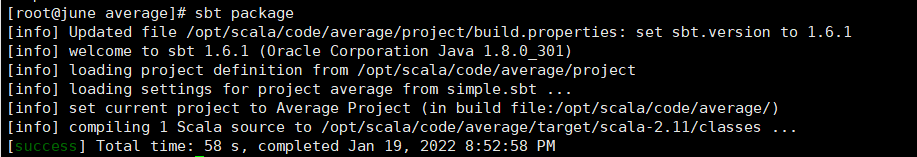

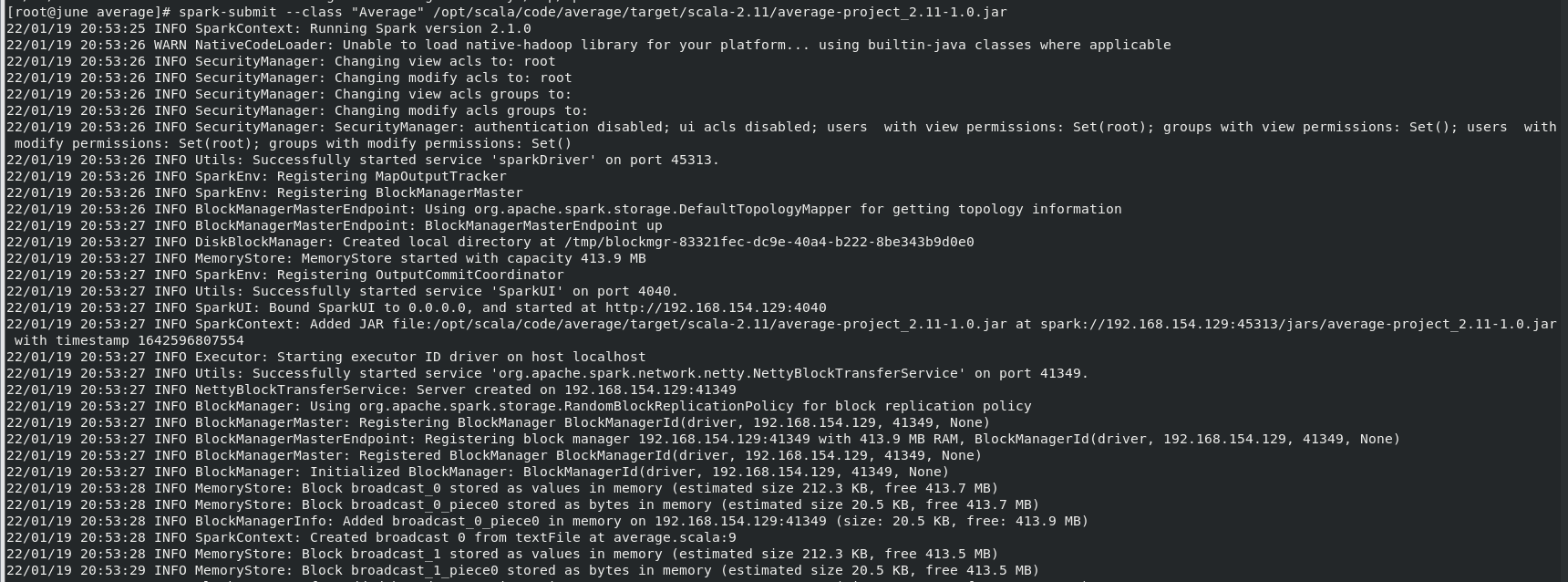

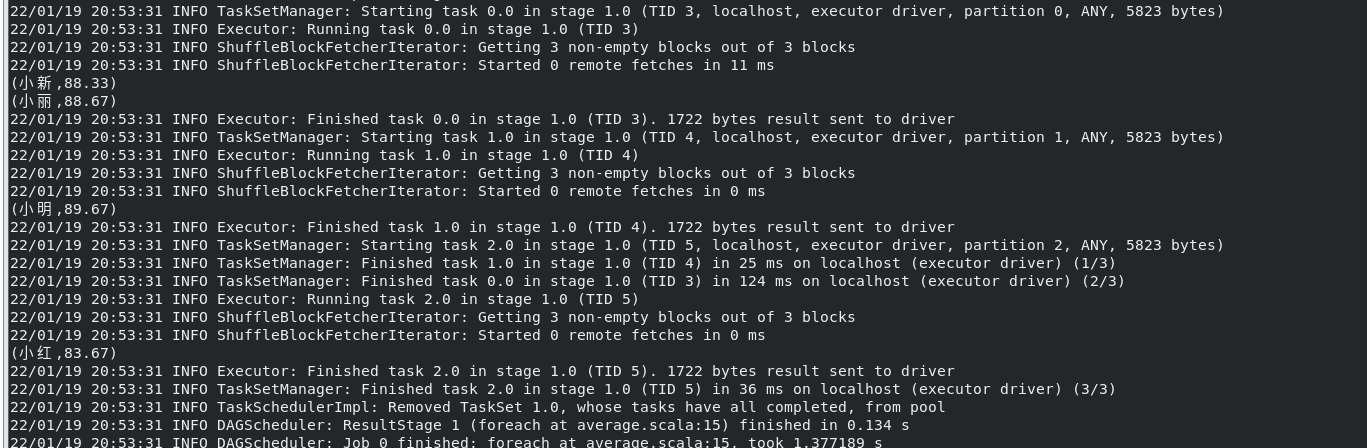

运行jar包:

运行结果:

__EOF__

本文链接:https://www.cnblogs.com/lx06/p/15822517.html

关于博主:评论和私信会在第一时间回复。或者直接私信我。

版权声明:本博客转载请注明出处!

声援博主:如果您觉得文章对您有帮助,可以点击文章右下角【推荐】一下。您的鼓励是博主的最大动力!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

· AI与.NET技术实操系列(六):基于图像分类模型对图像进行分类

2021-01-19 1月19日 学习记录