李宏毅unsupervised learning-Linear Methods(lecturte13)课堂笔记

贴标签,不知道要分成多少类?就要根据经验决定。----->简单介绍K近邻

贴标签,不知道要分成多少类?就要根据经验决定。----->简单介绍K近邻

两两计算相似度(相似度高的两个),切一刀看哪些在一组

两两计算相似度(相似度高的两个),切一刀看哪些在一组

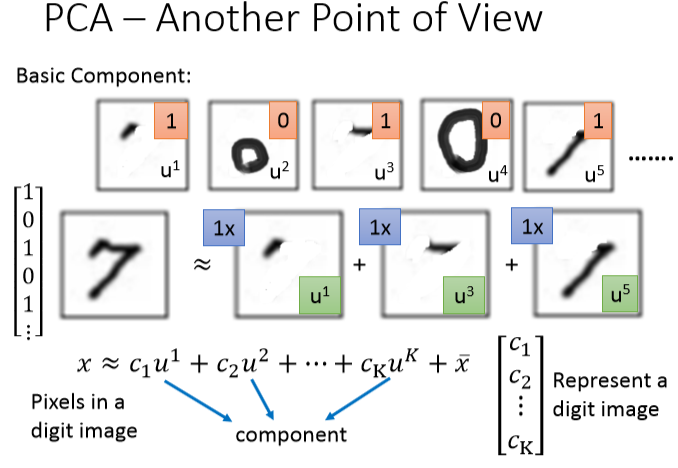

cluster时就是以偏概全,每个object都一定属于某个cluster,但这样太过粗糙,所以要用一个vector表示一个object。

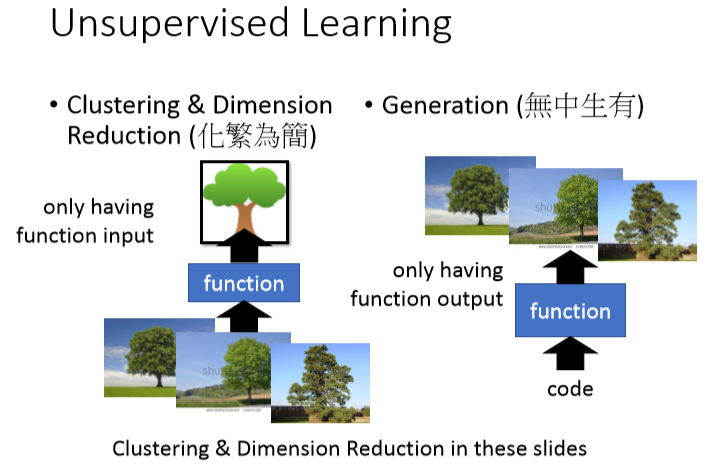

dimension reduction被引入,简介:

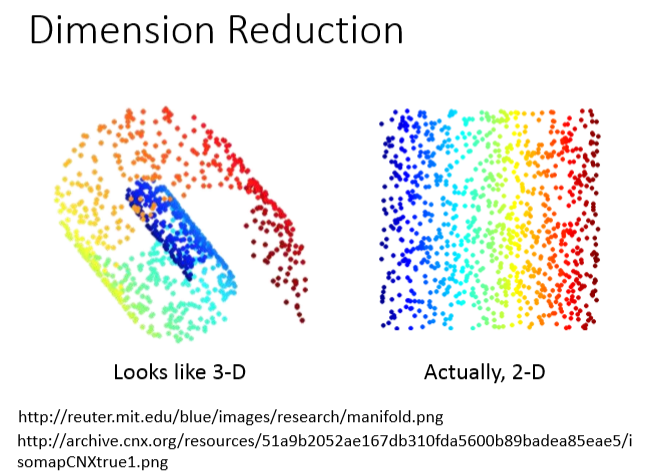

假设三维空间有如图左侧分布,但用三维空间去表示这些分布是很浪费的,摊平如右侧的2D就很容易解决

假设三维空间有如图左侧分布,但用三维空间去表示这些分布是很浪费的,摊平如右侧的2D就很容易解决

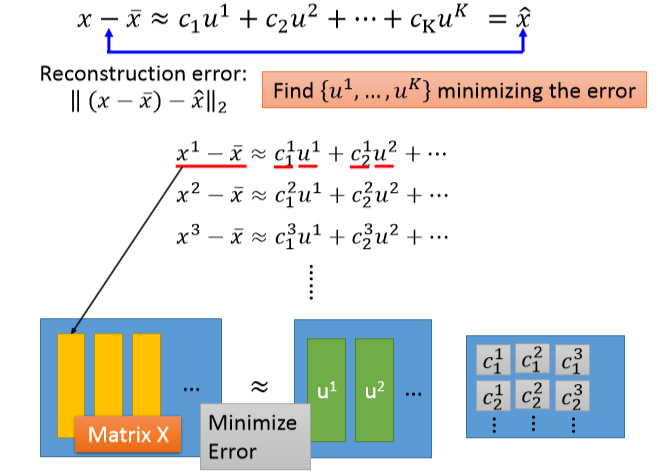

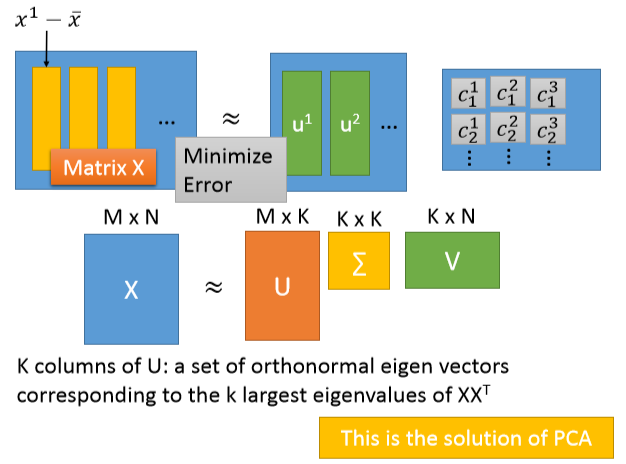

那么怎么做降维呢?就是要找一个function,输入是一个vector x,输出是一个vector z,z的维度小于x

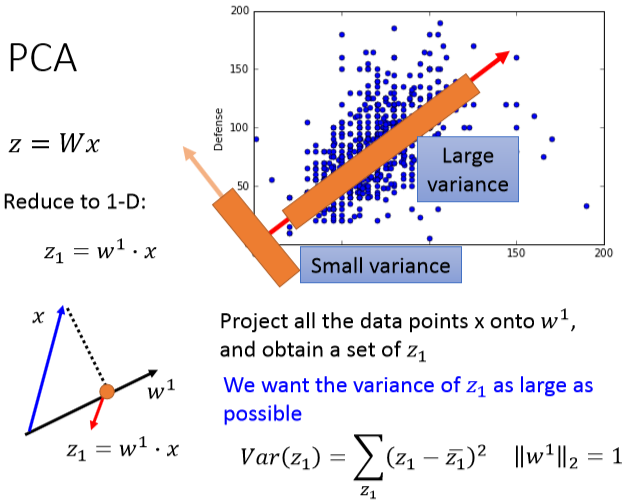

介绍两个方法,一个是feature selection,该方法有点鸡肋。另一个就是主成分分析PCA

介绍两个方法,一个是feature selection,该方法有点鸡肋。另一个就是主成分分析PCA

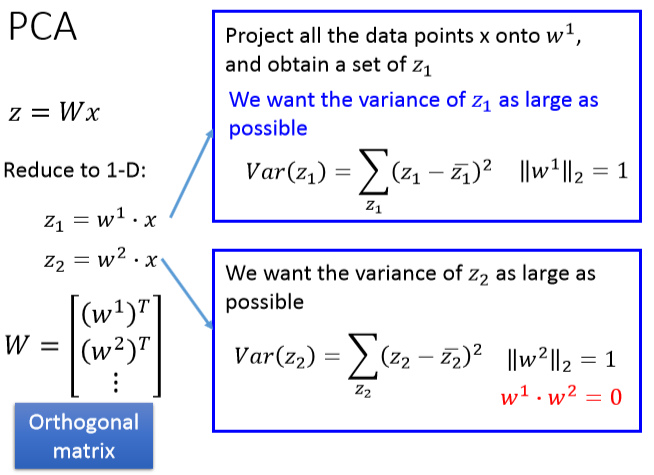

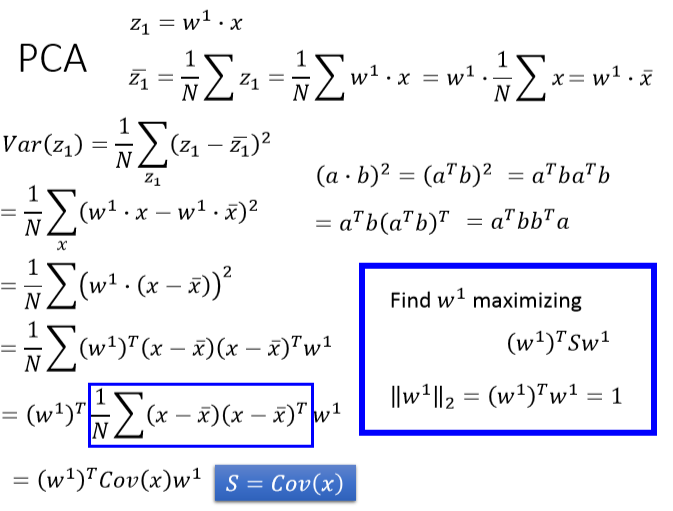

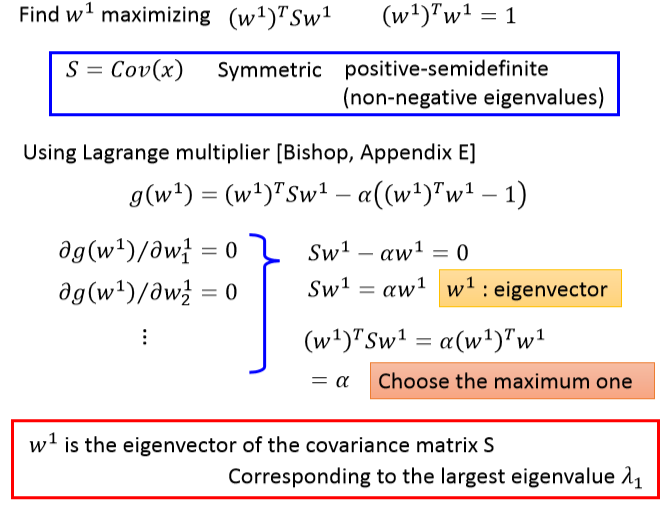

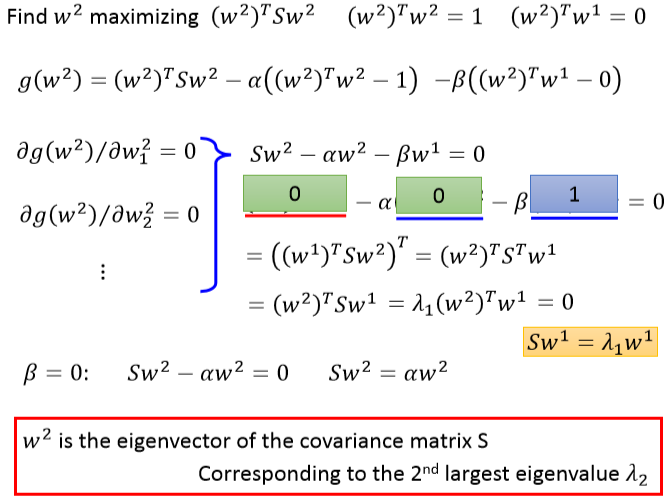

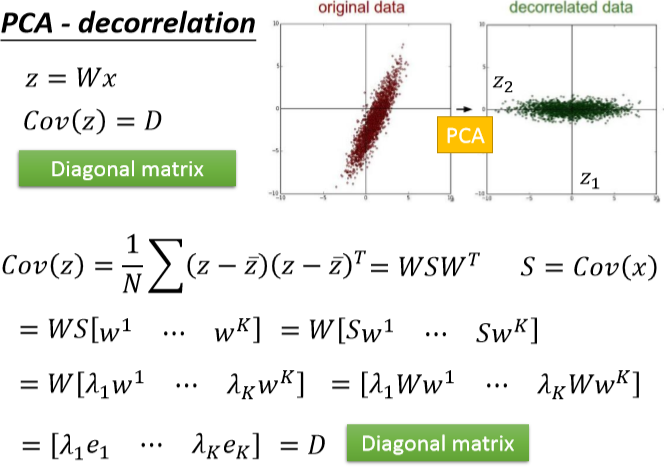

怎么解w1和w2呢(只截图了,没有好好看视频,也没有好好看公式)

直观PCA证明想法

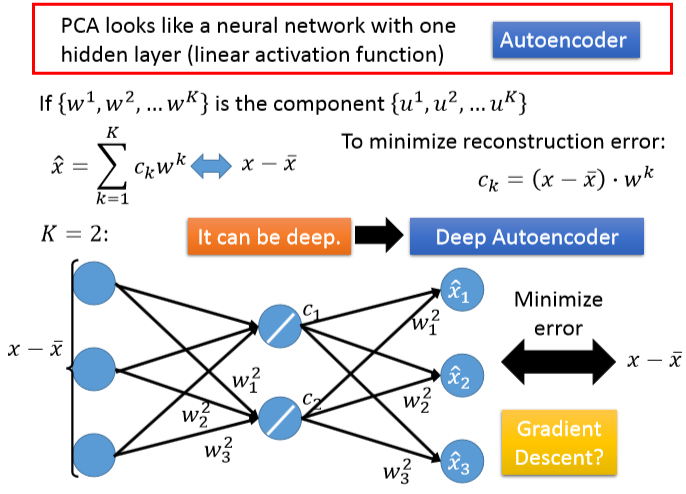

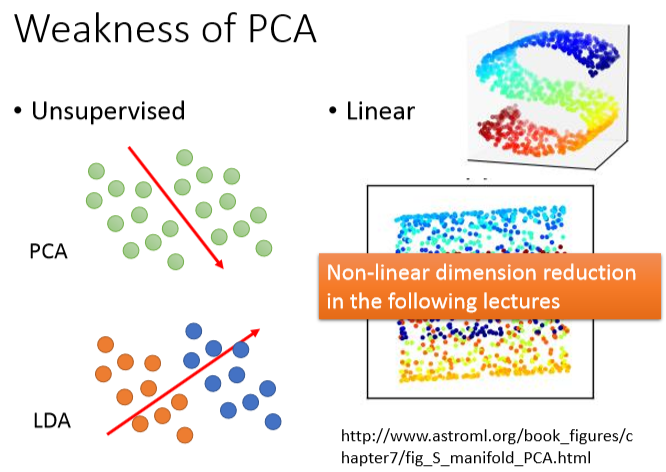

PCA缺点:

因为无监督可能会把两类投影一个平面上,因为是线性的,无法投影S曲面,只会打扁不会拉伸

因为无监督可能会把两类投影一个平面上,因为是线性的,无法投影S曲面,只会打扁不会拉伸

Matrix Factorization举例:

也是用梯度下降求出

也是用梯度下降求出