Kafka官方文档V2.7

1.开始

1.1 简介

什么是事件流?

事件流相当于人体的中枢神经系统的数字化。它是 "永远在线 "世界的技术基础,在这个世界里,业务越来越多地被软件定义和自动化,软件的用户更是软件。

从技术上讲,事件流是指以事件流的形式从数据库、传感器、移动设备、云服务和软件应用等事件源中实时捕获数据;将这些事件流持久地存储起来,以便日后检索;对事件流进行实时以及回顾性的操作、处理和反应;并根据需要将事件流路由到不同的目的技术。因此,事件流确保了数据的连续流动和解释,从而使正确的信息在正确的时间和地点出现。

我可以使用事件流做什么?

事件流被应用于众多行业和组织的各种用例中。它的许多例子包括:

- 实时处理支付和金融交易,如证券交易所、银行和保险公司。

- 实时跟踪和监控汽车、卡车、车队和货物,如物流和汽车行业。

- 持续采集和分析来自物联网设备或其他设备的传感器数据,例如在工厂和风场。

- 收集并立即响应客户的互动和订单,例如在零售、酒店和旅游行业以及移动应用中。

- 监测医院护理中的病人,并预测病情变化,以确保紧急情况下的及时治疗。

- 连接、存储和提供公司不同部门产生的数据。

- 作为数据平台、事件驱动架构和微服务的基础。

Apache Kafka®是一个事件流平台。这意味着什么?

Kafka结合了三个关键功能,因此您可以通过一个经过实战检验的解决方案,端到端实现您的事件流用例。

- 发布(写)和订阅(读)事件流,包括从其他系统持续导入/导出数据。

- 只要你想,就能持久可靠地存储事件流。

- 在事件发生时处理事件流,或对事件流进行追溯。

所有这些功能都是以分布式、高度可扩展、弹性、容错和安全的方式提供的。Kafka可以部署在裸机硬件、虚拟机和容器上,也可以部署在企业内部以及云端。您可以在自我管理Kafka环境和使用由各种供应商提供的完全托管服务之间进行选择。

Kafka是如何工作的?

Kafka是一个分布式系统,由服务器和客户端组成,通过高性能的TCP网络协议进行通信。它可以部署在内部以及云环境中的裸机硬件、虚拟机和容器上。

服务器。Kafka以一个或多个服务器集群的形式运行,可以跨越多个数据中心或云区域。这些服务器中的一些构成了存储层,称为broker。其他服务器运行Kafka Connect,以事件流的形式持续导入和导出数据,将Kafka与您现有的系统(如关系型数据库以及其他Kafka集群)集成。为了让您实现关键任务用例,Kafka集群具有高度的可扩展性和容错性:如果它的任何一台服务器发生故障,其他服务器将接管它们的工作,以确保在没有任何数据丢失的情况下连续运行。

客户端。它们允许你编写分布式应用和微服务,即使在网络问题或机器故障的情况下,也能以并行、大规模、容错的方式读取、写入和处理事件流。Kafka船载包含了一些这样的客户端,Kafka社区提供的几十个客户端对其进行了增强:客户端可用于Java和Scala,包括更高级别的Kafka Streams库,用于Go、Python、C/C++和许多其他编程语言,以及REST API。

主要概念和术语

事件记录了世界上或你的企业中 "发生了什么 "的事实。它在文档中也被称为记录或消息。当你向Kafka读写数据时,你是以事件的形式进行的。概念上,一个事件有一个键、值、时间戳和可选的元数据头。下面是一个事件的例子。

- 事件键:"Alice"

- 事件价值: "支付了200美元给鲍勃"

- 事件时间戳: "2020年6月25日下午2点06分"

生产者是那些向Kafka发布(写)事件的客户端应用,消费者是那些订阅(读取和处理)这些事件的应用。在Kafka中,生产者和消费者是完全解耦的,彼此不可知,这是实现Kafka闻名的高可扩展性的关键设计元素。例如,生产者从来不需要等待消费者。Kafka提供了各种保证,例如,能够精确地处理事件-once。

事件被组织并持久地存储在主题中。非常简化,一个topic类似于文件系统中的一个文件夹,而事件就是该文件夹中的文件。一个例子的topic名称可以是 "支付"。Kafka中的topic总是多生产者和多订阅者的:一个topic可以有零个、一个或许多生产者向它写入事件,也可以有零个、一个或许多消费者订阅这些事件。主题中的事件可以根据需要随时读取--与传统的消息系统不同,事件在消耗后不会被删除。相反,你可以通过每个主题的配置设置来定义Kafka应该保留你的事件多长时间,之后旧的事件将被丢弃。Kafka的性能与数据大小有效地保持不变,所以长时间存储数据是完全可以的。

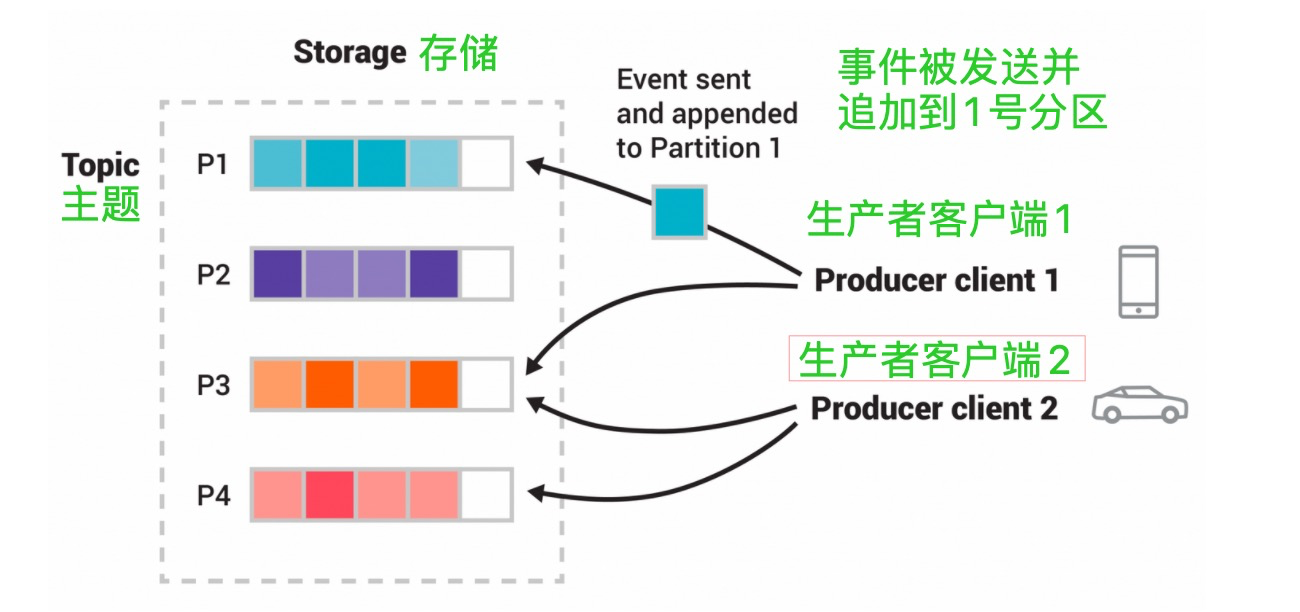

主题是分区的,也就是说一个主题会分布在位于不同的Kafkabroker上的多个 "桶 "上。这种数据的分布式放置对可扩展性非常重要,因为它允许客户端应用程序同时从/向许多broker读写数据。当一个新的事件被发布到一个主题时,它实际上被附加到主题的一个分区中。具有相同事件键的事件(例如,客户或车辆ID)被写入同一分区,Kafka保证给定主题-分区的任何消费者将始终以完全相同的顺序读取该分区的事件,因为它们被写入。

图:本例题有四个分区P1-P4。这个主题有四个分区P1 -P4。两个不同的生产者客户端通过网络将事件写入主题的分区,彼此独立地发布新事件到主题。具有相同键的事件(图中用它们的颜色表示)被写入同一个分区。注意,如果合适的话,两个生产者都可以写到同一个分区。

为了使你的数据具有容错性和高可用性,每个主题都可以被复制,甚至可以跨地理区域或数据中心,这样总有多个broker拥有数据的副本,以防万一出现问题,你想对broker进行维护等等。常见的生产设置是复制系数为3,即你的数据永远有三个副本。这种复制是在主题-分区的层面上进行的。

这个初级介绍应该足够了。如果你有兴趣的话,文档中的设计部分会完整详细地解释Kafka的各种概念。

Kafka APIs

除了用于管理和行政任务的命令行工具外,Kafka还有五个针对Java和Scala的核心API。

- 管理API用于管理和检查主题、broker和其他Kafka对象。

- Producer API用于向一个或多个Kafka主题发布(写入)事件流。

- 消费者API用于订阅(读取)一个或多个主题,并处理向其产生的事件流。

- Kafka Streams API用于实现流处理应用程序和微服务。它提供了更高层次的函数来处理事件流,包括转换、有状态的操作(如聚合和连接)、窗口化、基于事件时间的处理等。从一个或多个主题读取输入,以便生成输出到一个或多个主题,有效地将输入流转化为输出流。

- Kafka Connect API来构建和运行可重用的数据导入/导出连接器,这些连接器从外部系统和应用程序消耗(读)或产生(写)事件流,以便它们可以与Kafka集成。例如,连接PostgreSQL等关系型数据库的连接器可能会捕获一组表的每一个变化。然而,在实践中,你通常不需要实现自己的连接器,因为Kafka社区已经提供了数百个现成的连接器。

下一步是什么

- 要获得Kafka的实际操作经验,请关注快速入门。

- 要想更详细地了解Kafka,请阅读文档。您还可以选择Kafka书籍和学术论文。

- 浏览使用案例,了解全球社区的其他用户如何从Kafka中获得价值。

- 加入当地的Kafka meetup小组,观看Kafka社区的主要会议--Kafka Summit的演讲。

1.2使用案例

以下是对Apache Kafka®的一些流行用例的描述。关于这些领域的概述,请看这篇博客文章。

讯息传递

Kafka可以很好地替代更传统的消息中介。消息broker的使用有多种原因(将处理与数据生产者解耦,缓冲未处理的消息等)。与大多数消息系统相比,Kafka具有更好的吞吐量、内置的分区、复制和容错能力,这使得它成为大规模消息处理应用的良好解决方案。

根据我们的经验,消息处理的用途往往是比较低的吞吐量,但可能需要较低的端到端延迟,并且往往依赖于Kafka提供的强大的耐久性保证。

在这个领域中,Kafka可以和传统的消息系统,如ActiveMQ或RabbitMQ相媲美。

网站活动跟踪

Kafka最初的用例是能够将用户活动跟踪管道重建为一组实时发布-订阅feeds。这意味着网站活动(页面浏览、搜索或用户可能采取的其他行动)被发布到中心主题,每个活动类型有一个主题。这些feed可供订阅,用于一系列用例,包括实时处理、实时监控以及加载到Hadoop或离线数据仓库系统中进行离线处理和报告。

活动跟踪通常是非常大的量,因为每个用户页面浏览都会产生许多活动消息。

衡量标准

Kafka经常用于运营监控数据。这涉及到从分布式应用中聚合统计数据,以产生集中的运营数据源。

日志聚合

许多人使用Kafka作为日志聚合解决方案的替代品。日志聚合通常会从服务器上收集物理日志文件,并将它们放在一个中心位置(可能是文件服务器或HDFS)进行处理。Kafka抽象掉了文件的细节,并将日志或事件数据抽象为一个更干净的消息流。这使得处理延迟更低,更容易支持多个数据源和分布式数据消费。与Scribe或Flume等以日志为中心的系统相比,Kafka同样具有良好的性能,由于复制而具有更强的耐久性保证,端到端延迟也低得多。

流处理

Kafka的许多用户在由多个阶段组成的处理管道中处理数据,原始输入数据从Kafka主题中消耗,然后聚合、丰富或以其他方式转化为新的主题,以便进一步消耗或后续处理。例如,用于推荐新闻文章的处理管道可能会从RSS订阅中抓取文章内容,并将其发布到 "文章 "主题中;进一步的处理可能会对这些内容进行归一化或重复数据化,并将清洗后的文章内容发布到新的主题中;最后的处理阶段可能会尝试向用户推荐这些内容。这样的处理流水线会根据各个主题创建实时数据流的图。从0.10.0.0开始,Apache Kafka中提供了一个轻量级但功能强大的流处理库Kafka Streams,用于执行上述此类数据处理。除了Kafka Streams,其他的开源流处理工具还包括Apache Storm和Apache Samza。

事件源

事件源是一种应用设计风格,其中状态变化被记录为一个时间顺序的记录序列。Kafka对非常大的存储日志数据的支持使其成为以这种风格构建的应用程序的优秀后端。

提交日志

Kafka可以作为分布式系统的一种外部提交日志。该日志有助于在节点之间复制数据,并作为失败节点的重新同步机制,以恢复其数据。Kafka中的日志压缩功能有助于支持这种用法。在这个用法上,Kafka类似于Apache BookKeeper项目。

1.3 快速开始

步骤一:获取kafka

下载最新的Kafka版本并解压。

$ tar -xzf kafka_2.13-2.7.0.tgz

$ cd kafka_2.13-2.7.0步骤二:启动kafka环境

注意:您的本地环境必须安装有 Java 8+。

运行以下命令,以便以正确的顺序启动所有服务。

# Start the ZooKeeper service

# Note: Soon, ZooKeeper will no longer be required by Apache Kafka.

$ bin/zookeeper-server-start.sh config/zookeeper.properties打开另一个终端会话并运行。

# Start the Kafka broker service

$ bin/kafka-server-start.sh config/server.properties

一旦所有服务成功启动,您将拥有一个基本的Kafka环境运行并准备使用。

步骤三:创建一个主题来存储你的事件

Kafka是一个分布式事件流平台,它可以让你在许多机器上读取、写入、存储和处理事件(在文档中也称为记录或消息)。

示例事件有支付交易、手机的地理位置更新、运输订单、物联网设备或医疗设备的传感器测量等等。这些事件被组织并存储在主题中。非常简化,一个主题类似于文件系统中的一个文件夹,而事件就是该文件夹中的文件。

所以在你写第一个事件之前,你必须创建一个topic。打开另一个终端会话并运行。

$ bin/kafka-topics.sh --create --topic quickstart-events --bootstrap-server localhost:9092Kafka的所有命令行工具都有额外的选项:运行kafka-topics.sh命令,不需要任何参数就可以显示使用信息。例如,它还可以显示新主题的分区数等细节。

$ bin/kafka-topics.sh --describe --topic quickstart-events --bootstrap-server localhost:9092

Topic:quickstart-events PartitionCount:1 ReplicationFactor:1 Configs:

Topic: quickstart-events Partition: 0 Leader: 0 Replicas: 0 Isr: 0步骤四:将一些事件写进主题里

Kafka客户端通过网络与Kafkabroker进行通信,以写入(或读取)事件。一旦接收到事件,brokers将以持久和容错的方式存储这些事件,只要你需要--甚至永远。

运行控制台生产者客户端,将一些事件写入你的主题中。默认情况下,你输入的每一行都会导致一个单独的事件被写入主题。

$ bin/kafka-console-producer.sh --topic quickstart-events --bootstrap-server localhost:9092

This is my first event

This is my second event你可以在任何时候用Ctrl+C停止生产者客户端。

步骤五:读取事件

打开另一个终端会话,运行控制台消费者客户端来读取刚才创建的事件。

$ bin/kafka-console-consumer.sh --topic quickstart-events --from-beginning --bootstrap-server localhost:9092

This is my first event

This is my second event

你可以在任何时候用Ctrl+C停止消费者客户端。

随意试验一下:例如,切换回你的生产者终端(上一步)来写入额外的事件,看看这些事件是如何立即显示在你的消费者终端中的。

因为事件是持久存储在Kafka中的,所以它们可以被任意次数和任意数量的消费者读取。你可以通过打开另一个终端会话并再次重新运行上一条命令来轻松验证。

步骤六:使用KAFKA CONNECT将您的数据以事件流的形式导入/导出

你可能在现有的系统中拥有大量的数据,比如关系型数据库或传统的消息系统,以及许多已经使用这些系统的应用程序。Kafka Connect允许您将外部系统中的数据不断地摄入到Kafka中,反之亦然。因此,将现有系统与Kafka整合起来非常容易。为了使这一过程更加简单,有数百个这样的连接器随时可用。

看看Kafka连接部分,了解更多关于如何将你的数据连续导入/导出到Kafka中。

步骤七:使用KAFKA STREAMS处理您的事件

一旦您的数据以事件的形式存储在Kafka中,您就可以使用Java/Scala的Kafka Streams客户端库处理数据。它允许您实现任务关键型实时应用程序和微服务,其中输入和/或输出数据存储在Kafka主题中。Kafka Streams将在客户端编写和部署标准Java和Scala应用程序的简单性与Kafka服务器端集群技术的优势相结合,使这些应用程序具有高度的可扩展性、弹性、容错性和分布式。该库支持精确的一次性处理、有状态的操作和聚合、窗口化、连接、基于事件时间的处理等。

为了让大家先体验一下,下面是如何实现流行的WordCount算法。

KStream<String, String> textLines = builder.stream("quickstart-events");

KTable<String, Long> wordCounts = textLines

.flatMapValues(line -> Arrays.asList(line.toLowerCase().split(" ")))

.groupBy((keyIgnored, word) -> word)

.count();

wordCounts.toStream().to("output-topic"), Produced.with(Serdes.String(), Serdes.Long()));

Kafka Streams演示和应用开发教程演示了如何从头到尾地编码和运行这样一个流媒体应用。

步骤八:终止kafka运行环境

现在你已经到达了快速入门的终点,可以随意拆掉Kafka环境--或者继续玩。

- 用Ctrl-C停止生产者和消费者客户端,如果你还没有这样做。

- 用Ctrl-C停止Kafka broker。

- 最后,用Ctrl-C停止ZooKeeper服务器。

如果你还想删除你本地Kafka环境的任何数据,包括你一路创建的任何事件,运行下列命令:

$ rm -rf /tmp/kafka-logs /tmp/zookeeper

祝贺!

您已经成功完成了Apache Kafka快速入门。

要了解更多信息,我们建议采取以下步骤。

- 阅读简短的介绍,了解Kafka如何在高层次上工作,它的主要概念,以及它与其他技术的比较。要了解Kafka的更多细节,请前往文档。

- 浏览使用案例,了解全球社区的其他用户如何从Kafka中获得价值。

- 加入当地的Kafka meetup小组,观看Kafka社区的主要会议--Kafka Summit的演讲。

1.4 生态系统

在主发行版之外,有大量的工具与Kafka集成。生态系统页面列出了其中的许多工具,包括流处理系统、Hadoop集成、监控和部署工具。

1.5 从旧版本升级

从0.8.x到2.6.x的任何版本升级到2.7.0

如果您要从 2.1.x 之前的版本升级,请查看下面关于用于存储消费者偏移量的模式变化的说明。一旦您将 inter.broker.protocol.version 更改为最新版本,将无法降级到 2.1 之前的版本。

如何平滑升级:

- 更新所有broker的server.properties,并添加以下属性。CURRENT_KAFKA_VERSION 指的是您要升级的版本。CURRENT_MESSAGE_FORMAT_VERSION 指的是当前使用的消息格式版本。如果您之前已经覆盖了消息格式版本,您应该保留它的当前值。另外,如果您从 0.11.0.x 之前的版本升级,那么 CURRENT_MESSAGE_FORMAT_VERSION 应该设置为与 CURRENT_KAFKA_VERSION 匹配。

- inter.broker.protocol.version=CURRENT_KAFKA_VERSION (例如,2.6、2.5等)

- log.message.format.version=CURRENT_MESSAGE_FORMAT_VERSION (关于这个配置的详细作用,请看升级后对性能的潜在影响。)

如果你是从0.11.0.x或更高版本升级的,并且你没有覆盖消息格式,那么你只需要覆盖inter-broker协议版本。 - inter.broker.protocol.version=CURRENT_KAFKA_VERSION(如2.6、2.5等)。

- 一次升级一个broker:关闭broker,更新代码,然后重新启动它。一旦你这样做了,broker将运行最新的版本,你可以验证集群的行为和性能是否符合预期。如果有任何问题,此时仍然可以降级。

- 一旦集群的行为和性能得到验证,通过编辑inter.broker.protocol.version并将其设置为2.7来提升协议版本。

- 逐个重启broker,让新协议版本生效。一旦brokers开始使用最新的协议版本,将不再可能将群集降级到旧版本。

- 如果你已经按照上面的指示覆盖了消息格式版本,那么你需要再做一次滚动重启,将其升级到最新版本。一旦所有(或大多数)消费者都升级到0.11.0或更高版本,在每个broker上将log.message.format.version改为2.7,然后逐个重启它们。需要注意的是,不再维护的旧版Scala客户端不支持0.11中引入的消息格式,因此为了避免转换成本(或利用精确的一次语义),必须使用较新的Java客户端。

2.7.0中的显著变化

- 2.7.0版本包括KIP-595中规定的核心Raft实现。有一个单独的 "Raft "模块,包含大部分的逻辑。在与控制器的集成完成之前,有一个独立的服务器,用户可以用来测试Raft实现的性能。详细内容请参见 raft 模块中的 README.md。

- KIP-651 增加了对使用 PEM 文件作为密钥和信任存储的支持。

- KIP-612 增加了对执行整个代理和每个监听器连接创建率的支持。2.7.0 版本包含 KIP-612 的第一部分,动态配置将在 2.8.0 版本中推出。

- 通过KIP-599,能够节制主题和分区的创建或主题的删除,以防止集群受到伤害。

- 当Kafka中出现新功能时,主要有两个问题。

- Kafka客户如何知道broker的功能?

- broker如何决定启用哪些功能?

- KIP-584提供了一个灵活且易于操作的解决方案,用于客户端发现、功能门控和使用一次重启进行滚动升级。

- 通过KIP-431,现在可以通过ConsoleConsumer打印记录偏移量和头文件的能力。

- KIP-554的加入,继续朝着从Kafka中移除Zookeeper的目标前进。KIP-554的加入意味着你不必再直接连接到ZooKeeper来管理SCRAM凭证。

- 改变存在的监听器的不可重新配置的配置会导致InvalidRequestException。相比之下,之前(非预期)的行为会导致更新的配置被持久化,但直到broker被重新启动才会生效。更多讨论请参见KAFKA-10479。请参阅DynamicBrokerConfig.DynamicSecurityConfigs和SocketServer.ListenerReconfigurableConfigs,了解存在的监听器的支持的可重新配置。

- Kafka Streams在KStreams DSL中增加了对Sliding Windows Aggregations的支持。

- 在状态存储上进行反向迭代,使KIP-617的最近更新搜索更加高效。

- Kafka Steams中的端到端延迟指标,详见KIP-613。

- Kafka Streams增加了用KIP-607报告默认RocksDB属性的指标。

- KIP-616提供更好的Scala隐式Serdes支持。

2. APIS

Kafka包括五个核心API。

- 生产者API允许应用程序向Kafka集群中的主题发送数据流。

- Consumer API允许应用程序从Kafka集群中的主题读取数据流。

- Streams API允许将数据流从输入主题转换为输出主题。

- 连接API允许实现连接器,不断地从一些源系统或应用拉入Kafka,或从Kafka推入一些汇系统或应用。

- 管理API允许管理和检查主题、broker和其他Kafka对象。

Kafka通过一个独立于语言的协议公开其所有功能,该协议有许多编程语言的客户端。然而,只有Java客户端是作为Kafka主项目的一部分来维护的,其他的客户端是作为独立的开源项目来提供的。非Java客户端的列表可以在这里找到。

2.1 生产者API

Producer API允许应用程序向Kafka集群中的主题发送数据流。

javadocs中给出了如何使用producer的例子。

要使用producer,你可以使用以下maven依赖。

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.7.0</version>

</dependency>

2.2 消费者API

消费者API允许应用程序从Kafka集群中的主题读取数据流。

javadocs中给出了如何使用消费者的例子。

要使用消费者,你可以使用以下maven依赖。

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.7.0</version>

</dependency>

2.3 流API

Streams API允许将数据流从输入主题转换为输出主题。

在javadocs中给出了如何使用这个库的例子。

关于使用Streams API的其他文档在这里。

要使用Kafka Streams,你可以使用以下maven依赖。

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-streams</artifactId>

<version>2.7.0</version>

</dependency>

当使用Scala时,你可以选择包含kafka-streams-scala库。关于使用Kafka Streams DSL for Scala的其他文档请参见开发者指南。

要使用Kafka Streams DSL for Scala for Scala 2.13,你可以使用以下maven依赖。

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-streams-scala_2.13</artifactId>

<version>2.7.0</version>

</dependency>

2.4 连接API

Connect API允许实现连接器,不断地从一些源数据系统拉入Kafka,或者从Kafka推送到一些汇数据系统。

很多Connect的用户不需要直接使用这个API,不过,他们可以使用预建的连接器,而不需要编写任何代码。关于使用Connect的其他信息可以在这里获得。

想要实现自定义连接器的用户可以查看javadoc。

2.5 管理API

管理API支持管理和检查主题、broker、acls和其他Kafka对象。

要使用Admin API,请添加以下Maven依赖关系。

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>2.7.0</version>

</dependency>有关Admin APIs的更多信息,请参阅javadoc。

3. 配置

Kafka使用属性文件格式的键值对进行配置。这些值可以从文件或程序上提供。

3.1 broker配置

基本配置如下。

- broker.id

- log.dirs

- zookeeper.connect

下面将详细讨论主题级配置和默认值。

zookeeper.connect

以 hostname:port 的形式指定 ZooKeeper 连接字符串,其中 host 和 port 是 ZooKeeper 服务器的主机和端口。为了允许在该ZooKeeper机器宕机时通过其他ZooKeeper节点进行连接,你也可以以hostname1:port1,hostname2:port2,hostname3:port3的形式指定多个主机。

服务器也可以有一个ZooKeeper chroot路径作为其ZooKeeper连接字符串的一部分,它将其数据放在全局ZooKeeper命名空间的某个路径下。例如,给chroot路径为/chroot/path,你可以给连接字符串为hostname1:port1,hostname2:port2,hostname3:port3/chroot/path。类型:字符串

默认值:

有效值:

重要性:高

更新模式:只读

advertised.host.name

已经废弃:只有在没有设置advertised.listeners或listeners时才使用。请使用advertised.listeners代替。

发布到ZooKeeper的主机名,供客户端使用。在IaaS环境中,这可能需要与broker绑定的接口不同。如果没有设置,它将使用host.name的值,如果配置。否则,它将使用从 java.net.InetAddress.getCanonicalHostName()返回的值。类型:字符串

默认值: null

有效值:

重要性:高

更新模式:只读

advertised.listeners

监听器发布到ZooKeeper供客户端使用,如果与监听器配置属性不同。在IaaS环境中,这可能需要与broker绑定的接口不同。如果没有设置这个,将使用监听器的值。与监听器不同,宣传0.0.0.0元地址是无效的。

同样与监听器不同的是,在这个属性中可以有重复的端口,这样一个监听器可以被配置为宣传另一个监听器的地址。这在某些使用外部负载均衡器的情况下很有用。类型:字符串

默认值: null

有效值:

重要性:高

更新模式:每个broker

advertised.port

已经废弃:只有在没有设置advertised.listeners或listeners时才使用。请使用advertised.listeners代替。

发布到ZooKeeper供客户端使用的端口。在IaaS环境中,这可能需要与broker绑定的端口不同。如果没有设置,它将发布与broker绑定的相同端口。类型:int

默认值: null

有效值:

重要性:高

更新模式:只读

auto.create.topics.enable

启用自动创建服务器上的主题类型: 布尔型

默认:true

有效值:

重要性:高

更新模式:只读

auto.leader.rebalance.enable

启用自动领导平衡。后台线程定期检查分区领导的分布情况,可由`leader.imbalance.check.interval.seconds`配置。如果leader.imbalance.per.broker.百分比超过`leader.imbalance.per.broker.百分比`,则会触发对分区的首选leader重新平衡。

类型:布尔值

默认:true

有效值:

重要性:高

更新模式:只读

background.threads

用于各种后台处理任务的线程数。

类型:int

默认值:10

有效值:[1,...]

重要性:高

更新模式:全集群

broker.id

这个服务器的broker id,如果没有设置,将生成一个唯一的broker id。为了避免zookeeper生成的broker id和用户配置的broker id之间的冲突,生成的broker id从 reserved.broker.max.id + 1 开始。

类型:int

默认值:-1

有效值:

重要性:高

更新模式:只读

compression.type

指定给定主题的最终压缩类型。此配置接受标准的压缩编解码器('gzip'、'snappy'、'lz4'、'zstd')。此外,它还接受'uncompressed',这相当于没有压缩;以及'producer',这意味着保留制作者设置的原始压缩编解码器。

类型:字符串

默认:生产者

有效值:

重要性:高

更新模式:全集群

control.plane.listener.name

用于控制器和broker之间通信的监听器的名称。broker将使用control.plane.listener.name来定位监听器列表中的端点,以监听来自控制器的连接。例如,如果一个broker的配置是.plane.listener.name。

listeners = INTERNAL://192.1.1.8:9092, EXTERNAL://10.1.1.5:9093, CONTROLLER://192.1.1.8:9094。

listener.security.protocol.map = INTERNAL:PLAINTEXT, EXTERNAL:SSL, CONTROLLER:SSL。

control.plane.listener.name = CONTROLLER

在启动时,broker将开始监听 "192.1.1.8:9094",安全协议为 "SSL"。

在控制器端,当它通过zookeeper发现一个broker发布的端点时,它会使用control.plane.listener.name来找到端点,然后用它来建立与broker的连接。

例如,如果broker在zookeeper上发布的端点是...。

"endpoints" : ["INTERNAL://broker1.example.com:9092", "EXTERNAL://broker1.example.com:9093", "CONTROLLER://broker1.example.com:9094"] 。

而控制器的配置是 。

listener.security.protocol.map = INTERNAL:PLAINTEXT, EXTERNAL:SSL, CONTROLLER:SSL。

control.plane.listener.name = CONTROLLER

那么控制器将使用 "broker1.example.com:9094 "和安全协议 "SSL "来连接到代理。

如果没有明确配置,默认值为空,控制器连接将没有专用端点。

类型:字符串

默认值: null

有效值:

重要性:高

更新模式:只读

delete.topic.enable

启用删除主题。如果关闭此配置,通过管理工具删除主题将没有效果。

类型: 布尔型

默认:true

有效值:

重要性:高

更新模式:只读

host.name

已经过期:只有在没有设置监听器时才使用。使用 listeners 代替。

broker的主机名。如果设置了这个,它将只绑定到这个地址。如果没有设置,则会绑定到所有接口。

类型:字符串

默认:""

有效值:

重要性:高

更新模式:只读

leader.imbalance.check.interval.seconds

控制器触发分区再平衡检查的频率。

类型:长

默认值:300

有效值:

重要性:高

更新模式:只读

leader.imbalance.per.broker.percentage

每个broker允许的领导者不平衡的比率。如果每个broker超过这个值,控制器将触发一个领导者平衡。该值以百分比指定。

类型:int

默认值:10

有效值:

重要性:高

更新模式:只读

listeners

Listener List - 我们将监听的URI和监听者名称的逗号分隔的列表,如果监听者名称不是安全协议,还必须设置listener.security.protocol.map。如果监听器名称不是安全协议,还必须设置listener.security.protocol.map。

监听器名称和端口号必须是唯一的。

将hostname指定为0.0.0.0,绑定到所有接口。

将hostname留空以绑定到默认接口。

合法监听器列表的例子。

PLAINTEXT://myhost:9092,SSL://:9091

CLIENT://0.0.0.0:9092,REPLICATION://localhost:9093。

类型:字符串

默认值: null

有效值:

重要性:高

更新模式:每个broker

log.dir

保存日志数据的目录(log.dirs属性的补充)。

类型:字符串

默认值:/tmp/kafka-logs。

有效值:

重要性:高

更新模式:只读

log.dirs

保存日志数据的目录。如果没有设置,则使用log.dir中的值。

类型:字符串

默认值: null

有效值:

重要性:高

更新模式:只读

log.flush.interval.messages

在将消息刷新到磁盘之前,日志分区上累积的消息数量。

类型:长

默认:9223372036854775807。

有效值:[1,...]

重要性:高

更新模式:全集群

log.flush.interval.ms

任何主题中的消息在刷新到磁盘之前在内存中保存的最大时间,单位为ms。如果没有设置,则使用log.flush.schedule.interval.ms中的值。

类型:长

默认值: null

有效值:

重要性:高

更新模式:全集群

log.flush.offset.checkpoint.interval.ms

我们更新作为日志恢复点的最后一次刷新的持久性记录的频率。

类型:int

默认:60000(1分钟)

有效值:[0,...]

重要性:高

更新模式:只读

log.flush.scheduler.interval.ms

日志刷新器检查是否需要将日志刷新到磁盘上的频率,单位为ms。

类型:长

默认:9223372036854775807。

有效值:

重要性:高

更新模式:只读

log.flush.start.offset.checkpoint.interval.ms

更新日志起始偏移量的持久性记录的频率。

类型:int

默认:60000(1分钟

有效值:[0,...]

重要性:高

更新模式:只读

log.retention.bytes

删除前日志的最大尺寸

类型:长

默认值:-1

有效值:

重要性:高

更新模式:全集群

log.retention.hours

在删除日志文件之前保留日志文件的小时数(小时),三级为log.retaining.ms属性。

类型:int

默认值:168

有效值:

重要性:高

更新模式:只读

log.retention.minutes

删除日志文件前保留日志文件的分钟数(以分钟为单位),次于log.retain.ms属性。如果没有设置,则使用 log.retaining.hours 属性中的值。

类型:int

默认值: null

有效值:

重要性:高

更新模式:只读

log.retention.ms

删除日志文件前保留日志文件的毫秒数(单位:毫秒),如果没有设置,则使用log.retention.minutes中的值。如果设置为-1,则没有时间限制。

类型:长

默认值: null

有效值:

重要性:高

更新模式:全集群

log.roll.hours

新日志段推出前的最长时间(小时),次要为log.roll.ms属性。

类型:int

默认值:168

有效值:[1,...]

重要性:高

更新模式:只读

log.roll.jitter.hours

从logRollTimeMillis(小时)中减去的最大抖动,次要用于log.roll.jitter.ms属性。

类型:int

默认值:0

有效值:[0,...]

重要性:高

更新模式:只读

log.roll.jitter.ms

从logRollTimeMillis(毫秒)中减去的最大抖动。如果没有设置,则使用log.roll.jitter.hours中的值。

类型:长

默认值: null

有效值:

重要性:高

更新模式:全集群

log.roll.ms

新日志段推出前的最长时间(毫秒)。如果没有设置,则使用log.roll.hours中的值。

类型:长

默认值: null

有效值:

重要性:高

更新模式:全集群

log.segment.bytes

单个日志文件的最大大小

类型:int

默认值:1073741824 (1 gibibyte)

有效值: [14,...]

重要性:高

更新模式:全集群

log.segment.delete.delay.ms

从文件系统中删除文件前等待的时间。

类型:长

默认:60000(1分钟

有效值:[0,...]

重要性:高

更新模式:全集群

message.max.bytes

Kafka允许的最大记录批次大小(如果启用压缩,则压缩后)。如果增加这个大小,并且有比0.10.2更老的消费者,消费者的取数大小也必须增加,这样才能取到这么大的记录批。在最新的消息格式版本中,为了提高效率,记录总是被分组成批。在以前的消息格式版本中,未压缩的记录不会被分组成批,在这种情况下,这个限制只适用于单条记录。这可以通过主题级别的max.message.bytes config来设置每个主题。

类型:int

默认值:1048588

有效值:[0,...]

重要性:高

更新模式:全集群

min.insync.replicas

当生产者将acks设置为 "all"(或"-1")时,min.insync.replicas指定了必须确认写入才算成功的最小复制数。如果不能满足这个最小数量,那么生产者将引发一个异常(NotEnoughReplicas或NotEnoughReplicasAfterAppend)。

当一起使用时,min.insync.replicas和acks允许你实施更大的耐久性保证。一个典型的场景是创建一个复制因子为3的主题,将min.insync.replicas设置为2,并以 "all "的acks进行生产。这将确保生产者在大多数副本没有收到写入时引发异常。

类型:int

默认值:1

有效值:[1,...]

重要性:高

更新模式:全集群

num.io.threads

服务器用于处理请求的线程数,其中可能包括磁盘I/O。

类型:int

默认值:8

有效值:[1,...]

重要性:高

更新模式:全集群

num.network.threads

服务器用于接收来自网络的请求并向网络发送响应的线程数。

类型:int

默认值:3

有效值:[1,...]

重要性:高

更新模式:全集群

num.recovery.threads.per.dir。

每个数据目录的线程数,用于启动时的日志恢复和关闭时的刷新。

类型:int

默认值:1

有效值:[1,...]

重要性:高

更新模式:全集群

num.replica.alter.log.dirs.threads。

可以在日志目录之间移动复制的线程数量,其中可能包括磁盘I/O。

类型:int

默认值: null

有效值:

重要性:高

更新模式:只读

num.replica.fetchers

用于从源broker复制消息的fetcher线程数量。增加这个值可以增加follower broker的I/O并行度。

类型:int

默认值:1

有效值:

重要性:高

更新模式:全集群

offset.metadata.max.bytes.

与偏移提交相关联的元数据条目的最大尺寸。

类型:int

默认值:4096(4 kibibytes)

有效值:

重要性:高

更新模式:只读

offsets.commit.required.acks

接受提交前所需的acks。一般来说,默认值(-1)不应该被覆盖。

类型:短

默认值:-1

有效值:

重要性:高

更新模式:只读

offsets.commit.timeout.ms

偏移提交将被延迟,直到主题的所有副本收到提交或达到这个超时。

偏移提交将被延迟,直到偏移主题的所有副本收到提交或达到这个超时。这与生产者请求超时类似。

类型:int

默认:5000(5秒

有效值:[1,...]

重要性:高

更新模式:只读

offsets.load.buffer.size

当把偏移量加载到缓存中时,从偏移量段读取的批次大小(软限制,如果记录太大,则重写)。

类型:int

默认:5242880

有效值:[1,...]

重要性:高

更新模式:只读

offsets.retention.check.interval.ms

检查过期偏移量的频率

类型:长

默认:600000(10分钟)。

有效值:[1,...]

重要性:高

更新模式:只读

offsets.retention.minutes

当一个消费者组失去所有消费者(即变成空的)后,它的偏移量将在这个保留期内保留,然后被丢弃。对于独立的消费者(使用手动分配),偏移量将在最后一次提交时间加上这个保留期后过期。

类型:int

默认值:10080

有效值:[1,...]

重要性:高

更新模式:只读

offsets.topic.compression.codec

偏移主题的压缩编解码器--压缩可用于实现 "原子 "提交。

类型:int

默认值:0

有效值:

重要性:高

更新模式:只读

offsets.topic.num.partitions

偏移提交主题的分区数(部署后不应改变)。

类型:int

默认值:50

有效值:[1,...]

重要性:高

更新模式:只读

offsets.topic.replication.factor

偏移主题的复制因子(设置更高以确保可用性)。内部主题创建将失败,直到集群大小满足此复制因子要求。

类型:短

默认值:3

有效值:[1,...]

重要性:高

更新模式:只读

offsets.topic.segment.bytes

偏移主题段的字节数应保持相对较小,以利于加快日志压缩和缓存加载速度

类型:int

默认值:104857600(100 mebibytes)。

有效值:[1,...]

重要性:高

更新模式:只读

port

删除:只有在没有设置监听器时才使用。请使用监听器代替。

监听和接受连接的端口。

类型:int

默认值:9092

有效值:

重要性:高

更新模式:只读

queued.max.requests

在阻塞网络线程之前,允许数据层排队请求的数量。

类型:int

默认值:500

有效值:[1,...]

重要性:高

更新模式:只读

quota.consumer.default

已取消。仅在Zookeeper没有配置动态默认配额时使用。任何以clientId/consumer group区分的消费者,如果每秒获取的字节数超过这个值,就会被节流。

类型:长

默认:9223372036854775807。

有效值:[1,...]

重要性:高

更新模式:只读

quota.producer.default

已取消。仅在没有配置动态默认配额时使用,或者在Zookeeper中使用。任何以clientId区分的生产者如果每秒产生的字节数超过这个值,就会被节流。

类型:长

默认:9223372036854775807。

有效值:[1,...]

重要性:高

更新模式:只读

replica.fetch.min.bytes

每个获取响应的最小字节数。如果字节数不够,则等待时间最多为 replica.fetch.wait.max.ms (broker 配置)。

类型:int

默认值:1

有效值:

重要性:高

更新模式:只读

replica.fetch.wait.max.ms

追随者副本发出的每个取数请求的最大等待时间。该值在任何时候都应始终小于 replica.lag.time.max.ms,以防止低吞吐量主题的 ISR 频繁缩减。

类型:int

默认值:500

有效值:

重要性:高

更新模式:只读

replica.high.watermark.checkpoint.interval.ms

高水印保存到磁盘的频率。

类型:长

默认:5000(5秒)

有效值:

重要性:高

更新模式:只读

replica.lag.time.max.ms

如果一个跟随者至少在这段时间内没有发送任何fetch请求,或者没有消耗到领导者的日志结束偏移量,领导者将把这个跟随者从isr

类型:长

默认:30000(30秒)

有效值:

重要性:高

更新模式:只读

replica.socket.receive.buffer.bytes

网络请求的套接字接收缓冲区

类型:int

默认值:65536(64 kibibytes)。

有效值:

重要性:高

更新模式:只读

replica.socket.timeout.ms

网络请求的套接字超时时间,其值应至少为 replica.fetch.wait.max.ms。它的值至少应该是 replica.fetch.wait.max.ms。

类型:int

默认:30000(30秒)

有效值:

重要性:高

更新模式:只读

request.timeout.ms

该配置控制客户端等待请求响应的最长时间。如果在超时之前没有收到响应,客户端将在必要时重新发送请求,或者在重试次数耗尽时失败。

类型:int

默认:30000(30秒)

有效值:

重要性:高

更新模式:只读

socket.receive.buffer.bytes

socket服务器套接字的SO_RCVBUF缓冲区。如果值为-1,则使用OS默认值。

类型:int

默认值:102400 (100 kibibytes)

有效值:

重要性:高

更新模式:只读

socket.request.max.bytes

套接字请求的最大字节数。

类型:int

默认值:104857600(100 mebibytes)。

有效值:[1,...]

重要性:高

更新模式:只读

socket.send.buffer.bytes

socket服务器套接字的SO_SNDBUF缓冲区。如果值为-1,则使用OS默认值。

类型:int

默认值:102400 (100 kibibytes)

有效值:

重要性:高

更新模式:只读

transaction.max.timeout.ms

交易的最大允许超时时间。如果客户端请求的交易时间超过了这个时间,那么broker将在InitProducerIdRequest中返回一个错误。这可以防止客户端的超时时间过大,从而拖延消费者从交易中包含的主题中读取。

类型:int

默认:900000(15分钟)

有效值:[1,...]

重要性:高

更新模式:只读

transaction.state.log.load.buffer.size

当把生产者id和交易加载到缓存中时,从交易日志段读取的批次大小(软限制,如果记录太大,则重写)。

类型:int

默认:5242880

有效值:[1,...]

重要性:高

更新模式:只读

transaction.state.log.min.isr

重写事务主题的min.insync.replicas配置。

类型:int

默认值:2

有效值:[1,...]

重要性:高

更新模式:只读

transaction.state.log.num.partitions

事务主题的分区数(部署后不应改变)。

类型:int

默认值:50

有效值:[1,...]

重要性:高

更新模式:只读

transaction.state.log.replication.factor

事务主题的复制因子(设置较高以确保可用性)。内部主题创建将失败,直到集群大小满足此复制因子要求。

类型:短

默认值:3

有效值:[1,...]

重要性:高

更新模式:只读

transaction.state.log.segment.bytes

事务主题段的字节数应保持相对较小,以利于加快日志压缩和缓存加载速度

类型:int

默认值:104857600(100 mebibytes)。

有效值:[1,...]

重要性:高

更新模式:只读

transactional.id.expiration.ms

事务协调器在没有收到当前事务的任何事务状态更新的情况下,在其事务id过期前等待的时间,单位为ms。这个设置也会影响生产者id过期--一旦这个时间在给定的生产者id最后一次写入后过去,生产者id就会过期。请注意,如果由于主题的保留设置,生产者id的最后一次写入被删除,那么生产者id可能会过期更早。

类型:int

默认:604800000(7天)

有效值:[1,...]

重要性:高

更新模式:只读

zookeeper.connection.timeout.ms

客户端等待与zookeeper建立连接的最大时间。如果没有设置,将使用zookeeper.session.timeout.ms中的值。

类型:int

默认值: null

有效值:

重要性:高

更新模式:只读

zookeeper.max.in.flight.requests

在阻止之前,客户端向Zookeeper发送的最大未确认请求数。

类型:int

默认值:10

有效值:[1,...]

重要性:高

更新模式:只读

zookeeper.session.timeout.ms

Zookeeper会话超时

类型:int

默认:18000(18秒)

有效值:

重要性:高

更新模式:只读

zookeeper.set.acl

设置客户端使用安全ACL

类型: 布尔型

默认:假

有效值:

重要性:高

更新模式:只读

broker.id.generation.enable

启用自动生成服务器上的broker id。当启用时,预留.broker.max.id的配置值应该被审查。

类型:布尔值

默认:true

有效值:

重要性:中等

更新模式:只读

broker.rack

broker的机架。这将用于机架感知复制分配,以实现容错。例子:"RACK1"、"us-east-1d"。`RACK1`,`us-east-1d`。

类型:字符串

默认值: null

有效值:

重要性:中等

更新模式:只读

connections.max.idle.ms

闲置连接超时:服务器套接字处理器线程关闭闲置时间超过这个时间的连接。

类型:长

默认:600000(10分钟)

有效值:

重要性:中等

更新模式:只读

connections.max.reauth.ms

当明确设置为正数时(默认为0,不是正数),当v2.2.0或更高版本的客户端进行身份验证时,将向他们传达一个不超过配置值的会话寿命。broker将断开任何没有在会话寿命内重新认证的连接,然后将其用于重新认证以外的任何目的。配置名称可以选择用监听器前缀和SASL机制名称的小写字母作为前缀。例如,listener.name.sasl_ssl.oauthbearer.connection.max.reauth.ms=3600000。

类型:长

默认值:0

有效值:

重要性:中等

更新模式:只读

controlled.shutdown.enable

启用受控关闭服务器

类型: 布尔型

默认:true

有效值:

重要性:中等

更新模式:只读

controlled.shutdown.max.retries

受控关机可能因多种原因而失败。这就决定了发生这种故障时的重试次数。

类型:int

默认值:3

有效值:

重要性:中等

更新模式:只读

controlled.shutdown.retry.backoff.ms

在每次重试之前,系统需要时间从导致上一次故障的状态中恢复过来(控制器失效,复制滞后等)。这个配置决定了重试前的等待时间。

类型:长

默认:5000(5秒)

有效值:

重要性:中等

更新模式:只读

controller.socket.timeout.ms

控制器到中间商通道的套接字超时时间。

类型:int

默认:30000(30秒)

有效值:

重要性:中等

更新模式:只读

default.replication.factor

自动创建主题的默认复制因子类型:int

默认值:1

有效值:

重要性:中等

更新模式:只读

delegation.token.expiry.time.ms

需要更新令牌前的有效时间,以毫秒为单位。默认值为1天。类型:长

默认:86400000(1天)

有效值:[1,...]

重要性:中等

更新模式:只读

delegation.token.master.key

用于生成和验证授权令牌的主/秘钥。必须在所有的broker中配置相同的密钥。如果没有设置密钥或将密钥设置为空字符串,则broker将禁用授权令牌支持。类型:密码

默认值: null

有效值:

重要性:中等

更新模式:只读

delegation.token.max.lifetime.ms

令牌有最大的使用期限,超过期限就不能再更新。默认值为7天。类型:长

默认:604800000(7天)

有效值:[1,...]

重要性:中等

更新模式:只读

delete.records.purgatory.purge.interval.requests

删除记录请求清理区的清理间隔(以请求次数为单位)类型:int

默认值:1

有效值:

重要性:中等

更新模式:只读

fetch.max.bytes

我们将为一个获取请求返回的最大字节数。必须至少为1024。类型:int

默认值:57671680 (55 mebibytes)

有效值: [1024,...]

重要性:中等

更新模式:只读

fetch.purgatory.purge.interval.requests

获取请求净化器的清理间隔(以请求数为单位)。类型:int

默认:1000

有效值:

重要性:中等

更新模式:只读

group.initial.rebalance.delay.ms

在执行第一次重新平衡之前,组协调员将等待更多消费者加入新组的时间。较长的延迟意味着可能会减少再平衡,但会增加处理开始前的时间。类型:int

默认:3000(3秒)

有效值:

重要性:中等

更新模式:只读

group.max.session.timeout.ms

注册消费者的最大允许会话超时。较长的超时让消费者有更多的时间来处理心跳之间的消息,但代价是需要更长的时间来检测故障。类型:int

默认:1800000(30分钟)

有效值:

重要性:中等

更新模式:只读

group.max.size

单个消费者群体可容纳的最大消费者数量。类型:int

默认:2147483647

有效值:[1,...]

重要性:中等

更新模式:只读

group.min.session.timeout.ms

注册消费者的最小允许会话超时。较短的超时会导致更快的故障检测,但代价是更频繁的消费者心跳,这会使broker资源不堪重负。类型:int

默认:6000(6秒)

有效值:

重要性:中等

更新模式:只读

inter.broker.listener.name

用于broker之间通信的监听器的名称。如果未设置,则监听器名称由 security.inter.broker.protocol 定义。同时设置此属性和 security.inter.broker.protocol 属性是错误的。类型:字符串

默认值: null

有效值:

重要性:中等

更新模式:只读

inter.broker.protocol.version

指定将使用哪个版本的broker间协议。

这通常是在所有broker升级到新版本后进行的。

一些有效值的例子是 0.8.0, 0.8.1, 0.8.1.1, 0.8.2, 0.8.2.0, 0.8.2.1, 0.9.0.0, 0.9.0.1 查看ApiVersion的完整列表。类型:字符串

默认:2.7-IV2

有效值。 [0.8.0、0.8.1、0.8.2、0.9.0、0.10.0-IV0、0.10.0-IV1、0.10.1-IV0、0.10.1-IV1、0.10.1-IV2、0.10.2-IV0、0.11.0-IV0、0.11.0-IV1、0.11.0-IV2、1.0-IV0、1. 1-IV0、2.0-IV0、2.0-IV1、2.1-IV0、2.1-IV1、2.1-IV2、2.2-IV0、2.2-IV1、2.3-IV0、2.3-IV1、2.4-IV0、2.4-IV1、2.5-IV0、2.6-IV0、2.7-IV0、2.7-IV1、2.7-IV2]

重要性:中等

更新模式:只读

log.cleaner.backoff.ms

当没有日志需要清理时的睡眠时间。类型:长

默认:15000(15秒

有效值:[0,...]

重要性:中等

更新模式:全集群

log.cleaner.dedupe.buffer.size

所有清理线程中用于日志重复数据删除的总内存。类型:长

默认:134217728

有效:

重要性:中等

更新模式:全集群

log.cleaner.delete.retention.ms

删除记录保留多长时间?类型:长

默认:86400000(1天)。

有效值。

重要性:中等

更新模式:全集群

log.cleaner.enable

启用服务器上运行的日志清理程序。如果使用任何带有cleanup.policy=compact的主题,包括内部偏移主题,则应启用。如果禁用,这些主题将不会被压缩,并会持续增长。类型:布尔值

默认:true

有效值。

重要性:中等

更新模式:只读

log.cleaner.io.buffer.load.factor

日志清理器重复数据删除缓冲区的负载系数。重复数据缓冲区满的百分比。较高的值将允许一次清理更多的日志,但会导致更多的哈希碰撞。类型:双人

默认值:0.9

有效值。

重要性:中等

更新模式:全集群

log.cleaner.io.buffer.size

所有清理线程的日志清理I/O缓冲区所使用的总内存。类型:int

默认值:524288

有效值:[0,...]

重要性:中等

更新模式:全集群

log.cleaner.io.max.bytes.per.second

日志清理器将被节流,使其读写i/o之和平均小于此值。类型:双人

Default: 1.7976931348623157E308

有效值。

重要性:中等

更新模式:全集群

log.cleaner.max.compaction.lag.ms

消息在日志中不符合压实条件的最长时间。仅适用于正在压缩的日志。类型:长

默认:9223372036854775807。

有效值。

重要性:中等

更新模式:全集群

log.cleaner.min.cleanable.ratio

有资格进行清理的日志的脏日志与总日志的最小比率。如果还指定了 log.cleaner.max.compaction.lag.ms 或 log.cleaner.min.compaction.lag.ms 配置,则日志压缩器会在以下任一情况下立即认为该日志符合压缩条件。(i) 达到 dirty ratio 阈值,并且日志至少在 log.cleaner.min.compaction.lag.ms 持续时间内有 dirty(未压实)记录,或 (ii) 如果日志至少在 log.cleaner.max.compaction.lag.ms 期间有 dirty(未压实)记录,则日志压实器认为该日志符合压实条件。类型:双

默认值:0.5

有效值。

重要性:中等

更新模式:全集群

log.cleaner.min.compaction.lag.ms

消息在日志中未被压缩的最少时间。仅适用于正在压缩的日志。类型:长

默认值:0

有效值。

重要性:中等

更新模式:全集群

log.cleaner.threads

用于清理日志的后台线程数。类型:int

默认值:1

有效值:[0,...]

重要性:中等

更新模式:全集群

log.cleanup.policy

超出保留窗口的片段的默认清理策略。逗号分隔的有效策略列表。有效的策略是:"删除 "和 "压缩"。"删除 "和 "压缩"

类型:list

默认:delete

有效值。 [compact, delete]

重要性:中等

更新模式:全集群

log.index.interval.bytes

我们在偏移指数中添加条目的时间间隔。

类型:int

默认值:4096(4 kibibytes)

有效值:[0,...]

重要性:中等

更新模式:全集群

log.index.size.max.bytes

偏移索引的最大大小,以字节为单位。类型:int

默认值:10485760(10 mebibytes)

有效值: [4,...]

重要性:中等

更新模式:全集群

log.message.format.version

指定broker将使用的消息格式版本来追加消息到日志。该值应该是一个有效的ApiVersion。一些例子是 0.8.2, 0.9.0.0, 0.10.0, 查看ApiVersion了解更多细节。通过设置一个特定的消息格式版本,用户证明磁盘上所有现有的消息都小于或等于指定的版本。不正确地设置这个值会导致使用旧版本的消费者崩溃,因为他们会收到一个他们不理解的格式的消息。类型:字符串

默认:2.7-IV2

有效值。 [0.8.0、0.8.1、0.8.2、0.9.0、0.10.0-IV0、0.10.0-IV1、0.10.1-IV0、0.10.1-IV1、0.10.1-IV2、0.10.2-IV0、0.11.0-IV0、0.11.0-IV1、0.11.0-IV2、1.0-IV0、1. 1-IV0、2.0-IV0、2.0-IV1、2.1-IV0、2.1-IV1、2.1-IV2、2.2-IV0、2.2-IV1、2.3-IV0、2.3-IV1、2.4-IV0、2.4-IV1、2.5-IV0、2.6-IV0、2.7-IV0、2.7-IV1、2.7-IV2]

重要性:中等

更新模式:只读

log.message.timestamp.difference.max.ms

broker收到消息时的时间戳和消息中指定的时间戳之间允许的最大差异。如果log.message.timestamp.type=CreateTime,如果时间戳的差异超过这个阈值,消息将被拒绝。如果log.message.timestamp.type=LogAppendTime.允许的最大时间戳差异不应大于log.retain.ms,以避免不必要的频繁日志滚动。类型:长

默认:9223372036854775807。

有效值。

重要性:中等

更新模式:全集群

log.message.timestamp.type

定义消息中的时间戳是消息创建时间还是日志追加时间。该值应该是`CreateTime`或`LogAppendTime`。类型:字符串

默认值。 CreateTime

有效值。 [CreateTime, LogAppendTime]

重要性:中等

更新模式:全集群

log.preallocate

创建新段时是否应该预分配文件?如果你在Windows上使用Kafka,你可能需要将其设置为true。类型:布尔值

默认:假

有效值。

重要性:中等

更新模式:全集群

log.retention.check.interval.ms

日志清理器检查任何日志是否符合删除条件的频率,以毫秒为单位。类型:长

默认:300000(5分钟)

有效值:[1,...]

重要性:中等

更新模式:只读

max.connection.creation.rate

我们在任何时候在broker中允许的最大连接创建速率。监听器级别的限制也可以通过在配置名前加上监听器前缀来配置,例如,listener.name.internal.max.connection.create.rate.broker范围内的连接速率限制应该根据broker的容量来配置,而监听器的限制应该根据应用需求来配置。如果达到了监听器或broker限制,新的连接将被节流,但broker间监听器除外。只有当达到监听器级速率限制时,broker间监听器上的连接才会被节流。类型:int

默认:2147483647

有效值:[0,...]

重要性:中等

更新模式:全集群

max.connections

我们在任何时候允许的最大连接数。除了使用 max.connections.per.ip 配置的任何 per-ip 限制外,这个限制也会被应用。监听器级别的限制也可以通过在配置名称前加上监听器前缀来配置,例如,listener.name.internal.max.connection。Broker范围的限制应该根据broker的容量来配置,而监听器的限制应该根据应用需求来配置。如果达到了监听器或broker的限制,新的连接就会被阻止。即使达到了broker-wide限制,也允许在broker间监听器上进行连接。在这种情况下,另一个监听器上最近使用最少的连接将被关闭。

类型:int

默认:2147483647

有效值:[0,...]

重要性:中等

更新模式:全集群

max.connections.per.ip

每个ip地址允许的最大连接数。如果使用max.connections.per.ip.overrides属性配置了覆盖项,则可以将其设置为0。如果达到上限,来自该ip地址的新连接将被丢弃。

类型:int

默认:2147483647

有效值:[0,...]

重要性:中等

更新模式:全集群

max.connections.per.ip.overrides

以逗号分隔的每ip或主机名的列表,覆盖默认的最大连接数。例如:"hostName:100,127.0.0.1:200"

类型:字符串

默认:""

有效值。

重要性:中等

更新模式:全集群

max.incremental.fetch.session.cache.slots

我们将维持的最大增量取数。

类型:int

默认:1000

有效值:[0,...]

重要性:中等

更新模式:只读

num.partitions

每个主题的默认日志分区数类型:int

默认值:1

有效值:[1,...]

重要性:中等

更新模式:只读

password.encoder.old.secret

用于动态配置密码编码的旧密码。只有在更新秘密时才需要这个。如果指定了,所有动态编码的密码都会使用这个旧的秘密进行解码,并在 broker 启动时使用 password.encoder.secret 重新编码。类型:密码

默认值: null

有效值。

重要性:中等

更新模式:只读

password.encoder.secret

用于编码该broker动态配置的密码的秘密。类型:密码

默认值: null

有效值。

重要性:中等

更新模式:只读

principal.builder.class

实现KafkaPrincipalBuilder接口的类的全称,该接口用于构建授权过程中使用的KafkaPrincipal对象。该配置还支持被废弃的PrincipalBuilder接口,该接口之前用于通过SSL进行客户端认证。如果没有定义Principal builder,默认行为取决于使用的安全协议。对于SSL身份验证,如果提供了客户证书,将使用应用于客户证书中的区别名称的ssl.principal.mapping.rule所定义的规则推导出Principal;否则,如果不需要客户身份验证,Principal名称将是ANONYMOUS。对于SASL认证,如果使用GSSAPI,则将使用sasl.kerberos.principal.to.local.rules定义的规则推导出principal,对于其他机制,则使用SASL认证ID。对于PLAINTEXT,principal将是ANONYMOUS。类型:类

默认值: null

有效值。

重要性:中等

更新模式:每个broker

producer.purgatory.purge.interval.requests

生产者请求净化器的净化间隔(以请求数为单位)。类型:int

默认:1000

有效值。

重要性:中等

更新模式:只读

queued.max.request.bytes

在不再读取更多请求之前,允许排队的字节数。类型:长

默认值:-1

有效值。

重要性:中等

更新模式:只读

replica.fetch.backoff.ms

发生取件分区错误时的睡眠时间。类型:int

默认:1000(1秒)

有效值:[0,...]

重要性:中等

更新模式:只读

replica.fetch.max.bytes

每个分区要尝试获取的消息字节数。这不是一个绝对的最大值,如果取回的第一个非空分区的第一个记录批大于这个值,记录批仍然会被返回,以确保可以取得进展。broker接受的最大记录批次大小通过message.max.bytes(broker配置)或max.message.bytes(topic配置)来定义。类型:int

默认值:1048576(1 mebibyte)

有效值:[0,...]

重要性:中等

更新模式:只读

replica.fetch.response.max.bytes

整个取回响应的最大字节数。记录是分批取回的,如果取回的第一个非空分区中的第一个记录批大于这个值,则仍然会返回该记录批,以确保可以取得进展。因此,这不是一个绝对的最大值。broker接受的最大记录批次大小通过message.max.bytes(broker配置)或max.message.bytes(topic配置)来定义。类型:int

默认值:10485760(10 mebibytes)

有效值:[0,...]

重要性:中等

更新模式:只读

replica.selector.class

实现 ReplicaSelector 的完全限定类名。这被broker用来寻找首选的读取副本。默认情况下,我们使用返回领导者的实现。类型:字符串

默认值: null

有效值。

重要性:中等

更新模式:只读

reserved.broker.max.id

broker.id可以使用的最大数量。类型:int

默认:1000

有效值:[0,...]

重要性:中等

更新模式:只读

sasl.client.callback.handler.class

实现AuthenticateCallbackHandler接口的SASL客户端回调处理程序类的全称。类型:类

默认值: null

有效值。

重要性:中等

更新模式:只读

sasl.enabled.mechanisms

Kafka服务器中启用的SASL机制列表。该列表可以包含任何安全提供者可用的机制。默认情况下,只有GSSAPI被启用。类型:列表

默认值。 GSSAPI

有效值。

重要性:中等

更新模式:每个broker

sasl.jaas.config

JAAS登录上下文参数,用于SASL连接,格式为JAAS配置文件使用的格式。JAAS配置文件的格式在这里有介绍。值的格式为:'loginModuleClass controlFlag (optionName=optionValue)*;'。对于broker来说,配置必须以监听器前缀和SASL机制名称为前缀,并以小写字母表示。例如,listener.name.sasl_ssl.scram-sha-256.sasl.jaas.config=com.exam.ScramLoginModule必填。类型:密码

默认值: null

有效值。

重要性:中等

更新模式:每个broker

sasl.kerberos.kinit.cmd

Kerberos kinit 命令路径。类型:字符串

默认值。 /usr/bin/kinit

有效值。

重要性:中等

更新模式:每个broker

sasl.kerberos.min.time.before.relogin

登录线程刷新尝试之间的睡眠时间。类型:长

默认值:60000

有效值。

重要性:中等

更新模式:每个broker

sasl.kerberos.principal.to.local.rules

从主名到短名(通常是操作系统用户名)的映射规则列表。这些规则按顺序评估,与主名匹配的第一条规则被用来将其映射为短名。列表中后面的任何规则都会被忽略。默认情况下,{username}/{hostname}@{REALM}形式的主名会被映射到{username}。有关格式的更多细节,请参见安全授权和acls。请注意,如果 principal.builder.class 配置提供了 KafkaPrincipalBuilder 的扩展,这个配置将被忽略。类型:列表

默认值。 DEFAULT

有效值。

重要性:中等

更新模式:每个broker

sasl.kerberos.service.name

Kafka 运行的 Kerberos 主体名称。这可以在Kafka的JAAS配置或Kafka的配置中定义。类型:字符串

默认值: null

有效值。

重要性:中等

更新模式:每个broker

sasl.kerberos.ticket.renew.jitter

随机抖动加到续航时间的百分比。类型:双倍

默认值:0.05

有效值。

重要性:中等

更新模式:每个broker

sasl.kerberos.ticket.renew.window.factor。

登录线程将休眠,直到达到从上次刷新到票据到期的指定时间窗口系数,这时它将尝试更新票据。类型:双倍

默认值:0.8

有效值。

重要性:中等

更新模式:每个broker

sasl.login.callback.handler.class

实现AuthenticateCallbackHandler接口的SASL登录回调处理程序类的完全限定名称。对于broker来说,登录回调处理程序配置必须以监听器前缀和小写的SASL机制名称为前缀。例如,listener.name.sasl_ssl.scram-sha-256.sasl.login.callback.handler.class=com.example.CustomScramLoginCallbackHandler。类型:类

默认值: null

有效值。

重要性:中等

更新模式:只读

sasl.login.class

实现Login接口的类的全称。对于broker来说,login config必须以监听器前缀和SASL机制名称为前缀,并使用小写。例如,listener.name.sasl_ssl.scram-sha-256.sasl.login.class=com.example.CustomScramLogin。类型:类

默认值: null

有效值。

重要性:中等

更新模式:只读

sasl.login.refresh.buffer.seconds

刷新凭证时,在凭证到期前要保持的缓冲时间,以秒为单位。如果刷新的时间离到期时间比缓冲秒数更近,那么刷新时间将被提前,以尽可能多地保持缓冲时间。法定值在0到3600(1小时)之间;如果没有指定值,则使用默认值300(5分钟)。如果该值和sasl.login.refresh.min.period.seconds的总和超过了凭证的剩余寿命,则该值和sasl.login.refresh.min.period.seconds都会被忽略。目前只适用于OAUTHBEARER。类型:short

默认值:300

有效值。

重要性:中等

更新模式:每个broker

sasl.login.refresh.min.period.seconds

登录刷新线程在刷新凭证前需要等待的最短时间,以秒为单位。合法值在0到900(15分钟)之间;如果没有指定值,则使用默认值60(1分钟)。如果这个值和sasl.login.refresh.buffer.seconds的总和超过了一个凭证的剩余寿命,那么这个值和sasl.login.buffer.seconds都会被忽略。目前只适用于OAUTHBEARER。类型:short

默认值:60

有效值。

重要性:中等

更新模式:每个broker

sasl.login.refresh.window.factor

登录刷新线程将休眠,直到达到相对于凭证寿命的指定窗口系数,此时将尝试刷新凭证。合法值在0.5(50%)到1.0(100%)之间,如果没有指定值,则使用默认值0.8(80%)。目前仅适用于OAUTHBEARER。类型:double

默认值:0.8

有效值。

重要性:中等

更新模式:每个broker

sasl.login.refresh.window.jitter

相对于凭证的寿命,加到登录刷新线程的睡眠时间的最大随机抖动量。合法值在0到0.25(25%)之间,如果没有指定值,则使用默认值0.05(5%)。目前只适用于OAUTHBEARER。类型:double

默认值:0.05

有效值。

重要性:中等

更新模式:每个broker

sasl.mechanism.inter.broker.protocol

用于broker之间通信的SASL机制。默认为GSSAPI。类型:string

默认值。 GSSAPI

有效值。

重要性:中等

更新模式:每个broker

sasl.server.callback.handler.class

实现AuthenticateCallbackHandler接口的SASL服务器回调处理程序类的完全限定名称。服务器回调处理程序必须以监听器前缀和SASL机制名称为前缀,并使用小写字母。例如,listener.name.sasl_ssl.plain.sasl.server.callback.handler.class=com.example.CustomPlainCallbackHandler。类型:class

默认值: null

有效值。

重要性:中等

更新模式:只读

security.inter.broker.protocol

用于broker之间通信的安全协议。有效值是: PLAINTEXT, SSL, SASL_PLAINTEXT, SASL_SSL. 同时设置此属性和inter.broker.listener.name属性是错误的。类型:string

默认值。 PLAINTEXT

有效值。

重要性:中等

更新模式:只读

socket.connection.setup.timeout.max.ms

客户端等待建立套接字连接的最大时间。连接设置超时时间将随着每一次连续的连接失败而成倍增加,直到这个最大值。为了避免连接风暴,超时时间将被应用于0.2的随机系数,结果是低于计算值20%到高于计算值20%的随机范围。类型:长

默认:127000(127秒)

有效值。

重要性:中等

更新模式:只读

socket.connection.setup.timeout.ms

客户端等待socket连接建立的时间。如果在超时之前没有建立连接,客户端将关闭socket通道。类型:long

默认:10000(10秒)

有效值。

重要性:中等

更新模式:只读

ssl.cipher.suites

密码套件的列表。这是一个命名的认证、加密、MAC和密钥交换算法的组合,用于使用TLS或SSL网络协议协商网络连接的安全设置。默认情况下,支持所有可用的密码套件。类型:list

默认:""

有效值。

重要性:中等

更新模式:每个broker

ssl.client.auth

配置kafka broker请求客户端认证。以下是常用的设置。ssl.client.auth=required 如果设置为require,则客户端认证是必须的。

ssl.client.auth=requested 这意味着客户端认证是可选的,与required不同,如果设置了这个选项,客户端可以选择不提供自己的认证信息。

ssl.client.auth=none 这表示不需要客户端认证。

类型:string

默认:无

有效值: [required, requested, none]

重要性:中等

更新模式:每个broker

ssl.enabled.protocols

为SSL连接启用的协议列表。默认值是 "TLSv1.2,TLSv1.3",当运行Java 11或更新版本时,否则为 "TLSv1.2"。在Java 11的默认值下,如果客户端和服务器都支持TLSv1.3,则会优先选择TLSv1.3,否则会回退到TLSv1.2(假设两者都至少支持TLSv1.2)。这个默认值在大多数情况下应该是没有问题的。也可以参考`ssl.protocol`的配置文档。类型:list

默认值: TLSv1.2

有效值。

重要性:中等

更新模式:每个broker

ssl.key.password

密钥存储文件中私钥的密码,或在`ssl.keystore.key'中指定的PEM密钥。只有在配置了双向身份验证的情况下,客户端才需要这个密码。类型:password

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.keymanager.algorithm

钥匙管理器工厂用于SSL连接的算法,默认值是为Java虚拟机配置的钥匙管理器工厂算法。默认值是为Java虚拟机配置的密钥管理器工厂算法。类型:string

默认值。 SunX509

有效值。

重要性:中等

更新模式:每个broker

ssl.keystore.certificate.chain

证书链的格式由'ssl.keystore.type'指定。默认的SSL引擎工厂只支持PEM格式的X.509证书列表。类型:password

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.keystore.key

私钥的格式由'ssl.keystore.type'指定。默认SSL引擎工厂只支持PEM格式的PKCS#8密钥。如果密钥是加密的,必须使用'ssl.key.password'指定密钥密码。类型:password

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.keystore.location

密钥存储文件的位置。对客户端来说是可选的,可以用于客户端的双向认证。类型:string

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.keystore.password

密钥存储文件的存储密码。这对客户端来说是可选的,只有在配置了'ssl.keystore.location'时才需要。对于PEM格式,不支持密钥存储密码。类型:password

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.keystore.type

密钥存储文件的文件格式。对客户端来说是可选的。类型:string

默认值。 JKS

有效值。

重要性:中等

更新模式:每个broker

ssl.protocol

用来生成SSLContext的SSL协议,默认为'TLSv1.3',否则为'TLSv1.2'。当运行Java 11或更新版本时,默认为'TLSv1.3',否则为'TLSv1.2'。这个值对于大多数的使用情况来说应该是没有问题的。在最近的JVM中允许的值是'TLSv1.2'和'TLSv1.3'。TLS','TLSv1.1','SSL','SSLv2'和'SSLv3'在旧的JVM中可能会被支持,但由于已知的安全漏洞,我们不鼓励使用它们。在这个配置和'ssl.enabled.protocols'的默认值下,如果服务器不支持'TLSv1.3',客户端将降级为'TLSv1.2'。如果这个配置被设置为'TLSv1.2',即使是ssl.enabled.protocols中的一个值,并且服务器只支持'TLSv1.3',客户端也不会使用'TLSv1.3'。类型:string

默认值: TLSv1.2

有效值。

重要性:中等

更新模式:每个broker

ssl.provider

用于SSL连接的安全提供者的名称。默认值是JVM的默认安全提供者。类型:string

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.trustmanager.algorithm

信任管理器工厂用于SSL连接的算法。默认值是为Java虚拟机配置的信任管理器工厂算法。类型:string

默认值。 PKIX

有效值。

重要性:中等

更新模式:每个broker

ssl.truststore.certificates

可信证书的格式由'ssl.truststore.type'指定。默认SSL引擎工厂只支持PEM格式的X.509证书。类型:password

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.truststore.location

信任存储文件的位置。类型:string

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.truststore.password

信任存储文件的密码。如果没有设置密码,则仍然使用配置的信任存储文件,但完整性检查被禁用。PEM格式不支持信任存储密码。类型:password

默认值: null

有效值。

重要性:中等

更新模式:每个broker

ssl.truststore.type

信任存储文件的文件格式。类型:string

默认值。 JKS

有效值。

重要性:中等

更新模式:每个broker

zookeeper.clientCnxnSocket

当使用TLS连接到ZooKeeper时,通常设置为org.apache.zookeeper.ClientCnxnSocketNetty。覆盖任何通过同名的zookeeper.clientCnxnSocket系统属性设置的显式值。类型:string

默认值: null

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.client.enable

设置客户端连接到ZooKeeper时使用TLS。显式的值会覆盖任何通过zookeeper.client.secure system属性设置的值(注意名称不同)。如果两者都没有设置,默认为false;当为true时,必须设置zookeeper.clientCnxnSocket(通常为org.apache.zookeeper.ClientCnxnSocketNetty);其他需要设置的值可能包括zookeeper.ssl.cipher.suites、zookeeper.ssl.crl.enable、zookeeper.ssl.enabled.protocols、zookeeper.ssl. endpoint.identification.algorithm, zookeeper.ssl.keystore.location, zookeeper.ssl.keystore.password, zookeeper.ssl.keystore.type, zookeeper.ssl.ocsp.enable, zookeeper.ssl.protocol, zookeeper.ssl.truststore.location, zookeeper.ssl.truststore.password, zookeeper.ssl.truststore.type。类型: boolean

默认:假

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.keystore.location

当使用客户端证书与TLS连接到ZooKeeper时的keystore位置。覆盖任何通过zookeeper.ssl.keyStore.location系统属性设置的显式值(注意是camelCase)。类型:string

默认值: null

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.keystore.password

当使用客户端证书与TLS连接到ZooKeeper时的密钥存储密码。覆盖任何通过zookeeper.ssl.keyStore.password系统属性设置的显式值(注意是camelCase)。注意ZooKeeper不支持与keystore密码不同的密钥密码,所以一定要将keystore中的密钥密码设置为与keystore密码相同,否则连接Zookeeper的尝试将失败。类型:password

默认值: null

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.keystore.type

当使用客户端证书与TLS连接到ZooKeeper时的keystore类型。覆盖任何通过zookeeper.ssl.keyStore.type系统属性设置的显式值(注意骆驼大写)。默认值为null意味着类型将根据keystore的文件扩展名自动检测。类型:string

默认值: null

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.truststore.location

当使用TLS连接到ZooKeeper时的Truststore位置。覆盖任何通过zookeeper.ssl.trustStore.location系统属性设置的显式值(注意是camelCase)。类型:string

默认值: null

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.truststore.password

当使用TLS连接到ZooKeeper时的Truststore密码。覆盖任何通过zookeeper.ssl.trustStore.password系统属性设置的显式值(注意是camelCase)。类型:password

默认值: null

有效值。

重要性:中等

更新模式:只读

zookeeper.ssl.truststore.type

当使用TLS连接到ZooKeeper时的Truststore类型。覆盖任何通过zookeeper.ssl.trustStore.type系统属性设置的显式值(注意骆驼大写)。默认值为null意味着该类型将根据truststore的文件扩展名自动检测。类型:string

默认值: null

有效值。

重要性:中等

更新模式:只读

alter.config.policy.class.name

应该用于验证的 alter configs 策略类。该类应该实现org.apache.kafka.server.policy.AlterConfigPolicy接口。类型:class

默认值: null

有效值。

重要性:低

更新模式:只读

alter.log.dirs.replication.quota.window.num

为改变日志目录复制配额而保留在内存中的样本数量。类型:int

默认值:11

有效值:[1,...]

重要性:低

更新模式:只读

alter.log.dirs.replication.quota.window.size.seconds

alter log dirs复制配额的每个样本的时间跨度。类型:int

默认值:1

有效值:[1,...]

重要性:低

更新模式:只读

authorizer.class.name

实现sorg.apache.kafka.server.authorizer.Authorizer接口的类的完全限定名称,该类被broker用于授权。该配置还支持实现已废弃的kafka.security.uth.Authorizer trait的授权者,该授权者以前用于授权。类型:string

默认:""

有效值。

重要性:低

更新模式:只读

client.quota.callback.class

实现ClientQuotaCallback接口的类的全称,该类用于确定应用于客户端请求的配额限制。默认情况下,应用的是 ,或ZooKeeper中存储的配额。对于任何给定的请求,将应用与会话的用户主控和请求的client-id相匹配的最具体的配额。类型:class

默认值: null

有效值。

重要性:低

更新模式:只读

connection.failed.authentication.delay.ms

认证失败时的连接关闭延迟:这是认证失败时连接关闭延迟的时间(毫秒)。该值必须配置为小于 connections.max.idle.ms,以防止连接超时。类型:int

默认值:100

有效值:[0,...]

重要性:低

更新模式:只读

controller.quota.window.num

控制器突变配额在内存中保留的样本数量。类型:int

默认值:11

有效值:[1,...]

重要性:低

更新模式:只读

controller.quota.window.size.seconds

控制器突变定额的每个样本的时间跨度。类型:int

默认值:1

有效值:[1,...]

重要性:低

更新模式:只读

create.topic.policy.class.name

应该用于验证的创建主题策略类。该类应该实现org.apache.kafka.server.policy.CreateTopicPolicy接口。类型:class

默认值: null

有效值。

重要性:低

更新模式:只读

delegation.token.expiry.check.interval.ms

移除过期的授权令牌的扫描间隔。类型:长

默认:3600000(1小时)

有效值:[1,...]

重要性:低

更新模式:只读

kafka.metrics.polling.interval.secs

kafka.metrics.reporters实现中可以使用的度量值轮询间隔(秒)。类型:int

默认值:10

有效值:[1,...]

重要性:低

更新模式:只读

kafka.metrics.reporters

作为Yammer metrics自定义报告器的类列表。这些报告器应该实现kafka.metrics.KafkaMetricsReporter trait。如果客户端想要在自定义报告器上公开JMX操作,自定义报告器需要额外实现一个MBean trait,这个MBean trait扩展了kafka.metrics.KafkaMetricsReporterMBean trait,以便注册的MBean符合标准MBean约定。类型:list

默认:""

有效值。

重要性:低

更新模式:只读

listener.security.protocol.map

监听器名称和安全协议之间的映射。要想让同一个安全协议在多个端口或IP中使用,就必须定义这个映射。例如,内部和外部流量可以分开,即使两者都需要SSL。具体来说,用户可以将名称为INTERNAL和EXTERNAL的监听器和这个属性定义为。`INTERNAL:SSL,EXTERNAL:SSL`。如图所示,键和值用冒号隔开,映射项用逗号隔开。每个监听器名称在地图中只能出现一次。通过在配置名称中添加规范化的前缀(监听器名称为小写),可以为每个监听器配置不同的安全(SSL和SASL)设置。例如,如果要为INTERNAL监听器设置不同的keystore,就可以设置名称为listener.name.internal.ssl.keystore.location的config。如果没有设置监听器名称的config,config将回落到通用config(即ssl.keystore.location)。类型:string

默认值。 PLAINTEXT:PLAINTEXT,SSL:SSL,SASL_PLAINTEXT:SASL_PLAINTEXT,SASL_SSL:SASL_SSL。

有效值。

重要性:低

更新模式:每个broker

log.message.downconversion.enable

此配置控制是否启用消息格式的向下转换以满足消费请求。当设置为false时,broker不会对期待旧消息格式的消费者执行向下转换。broker 会对来自此类旧客户的消费请求作出 UNSUPPORTED_VERSION 错误响应。此配置不适用于复制到跟随者时可能需要的任何消息格式转换。类型:boolean

默认:true

有效值。

重要性:低

更新模式:全集群

metric.reporters

作为度量报告器使用的类的列表。实现org.apache.kafka.common.metrics.MetricsReporter接口允许插入将被通知新的度量创建的类。JmxReporter总是被包含在注册JMX统计数据中。类型:list

默认:""

有效值。

重要性:低

更新模式:全集群

metrics.num.samples

为计算指标而维护的样本数量。类型:int

默认值:2

有效值:[1,...]

重要性:低

更新模式:只读

metrics.recording.level

指标的最高记录级别。类型:string

默认:INFO

有效值。

重要性:低

更新模式:只读

metrics.sample.window.ms

度量样本计算的时间窗口。类型:长

默认:30000(30秒)

有效值:[1,...]

重要性:低

更新模式:只读

password.encoder.cipher.algorithm

动态配置密码的加密算法。类型:string

默认情况下,AES/CBC/PKCS5Padding AES/CBC/PKCS5Padding。

有效值。

重要性:低

更新模式:只读

password.encoder.iterations

动态配置的密码编码的迭代次数。类型:int

默认值:4096

有效值: [1024,...]

重要性:低

更新模式:只读

password.encoder.key.length

动态配置密码的密钥长度。类型:int

默认值:128

有效值: [8,...]

重要性:低

更新模式:只读

password.encoder.keyfactory.algorithm

用于动态配置密码编码的SecretKeyFactory算法,如果有的话,默认为PBKDF2WithHmacSHA512,否则为PBKDF2WithHmacSHA1。默认值为PBKDF2WithHmacSHA512(如果可用),否则为PBKDF2WithHmacSHA1。类型:string

默认值: null

有效值。

重要性:低

更新模式:只读

quota.window.num

客户端配额在内存中保留的样本数量。类型:int

默认值:11

有效值:[1,...]

重要性:低

更新模式:只读

quota.window.size.seconds

客户定额的每个样本的时间跨度。类型:int

默认值:1

有效值:[1,...]

重要性:低

更新模式:只读

replication.quota.window.num

为复制配额而保留在内存中的样本数量。类型:int

默认值:11

有效值:[1,...]

重要性:低

更新模式:只读

replication.quota.window.size.seconds

复制定额的每个样本的时间跨度。类型:int

默认值:1

有效值:[1,...]

重要性:低

更新模式:只读

security.providers

一个可配置的创建者类的列表,每个类都返回一个实现安全算法的提供者。这些类应该实现org.apache.kafka.common.security.ah.SecurityProviderCreator接口。类型:string

默认值: null

有效值。

重要性:低

更新模式:只读

ssl.endpoint.identification.algorithm

使用服务器证书验证服务器主机名的端点识别算法。类型:string

默认:https

有效值。

重要性:低

更新模式:每个broker

ssl.engine.factory.class

org.apache.kafka.common.security.auth.SslEngineFactory类型的类来提供SSLEngine对象。默认值是org.apache.kafka.common.security.ssl.DefaultSslEngineFactory。类型:class

默认值: null

有效值。

重要性:低

更新模式:每个broker

ssl.principal.mapping.rules

用于将客户证书中的区别名称映射到短名称的规则列表。这些规则按顺序评估,第一条与主名匹配的规则被用来将其映射为短名。列表中的任何后面的规则将被忽略。默认情况下,X.500 证书的区别名称将是主证书。有关格式的更多细节,请参见安全授权和 acls。请注意,如果 principal.builder.class 配置提供了 KafkaPrincipalBuilder 的扩展,这个配置将被忽略。类型:string

默认值。 默认值: DEFAULT

有效值。

重要性:低

更新模式:只读

ssl.secure.random.implementation

用于SSL加密操作的SecureRandom PRNG实现。类型:string

默认值: null

有效值。

重要性:低

更新模式:每个broker

transaction.abort.timed.out.transaction.cleanup.interval.ms

回滚已超时的事务的时间间隔。类型:int

默认:10000(10秒)

有效值:[1,...]

重要性:低

更新模式:只读

transaction.remove.expired.transaction.cleanup.interval.ms

删除因transactional.id.expertation.ms过期而过期的事务的时间间隔。类型:int

默认:3600000(1小时)

有效值:[1,...]

重要性:低

更新模式:只读

zookeeper.ssl.cipher.suites

指定ZooKeeper TLS协商中使用的密码套件(csv)。覆盖任何通过zookeeper.ssl.ciphersuites系统属性设置的显式值(注意单字 "ciphersuites")。默认值为null意味着启用的密码套件列表是由正在使用的Java运行时决定的。类型:list

默认值: null

有效值。

重要性:低

更新模式:只读

zookeeper.ssl.crl.enable

指定是否启用ZooKeeper TLS协议中的证书撤销列表。覆盖任何通过zookeeper.ssl.crl系统属性设置的显式值(注意是短名)。类型:boolean

默认:假

有效值。

重要性:低

更新模式:只读

zookeeper.ssl.enabled.protocols

指定ZooKeeper TLS协商(csv)中启用的协议。覆盖任何通过zookeeper.ssl.enabledProtocols系统属性设置的显式值(注意骆驼大写)。默认值为null意味着启用的协议将是zookeeper.ssl.protocol配置属性的值。类型:list

默认值: null

有效值。

重要性:低

更新模式:只读

zookeeper.ssl.endpoint.identification.algorithm

指定是否在ZooKeeper TLS协商过程中启用主机名验证,(不区分大小写)"https "表示启用ZooKeeper主机名验证,显式的空白值表示禁用(仅为测试目的建议禁用)。明确的值会覆盖任何通过zookeeper.ssl.hostnameVerification系统属性设置的 "true "或 "false "值(注意不同的名称和值,true意味着https,false意味着空白)。类型:string

默认:HTTPS

有效值。

重要性:低

更新模式:只读

zookeeper.ssl.ocsp.enable

指定是否启用ZooKeeper TLS协议中的在线证书状态协议。覆盖任何通过zookeeper.ssl.ocsp系统属性设置的显式值(注意是短名)。类型:boolean

默认:假

有效值。

重要性:低

更新模式:只读

zookeeper.ssl.protocol

指定ZooKeeper TLS协商中使用的协议。一个显式的值会覆盖通过同名的zookeeper.ssl.protocol系统属性设置的任何值。类型:string

默认值: TLSv1.2

有效值。

重要性:低

更新模式:只读

zookeeper.sync.time.ms

一个ZK跟随者可以落后于一个ZK领导者多远类型:int

默认:2000(2秒)

有效值。

重要性:低

更新模式:只读

关于broker配置的更多细节可以在scala类kafka.server.KafkaConfig中找到。

3.1.1 更新broker配置

从Kafka 1.1版本开始,部分broker配置可以在不重新启动broker的情况下进行更新。请参阅Broker Configs中的动态更新模式列,了解每个broker配置的更新模式。

- 只读。需要重启broker才能更新

- 每家broker。可为每个broker动态更新

- 全群集。可作为全群组的默认值动态更新。也可以作为每个broker的值进行更新,以便测试。

要改变当前broker id 0的broker配置(例如,日志清理线程的数量)。

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type brokers --entity-name 0 --alter --add-config log.cleaner.threads=2

要描述当前动态broker配置的broker id 0:

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type brokers --entity-name 0 --describe

要删除config覆盖,并恢复到broker id 0的静态配置或默认值(例如,日志清理线程的数量)。

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type brokers --entity-name 0 --alter --delete-config log.cleaner.threads

某些配置可能会被配置为整个群集的默认值,以保持整个群集的一致值。集群中的所有broker将处理集群默认更新。例如,要更新所有broker上的日志清理线程。

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type brokers --entity-default --alter --add-config log.cleaner.threads=2

要描述当前配置的动态全集群默认配置。

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type brokers --entity-default --describe

所有在群集级别上可配置的配置值也可以在每个路由器级别上配置(例如用于测试)。如果一个配置值在不同级别定义,则使用以下优先顺序。

- 在ZooKeeper中的动态存储每个broker配置。

- 动态的全集群默认配置存储在ZooKeeper中。

- 从server.properties中静态配置broker

- Kafka默认值,见broker配置

动态更新密码设置

动态更新的密码配置值在ZooKeeper中存储前会被加密。broker配置password.encoder.secret必须在server.properties中配置以启用动态更新密码配置。不同的broker的secret可能不同。

用于密码编码的秘密可能会随着broker的滚动重启而轮换。目前ZooKeeper中用于编码密码的旧秘密必须在静态broker配置password.encoder.old.secret中提供,新秘密必须在password.encoder.secret中提供。所有存储在ZooKeeper中的动态密码配置将在broker启动时用新的秘密重新编码。

在Kafka 1.1.x中,当使用kafka-configs.sh更新配置时,必须在每个alter请求中提供所有动态更新的密码配置,即使密码配置没有被改变。这个限制将在未来的版本中被移除。

在开始broker之前更新ZooKeeper的密码设置

从Kafka 2.0.0开始,kafka-configs.sh可以在启动broker进行引导之前,使用ZooKeeper更新动态broker配置。这使得所有的密码配置都以加密的形式存储,避免了在server.properties中清除密码的需要。如果在alter命令中包含任何密码配置,还必须指定broker配置password.encoder.secret。也可以指定其他加密参数。密码编码器配置将不会在ZooKeeper中持续存在。例如,要在broker 0上存储监听器INTERNAL的SSL密钥密码。

> bin/kafka-configs.sh --zookeeper localhost:2182 --zk-tls-config-file zk_tls_config.properties --entity-type brokers --entity-name 0 --alter --add-config

'listener.name.internal.ssl.key.password=key-password,password.encoder.secret=secret,password.encoder.iterations=8192'配置监听器.name.internal.ssl.key.password将使用提供的编码器配置以加密的形式持久化在ZooKeeper中。编码器的秘密和迭代不会持续在ZooKeeper中。

更新现有监听器的SSL密钥库

broker可以配置有效期较短的SSL密钥存储,以降低证书泄露的风险。密钥存储可以动态更新,而无需重新启动broker。配置名称必须以监听器前缀listener.name.{listenerName}为前缀,这样就只更新特定监听器的keystore配置。以下配置可以在每个broker级别的单个alter请求中更新。

- ssl.keystore.type

- ssl.keystore.location

- ssl.keystore.password

- ssl.key.password

如果监听器是broker之间的监听器,只有当新的keystore被为该监听器配置的truststore信任时,才允许更新。对于其他监听器,broker不会对密钥store进行信任验证。证书必须由签署旧证书的同一证书颁发机构签署,以避免任何客户端验证的失败。

更新现有监听器的SSL Truststore

brokertruststores可以动态更新,而不需要重新启动broker来添加或删除证书。更新后的truststore将用于验证新的客户端连接。配置名称必须以监听器前缀listener.name.{listenerName}为前缀,这样只有特定监听器的truststore配置才会更新。以下配置可以在每个broker级别的单个alter请求中更新。

- ssl.truststore.type

- ssl.truststore.location

- ssl.truststore.password

如果监听器是broker之间的监听器,只有当该监听器的现有keystore被新的truststore信任时,才允许更新。对于其他监听器,更新前,中间商不进行信任验证。从新的信任store中删除用于签署客户端证书的CA证书会导致客户端认证失败。

更新默认主题配置

broker使用的默认主题配置选项可以在不重启broker的情况下更新。这些配置被应用于没有主题配置覆盖的主题,相当于每个主题的配置。这些配置中的一个或多个可以在所有broker使用的集群默认级别被覆盖。

log.segment.byteslog.roll.mslog.roll.hourslog.roll.jitter.mslog.roll.jitter.hourslog.index.size.max.byteslog.flush.interval.messageslog.flush.interval.mslog.retention.byteslog.retention.mslog.retention.minuteslog.retention.hourslog.index.interval.byteslog.cleaner.delete.retention.mslog.cleaner.min.compaction.lag.mslog.cleaner.max.compaction.lag.mslog.cleaner.min.cleanable.ratiolog.cleanup.policylog.segment.delete.delay.msunclean.leader.election.enablemin.insync.replicasmax.message.bytescompression.typelog.preallocatelog.message.timestamp.typelog.message.timestamp.difference.max.ms

从Kafka 2.0.0版本开始,当动态更新配置unclean.leader.election.enhance时,控制器会自动启用unclean.leader.election.enhance。在Kafka 1.1.x版本中,对unclean.leader.election.enable的更改只有在新控制器当选时才会生效。可以通过运行控制器重新选举来强制执行。

> bin/zookeeper-shell.sh localhost

rmr /controller更新日志清理器配置

日志清理配置可以在所有broker使用的集群默认级别动态更新。这些更改将在下一次日志清理迭代时生效。这些配置中的一个或多个可以被更新。

log.cleaner.threadslog.cleaner.io.max.bytes.per.secondlog.cleaner.dedupe.buffer.sizelog.cleaner.io.buffer.sizelog.cleaner.io.buffer.load.factorlog.cleaner.backoff.ms

更新线程配置

broker使用的各种线程池的大小可以在所有broker使用的集群默认级别动态更新。更新限制在currentSize / 2到currentSize * 2的范围内,以确保配置更新被优雅地处理。

num.network.threadsnum.io.threadsnum.replica.fetchersnum.recovery.threads.per.data.dirlog.cleaner.threadsbackground.threads

更新连接配额配置

broker对给定 IP/主机允许的最大连接数可以在所有broker使用的集群默认级别动态更新。这些变化将适用于新连接的创建,现有的连接数将被新的限制所考虑。

max.connections.per.ipmax.connections.per.ip.overrides

添加和删除监听器

监听器可以被动态地添加或删除。当添加新的监听器时,必须以监听器前缀listener.name.{listenerName}.的监听器配置来提供监听器的安全配置。如果新的监听器使用SASL,必须使用JAAS配置属性sasl.jaas.config提供监听器的JAAS配置,并加上监听器和机制前缀。详情请参见Kafkabroker的JAAS配置。

在Kafka 1.1.x版本中,broker间监听器使用的监听器可能无法动态更新。要将broker间监听器更新为新的监听器,可以在所有broker上添加新的监听器,而不需要重新启动broker。然后需要滚动重启来更新inter.broker.listener.name。

除了新监听器的所有安全配置外,以下配置可以在每个broker级别动态更新。

listenersadvertised.listenerslistener.security.protocol.map

broker之间的监听器必须使用静态broker配置inter.broker.listener.name或inter.broker.security.protocol进行配置。

3.2 主题级配置

与主题相关的配置既有服务器默认值,也有可选的每个主题覆盖值。如果没有给出每个主题的配置,则使用服务器默认值。覆盖可以在创建主题时通过给出一个或多个--config选项来设置。这个例子创建了一个名为my-topic的主题,并自定义了最大消息大小和刷新率。

> bin/kafka-topics.sh --bootstrap-server localhost:9092 --create --topic my-topic --partitions 1 \

--replication-factor 1 --config max.message.bytes=64000 --config flush.messages=1覆盖也可以在以后使用 alter configs 命令进行更改或设置。这个例子更新了my-topic的最大消息大小。

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type topics --entity-name my-topic --alter --add-config max.message.bytes=128000

要检查主题上重载的设置,你可以执行以下操作

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type topics --entity-name my-topic --describe

要删除重载的设置,您可以执行以下操作

> bin/kafka-configs.sh --bootstrap-server localhost:9092 --entity-type topics --entity-name my-topic --alter --delete-config max.message.bytes

以下是主题级的配置。在服务器默认属性标题下给出了该属性的服务器默认配置。给定的服务器默认配置值只适用于没有明确的主题配置覆盖的主题。

cleanup.policy

字符串,可以是 "删除 "或 "压缩",或者两者都是。此字符串指定对旧日志段使用的保留策略。默认策略("删除")将在达到保留时间或大小限制时丢弃旧片段。紧凑 "设置将启用主题上的日志压缩。类型:list

默认:delete

有效值。[compact, delete]

服务器默认属性:log.cleanup.policy。

重要性:中等

compression.type

指定给定主题的最终压缩类型。此配置接受标准的压缩编解码器('gzip'、'snappy'、'lz4'、'zstd')。此外,它还接受'uncompressed',这相当于没有压缩;以及'producer',这意味着保留制作者设置的原始压缩编解码器。类型:string

默认:producer

有效值。 [uncompressed, zstd, lz4, snappy, gzip, producer]

服务器默认属性:compression.type

重要性:中等

delete.retention.ms

为日志压缩主题保留删除墓碑标记的时间。如果消费者从偏移量0开始读取,这个设置还给出了消费者必须完成读取的时间界限,以确保他们得到最后阶段的有效快照(否则,删除墓碑可能会在完成扫描之前被收集)。类型:long

默认:86400000(1天)。

有效值:[0,...]

服务器默认属性:log.cleaner.delete.retention.ms

重要性:中等

file.delete.delay.ms

从文件系统中删除文件前等待的时间。类型:long

默认:60000(1分钟)

有效值:[0,...]

服务器默认属性:log.segment.delete.delay.ms

重要性:中等

flush.messages

这个设置允许指定一个时间间隔,在这个时间间隔内,我们将强制对写入日志的数据进行fsync。例如,如果设置为1,我们将在每条消息后进行fsync;如果设置为5,我们将在每五条消息后进行fsync。一般情况下,我们建议你不要设置这个,使用复制来保证持久性,并允许操作系统的后台刷新功能,因为它更有效率。这个设置可以在每个主题的基础上被覆盖(见每个主题配置部分)。类型:长

默认:9223372036854775807。

有效值:[0,...]

服务器默认属性:log.flush.interval.messages

重要性:中等

flush.ms

这个设置允许指定一个时间间隔,在这个时间间隔内,我们将强制对写入日志的数据进行fsync。例如,如果设置为1000,我们将在1000毫秒后进行fsync。一般情况下,我们建议你不要设置这个,使用复制来提高耐用性,并允许操作系统的后台刷新功能,因为它更有效。类型:long

默认:9223372036854775807。

有效值:[0,...]

服务器默认属性:log.flush.interval.ms

重要性:中等

follower.replication.throttled.replicas

一个副本的列表,对于这些副本,日志复制应该在follower端进行节流。该列表应该以[PartitionId]:[BrokerId],[PartitionId]:[BrokerId]:...的形式描述一组副本,或者使用通配符'*'来节制这个主题的所有副本。类型:list

默认:""

有效值。 [partitionId]:[brokerId],[partitionId]:[brokerId],...

服务器默认属性:follower.replication.throttled.replicas

重要性:中等

index.interval.bytes

这个设置控制了Kafka向其偏移索引添加索引项的频率。默认设置确保我们大约每4096个字节为一条消息建立索引。更多的索引允许读取跳转到更接近日志中的准确位置,但会使索引更大。你可能不需要改变这个设置。类型:int

默认值:4096(4 kibibytes)

有效值:[0,...]

服务器默认属性:log.index.interval.bytes

重要性:中等

leader.replication.throttled.replicas

复制的列表,对于这些复制,日志复制应该在领导侧进行节流。该列表应以[PartitionId]:[BrokerId],[PartitionId]:[BrokerId]:...的形式描述一组副本,或者使用通配符'*'来节制这个主题的所有副本。类型:list

默认:""

有效值。 [partitionId]:[brokerId],[partitionId]:[brokerId],...

服务器默认属性:leader.replication.throttled.replicas

重要性:中等

max.compaction.lag.ms

消息在日志中不符合压实条件的最长时间。仅适用于正在压缩的日志。类型:long

默认:9223372036854775807

有效值:[1,...]

服务器默认属性:log.cleaner.max.compaction.lag.ms

重要性:中等

max.message.bytes

Kafka允许的最大记录批次大小(如果启用压缩,则压缩后)。如果增加这个大小,并且有比0.10.2更老的消费者,消费者的取数大小也必须增加,这样才能取到这么大的记录批。在最新的消息格式版本中,为了提高效率,记录总是被分组成批。在以前的消息格式版本中,未压缩的记录不会被分组成批,在这种情况下,这个限制只适用于单个记录。类型:int

默认值:1048588

有效值:[0,...]

服务器默认属性: message.max.bytes

重要性:中等

message.format.version

指定broker将使用的消息格式版本来追加消息到日志。该值应该是一个有效的ApiVersion。一些例子是 0.8.2, 0.9.0.0, 0.10.0, 查看ApiVersion了解更多细节。通过设置一个特定的消息格式版本,用户证明磁盘上所有现有的消息都小于或等于指定的版本。不正确地设置这个值会导致使用旧版本的消费者崩溃,因为他们会收到一个他们不理解的格式的消息。类型:string

默认:2.7-IV2

有效值。 [0.8.0、0.8.1、0.8.2、0.9.0、0.10.0-IV0、0.10.0-IV1、0.10.1-IV0、0.10.1-IV1、0.10.1-IV2、0.10.2-IV0、0.11.0-IV0、0.11.0-IV1、0.11.0-IV2、1.0-IV0、1. 1-IV0、2.0-IV0、2.0-IV1、2.1-IV0、2.1-IV1、2.1-IV2、2.2-IV0、2.2-IV1、2.3-IV0、2.3-IV1、2.4-IV0、2.4-IV1、2.5-IV0、2.6-IV0、2.7-IV0、2.7-IV1、2.7-IV2]

服务器默认属性:log.message.format.version

重要性:中等

message.timestamp.difference.max.ms

broker收到消息时的时间戳和消息中指定的时间戳之间允许的最大差异。如果 message.timestamp.type=CreateTime,如果时间戳的差异超过这个阈值,消息将被拒绝。如果 message.timestamp.type=LogAppendTime,这个配置会被忽略。类型:long

默认:9223372036854775807

有效值:[0,...]

服务器默认属性:log.message.timestamp.difference.max.ms

重要性:中等

message.timestamp.type

定义消息中的时间戳是消息创建时间还是日志追加时间。该值应该是`CreateTime`或`LogAppendTime`。类型:string

默认值: CreateTime

有效值: [CreateTime, LogAppendTime]

服务器默认属性:log.message.timestamp.type

重要性:中等

min.cleanable.dirty.ratio

此配置可控制日志压缩器尝试清理日志的频率(假设已启用日志压缩)。默认情况下,我们将避免清理日志中超过 50% 的日志已被压缩。这个比率限制了重复的日志所浪费的最大空间(在50%时,最多有50%的日志可能是重复的)。更高的比率意味着更少、更有效的清理,但意味着日志中浪费的空间更多。如果还指定了max.compaction.lag.ms或min.compaction.lag.ms配置,那么日志压缩器认为只要达到以下任一条件,该日志就有资格进行压缩。(i) 达到 dirty ratio 阈值,并且日志至少在 min.compaction.lag.ms 持续时间内有 dirty(未压缩)记录,或 (ii) 如果日志最多在 max.compaction.lag.ms 期间有 dirty(未压缩)记录,则日志压缩器认为有资格进行压缩。类型:double

默认值:0.5

有效值:[0,...,1]

服务器默认属性:log.cleaner.min.cleanable.ratio

重要性:中等

min.compaction.lag.ms

消息在日志中未压缩的最短时间。仅适用于正在压缩的日志。

类型:long

默认值:0

有效值:[0,...]

服务器默认属性:log.cleaner.min.compaction.lag.ms

重要性:中等

min.insync.replicas

当生产者将acks设置为 "all"(或"-1")时,这个配置指定了必须确认写入才能被认为是成功的最低数量的复制。如果不能满足这个最小数量,那么生产者将引发一个异常(NotEnoughReplicas或NotEnoughReplicasAfterAppend)。

当一起使用时,min.insync.replicas和acks允许你实施更大的耐久性保证。一个典型的场景是创建一个复制因子为3的主题,将min.insync.replicas设置为2,并以 "all "的acks进行生产。这将确保生产者在大多数副本没有收到写入时引发异常。类型:int

默认值:1

有效值:[1,...]

服务器默认属性:min.insync.replicas

重要性:中等

preallocate

当创建一个新的日志段时,如果我们应该在磁盘上预分配文件,则为真。类型:boolean

默认:false

有效值:

服务器默认属性:log.preallocate

重要性:中等

retention.bytes

如果我们使用 "删除 "保留策略,此配置可控制分区(由日志段组成)的最大大小,然后我们才会丢弃旧的日志段以释放空间。默认情况下,没有大小限制,只有时间限制。由于该限制是在分区级别执行的,因此将其乘以分区的数量来计算以字节为单位的主题保留。类型:long

默认值:-1

有效值:

服务器默认属性:log.retaining.bytes

重要性:中等

retention.ms

如果我们使用 "删除 "保留策略,此配置可控制我们在丢弃旧的日志段以释放空间之前保留日志的最长时间。这代表了消费者必须在多长时间内读取其数据的SLA。如果设置为-1,则不适用时间限制。类型:long

默认:604800000(7天)

有效值:[-1,...]

服务器默认属性:log.retention.ms

重要性:中等

segment.bytes

此配置控制日志的段文件大小。保留和清理总是以文件为单位进行的,因此较大的段大小意味着较少的文件,但对保留的精细控制较少。类型:int

默认值:1073741824 (1 gibibyte)

有效值: [14,...]

服务器默认属性:log.segment.bytes

重要性:中等

segment.index.bytes

这个配置控制了将偏移量映射到文件位置的索引的大小。我们预先分配这个索引文件,只有在日志滚动后才会将其缩小。一般来说,你不应该需要改变这个设置。类型:int

默认值:10485760(10 mebibytes)

有效值:[0,...]

服务器默认属性:log.index.size.max.bytes

重要性:中等

segment.jitter.ms

从预定的段滚动时间中减去的最大随机抖动,以避免雷鸣般的段滚动群。类型:long

默认值:0

有效值:[0,...]

服务器默认属性:log.roll.jitter.ms

重要性:中等

segment.ms

这个配置控制了一段时间后,即使段文件没有满,Kafka也会强制滚动日志,以确保留存可以删除或压缩旧数据。类型:long

默认:604800000(7天)

有效值:[1,...]

服务器默认属性:log.roll.ms

重要性:中等

unclean.leader.election.enable

表示是否启用不在 ISR 集中的副本作为最后手段被选为领导者,即使这样做可能会导致数据丢失。类型:boolean

默认:false

有效值

服务器默认属性:unclean.leader.election.enable

重要性:中等

message.downconversion.enable

此配置控制是否启用消息格式的向下转换以满足消费请求。当设置为false时,broker不会对期待旧消息格式的消费者执行向下转换。broker 会对来自此类旧客户的消费请求作出 UNSUPPORTED_VERSION 错误响应。此配置不适用于复制到跟随者时可能需要的任何消息格式转换。类型:boolean

默认:true

有效值:

服务器默认属性:log.message.downconversion.enable

重要性:低

3.3 生产者配置

下面是生产者的配置:

key.serializer

实现org.apache.kafka.common.serialization.Serializer接口的key的Serializer类。类型:class

默认值:

有效值:

重要性:高

value.serializer

实现 org.apache.kafka.common.serialization.Serializer 接口的值的 Serializer 类。类型:class

默认值:

有效值:

重要性:高

acks

生产者要求领导人在认为请求完成之前收到的确认次数。这控制了发送记录的耐久性。允许以下设置。acks=0 如果设置为0,那么生产者将完全不等待服务器的任何确认。记录将立即被添加到套接字缓冲区中,并被视为已发送。在这种情况下,不能保证服务器已经收到了记录,重试配置也不会生效(因为客户端一般不会知道任何失败)。每条记录回馈的偏移量将始终设置为-1。

acks=1 这意味着领导者将把记录写到它的本地日志中,但不需要等待所有跟随者的完全确认就会做出回应。在这种情况下,如果领导者在确认记录后,但在追随者复制记录之前立即失败,那么记录将丢失。

acks=all 这意味着领导者将等待所有同步复制的记录确认。这保证了只要至少有一个同步复制体还活着,记录就不会丢失。这是最强的可用保证。这相当于 acks=-1 设置。

类型 : string

默认值:1

有效值:[all, -1, 0, 1]

重要性:高

bootstrap.servers

用于建立Kafka集群初始连接的主机/端口对的列表。客户端将使用所有的服务器,不管这里指定了哪些服务器用于引导--这个列表只影响用于发现全部服务器集的初始主机。这个列表的形式应该是 host1:port1,host2:port2,....。因为这些服务器只是用于初始连接,以发现完整的集群成员(可能会动态变化),所以这个列表不需要包含完整的服务器集(不过,你可能需要多个服务器,以防某个服务器宕机)。类型:list

默认:""

有效值:non-null string

重要性:高

buffer.memory

生产者可以用来缓冲等待发送到服务器的记录的总内存字节数。如果记录的发送速度超过了服务器的发送速度,那么生产者就会缓冲max.block.ms,之后就会抛出一个异常。这个设置应该与生产者将使用的总内存大致对应,但并不是一个硬约束,因为生产者使用的内存并不都是用来缓冲的。一些额外的内存将被用于压缩(如果启用了压缩)以及维护飞行中的请求。

类型:long

默认:33554432

有效值:[0,...]

重要性:高

compression.type

生产者生成的所有数据的压缩类型。默认值是none(即无压缩)。有效值为none、gzip、snappy、lz4或zstd。压缩的是整批的数据,所以批处理的功效也会影响压缩比(批处理越多意味着压缩效果越好)。类型:string

默认:none

有效值:

重要性:高

retries

设置一个大于零的值,将导致客户端重新发送任何发送失败的记录,并可能出现短暂的错误。请注意,这种重试与客户端在收到错误后重新发送记录没有区别。允许重试而不将max.in.flight.request.per.connection设置为1,将有可能改变记录的顺序,因为如果向一个分区发送两批记录,第一批失败并重试,但第二批成功,那么第二批的记录可能会先出现。另外需要注意的是,如果delivery.timeout.ms配置的超时时间在成功确认前先过期,那么在重试次数用完之前,produce请求就会失败。一般来说,用户最好不要设置这个配置,而是使用delivery.timeout.ms来控制重试行为。类型:int

默认:2147483647

有效值: [0,...,2147483647]

重要性:高

ssl.key.password

密钥存储文件中私钥的密码,或在`ssl.keystore.key'中指定的PEM密钥。只有在配置了双向身份验证的情况下,客户端才需要这个密码。类型:password

默认值: null

有效值:

重要性:高

ssl.keystore.certificate.chain

证书链的格式由'ssl.keystore.type'指定。默认的SSL引擎工厂只支持PEM格式的X.509证书列表。类型:password

默认值: null

有效值:

重要性:高

ssl.keystore.key

私钥的格式由'ssl.keystore.type'指定。默认SSL引擎工厂只支持PEM格式的PKCS#8密钥。如果密钥是加密的,必须使用'ssl.key.password'指定密钥密码。类型:password

默认值: null

有效值。

重要性:高

ssl.keystore.location

密钥存储文件的位置。对客户端来说是可选的,可以用于客户端的双向认证。类型:string

默认值: null

有效值:

重要性:高

ssl.keystore.password

密钥存储文件的存储密码。这对客户端来说是可选的,只有在配置了'ssl.keystore.location'时才需要。对于PEM格式,不支持密钥存储密码。类型:password

默认值: null

有效值。

重要性:高

ssl.truststore.certificates

可信证书的格式由'ssl.truststore.type'指定。默认SSL引擎工厂只支持PEM格式的X.509证书。类型:password

默认值: null

有效值。

重要性:高

ssl.truststore.location

信任存储文件的位置。类型:string

默认值: null

有效值。

重要性:高

ssl.truststore.password

信任存储文件的密码。如果没有设置密码,则仍然使用配置的信任存储文件,但完整性检查被禁用。PEM格式不支持信任存储密码。类型:password

默认值: null

有效值。

重要性:高

batch.size

每当多个记录被发送到同一个分区时,生产者会尝试将记录一起批处理成较少的请求。这有助于提高客户端和服务器的性能。这个配置控制默认的批处理大小,单位是字节。不会尝试将大于此大小的记录批量化。

发送给broker的请求将包含多个批次,每个具有可发送数据的分区都有一个批次。

批量小会使批处理不常见,并可能会降低吞吐量(批量为零会完全禁止批处理)。一个非常大的批次大小可能会更浪费地使用内存,因为我们总是会分配一个指定的批次大小的缓冲区,以应对额外的记录。

类型:int

默认值:16384

有效值:[0,...]

重要性:中等

client.dns.lookup

控制客户端如何使用DNS查找。如果设置为use_all_dns_ips,则依次连接到每个返回的IP地址,直到成功建立连接。断开连接后,会使用下一个IP。一旦所有的IP都被使用过一次,客户端就会再次解析主机名中的IP(然而,JVM和操作系统都会缓存DNS名称查询)。如果设置为resolve_canonical_bootstrap_servers_only,则将每个引导地址解析成一个canonical名称列表。在引导阶段之后,这和use_all_dns_ips的行为是一样的。如果设置为默认(已废弃),即使查找返回多个IP地址,也会尝试连接到查找返回的第一个IP地址。类型:string

默认值: use_all_dns_ips

有效值。 [default, use_all_dns_ips, resolve_canonical_bootstrap_servers_only] 。

重要性:中等

client.id

一个ID字符串,在发出请求时传递给服务器。这样做的目的是为了在服务器端请求日志中包含一个逻辑应用程序名称,从而能够跟踪请求的来源,而不仅仅是ip/端口。类型:string

默认:""

有效值。

重要性:中等

connections.max.idle.ms

在该配置指定的毫秒数之后关闭空闲连接。类型:long

默认:540000(9分钟)

有效值:

重要性:中等

delivery.timeout.ms

调用send()返回后报告成功或失败的时间的上限。这限制了记录在发送前被延迟的总时间,等待broker确认的时间(如果预期),以及允许的可重复发送失败的时间。如果遇到不可恢复的错误,重试次数已经用尽,或者记录被添加到一个达到较早发送到期期限的批次中,生产者可能会报告未能在这个配置之前发送记录。这个配置的值应该大于或等于 request.timeout.ms 和 linger.ms 之和。类型:int

默认:120000(2分钟)

有效值:[0,...]

重要性:中等

linger.ms

制作者将请求传输之间到达的所有记录归为一个单一的批量请求。通常只有在负载下,当记录到达的速度超过了它们的发送速度时,才会出现这种情况。然而在某些情况下,即使在中等负载下,客户端也可能希望减少请求的数量。这个设置通过添加少量的人为延迟来实现--也就是说,生产者不会立即发送一条记录,而是会等待到给定的延迟,以允许其他记录被发送,这样就可以将这些记录一起打包发送。这可以被认为是类似于TCP中的Nagle算法。这个设置给出了批处理延迟的上限:一旦我们得到一个分区的 batch.size 值的记录,不管这个设置如何,它都会立即被发送,但是如果我们为这个分区积累的字节数少于这个数,我们就会在指定的时间内 "滞留",等待更多记录的出现。这个设置默认为0(即没有延迟)。例如,设置linger.ms=5,会减少发送请求的数量,但在没有负载的情况下,发送的记录会增加5ms的延迟。类型:long

默认值:0

有效值:[0,...]

重要性:中等

max.block.ms

该配置控制KafkaProducer的send()、partitionsFor()、initTransactions()、sendOffsetsToTransaction()、commitTransaction()和abortTransaction()方法阻塞的时间。对于send()来说,这个超时限制了等待元数据获取和缓冲区分配的总时间(用户提供的序列器或分区器中的阻塞不计入这个超时)。对于partitionsFor()来说,如果元数据不可用,这个超时就会限制等待元数据的时间。与事务相关的方法总是阻塞,但如果事务协调器不能被发现或没有在超时内响应,则可能超时。类型:long

默认:60000(1分钟)

有效值:[0,...]

重要性:中等

max.request.size

请求的最大大小,单位是字节。这个设置将限制制作者在一次请求中发送的记录批次数量,以避免发送巨大的请求。这实际上也是对未压缩的最大记录批次大小的一个上限。请注意,服务器有自己的记录批量大小的上限(如果启用了压缩,则在压缩后),可能与此不同。类型:int

默认值:1048576

有效值:[0,...]

重要性:中等

partitioner.class

Partitioner类,实现了org.apache.kafka.client.producer.Partitioner接口。类型:class

默认值:org.apache.kafka.client.producer.internals.DefaultPartitioner。

有效值:

重要性:中等

receive.buffer.bytes

读取数据时要使用的TCP接收缓冲区(SO_RCVBUF)的大小。如果该值为-1,则使用OS默认值。类型:int

默认值:32768(32 kibibytes)

有效值:[-1,...]

重要性:中等

request.timeout.ms

该配置控制客户端等待请求响应的最长时间。如果在超时之前没有收到响应,客户端将在必要时重新发送请求,或者在重试次数用尽时失败请求。这个值应该大于 replica.lag.time.max.ms(一种broker配置),以减少由于不必要的生产者重试而导致消息重复的可能性。类型:int

默认:30000(30秒)

有效值:[0,...]

重要性:中等

sasl.client.callback.handler.class

实现AuthenticateCallbackHandler接口的SASL客户端回调处理程序类的全称。类型:class

默认值: null

有效值:

重要性:中等

sasl.jaas.config

JAAS登录上下文参数,用于SASL连接,格式为JAAS配置文件使用的格式。JAAS配置文件的格式在这里有介绍。值的格式为:'loginModuleClass controlFlag (optionName=optionValue)*;'。对于broker来说,配置必须以监听器前缀和SASL机制名称为前缀,并以小写字母表示。例如,listener.name.sasl_ssl.scram-sha-256.sasl.jaas.config=com.exam.ScramLoginModule必填。类型:password

默认值: null

有效值。

重要性:中等

sasl.kerberos.service.name

Kafka 运行的 Kerberos 主体名称。这可以在Kafka的JAAS配置或Kafka的配置中定义。类型:string

默认值: null

有效值。

重要性:中等

sasl.login.callback.handler.class

实现AuthenticateCallbackHandler接口的SASL登录回调处理程序类的完全限定名称。对于broker来说,登录回调处理程序配置必须以监听器前缀和小写的SASL机制名称为前缀。例如,listener.name.sasl_ssl.scram-sha-256.sasl.login.callback.handler.class=com.example.CustomScramLoginCallbackHandler。类型:class

默认值: null

有效值。

重要性:中等

sasl.login.class

实现Login接口的类的全称。对于broker来说,login config必须以监听器前缀和SASL机制名称为前缀,并使用小写。例如,listener.name.sasl_ssl.scram-sha-256.sasl.login.class=com.example.CustomScramLogin。类型:class

默认值: null

有效值。

重要性:中等

sasl.mechanism

用于客户端连接的SASL机制。这可以是任何有安全提供者的机制。GSSAPI是默认机制。类型:string

默认值。 GSSAPI

有效值。

重要性:中等

security.protocol

用于与broker通信的协议。有效值是: PLAINTEXT, SSL, SASL_PLAINTEXT, SASL_SSL.类型:string

默认值。 PLAINTEXT

有效值。

重要性:中等

send.buffer.bytes

发送数据时要使用的TCP发送缓冲区(SO_SNDBUF)的大小。如果该值为-1,则使用OS默认值。类型:int

默认值:131072 (128 kibibytes)

有效值:[-1,...]

重要性:中等

socket.connection.setup.timeout.max.ms

客户端等待建立套接字连接的最大时间。连接设置超时时间将随着每一次连续的连接失败而成倍增加,直到这个最大值。为了避免连接风暴,超时时间将被应用于0.2的随机系数,结果是低于计算值20%到高于计算值20%的随机范围。类型:long

默认:127000(127秒)

有效值:

重要性:中等

socket.connection.setup.timeout.ms

客户端等待socket连接建立的时间。如果在超时之前没有建立连接,客户端将关闭socket通道。类型:long

默认:10000(10秒)

有效值。

重要性:中等

ssl.enabled.protocols

为SSL连接启用的协议列表。默认值是 "TLSv1.2,TLSv1.3",当运行Java 11或更新版本时,否则为 "TLSv1.2"。在Java 11的默认值下,如果客户端和服务器都支持TLSv1.3,则会优先选择TLSv1.3,否则会回退到TLSv1.2(假设两者都至少支持TLSv1.2)。这个默认值在大多数情况下应该是没有问题的。也可以参考`ssl.protocol`的配置文档。类型:list

默认值: TLSv1.2

有效值。

重要性:中等

ssl.keystore.type

密钥存储文件的文件格式。对客户端来说是可选的。类型:string

默认值。 JKS

有效值。

重要性:中等

ssl.protocol

用来生成SSLContext的SSL协议,默认为'TLSv1.3',否则为'TLSv1.2'。当运行Java 11或更新版本时,默认为'TLSv1.3',否则为'TLSv1.2'。这个值对于大多数的使用情况来说应该是没有问题的。在最近的JVM中允许的值是'TLSv1.2'和'TLSv1.3'。TLS','TLSv1.1','SSL','SSLv2'和'SSLv3'在旧的JVM中可能会被支持,但由于已知的安全漏洞,我们不鼓励使用它们。在这个配置和'ssl.enabled.protocols'的默认值下,如果服务器不支持'TLSv1.3',客户端将降级为'TLSv1.2'。如果这个配置被设置为'TLSv1.2',即使是ssl.enabled.protocols中的一个值,并且服务器只支持'TLSv1.3',客户端也不会使用'TLSv1.3'。类型:string

默认值: TLSv1.2

有效值。

重要性:中等

ssl.provider

用于SSL连接的安全提供者的名称。默认值是JVM的默认安全提供者。类型:string

默认值: null

有效值。

重要性:中等

ssl.truststore.type

信任存储文件的文件格式。类型:string

默认值。 JKS

有效值。

重要性:中等

enable.idempotence

当设置为'true'时,生产者将确保每条消息的副本正好写在流中。如果为'false',生产者因broker故障等原因重试,可能会将重试的消息重复写入流中。注意,启用idempotence需要max.in.flight.request.per.connection小于或等于5,重试大于0,acks必须是'all'。如果用户没有明确设置这些值,将选择合适的值。如果设置了不兼容的值,将抛出一个ConfigException。类型:boolean

默认:假

有效值。

重要性:低

interceptor.classes

作为拦截器使用的类的列表。实现org.apache.kafka.clients.producer.ProducerInterceptor接口,可以让你在记录发布到Kafka集群之前,拦截(并可能突变)生产者收到的记录。默认情况下,没有拦截器。类型:list

默认:""

有效值:非空字符串

重要性:低

max.in.flight.requests.per.connection

客户端在阻断之前在单个连接上发送的未确认请求的最大数量。请注意,如果此设置大于1,并且发送失败,则有可能因重试而重新排序消息(即,如果启用了重试)。类型:int

默认值:5

有效值:[1,...]

重要性:低

metadata.max.age.ms

即使我们没有看到任何分区领导权变化,我们也会强制刷新元数据,以主动发现任何新的broker或分区的时间,以毫秒为单位。类型:长

默认:300000(5分钟)

有效值:[0,...]

重要性:低

metadata.max.idle.ms

控制生产者为空闲的主题缓存元数据的时间。如果一个主题最后一次被生产出来后的时间超过了元数据的空闲时间,那么这个主题的元数据就会被遗忘,下一次访问它时将强制执行元数据获取请求。类型:长

默认:300000(5分钟)

有效值:[5000,...]

重要性:低

metric.reporters

作为度量报告器使用的类的列表。实现org.apache.kafka.common.metrics.MetricsReporter接口允许插入将被通知新的度量创建的类。JmxReporter总是被包含在注册JMX统计数据中。类型:list

默认:""

有效值:非空字符串

重要性:低

metrics.num.samples

为计算指标而维护的样本数量。类型:int

默认值:2

有效值:[1,...]

重要性:低

metrics.recording.level

指标的最高记录级别。类型:string

默认:INFO

有效值:[INFO, DEBUG, TRACE]

重要性:低

metrics.sample.window.ms

度量样本计算的时间窗口。类型:长

默认:30000(30秒)

有效值:[0,...]

重要性:低

reconnect.backoff.max.ms

当重新连接到一个反复连接失败的broker时,等待的最大时间,以毫秒为单位。如果提供,每台主机的backoff将在每一次连续连接失败时以指数形式增加,直到这个最大值。在计算背离增加后,20%的随机抖动被添加到避免连接风暴中。类型:长

默认:1000(1秒)

有效值:[0,...]

重要性:低

reconnect.backoff.ms

试图重新连接到给定主机前的基本等待时间。这可以避免在一个紧密的循环中重复连接到主机。这个backoff适用于客户端到broker的所有连接尝试。类型:long

默认值:50

有效值:[0,...]

重要性:低

retry.backoff.ms

试图重试给定主题分区的失败请求前的等待时间。这可以避免在某些失败情况下,在一个紧密的循环中重复发送请求。类型:long

默认值:100

有效值:[0,...]

重要性:低

sasl.kerberos.kinit.cmd

Kerberos kinit 命令路径。类型:string

默认值:/usr/bin/kinit

有效值: