GPT-4 Technical Report

Abstract

我们报告了GPT-4的开发,GPT-4是一种大规模的多模态模型,可以接受图像和文本输入并生成文本输出。尽管GPT-4在许多现实世界场景中的能力不如人类,但它在各种专业和学术基准上表现出人类水平的性能,包括通过了一次模拟的律师资格考试,分数在前10%左右。GPT-4是一个基于Transformer的模型,经过预训练,可以预测文档中的下一个令牌。训练后的调整过程可提高真实性和遵守期望行为的性能。该项目的一个核心组成部分是开发基础设施和优化方法,这些方法可以在广泛的范围内进行预测。这使我们能够根据GPT-4计算量不超过1/1000的模型准确预测GPT-4性能的某些方面。

1 Introduction

本技术报告介绍了GPT-4,这是一种能够处理图像和文本输入并生成文本输出的大型多模态模型。这类模型是一个重要的研究领域,因为它们具有广泛应用的潜力,如对话系统、文本摘要和机器翻译。因此,近年来,它们一直是人们感兴趣和取得进展的主题[1-28]。

开发此类模型的主要目标之一是提高其理解和生成自然语言文本的能力,尤其是在更复杂和微妙的场景中。为了测试GPT-4在这种情况下的能力,GPT-4通过最初为人类设计的各种测试进行了评估。在这些评估中,它表现得相当好,往往超过绝大多数人类测试者。例如,在模拟的律师资格考试中,GPT-4的分数在前10%的考生中排名靠前。这与GPT-3.5形成了对比,GPT-3.5的得分垫底10%。

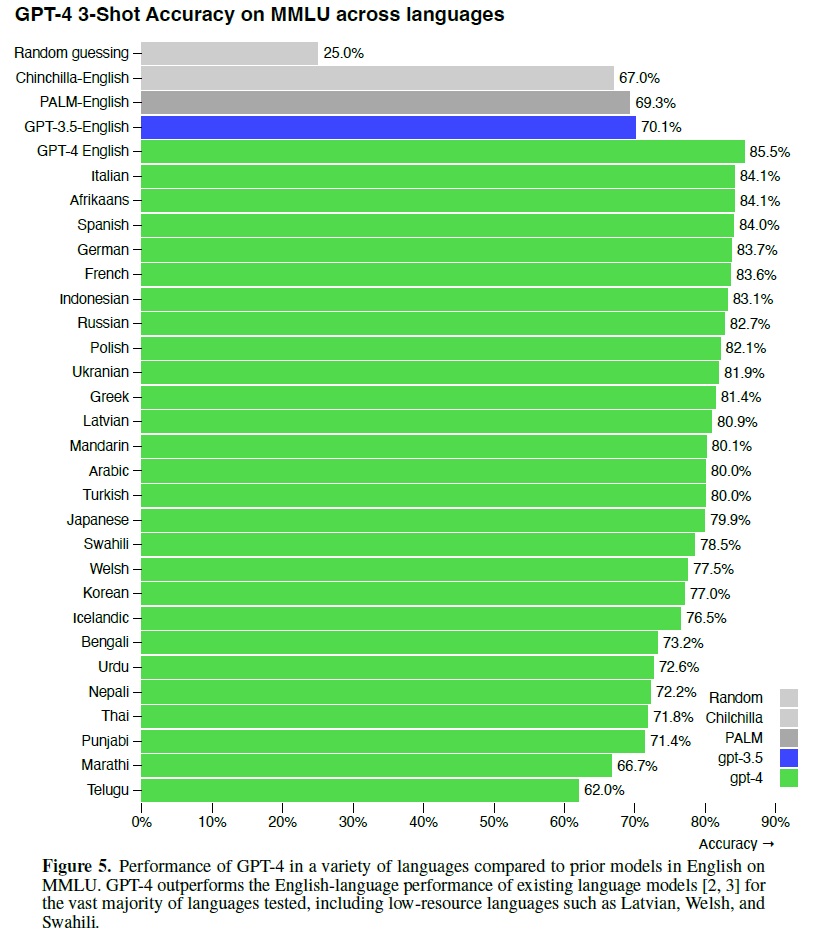

在一套传统的NLP基准测试中,GPT-4优于以前的大型语言模型和最先进的系统(通常具有特定于基准的训练或手工工程)。在MMLU基准[29,30](一套涵盖57个科目的英语选择题)上,GPT-4不仅在英语方面大大优于现有模型,而且在其他语言方面也表现出色。在MMLU的翻译变体上,GPT-4在所考虑的26种语言中的24种语言中超过了英语的最先进水平。我们将在后面的章节中更详细地讨论这些模型能力结果以及模型安全改进和结果。

本报告还讨论了该项目的一个关键挑战,即开发深度学习基础设施和优化方法,这些方法在广泛的范围内表现出可预测性。这使我们能够预测GPT-4的预期性能(基于以类似方式训练的小运行),并与最终运行进行比较,以提高我们训练的信心。

尽管GPT-4具有功能,但其局限性与早期GPT模型类似[1,31,32]:它不完全可靠(例如,可能会出现“幻觉”),上下文窗口有限,并且无法从经验中学习。使用GPT-4的输出时应小心,尤其是在可靠性很重要的情况下。

GPT-4的能力和局限性带来了重大而新颖的安全挑战,鉴于潜在的社会影响,我们认为仔细研究这些挑战是一个重要的研究领域。本报告包括一张广泛的系统卡片(在附录之后),描述了我们预计的偏见、虚假信息、过度依赖、隐私、网络安全、扩散等方面的一些风险。它还描述了我们为减轻GPT-4部署带来的潜在危害而采取的干预措施,包括与领域专家的对抗性测试,以及模型辅助安全流水线。

2 Scope and Limitations of this Technical Report

本报告重点介绍GPT-4的功能、局限性和安全属性。GPT-4是一个Transformer风格的模型[33],经过预训练,可以使用公开可用的数据(如互联网数据)和第三方提供商许可的数据来预测文档中的下一个令牌。然后使用来自人类反馈的强化学习(RLHF)对模型进行微调[34]。考虑到竞争格局和GPT-4等大型模型的安全影响,本报告未包含有关架构(包括模型大小)、硬件、训练计算、数据集构建、训练方法或类似内容的更多细节。

我们致力于对我们的技术进行独立审计,并在本次发布的系统卡片中分享了这方面的一些初步步骤和想法。2 我们计划向其他第三方提供更多的技术细节,这些第三方可以就如何权衡上述竞争和安全考虑因素与进一步透明度的科学价值提供建议。

3 Predictable Scaling

GPT-4项目的一大重点是构建一个可预测扩展的深度学习堆栈。主要原因是,对于GPT-4这样的大型训练运行,进行广泛的特定于模型的调整是不可行的。为了解决这个问题,我们开发了基础设施和优化方法,这些方法在多个尺度上具有非常可预测的行为。这些改进使我们能够从使用更少计算量(节约1000-10000倍)训练的较小模型中可靠地预测GPT-4性能的某些方面。

3.1 Loss Prediction

3.2 Scaling of Capabilities on HumanEval

4 Capabilities

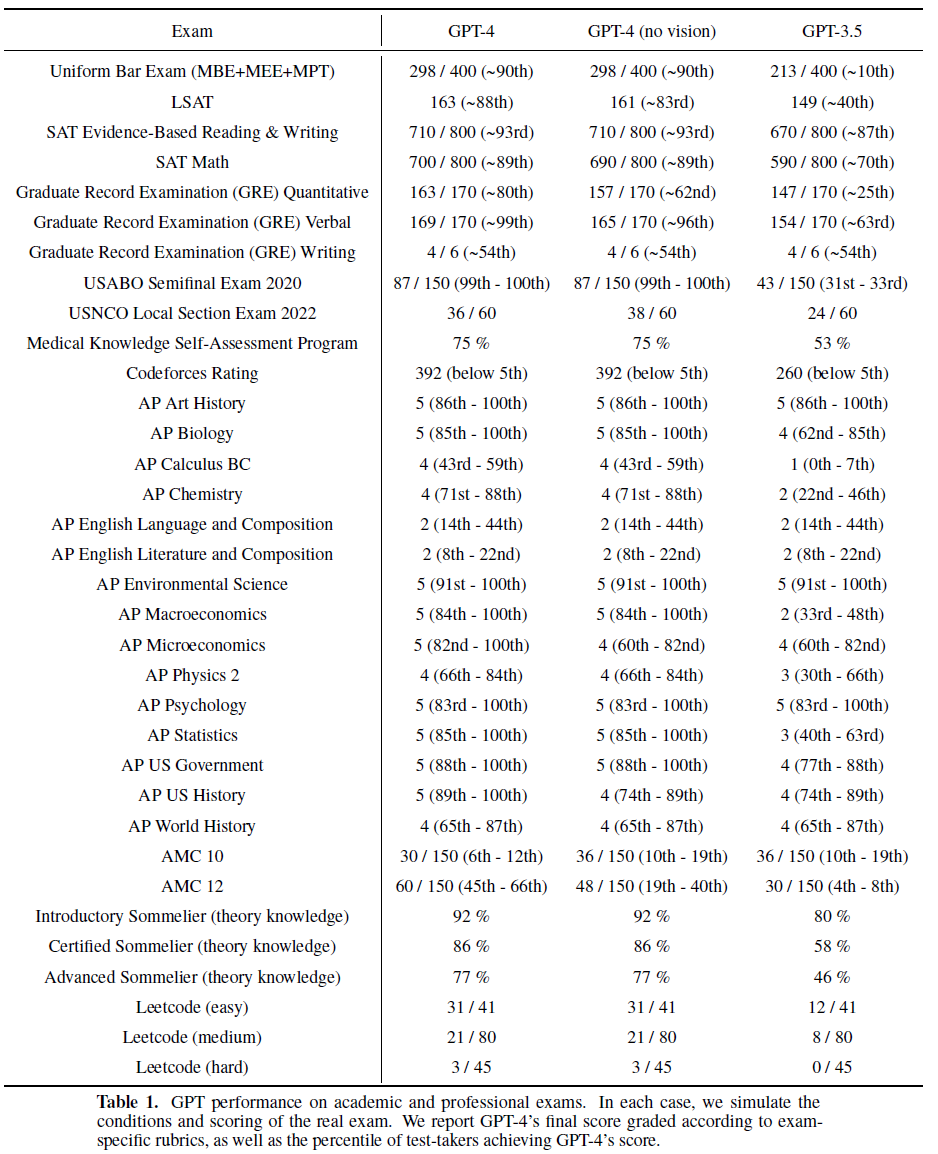

我们在一组不同的基准测试中测试了GPT-4,包括最初为人类设计的模拟测试。考试中的少数问题是模型在训练中发现的;对于每一次考试,我们都会运行一个变体(去掉这些问题),并报告两者中较低的分数。我们认为结果具有代表性。有关污染的更多详细信息(方法和每次检查统计),请参见附录C。

检查来源于公开资料。考试问题包括选择题和自由回答题;我们为每种格式设计了单独的提示,并将图像包含在需要的问题的输入中。评估设置是基于一组验证考试的表现而设计的,并且我们报告了延期考试的最终结果。通过使用公开可用的方法,结合多项选择题和自由回答题的分数,确定每次考试的总分数。有关考试评估方法的更多详细信息,请参见附录A。

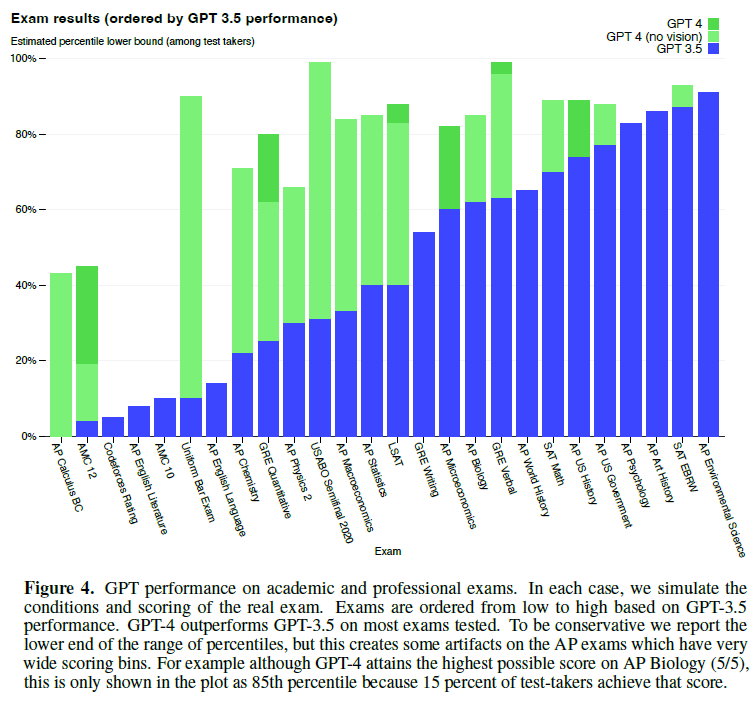

GPT-4在大多数专业和学术考试中表现出人类水平的性能。值得注意的是,它通过了模拟版的统一律师考试,成绩在前10%的考生中(表1,图4)。

该模型的考试能力似乎主要源于预训练过程,不受RLHF的显著影响。在多项选择题上,在我们测试的考试中,基本GPT-4模型和RLHF模型的平均表现都一样好(见附录B)。

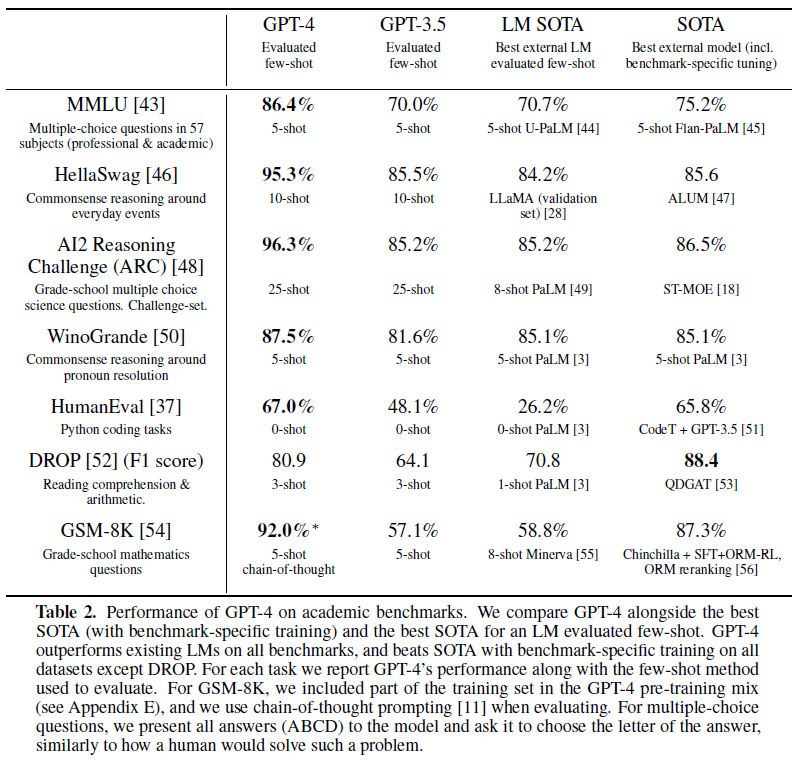

我们还在为评估语言模型而设计的传统基准上评估了预先训练的基础GPT-4模型。对于我们报告的每个基准,我们对训练集中出现的测试数据进行了污染检查(有关每个基准污染的全部详细信息,请参阅附录D)。4 在评估GPT-4时,我们对所有基准使用了少量提示[1]。5

GPT-4大大优于现有的语言模型,以及以前最先进的(SOTA)系统,这些系统通常具有特定于基准的手工制作或额外的训练协议(表2)。

许多现有的ML基准测试都是用英语编写的。为了初步了解GPT-4在其他语言中的功能,我们使用Azure Translate将MMLU基准[29,30](一套涉及57个主题的多项选择问题)翻译成各种语言(请参阅附录F中的翻译和提示示例)。我们发现,在我们测试的大多数语言中,包括拉脱维亚语、威尔士语和斯瓦希里语等低资源语言,GPT-4的英语性能优于GPT 3.5和现有语言模型(Chinchilla[2]和PaLM[3])(图5)。

GPT-4在遵循用户意图的能力方面比以前的模型显著提高[57]。在提交给ChatGPT [58]和OpenAI API [41]的5214个提示的数据集上,在70.2%的提示上,GPT-4生成的响应优于GPT-3.5生成的响应。6

我们正在开源OpenAI Evals7,这是我们的框架,用于创建和运行基准测试,以评估GPT-4等模型,同时逐样本检查性能。Evals与现有的基准测试兼容,可用于跟踪部署中模型的性能。我们计划随着时间的推移增加这些基准的多样性,以代表更广泛的故障模式和更艰巨的任务。

4 在我们的污染检查中,我们发现BIG-bench [42]的部分无意中混入了训练集中,我们将其从报告的结果中排除。

5 对于GSM-8K,我们将部分训练集包含在GPT-4的预训练组合中(详见附录E)。我们在评估时使用思维链提示[11]。

6 我们收集了通过ChatGPT和OpenAI API发送给我们的用户提示,从每个模型中抽取一个响应,并将这些提示和响应发送给人类标签机。标签员被指示判断在给出提示的情况下,用户是否希望得到响应。标记者没有被告知哪种反应是由哪种模型产生的,反应的呈现顺序是随机的。我们过滤掉包含任何被禁止或敏感内容的提示,包括个人身份信息(PII)、性内容、仇恨言论和类似内容。我们还过滤简短的(例如“你好,ChatGPT!”)和过于常见的提示。

7 https://github.com/openai/evals

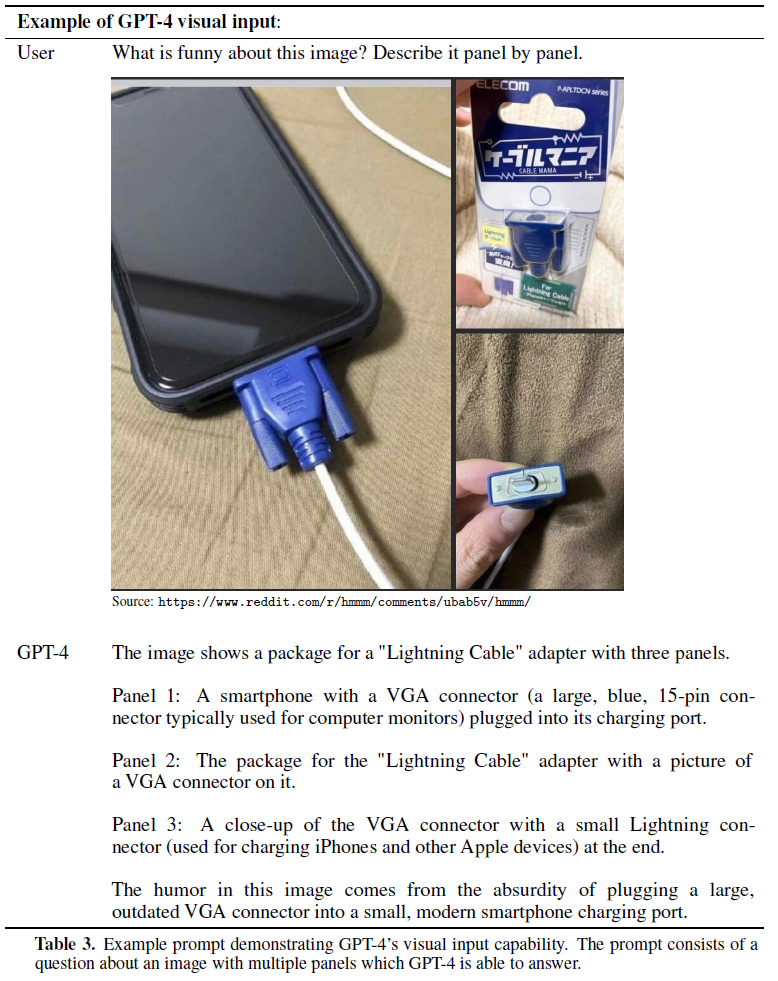

4.1 Visual Inputs

GPT-4接受由图像和文本组成的提示,这些提示与纯文本设置并行,允许用户指定任何视觉或语言任务。具体而言,对于任意交错的文本和图像组成的给定输入,该模型生成文本输出。在一系列领域,包括带有文本和照片的文档、图表或屏幕截图,GPT-4表现出与纯文本输入类似的功能。GPT-4的视觉输入示例见表3。为语言模型开发的标准测试时间技术(例如,少数镜头提示、思维链等)在同时使用图像和文本时同样有效-示例见附录G。

GPT-4博客文章[59]中可以找到一组学术愿景基准的初步结果。我们计划在后续工作中发布更多有关GPT-4视觉功能的信息。

5 Limitations

尽管GPT-4具有功能,但其局限性与早期GPT模型相似。最重要的是,它仍然不完全可靠(它“幻觉”了事实并犯了推理错误)。在使用语言模型输出时,尤其是在高风险环境中,应非常小心,使用与特定应用程序需求相匹配的精确协议(如人工审查、附加上下文基础或完全避免高风险使用)。有关详细信息,请参阅我们的系统卡片。

与以前的GPT-3.5模型相比,GPT-4显著减少了幻觉(这些模型本身随着不断迭代而不断改进)。GPT-4的得分比我们最新的GPT-3.5高出19个百分点(图6)。

GPT-4在TruthfulQA等公共基准上取得了进展[60],该基准测试了模型将事实与一组错误陈述(图7)分开的能力。这些问题与统计上有吸引力的事实上不正确的答案配对。GPT-4基础模型在这一任务上仅略优于GPT-3.5;然而,在RLHF后训练后,我们观察到与GPT-3.5相比的大幅改善8。表4显示了正确和错误的答案。GPT-4拒绝选择常见的俗语(你不能教老狗新把戏),但它仍然可以忽略细节(埃尔维斯·普雷斯利不是演员的儿子,所以帕金斯是正确的答案)。

GPT-4通常对绝大多数预训练数据中断后发生的事件(2021年9月9)缺乏了解,也没有从其经验中学习。它有时会犯一些简单的推理错误,这些错误似乎与跨这么多领域的能力不符,或者在接受用户的明显虚假陈述时过于容易受骗。它可能会像人类一样在遇到棘手问题时失败,例如在其生成的代码中引入安全漏洞。

GPT-4的预测也有可能是错误的,在可能出错时不必仔细检查工作。有趣的是,预训练的模型是高度校准的(其对答案的预测置信度通常与正确的概率相匹配)。然而,在后训练过程之后,校准减少(图8)。

GPT-4在其输出中存在各种偏差,我们已努力纠正这些偏差,但这需要一些时间来充分描述和管理。我们的目标是使GPT-4和我们构建的其他系统具有合理的默认行为,这些行为反映了广泛的用户价值观,允许这些系统在一定范围内进行定制,并获得关于这些范围的公共输入。更多详情请参见OpenAI [62]。

8 我们没有使用TruthfulQA检查RLHF后训练数据的污染情况

9 预训练和后训练数据包含少量最新数据

6 Risks & mitigations

我们投入了大量精力来改善GPT-4的安全性和一致性。在这里,我们强调了我们使用领域专家进行对抗性测试和红队测试(red-teaming),以及我们的模型辅助安全流水线[63],以及与先前模型相比安全度量的改进。

Adversarial Testing via Domain Experts:

Model-Assisted Safety Pipeline:

Improvements on Safety Metrics:

7 Conclusion

我们描述了GPT-4,这是一个大型多模态模型,在某些困难的专业和学术基准上具有人类水平的性能。GPT-4在一系列NLP任务上优于现有的大型语言模型,并超过了绝大多数报告的最先进系统(通常包括任务特定的微调)。我们发现,虽然通常用英语来衡量能力的提高,但可以用许多不同的语言来证明。我们强调了可预测的扩展如何使我们能够准确预测GPT-4的损失和功能。

GPT-4由于能力的提高而带来了新的风险,我们讨论了理解和改进其安全性和一致性所采取的一些方法和结果。尽管还有很多工作要做,GPT-4代表着朝着广泛有用和安全部署的人工智能系统迈出了重要一步。

Appendix

A Exam Benchmark Methodology

A.1 Sourcing

A.2 Prompting: multiple-choice

A.3 Prompting: free-response

A.4 Images

A.5 Scoring

A.6 Model snapshot details

A.7 Example few-shot prompts

B Impact of RLHF on capability

C Contamination on professional and academic exams

D Contamination on academic benchmarks

E GSM-8K in GPT-4 training

F Multilingual MMLU

G Examples of GPT-4 Visual Input

H System Card

浙公网安备 33010602011771号

浙公网安备 33010602011771号