A Spiking Neural Model for Stable Reinforcement of Synapses Based on Multiple Distal Rewards

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布!

Neural Computation, no. 1 (2013): 123-156

Abstract

在这篇文章中,开发了一种新颖的类似critic的算法来扩展Florian (2007)和Izhikevich (2007)中描述的突触可塑性规则,以解决同时学习多个远端奖励的问题。该系统增加了短期可塑性(STP)以稳定学习动态,从而提高系统的学习能力。估计该系统可以学习的远端奖励数量的理论阈值。通过计算机模拟验证了新算法的有效性。

1 Introduction

强化学习是一种试错学习的方法,其中智能体的行为由一类称为奖励的信号引导。强化学习模型内置于智能体和系统中,可以从它们与环境的交互中学习。强化模型优于监督学习模型(Rumelhart & McClelland, 1987),因为它们不需要监督者向智能体提供实时反馈。强化学习期间的奖励来自环境,为智能体提供价值感,以指导智能体与环境交互期间的学习。通常,奖励出现在与其对应的提示和动作之后,被称为远端奖励问题(Hull, 1943; Izhikevich, 2007);在强化学习界中,它被称为信度分配问题(Sutton & Barto, 1998)。设计此类系统的最终目标是生产自主且自编程的系统,以灵活可靠的方式实现其目标。

大多数对强化学习建模的计算方法都集中在TD算法上(Sutton & Barto, 1998; Hazy, Frank, & O'Reilly, 2010),该算法使用时间折扣的显式说明来计算期望奖励(Sutton & Barto, 1998)。在这篇文章中,重点是开发一种生物学合理的方法来使用脉冲神经模型对远端奖励问题进行建模。这是因为大脑中神经元之间的主要通信模式是以脉冲、动作电位或脉冲的形式编码的。这种交流模式使由数十亿个神经细胞组成的大脑能够消耗不到20 Wof的能量(Lennie, 2003; Attwell & Laughlin, 2001)。

神经元是通过突触相互连接的复杂结构。这些突触可以使用经过实验验证的学习规则,脉冲时间依赖性可塑性(STDP),根据突触前神经元和突触后神经元之间脉冲的相对时间来修改它们的增益(Markram, Lübke, Frotscher, & Sakmann, 1997; Bi & Poo, 1998; Magee & Johnston, 1997; Levy and Steward, 1983; Debanne, Gähwiler, & Thompson, 1998; Dan & Poo, 2004)。

哺乳动物大脑中的奖励信号与多巴胺系统有关(Schultz & Romo, 1990; Ljungberg, Apicella, & Schultz, 1991)。Izhikevich (2007)和Florian (2007)开发了一种将STDP和多巴胺信号联系起来的模型,称为奖励调节STDP (R-STDP)。在R-STDP中,突触由STDP进化并由多巴胺等全局奖励信号调节。尽管R-STDP取得了成功,但Frémaux, Sprekeler和Gerstner (2010)证明R-STDP无法同时学习多个强化任务。在这篇文章中,R-STDP被扩展以解决同时学习多个远端奖励的问题。

2 Distal Reward Problem

在巴甫洛夫条件反射实验中,智能体学会将某些线索与奖励或惩罚联系起来。这是强化学习,因为学习来自于根据提示进行的奖励(或惩罚)。在脉冲神经网络的上下文中,与奖励或惩罚相关的脉冲序列在此称为r-模式。此外,奖励项将用于表示奖励或惩罚,因为两者都可以用于强化学习。继续使用这个项,在巴甫洛夫学习中,奖励比r-模式滞后几秒,但奖励仍然产生有效的学习(Pavlov, 1927; Hull, 1943; Houk, Davis, & Beiser, 1995; Schultz, 1998; Dayan & Abbott, 2001)。r-模式和奖励之间的延迟正是强化学习成为如此强大工具的原因:它允许对智能体-环境交互进行事后评估,然后智能体可以将其纳入行为修改中。然而,这种延迟也带来了棘手的问题。由于奖励滞后于r-模式,当奖励可用于帮助学习时,r-模式不再存在,这在脉冲神经网络中采用突触强度修改的形式。

第二个观察结果是,在r-模式和系统获取奖励之间的延迟期间,网络的其余部分继续飙升。因此,如果奖励真的是为了增强r-模式,使其更有可能在未来出现,那么奖励如何挑选出引起奖励的特定脉冲模式?例如,考虑让狗坐下的情况。假设然后狗执行两个几乎同时的动作,例如摇头和坐下。然后给狗一个坐下的款待。然而,狗怎么"知道"坐下的动作是有奖励的,而不是摇头的动作?当然,关键在于重复,但这在宏观或行为层面上。在细胞水平上看到相应的相关性很有趣。这种在网络中的其他脉冲模式上强化特定r-模式的问题称为远端奖励问题(Hull, 1943)或信度分配问题(Minsky, 1961; Barto, Sutton, & Anderson, 1983; Houk et al., 1995; Sutton & Barto, 1998; Dayan & Abbott, 2001; Wörgötter & Porr, 2005)。

如第1节所述,Florian (2007)和Izhikevich (2007)在脉冲神经网络的背景下,使用奖励调节STDP (R-STDP)解决了单个r-模式的远端奖励问题。在这篇文章中,对R-STDP进行了扩展,使脉冲神经网络能够学习多个r-模式。

3 Methods

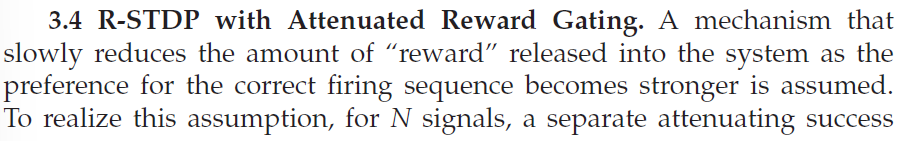

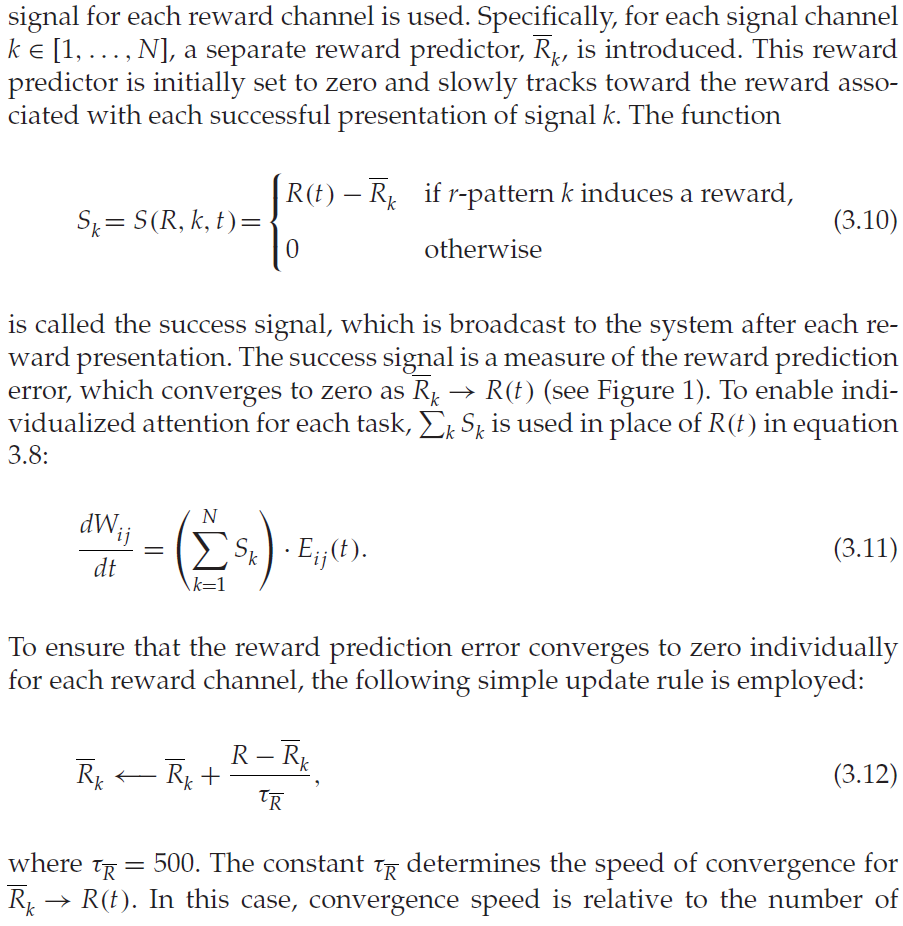

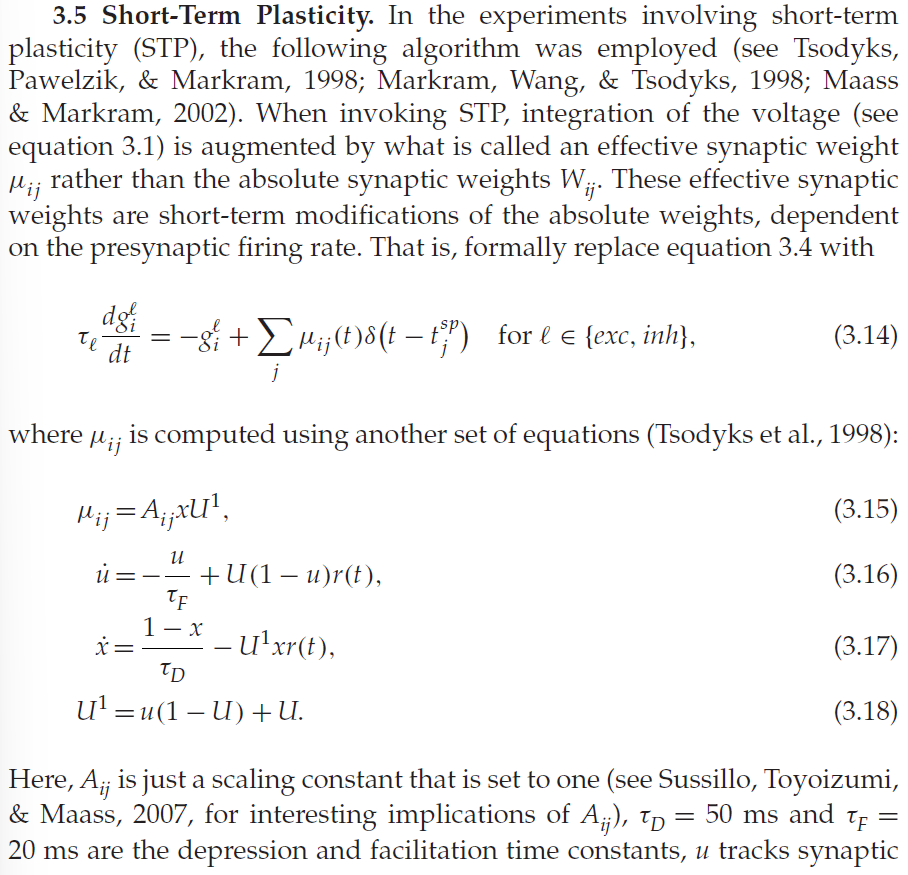

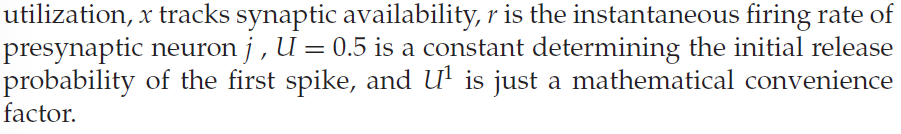

第3节描述了这篇文章中使用的所有模型。第3.1节定义了神经元模型,第3.2节定义了STDP可塑性规则,第3.3节定义了R-STDP,它扩展了STDP以用于强化学习。在第3.4节中,开发了一个新的学习规则,称为ARG-STDP,它改进了强化模型,能够学习多个远端奖励。第3.5节指定了用于稳定网络动态的STP模型。

3.1 Neuron Model.

3.2 STDP.

3.3 Reward-Modulated STDP.

4 Single-Synapse Reinforcement Experiment

5 Generalization to Multiple Synapse Learning

5.1 R-STDP with STP Can Learn Multiple r-Patterns.

5.2 ARG-STDP Can Learn Multiple r-Patterns.

5.3 STP Stabilizes ARG-STDP Network Learning Dynamics.

6 Properties of ARG-STDP with STP

6.1 Reward Predictive Properties of r-Patterns.

6.2 Learning Robustness to Reward Release Probability.

6.3 Learning Robustness to Reward Ordering.

6.4 Network Scaling.

6.5 The Reward Scheduling Problem.

6.6 Firing Rate Affects Learning Capacity.

6.7 Eligibility Trace Time Constant Affects Learning Capacity.

6.8 Interval Learning.

7 Discussion

在这篇文章中,表明R-STDP可以扩展到学习多个远端奖励,使用带有STP的新型ARG-STDP。Frémaux et al. (2010)描述了R-Max可塑性规则(Xie & Seung, 2004; Pfister, Toyoizumi, Barber, & Gerstner, 2006; Florian, 2007),它是使用奖励最大化原则推导出来的。这种可塑性规则还可以学习多个远端奖励,如Frémaux et al. (2010)所示,但能够做到这一点正是因为该规则缺乏无监督的偏差。尽管Florian (2007)煞费苦心地推导出了R-Max规则,但在模拟中使用了R-STDP,因为正如Florian所言,没有实验证明的模型可以像R-Max那样将神经元的发放强度纳入可塑性规则中。由于R-Max规则缺乏实验证据,以及R-Max在无监督学习任务中的不足,这篇文章的重点是扩展更常用的R-STDP规则。在R-STDP上扩展,ARG-STDP规则展示了为单个学习问题学习多个远端奖励的能力,同时保持无监督偏差。无监督偏差是无监督学习的一个重要方面;因此,它不应该完全从可塑性规则中消除。例如,利用无监督学习偏差,Young et al. (2007)证明了STDP与皮质重组的一致性。

应该注意的是,R-STDP和R-Max都是现象学规则,具有受全局奖励调节的局部赫布规则的结构,因此两者都是试图拟合数据曲线的可塑性候选者。然而,数据曲线通常是在体外测量的,可能会产生生理上不准确的结果。可塑性甚至取决于突触在树突树中的位置(Letzkus, Kampa, & Stuart, 2006)。很明显,R-STDP不足以重现突触可塑性的所有非线性方面。然而,R-STDP与皮质纹状体可塑性部分一致,其中长期效果需要激活D1/D5受体(Pawlak & Kerr, 2008)。此外,作为Frémaux et al. (2010)认为,ARG-STDP可能比R-Max更受青睐,因为它是时序差分学习的精神(Sutton & Barto, 1998),并且 ARG-STDP同意将皮层下多巴胺信号广泛解释为奖励-预测-误差(Schultz, 2007, 2010)。另一方面,Clopath和Gerstner (2010)支持电压相关的可塑性规则。今天可用的模型有局限性,但是这篇文章中的技术为解决多重远端奖励问题提供了进一步的见解,独立于潜在的强化模型。

Friedrich、Urbanczik和Senn (2011)还使用R-Max算法的变体解决了远端奖励问题。弗里德里希等人。使用级联资格迹在不同的时间尺度上学习。他们还展示了随网络规模扩展的学习。然而,这项工作表明,更大的网络会加快学习速度,而不是展示学习能力的提高。Friedrich et al. (2011)还主张多重资格迹的生物学基础。看看级联资格迹是否可以与R-STDP或ARG-STDP和STP一起使用并获得相似的结果,并看看这些扩展是否可以在不同的时间尺度上学习多个远端奖励。

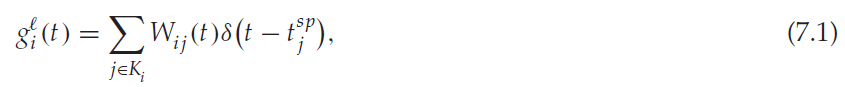

尽管这项工作受到了先前工作的启发(Florian, 2007; Izhikevich, 2007; Frémaux et al., 2010),但仍有一些差异。虽然Izhikevich (2007)使用Izhikevich神经元模型,但在这项工作中使用了LIF神经元模型,它具有更简单的动力学。尽管神经动力学更简单,但证明了许多远端奖励的稳定学习。此外,与这项工作相比,Izhikevich在所使用的突触输入模型中没有采用指数电导衰减。也就是说,Izhikevich使用电导求和方程,

与公式3.4中采用的经生物学验证的动力学相反。

这项工作采用了与Frémaux et al. (2010)类似的技术,通过要求每个通道的成功信号独立于其他通道消失。然而,这项工作与Frémaux et al. (2010)的工作以多种方式不同。在此,采用了具有基于电导的LIF神经元的事件驱动的脉冲神经网络模型。Frémaux等人使用SRM0神经元模型(Gerstner & Kistler, 2002)。这篇文章中介绍的模型使用STP来学习更多的远端奖励,并提供了一项分析来预测可以根据模拟中使用的参数学习的远端奖励数量的上限。此外,这篇文章中使用的网络配置的不同之处在于使用了更大、更通用的循环神经元池,其中包括兴奋性和抑制性神经元。此外,嵌入在后台网络中的一个小系统负责这里描述的学习任务,这在生物学上更现实。Frémaux et al. (2010)使用了一个小的、令人兴奋的、严格的前馈网络进行学习。

学习环境也不同。在这篇文章中,学习是连续的和普遍的,因为r-模式可能在任何给定时间发生并且可能重叠。r-模式反过来会在某个延迟时间从一个间隔均匀地抽取任何通道上的奖励。 因此,奖励可能以与r-模式不同的顺序发生,并且也可能重叠。这与Frémaux等人形成鲜明对比,其中神经网络通过设置试验进行训练,每次试验期间呈现特定的r-模式,然后在固定时间后获得奖励。

在这篇文章中用STP增强的ARG-STDP学习规则能够稳定地学习许多远端奖励,同时避免高发放率引起的潜在网络不稳定性,同时保持学习偏差。ARG-STDP使用一种机制来单独衰减每个r-模式的成功信号,作为r-模式出现次数的函数。由于![]() 被初始化为零并在讨论的实验中单调收敛到 R,因此成功信号

被初始化为零并在讨论的实验中单调收敛到 R,因此成功信号![]() 始终大于零。因此,R-STDP的无监督偏差并没有像Frémaux et al. (2010)声称类似的算法那样被消除。事实上,在此,当

始终大于零。因此,R-STDP的无监督偏差并没有像Frémaux et al. (2010)声称类似的算法那样被消除。事实上,在此,当![]() 时,学习变得可以忽略不计,这与移除规则的偏差时相同。相比之下,Frémaux et al. (2010)认为,当S = R − <R>被广播时,R-STDP的无监督偏差被消除,其中<R> 的计算方式与

时,学习变得可以忽略不计,这与移除规则的偏差时相同。相比之下,Frémaux et al. (2010)认为,当S = R − <R>被广播时,R-STDP的无监督偏差被消除,其中<R> 的计算方式与![]() 类似(但是,不同的参数用于创建奖励的短记忆试验平均值)。然后论证是<S> = <R - <R>> = 0,消除了规则的偏差。

类似(但是,不同的参数用于创建奖励的短记忆试验平均值)。然后论证是<S> = <R - <R>> = 0,消除了规则的偏差。

8 Conclusion

在这篇文章中,开发了一种新的ARG-STDP算法来学习Izhikevich (2007)中介绍的单突触强化学习问题的多个远端奖励。未来的工作将涉及将ARG-STDP中的critic算法近似转换为可以在脉冲域中实现的生物学上合理的在线critic,以解决涉及体现实际任务的神经元群体的更现实的问题。分析该模型的学习稳定性和多个远端奖励的学习能力。模拟结果表明,该模型能够在生物学上合理的神经网络中学习多个远端奖励。制定了网络学习能力的理论限制。

虽然ARG-STDP的学习能力有限,但将其与STP动态结合可以提高学习能力。了解如何扩展ARG-STDP以提高其学习能力非常重要。了解其对具有行为后果的现实情况的适用性同样重要。

Appendix A: Defining the Correlation Metric

Appendix B: Computing the Decaying Eligibility Trace