Deep Reinforcement Learning and Its Neuroscientific Implications

郑重声明:原文参见标题,如有侵权,请联系作者,将会撤销发布!

Abstract

强大的人工智能(AI)的出现为神经科学定义了新的研究方向。迄今为止,这项研究主要集中于在诸如图像分类等任务中使用监督学习训练的深度神经网络。但是,目前AI工作还有另一个领域受到神经科学家的关注较少,但可能具有深远的神经科学意义:深度强化学习(RL)。深度RL为研究学习,表征和决策之间的相互作用提供了一个全面的框架,为脑科学提供了一套新的研究工具和一系列新颖的假设。在当前的综述中,我们提供了深度RL的高层次介绍,讨论了其在神经科学中的一些初步应用,并调查了其对大脑和行为研究的广泛意义,并提供了进行下一步研究的机会。

在过去的几年中,人们对深度学习作为建模脑功能的基础的兴趣激增(Cichy and Kaiser, 2019; Güclü and van Gerven, 2017; Hasson et al., 2020; Marblestone et al., 2016; Richards et al., 2019)。深度学习已被研究用于建模多个系统,包括视觉(Yamins et al., 2014; Yamins and DiCarlo, 2016),听觉(Kell et al., 2018),运动控制(Merel et al., 2019; Weinstein and Botvinick, 2017),导航(Banino et al., 2018; Whittington et al., 2019)和认知控制(Mante et al., 2013; Botvinick and Cohen, 2014)。机器学习和AI的最新发展推动了人们对深度学习兴趣的兴起。与之特别相关的是在诸如图像分类的任务上使用监督学习训练深度学习系统的进展——即在任务训练期间明确提供“正确答案”(Krizhevsky et al., 2012; Deng et al., 2009)。

尽管有其新鲜感,但实际上可以将监督深度学习的神经科学应用追溯到1980年代,当时,监督深度学习的第一个神经科学应用开始出现(Zipser and Andersen, 1988; Zipser, 1991)。当然,鉴于功能更强大的计算机的出现带来了新的机遇,这种回报是非常合理的,它可以将监督深度学习系统扩展到更有趣的数据集和任务。但是,与此同时,最近的AI研究还有其他一些发展,这从根本上讲是新颖的,受到神经科学家的关注较少。我们在这篇综述中的目的是要引起人们对神经科学至关重要的领域的关注,即深度RL。

我们将详细介绍,深度RL将深度学习与已经对神经科学研究产生重大影响的第二个计算框架结合在一起。尽管将RL与深度学习相集成一直是AI的长期愿望,但直到最近几年这种集成才取得成果。反过来,这项工程突破带来了在深度学习或RL中都不会出现的各种计算问题。其中许多以有趣的方式与大脑功能的关键方面相关,为神经科学研究提供了一系列诱人的机会:迄今为止很少被探索的机会。

接下来,我们从对深度RL的简要概念和历史介绍入手,并讨论为什么它对神经科学具有潜在的重要性。然后,我们重点介绍一些研究,这些研究已开始探索深度RL与脑功能之间的关系。最后,我们提出了一系列广泛的主题,深度RL可以为神经科学提供新的手段,同时提出一系列注意事项和公开挑战。

图1. RL,深度学习和深度RL

(A) 左:RL问题。智能体选择动作并将其传输到环境,然后环境又将观测和奖励传输回智能体。智能体尝试选择将最大化长期奖励的动作。最优动作可能不会立即产生奖励,而是可能将环境状态更改为以后可以获取奖励的状态。右:RL问题的表格化解决方案。智能体认为环境处于几种离散状态之一,并从经验中学习与在每种状态下执行每个动作相关的期望长期回报。这些奖励期望是独立学习的,不会推广到新的状态或新的动作。

(B) 左:监督学习问题。智能体会收到一系列未标记的数据样本(例如图像),并且必须猜测真实标签。对真实标签的反馈会被立即提供。右:针对监督学习问题的深度学习解决方案。样本的特征(例如像素强度)穿过几层人工神经元(圆形)。每个神经元的活动是其输入的加权和,其输出是活动的非线性函数。网络的输出将转换为对该样本真实标签的猜测。在学习期间,调整网络权重,以使这些猜测接近真实标签。已经发现这些解决方案可以很好地推广到尚未对其进行训练的样本。

(C) 深度RL学习,其中将神经网络用作解决RL问题的智能体。通过学习适当的内部表征,发现这些解决方案可以很好地推广到新的状态和动作。

An Introduction to Deep RL Reinforcement Learning

RL (Sutton and Barto, 2018)考虑了学习者或智能体嵌入环境的问题,在这种环境中,智能体必须根据每个环境情况或状态逐步改进其选择的动作(图1A)。至关重要的是,与监督学习相反,智能体没有收到直接指示正确动作的明确反馈。取而代之的是,每个动作都会引发相关的奖励或缺乏奖励的信号,而RL问题是逐步更新行为,以使随时间累积的奖励最大化。因为没有直接告诉智能体该怎么做,所以它必须探索可选动作,积累有关它们产生的结果信息,从而逐步遵循一种奖励最大化的行为策略。

注意,RL是根据学习问题而不是通过学习系统的结构或学习算法本身来定义的。实际上,已经开发了各种各样的结构和算法,涵盖了关于表示什么量,如何根据经验更新这些量以及如何做出决策的一系列假设。

RL问题的任何解决方案的基础都是应如何表示环境状态的问题。RL的早期工作涉及简单的环境,该环境仅包含少数可能的状态和简单的智能体,这些智能体独立地了解每个状态,即所谓的表格式状态表征。通过设计,这种表征无法支持泛化(将一个状态的知识应用到其他相似状态的能力),这种缺点是随着环境变得越来越大且越来越复杂,那么其效率会变得越来越低,因此个别状态不太可能再次出现。

实现状态之间泛化的一种重要方法称为函数近似(Sutton and Barto, 2018),该方法试图将相似的表征分配给需要相似动作的状态。这种方法的一个简单实现称为线性函数近似,每个状态或情况都被编码为一组特征,学习者使用这些特征的线性值作为选择动作的基础。

尽管RL研究中经常使用线性函数近似,但人们早已认识到令RL产生智能的类人行为所需的是某种形式的非线性函数近似。众所周知,识别视觉类别(例如“猫”)需要对视觉特征(边缘,纹理和更复杂的配置)进行非线性处理,通常需要对感知输入进行非线性处理,以决定自适应动作。

考虑到这一点,RL研究长期以来一直在寻求可行的非线性函数近似方法。尽管多年来探索了多种方法,通常将表征学习问题与潜在的RL问题独立地进行处理(Mahadevan and Maggioni, 2007; Konidaris et al., 2011),但长期以来人们一直渴望使用深度神经网络进行自适应的非线性函数近似。

Deep Learning

深度神经网络是由通过类似突触的接触连接的类似神经元的单元组成的计算系统(图1B)。每个单元都发送一个类似于脉冲发放率的标量值,该标量值是根据其输入之和计算得出的,即“上游”单元的活动乘以传输突触或连接的强度(Goodfellow et al., 2016)。至关重要的是,单位活动是这些输入的非线性函数,允许在系统的“输入”和“输出”之间插入单位层的网络(即“深度”神经网络)能够近似将激活输入映射到激活输出的任何函数(Sutskever and Hinton, 2008)。此外,当连接模式包含循环时(例如在“循环”神经网络中),网络的激活可以保留有关过去事件的信息,从而使网络可以根据输入序列来计算函数。

“深度学习”是指在深度神经网络中调整连接权重以建立所需的输入-输出映射的问题。尽管存在许多解决该问题的算法,但是迄今为止,最有效且广泛使用的算法是反向传播,它使用微积分的链式规则来决定如何调整整个网络的权重。

尽管反向传播已经发展了30多年(Rumelhart et al., 1985; Werbos, 1974),但直到最近,反向传播几乎只用于上述定义的监督学习或无监督学习(仅提供输入),并且后者的任务是在一些评估表征结构的函数的基础上学习这些输入的“良好”表征,例如聚类算法。重要的是,这两个学习问题都与RL存在根本上的不同。特别是,与有监督和无监督学习不同,RL需要探索,因为学习者负责发现增加奖励的动作。此外,探索必须与利用已获得的动作-价值信息进行权衡,或者按照传统说法,必须与“开发”进行权衡。与大多数传统的有监督和无监督的学习问题不同,RL中的标准假设是学习系统的动作会在下一个时间步骤影响其输入,从而形成感觉-运动反馈回路,并由于训练数据的不稳定性而导致潜在的困难。这会导致目标行为或输出涉及多步决策过程,而不是单个输入-输出映射的情况。直到最近,将深度学习应用于RL设置一直是一个令人沮丧且难以理解的问题。

Deep Reinforcement Learning

深度RL利用深度学习的表征能力来解决RL问题。我们将深度RL系统定义为解决任何RL问题(即最大化长期奖励)的系统,使用的是通过深度神经网络本身学习的表征(而不是设计者规定的)。通常,深度RL系统使用深度神经网络来计算从感知输入到动作价值(例如Mnih et al. 2015)或动作概率(例如Silver et al., 2016)的非线性映射,并且RL信号通常通过反向传播来更新网络中的权重,以产生更好的奖励估计或增加高奖励动作的频率(图1C)。

1990年代初期,当下成功的深度RL,其值得注意的早期先驱出现了,这个系统名为TD-Gammon,它将神经网络与RL结合起来学习如何与顶级人类玩家竞争性地玩西洋双陆棋(Tesauro, 1994)。更具体地说,TD-Gammon使用时序差分RL算法,该算法针对每个遇到的棋盘位置计算系统获胜的可能性估计(状态-价值估计)。然后,系统根据后续事件计算奖励预测误差(RPE)—— 本质上是惊喜或失望的指示。RPE作为误差信号输入到反向传播算法中,该算法更新了网络的权重,以便产生更准确的状态-价值估计。然后对动作进行选择,以使下一个棋盘状态的状态价值最大化。为了生成许多用于训练的游戏回合,TD-Gammon使用了自我博弈,在该游戏中,算法将自己对战,直到一方获胜。

尽管TD-Gammon提供了一个诱人的示例,说明通过神经网络实施的RL可以提供什么,但其方法在其他问题领域却产生了令人失望的结果。主要问题是不稳定。在表格式线性系统中,RL能够可靠地朝着更好的行为发展,而当RL与神经网络结合时,这些模型经常崩溃或停滞,导致极差的结果。

2013年,随着深度Q网络(DQN)的出现,这种情况发生了巨大变化。DQN是第一个学会玩经典Atari视频游戏的深度RL系统(Mnih et al., 2013, 2015)。尽管DQN在许多游戏上都获得了比人类更好的性能,但真正的突破只是使深度RL以可靠稳定的方式工作。它结合了几种减少非平稳性的机制,以更像一系列有监督的学习问题的方式对待RL问题,在这些问题上可以更可靠地应用深度学习的工具。一个例子是“经验回放”(Lin, 1991),其中过去的状态-动作-奖励-下一个状态的转换被存储起来,并以随机顺序间歇地回放,以模仿发生在监督学习中的训练样本的随机采样。这有助于大大减少方差并稳定更新。

自DQN以来,深度RL的工作以惊人的速度发展和扩展。深度RL已扩展到高度复杂的游戏域,范围从Dota (Berner et al., 2019)到《星际争霸II》(Vinyals et al., 2019),再到夺取旗帜(Jaderberg er al., 2019)。新架构已经被开发出来,以在需要详细长期记忆的任务中支持有效的深度RL(Graves et al., 2016; Wayne et al., 2018)。深度RL已与基于模型的规划集成在一起,从而在包括国际象棋和围棋的复杂游戏中实现了超出人类的水平(Silver et al., 2016, 2017a, 2017b, 2018)。此外,已经开发出了方法来允许深度RL解决连续电机控制中的难题,包括足球和体操的模拟(Merel et al., 2018; Heess et al., 2016)以及机器人技术问题,例如用手操纵魔方(Akkaya et al., 2019)。我们在下面更详细地回顾了其中的一些进展,这是对深度RL对神经科学可能产生的影响的更大考虑的一部分,也是我们现在转向的话题。

图2. 在神经科学中的应用

(A) 在广泛的研究中,有监督的深度学习已用于建模和解释神经活动。在一项有影响力的研究中,Yamins and DiCarlo (2016)使用深度卷积网络(在图的下部示意性显示)在猕猴腹侧流的各个部分(上部)中模拟单独单元响应。该图改编自Yamins and DiCarlo (2016)。

(B) RL已通过多种方式与神经功能联系在一起。最具影响力的也许是在多巴胺释放与时序差分奖励预测误差信号(RPE)之间建立的联系。面板的左侧显示了在食物奖励意外到达(顶部),预测性提示(条件刺激[CS])到达或在CS之后省略奖励的情况下,腹侧被盖区中多巴胺神经元的典型脉冲栅格和直方图。右侧的相应面板在并行条件下绘制了来自时序差分RL模型的RPE,显示了定性相同的动态。图取自Niv (2009)。

(C) 深度RL在神经科学中的应用才刚刚开始。在一项开创性研究中,Song et al. (2017)在一个基于奖励的决策任务上训练了一个循环深度RL网络,该任务与Padoa-Schioppa and Assad (2006)在猴子中研究的任务相似。后者的研究检测了眼眶额叶区域13m(见左图)中神经元对许多不同选择集的反应,这些选择集涉及特定量的两种汁液(上图中的x轴),报告了跟踪猴子首选的推断值的神经元活动(前两个面板),每个汁液的价值(后两个面板)或实际选择的汁液的标识(右面板)。检测其深度RL模型中的单元,Song et al. (2017)发现活动模式与神经生理学数据非常相似(底部面板)。面板改编自Song et al. (2017),Padoa-Schioppa and Assad (2006)和Stalnaker et al. (2015)。

(C补充) 在Padoa-Schioppa and Assad (2006)的实验中,猴子在提供不同数量的两种汁液(A和B;其中A是首选)之间进行选择。猴子在水(汁液A)和不加糖的Kool-Aid(汁液B)之间进行选择。报价类型包括1B : 2A,1B : 1A,2B : 1A,3B : 1A,4B : 1A,6B : 1A和10B : 1A,以及“强制选择” 0B : 1A和3B : 0A。行为上,我们观察到汁液类型和汁液量之间的权衡。当有1B,2B或3B可供选择时,猴子选择A;当报价4B : 1A时,猴子在两种汁液之间基本没有差异;当有6B或10B时,猴子选择B。每个试验都以750毫秒的固定期开始;然后报价显示了左侧和右侧选择的“汁液”类型和量,持续时间为1000-2000毫秒,随后是750毫秒的决策期,在此期间需要网络指示其决策。

上方五个面板记录的是五个不同神经元的活动。在报价后(蓝色)和汁液后(黑色)时间窗口中记录响应。对于每个细胞,浅灰色曲线显示了报价前时间窗口中的活动。误差线代表s.e.m. 。

下方五个面板为示例价值网络单元在决策前(此处定义为决策之前的500毫秒)的平均活动。正如在猴子眼眶额叶皮层中观察到的那样,价值网络中的单位表现出不同的选择性。对于“选择”(最后一个面板),将试验分为选择A(红色菱形)和选择B(蓝色圆圈)。

Deep RL and Neuroscience

深度RL是由深度学习和RL组成的,它们已经独立地对神经科学产生了深远的影响。事实证明,深度神经网络是出色的神经表征模型(Yamins et al., 2014; Sussillo et al., 2015; Kriegeskorte, 2015; Mante et al., 2013; Pandarinath et al., 2018; Rajan et al., 2016; Zipser, 1991; Zipser and Andersen, 1988;图2A)。但是,这项研究大部分使用有监督的训练,因此几乎没有直接影响理解感知-运动环内的动机性目标导向行为的全局问题。同时,RL为学习和决策的神经机制提供了强有力的理论(Niv, 2009)。该理论最著名的是解释了多巴胺神经元的活动作为RPE (Watabe-Uchida et al., 2017; Glimcher, 2011; Lee et al., 2012; Daw and O'Doherty, 2014;图2B),但也解释了各种大脑结构在奖励驱动的学习和决策中的作用(Stachenfeld et al., 2017; Botvinick et al., 2009; O'Reilly and Frank, 2006; Glascher et al., 2010; Wang et al., 2018; Wilson et al., 2014b)。它已被集成到具有手工设计结构的小型神经网络中,以提供多个大脑区域如何相互作用以指导学习和决策的模型(O'Reilly and Frank, 2006; Frank and Claus, 2006)。就像在机器学习的环境中一样,直到最近,RL本身也没有为神经科学提供关于思考表征问题的指导(有关讨论,请参见Botvinick et al., 2015; Wilson et al., 2014b; Stachenfeld et al., 2017; Behrens et al., 2018; Gershman et al., 2010)。

深度RL通过展示RL和深度学习如何融合在一起,为神经科学提供了新的东西。深度学习着重于如何学习表征法,而RL着重于奖励如何指导学习,而在深度RL中,出现了新的现象:表征法支持奖励驱动的学习和决策并由其形成的过程。

如果深度RL仅以其熟悉的形式提供深度学习和RL的串联,那么它的意义将是有限的。但是深度RL不仅限于此。当深度学习和RL集成在一起时,它们各自会触发新的行为模式,从而导致深度学习或RL本身看不到的计算现象。也就是说,深度RL不仅仅是其各个部分的总和。集成框架的新颖方面又转化为神经科学的新解释原理,假设和可用模型。

在下一部分中,我们将考虑到目前为止已经出现的一些利用深度RL的神经科学研究,来介绍这一点,随后转向考虑深度RL为神经科学研究提出的一些更广泛的问题。

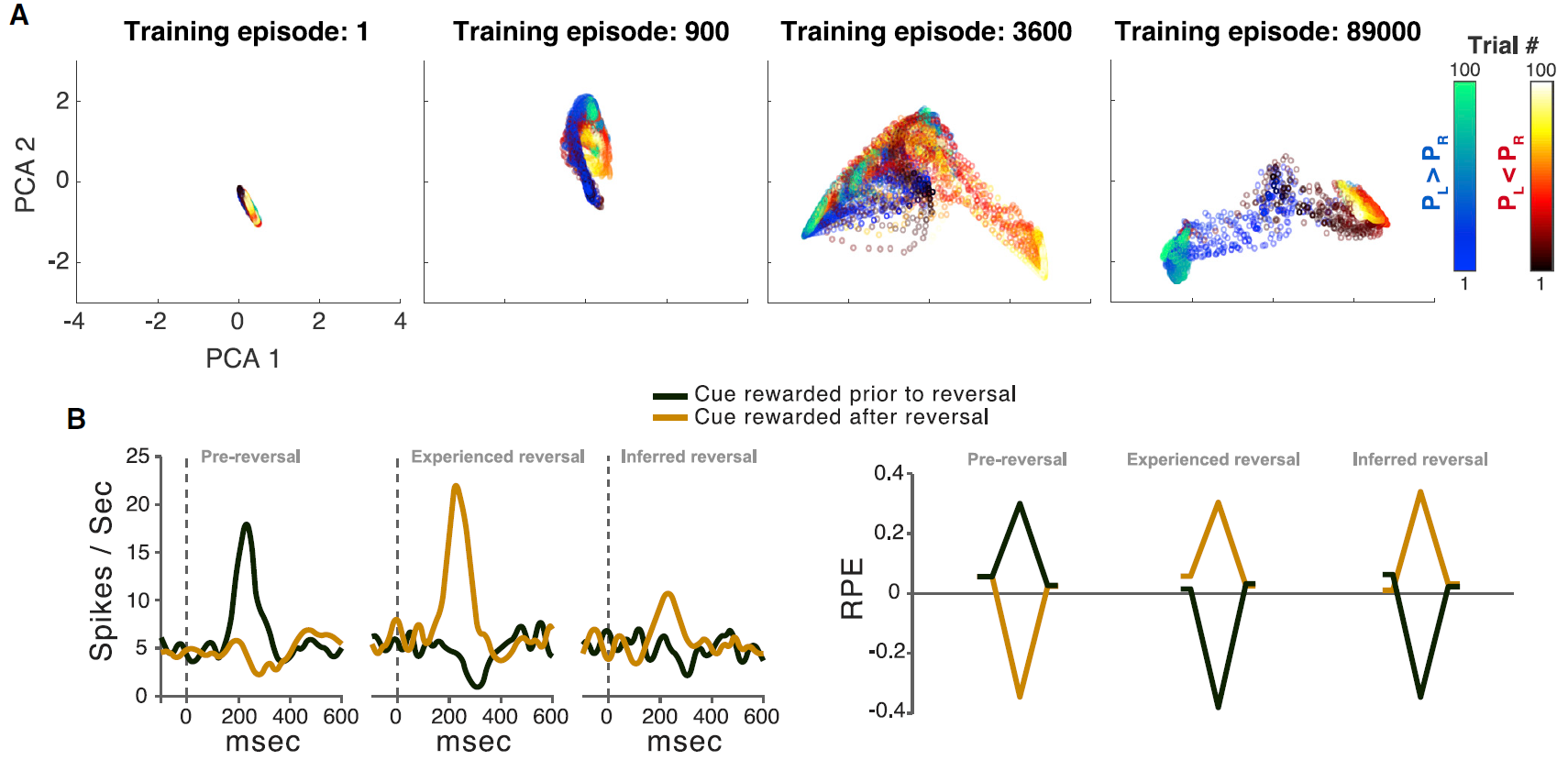

图3. 元RL

(A) 在训练的各个阶段,通过元RL学到的表征的可视化。人工智能体在一系列独立的Bernoulli双臂赌博机上进行训练(每个回合100次试验),从U(0, 1)中均匀得出奖励支出PL和PR的概率。散点描述了RNN激活(LSTM输出)向量的前两个主要成分,这些向量取自训练中某些点的评估回合,并根据试验编号(较暗且较早的试验)以及是否满足PL > PR进行了着色。只有满足| PL - PR | > 0.3的回合被画出。

(B) 面板改编自Bromberg-Martin et al. (2010)和Wang et al. (2018)。左:多巴胺能活动响应于反转之前的信号(左)以及经验价值(中间)和推断价值(右)变化的信号。右:来自人工智能体的相应RPE信号。每个数据系列的起点和终点对应于初始注视和扫视步骤。峰谷对应于刺激呈现方式。

(B补充) 左图三个面板分别为该区块的第1次试验(试验1),第2次试验目标与第1次试验相同(试验2,经验反转),以第2次试验目标与第1次试验不同(试验2,推断反转)。不同曲线分别代表前一个区块中有奖励但在当前区块中无奖励的目标(黑色)和前一个区块中无奖励并在当前区块中有奖励的目标(黄色)。神经发放率用高斯核(15ms)平滑并在神经元上取平均值。横坐标为目标出现后的时间。多巴胺能细胞的基准发放率为每秒5个脉冲。

标准模型的一个明显挑战是DA的RPE信号反映了任务结构的知识。一个例子就是Bromberg-Martin et al. (2010)报告的“推断价值”效应。在执行任务的每个试验中,视觉目标都出现在显示器的左侧或右侧,并且猴子被期望扫向目标。在实验的任何时候,左目标或右目标都会产生果汁奖励,而另一边则不会,并且这些角色分配在整个测试过程中会间歇性地反转。关键观察到的是反转后DA信号的变化:在猴子对一个目标的奖励发生变化之后,DA立即对另一个目标的出现做出了显著变化,反映出该目标的价值也发生了变化(左图)。

这种推断价值效应以及其他相关发现引出了模型,其中PFC或海马体对抽象的隐状态表示进行编码,然后可以将其送入生成RPE的计算中。事实证明,相关的机制自然是由元RL引起的。为了证明这一点,Wang et al. (2018)在Bromberg-Martin et al. (2010)的任务中训练了元RL模型。在测试中,Wang et al. (2018)观察到RPE信号复制了DA显示的模式。特别是,该模型清楚地再现了关键推断价值效应(右图)。

Bromberg-Martin et al. (2010)训练了四只猴子来执行奖励偏向的扫视任务。在此任务中,猴子通过将注视保持在固定点上1.2s来开始每次试验。然后,固定点消失,猴子对出现在屏幕左侧或右侧的视觉目标进行了眼球运动。扫视目标的位置指示了试验即将进行的奖励结果。在每个区块的24个试验中,一个目标位置得到奖励,而另一个目标位置未被奖励。即使在没有奖励的试验中,猴子仍必须正确进行扫视,否则试验将重复进行。在每个块的末尾,两个目标位置的奖励值被反转而没有告诉动物。要求猴子在500毫秒内向目标进行扫视。扫视错误会发出哔哔声,然后重复相同的试验。正确的扫视将在扫视后200毫秒开始发出100毫秒的音调信号。在有奖励的试验中,提供了流体奖励,并与音调刺激同时开始。在每区块的24个试验中,向一个固定方向的扫视奖励0.3毫升苹果汁,而向另一个方向的扫视则没有奖励。在下一个区块中,反转了位置奖励偶发事件。没有外部指令指示该块已更改。结果(奖励和不奖励)和目标位置(左右)的发生频率均相等。

在这项研究中,Bromberg-Martin et al. (2010)在反转后的前两个试验中分析了行为和神经活动,当时动物不得不了解目标的奖励值已经改变。例如,假设在上一个区块中,左侧目标能获得奖励,右侧目标不能获得奖励。然后在新区块的第一次试验中,正确的目标出现并得到奖励,这是意外的结果。猴子应该如何调整对两个目标的奖励价值的估计?显然,猴子可以使用正确目标的最近经历的结果(作为奖励)来估计正确目标现在具有很高的价值(补充图B,相同目标,经验价值)。但是,另一个左侧目标又如何呢?如果猴子仅从刺激-奖励配对中学习,则猴子不会更新左目标的价值,因为左目标实际上没有出现,也没有与其新的奖励结果配对。猴子仍然会相信左目标具有很高的价值,并且在目标之间不会有任何偏好(补充图C,根据经验学到的刺激价值)。另一方面,如果猴子使用调整为任务环境的奖励统计的策略来学习,则猴子会正确地推断出右目标价值的增加暗示左目标价值的减少。 猴子会将自己的偏好从左目标切换到右目标(补充图C,通过推理获得的刺激价值)。

至关重要的是,在每个块的第二次试验中,神经元更改了其奖励预测活动以匹配两个目标的新奖励值。当已经经历了第二次试验目标的价值时,可以看出这一点(图3B,经验反转);还可以看到,以前的试验中没有第二次试验的目标,并且必须推断出它的价值(图3B,推断反转)。因此,多巴胺神经元发出了既有经验价值又有推断价值的信号。就像猴子的行为一样,在推断价值试验中,两个目标之间神经反应强度的差异要弱一些,这表明神经元获得了与控制猴子的行为相同的目标价值估计。这些数据表明,猴子和神经元并没有完全根据刺激-奖励配对或特定于任务的推理规则来估计刺激计算值;相反,他们结合使用了两者。

补充图:奖励偏向的扫视任务,引用自Bromberg-Martin et al. (2010)。

A:任务图。将中心点固定1.2s。然后该点消失,同时在屏幕的左侧或右侧出现了视觉目标。要求猴子扫视目标。在24个试验的1个区块中,奖励了左扫视,未奖励右扫视(块1);在下一个区块中,奖励值被反转而没有通知动物(区块2)。

B:块更改后的事件序列示例。在新方块的第一个试验中,猴子收到意外的奖励结果(试验1:正确的目标,奖励)。区块的第二次试验可以呈现相同的目标,而该目标刚刚经历了奖励值(试验2:同一目标,经验价值),或者可以呈现另一个目标,该目标在先前的试验中不存在,并且其必须根据任务的反转规则来推断新的奖励价值(试验2:其他目标,推断价值)。

C:从配对正确目标→奖励中学习刺激价值的2种方法。左:如果动物仅通过经验学习,则右侧目标价值将增加,但左侧目标价值将保持不变。在试验2中,动物在目标之间没有任何偏好。右:如果动物通过推理学习,则该动物还会推断出该块已更改为块2,因此左侧目标值已减小。动物的偏好将从左目标切换到右目标。

Vanguard Studies

尽管出现了许多从神经科学角度探讨深度RL方面的评论(Hassabis et al., 2017; Zador, 2019; Marblestone et al., 2016),但很少有研究将深度RL模型直接应用于神经科学数据。

在少数情况下,研究人员以类似于监督深度学习和RL的先前应用的方式部署了深度RL。例如,将长期的研究策略从深度学习(Yamins et al., 2014; Zipser, 1991)移植到深度RL,Song et al. (2017)在神经科学文献中研究了一系列基于奖励的决策任务上的循环深度RL模型,报告了在网络内部单元中观察到的激活模式与背外侧前额叶,眶额叶和顶叶皮层中的神经元之间的密切对应关系(图2C)。Banino et al. (2018)的工作将监督深度学习和深度RL方法相结合,以显示类似于在内嗅皮层中看到的网格状表征如何增强目标导向的导航性能。

正如我们已经强调的那样,深度RL中出现的现象在单独考虑的深度学习或RL中不会出现。最近的两项研究集中在这些新兴现象的神经科学意义上。在一项研究中,Wang et al. (2018)研究了循环深度RL系统的行为,并描述了一种新颖的元RL效应:在一系列相互关联的任务(例如一系列具有相同总体结构但奖励概率不同的强制选择决策任务)上训练的循环深度RL网络可在不改变权重的情况下发展适应新任务的能力。这伴随着在整个训练过程中出现的隐含单元活动动态的相应结构化表征(图3A)。在网络连接权重级别上缓慢的RL驱动学习会影响网络的激活动态,从而快速的行为适应性可以仅由这些激活动态来驱动,这类似于神经科学的想法,即在某些情况下,RL可由基于活动的工作记忆来支持(Collins and Frank, 2012)。简而言之,慢速RL自发地产生了一个单独且更快的RL算法。Wang et al. (2018)显示了这种元RL效应如何可用于解释多巴胺和前额叶皮层功能的神经科学研究中广泛的令人费解的发现(图3B)。

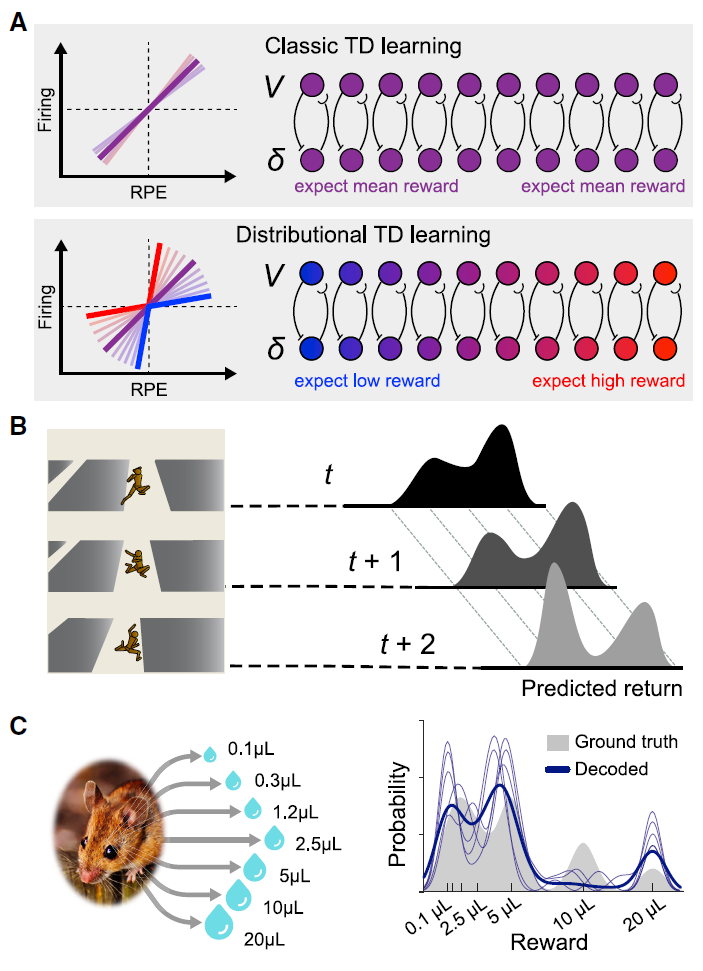

Dabney et al. (2020)进行了第二个此类研究。他们利用了在最近的AI工作中开发的一种深度RL技术,被称为分布RL (Bellemare et al., 2017)。之前,在讨论深度RL的历史时,我们提到了RPE。在传统RL中,此信号是简单的标量,正数表示惊喜,负数表示失望。最近的神经科学启发模型表明,考虑奖励的分布和不确定性对于风险决策至关重要(Mikhael and Bogacz, 2016)。在分布RL中,RPE扩展为向量,其中不同元素根据不同的先验预测(从高度乐观到高度悲观的预测)发送RPE信号(图4A和4B)。在AI工作中已经观察到这种修改可以显著提高RL在各种任务中的速度和结果,重要的是,在深度RL中观察到了某些东西,但在表格式或线性RL等简单形式中却没有观察到(部分原因是由于分布编码对表征学习的影响;Lyle et al., 2019)。将这一发现带入神经科学领域,Dabney et al. (2020)研究了来自小鼠的电生理数据,以测试多巴胺系统是否可能使用分布RL中涉及的矢量代码。如前所述,已经提出了多巴胺可以传输类似RPE的信号。Dabney et al. (2020)获得了强有力的证据,表明这种多巴胺能信号是分布的,传达了从悲观到乐观的一系列RPE信号(图4C)。

图4. 分布RL

(A) 上图:在经典TD模型中,每个多巴胺细胞针对相同的预测奖励V计算一个预测误差δ。底部:在分布TD中,一些RPE通道会放大负RPE(蓝色),而另一些会放大正RPE(红色)。这导致通道学习不同的奖励预测,范围从非常悲观(蓝色)到非常乐观(红色)。

(B) 具有不同RPE缩放比例的人工智能体学会预测回报分布。在此示例中,智能体不确定它是否将成功登陆平台。右侧显示了智能体在三个连续时间步骤上的预期奖励分布。

(C) 在真实动物中,可以直接从多巴胺活动中解码奖励分布。在这里,对小鼠进行了具有概率奖励的任务的全面训练。任务的实际奖励分布被显示为灰色阴影区域。当被解释为分布TD学习者的RPE通道时,多巴胺细胞的发放会解码为蓝色显示的分布(细迹线是最好的五种解决方案,粗迹线是其均值)。解码后的分布与实际奖励分布的多种模式匹配。面板改编自Dabney et al. (2020)。

Topics for Next-Step Research

正如我们已经指出的,对神经科学中的深度RL的探索才刚刚开始。未来的主要机遇是什么?在以下各节中,我们概述了深度RL可能为神经科学研究提供影响的六个领域。在每种情况下,都已经在AI环境中进行了深入的探索,从而为神经科学提供了转化研究的具体机会。尽管我们在下文中强调了切实可行的建议,但重要的是要记住,这些建议不限制深度RL的定义。相反,深度RL是一个广泛且多方面的框架,在该框架中,可以通过多种方式实现算法细节,从而使神经科学假设的空间变得多样化。

图5. 深度监督学习和深度RL学到的表征

(A) 来自深度神经网络的自然图像表征(ImageNet;Deng et al., 2009),该网络经过训练以对目标进行分类(Carter et al., 2019)。一层("mixed5b")中表征的t分布随机邻居嵌入(t-SNE),由预测的目标类别着色,并显示示例图像。

(B) 来自受过深度RL训练的DQN智能体的Atari视频游戏图像(Bellemare et al., 2013)的表征(Mnih et al., 2015)。最终隐含层表征的t-SNE,以预测的未来奖励价值进行着色,并显示示例图像。

(C) 最大限度地激活单个人工神经元(在"mixed4a"层中)的综合输入显示了高级特征和纹理的专业化,以支持目标识别(Olah et al., 2017)。

(D) 从最终卷积层最大程度地激活单个细胞的合成图像揭示了具有纹理的细节,用于奖励预测功能(Such et al., 2019)。例如,在游戏Seaquest中,潜水艇与进来的鱼的相对位置似乎捕获在最右上方的图像中。

Representation Learning

表征的问题长期以来一直是神经科学的中心问题,也许始于Hubel and Weisel (1959)的研究,并且一直持续到今天(Constantinescu eet al., 2016; Stachenfeld et al., 2017; Wilson et al., 2014b)。表征的神经科学研究已经受益于深度学习提供的工具(Zipser and Andersen, 1988; Yamins et al., 2014),该模型提供了如何通过感官经验来塑造表征模型。深度RL扩展了该工具包,首次提供了如何通过奖励和任务需求来塑造表征模型。在深度RL智能体中,基于奖励的学习塑造了内部表征,而这些表征又支持基于奖励的决策制定。一个典型的例子是有关Atari任务的DQN网络训练。在这里,根据得分多少生成的奖励信号会馈入反向传播算法,该算法会修改整个深度神经网络的权重,从而更新所有单元的响应曲线。这将导致适合该任务的表征。监督学习系统将相似的表征分配给具有相似标签的图像(图5A和5C),而深度RL倾向于将具有相似功能任务含义的图像关联起来(图5B和5D)。

这种基于奖励的表征学习的思想与神经科学的大量证据产生了共鸣。例如,我们知道前额叶皮层中视觉刺激的表征取决于动物被训练执行的任务(Freedman et al., 2001),并且即使在初级视觉皮层中也可以看到任务奖励对神经反应的影响(Pakan et al., 2018)。

深度RL系统的开发和使用提高了人们对仅由RL塑造的表征的两个严重缺陷的认识。一个问题是与任务相关的奖励通常很少。例如,在国际象棋中,每场比赛只发生一次奖励,这对于学习开局动作来说是微弱的信号。第二个问题是过拟合:仅由特定于任务的奖励形成的内部表征可能最终仅对学习者执行的任务有用,而对新任务则完全错误(Zhang et al., 2018; Cobbe et al., 2019)。一些更好的学习过程,它会产生更广泛有用的内部表征,以支持任务之间的迁移。

为了解决这些问题,实践中通常会对深度RL补充以无监督学习(Higgins et al., 2017)或“自监督”学习。 在自监督学习中,除了动作之外,智能体还被训练以产生一些匹配输出信号的辅助输出,这是从智能体的经验流中自然获得的,而不需要考虑训练的是哪个特定的RL任务(Jaderberg et al., 2016; Banino et al., 2018)。一个例子是预测学习,其中训练智能体根据其当前情况预测其在未来时间步骤中将观察到的内容(Wayne et al., 2018; Gelada et al., 2019)。无监督和自监督学习减轻了与纯RL相关的两个问题,因为它们以不完全依赖于学习者面临的特定任务的方式塑造表征,因此产生的表征有可能支持在他们迁移到其他任务时出现。所有这些都与现有的神经科学工作相一致,其中无监督学习(例如,Olshausen and Field, 1996; Hebb, 1949; Kohonen, 2012)和预测学习(例如,Schapiro et al., 2013; Stachenfeld et al., 2017; Rao and Ballard, 1999)已提出以塑造内部表征。深度RL提供了在这样的环境中追求这些想法的机会,其中这些学习形式可以与奖励驱动的学习相结合(Marblestone et al., 2016; Richards et al., 2019),它们产生的表征支持适应性行为。

深度RL中的另一个问题涉及归纳偏差在塑造表征学习中的作用。接受视觉输入的大多数深度RL系统使用的处理架构(卷积网络;Fukushima, 1980)偏向考虑图像平移不变性的表征。而最近开发的架构则偏向于将视觉输入表示为包含具有重复成对关系的离散对象集(Watters et al., 2019; Battaglia et al., 2018)。这些想法使人回想起现有的神经科学发现(Roelfsema et al., 1998),并对深度RL产生了有趣的影响,例如通过将环境分解成目标,可以更有效地探索和学习的可能性(Diuk et al., 2008; Watters et al., 2019)。

Model-Based RL

RL算法的一个重要分类是“无模型”算法和“有模型”算法,“无模型”算法学习从感知输入到动作输出的直接映射,而“有模型”算法则学习动作-结果的“模型” 关系,并通过预测结果来规划动作。

这种二分法对神经科学产生了显著影响,大脑区域在这两种学习中被赋予了不同的作用,并且有影响力的研究重点在于两种学习形式如何相互取舍(Lee et al., 2014; Daw et al., 2005, 2011; Balleine and Dickinson, 1998; Dolan and Dayan, 2013)。深度RL为无模型RL与有模型RL之间的关系开辟了一个新的优势。例如,在AlphaGo及其后续系统(Silver et al., 2016, 2017b, 2018)中,有模型的规划部分通过价值估计和通过无模型RL所学习的动作趋势来指导。已经在神经科学和心理学中研究了这两个系统之间的相互作用(Cushman and Morris, 2015; Keramati et al., 2016)。

在AlphaGo中,规划中使用的动作-结果模型是手动编码的。更有趣的是,从神经科学的角度来看(Glascher et al., 2010),有模型RL依赖于从经验中学到的模型(Schrittwieser et al., 2019; Nagabandi et al., 2018; Ha and Schmidhuber, 2018)。尽管这些算法在某些领域已经取得了巨大的成功,但一个关键的开放问题是系统是否可以学会以较高的抽象水平捕获转换动态("如果我在那个窗口扔石头,它将被粉碎")而不是与关于感知观察的详细预测联系在一起(预测每个碎片将落在哪里)(Behrens et al., 2018; Konidaris, 2019)。

深度RL的一个特别有趣的发现是,在某些情况下,类似于有模型RL的过程可能会在使用无模型RL算法训练的系统中自发出现(Wang et al., 2016; Guez et al., 2019)。这种“无模型规划”的神经科学含义已经得到了初步研究(Wang et al., 2018),但值得进一步研究。有趣的是,在基于RL的系统中也看到了基于模型的行为,该系统使用一种特殊形式的预测代码,即所谓的"后继表征"(Vértes and Sahani, 2019; Momennejad, 2020; Kulkarni et al., 2016; Barreto et al., 2017),并提出了一种可能的机制,通过这种机制可能会产生无模型的规划。

在神经科学工作中出现的一个有趣的问题是,如何仲裁无模型和有模型的RL之间的平衡,即,是什么机制在瞬间决定行为是由无模型还是有模型的机制控制的(Daw et al., 2005; Lee et al., 2014)。与这个问题相关的是,AI中一些深入的RL工作引入了一种机制,该机制可以通过RL来学习在采取动作之前是否以及如何进行深度规划(Hamrick et al., 2017)。由此产生的架构让人想起神经科学在前额叶皮层中实现的认知控制机制所做的工作(Botvinick and Cohen, 2014),我们将在下面进一步讨论这个话题。

Memory

关于记忆,可以说是神经科学中最重要的话题之一,深度RL再次提出了极具吸引力的新问题,并强调了新颖的计算可能性。特别是,深度RL提供了一种计算环境,可用于研究记忆如何支持基于奖励的学习和决策,这一话题在神经科学领域引起了越来越多的关注(例如,参见Eichenbaum et al., 1999; Gershman and Daw, 2017)。第一个广泛成功的深度RL模型依赖于经验回放(Mnih et al., 2013),其中过去的经验被存储并间歇地与新的经验一起用于驱动学习。这与在海马体和其他地方观察到的回放事件有着令人着迷的相似性,并且确实是受到这种现象及其在记忆巩固中的怀疑作用的启发(Wilson and McNaughton, 1994; Kumaran et al., 2016)。尽管早期的深度RL系统对经验进行均匀回放,但大脑中的回放并不均匀(Mattar and Daw, 2018; Gershman and Daw, 2017; Gupta et al., 2010; Carey et al., 2019),并且机器学习中一直在探索非均匀性,将其作为一种增强学习的方式(Schaul et al., 2015)。

除了推动巩固之外,大脑的记忆维护和检索还用于在线决策(Pfeiffer and Foster, 2013; Wimmer and Shohamy, 2012; Bornstein and Norman, 2017; O'Reilly and Frank, 2006)。在深度RL中,两种记忆具有此功能。首先,"回合式"记忆系统读写长期存储插槽(Wayne et al., 2018; Lengyel and Dayan, 2008; Blundell et al., 2016)。这些系统的一个有趣的方面是,它们允许相对容易地分析每个时间步骤存储和检索的信息(Graves et al., 2016; Banino et al., 2020),从而可以与神经数据进行比较。其次,循环神经网络以类似于神经科学中称为工作记忆维护的方式,在激活中存储信息。广泛使用的LSTM(长短期记忆)和GRU(门控循环单元)结构使用可学习的门控来忘记或保留与任务相关的信息,这使人想起了类似的大脑机制(Chatham and Badre, 2015; Stalter et al., 2020)。

更深层次的RL记忆机制正在迅速发展,包括在记忆中的信息上进行注意力和关系处理的系统(例如Parisotto et al., 2019; Graves et al., 2016)以及结合并协调工作和回合式记忆的系统(例如Ritter et al., 2018)。这代表了深度RL和神经科学之间的交流似乎最可行且最有前途的主题领域之一。

Exploration

如前所述,探索是将RL与其他标准学习问题区分开的特征之一。RL要求有必要主动寻求信息,测试新颖的行为,并使其与既有知识保持平衡,并在探索与开发之间进行权衡。当然,动物也面临这一挑战,并且在神经科学和心理学领域也引起了极大的关注(参见,例如,Costa et al., 2019; Gershman, 2018; Wilson et al., 2014a; Schwartenbeck et al., 2013)。在这里,深度RL再次提供了新的计算视角和一组特定的算法思想。

RL探索工作中的关键策略是包括辅助("内在")奖励(Schmidhuber, 1991; Dayan and Balleine, 2002; Chentanez et al., 2005; Oudeyer et al., 2007)。至于新颖性,这会鼓励智能体访问陌生的状态或情况。但是,由于深度RL通常处理高维感知观察,因此很少会出现完全相同的感知观察。因此出现了如何量化新颖性的问题,并提出了一系列创新技术来解决这个问题(Bellemare et al., 2016; Pathak et al., 2017; Burda et al., 2019; Badia et al., 2020)。出于内在动机的探索的另一种方法不是基于新颖性而是基于不确定性,这鼓励智能体进入其预测不太自信的环境部分(Osband et al., 2016)。在任务经验的基础上,其他工作仍在追求使智能体学习或发展自身内在动机的想法(Niekum et al., 2010; Singh et al., 2010; Zheng et al., 2018)。

元RL为探索提供了另一种有趣且新颖的观点。如前所述,即使权重变化被暂停,元RL也会产生支持学习的激活动态。重要的是,在这种情况下进行的学习涉及探索,因为它的结构可以适应系统所训练的各种问题,所以探索非常有效。确实,元RL系统中的探索看起来更像是假设驱动的实验,而不是随机探索(Denil et al., 2016; Dasgupta et al., 2019)。元RL系统的这些特性使它们成为研究动物战略探索的神经基础的具有吸引力的潜在工具。

最后,一些有关深度RL的研究提出通过在分层行为空间中随机采样来解决探索问题(Machado et al., 2017; Jinnai et al., 2020; Hansen et al., 2020)。这导致了一种定向的,时间上扩展的,随机探索形式,让人联想到一些动物觅食模型(Viswanathan et al., 1999)。

Cognitive Control and Action Hierarchies

认知神经科学长期以来都具有一系列功能,统称为“认知控制”,可指导任务选择并从战略上组织认知活动和行为(Botvinick and Cohen, 2014)。深度RL的最初应用不包含与此功能集相对应的内容。但是,随着深度RL研究的发展,它已开始解决在多个任务或技能之间获得能力和转换的问题,在这种情况下,已经开发出许多与认知控制的神经科学模型有着令人感兴趣的关系的计算技术。

也许最相关的研究已经适应了源于分层RL较旧领域的深度RL思想。在此,RL在两个级别上进行操作,从而在高级多步动作(例如“煮咖啡”)和更具原子性的动作(例如“磨豆”;请参阅Botvinick et al., 2009)之间做出选择。深度RL研究以多种方式采用了这种分层方案(Bacon et al., 2017; Harutyunyan et al., 2019; Barreto et al., 2019; Vezhnevets et al., 2017)。在其中一些系统中,低层系统可以自主运行,而上层系统仅以构成RL目标一部分的成本进行干预(Teh et al., 2017; Harb et al., 2018),是一个令习惯性途径与自动化的神经科学概念和受控处理(Dolan and Dayan, 2013; Balleine and O'Doherty, 2010)以及“控制成本”的思想(Shenhav et al., 2017)相呼应的安排。在深度RL中,自上而下控制低层习惯的概念也已应用到运动控制任务中,以及在与经典神经科学模型进行分层控制产生共鸣的结构中(Merel et al., 2018; Heess et al., 2016)。

有趣的是,在某些情况下,分层深度RL系统已配置为在不同时间尺度与不同层次上运行,而在更高层次上更新速度较慢,这一组织原理与一些关于跨皮质的分层组织时间尺度的神经科学证据相呼应(Badre, 2008; Hasson et al., 2008)。

Social Cognition

神经科学研究的一个新兴领域正在研究社会认知的神经基础。在过去的两年中,深度RL进入了这个领域,开发了在有趣的多智能体场景中并行训练多个智能体的方法。这包括竞争性团队游戏,其中每个智能体必须学习如何协调其动作(Jaderberg et al., 2019; Berner et al., 2019);需要困难协调的合作游戏(Foerster et al., 2019);以及棘手的“社会困境”,必须权衡短视的自私行为和合作行为(Leibo et al., 2017)。行为科学对这种情况进行了长期的研究,而多智能体深度RL在这一研究领域提供了新的计算手段,直至包括其他人的心理模型或“心智理论”所基于的神经机制(Rabinowitz et al., 2018; Tacchetti et al., 2018)。

Challenges and Caveats

重要的是要注意,深度RL是一个活跃的研究领域,而且确实是一个相当新的领域,并且动物和特别是人类行为的许多方面尚未被成功捕获。可以说,从神经科学的角度来看,这些局限性是有好处的,因为它们使仍然最需要计算阐明的认知能力得到缓解(Lake et al., 2017; Zador, 2019),并且确实指出了神经科学的特定领域也许能够使AI研究受益。

经常被指出的一个问题是深度RL中学习的缓慢性,即对大量数据的需求。例如,DQN与实际的人类学习者相比,在Atari游戏中达到人类水平的性能需要更多的经验(Lake et al., 2017)。这个问题比起初听起来要复杂,这两者都是因为标准的深度RL算法通过替代学习方法(例如基于回合式记忆的元学习和深度RL)已逐渐提高了采样效率(Ritter et al., 2018; Botvinick et al., 2019),并且对于每一个新的学习问题,人类学习者会利用毕生的经验。

话虽如此,重要的是要认识到,深度RL系统尚未被证明能够根据结构化推论灵活地适应人类,并利用强大的背景知识。深度RL系统能否弥补这一差距是一个开放且令人兴奋的问题。最近的一些工作表明,深度RL系统可以在适当的情况下利用过去的经验来快速系统地适应看起来很新颖的情况(Hill et al., 2019),但这并不会必然发生(例如参见Lake and Baroni, 2017),并且AI和神经科学对理解这种差异都很感兴趣。

第二组问题集中在学习如何发生的更多细节上。在这方面,一个重要的挑战是长期时间信度分配,即基于奖励的更新行为,这些奖励可能要等到产生这些奖励的行为发生后的相当长的时间才会累积。对于深度RL系统而言,这仍然是一个挑战。最近已经提出了新颖的算法(参见例如Hung et al., 2019),但是问题远未解决,将这一领域与神经科学交叉可能对这两个领域都有利。

更基本的是深度RL研究中几乎普遍使用的学习算法:反向传播。正如在有监督的深度学习研究(也使用反向传播)中进行的广泛讨论一样,存在关于如何在生物神经系统中实施反向传播(如果确实存在的话)的悬而未决的问题 (Lillicrap et al., 2020; Whittington and Bogacz, 2019; 尽管参见Sacramento et al., 2018和Payeur et al., 2020,有关如何在生物回路中实施反向传播的有趣建议)。在面对新学习的情况下,与保持旧学习结果相关的反向传播存在固有的困难,正在积极研究补救措施的问题,在某些情况下是从神经科学获得灵感的(Kirkpatrick et al., 2017)。

最后,尽管我们强调了深度RL研究与神经科学的一致性,但强调不匹配的重要方面也很重要。当前的大量RL研究都是在工程环境中进行的,而不是作为对脑功能建模的一部分。作为结果,在深度RL研究中使用的许多技术从根本上不同于可以在生物系统中合理实施的任何技术。同时,在神经科学中很重要的许多问题,例如能源效率或世代相传知识的遗传性,并没有在面向AI的深度RL研究中作为自然问题出现。当然,即使有重要方面将面向工程的深度RL系统与生物系统区分开,也可能仍然存在可以跨越鸿沟的高层次见解。但是,在确定神经科学与当前深度RL研究之间进行交流的潜力时,务必牢记这些潜在的差异来源。

Conclusion

AI的最新发展为神经科学提供了许多激动人心的新机会。在讨论深度RL时,我们将重点放在AI研究的一个特别新颖的领域上,我们认为该领域对神经科学具有特别丰富的意义,但其中大多数尚未得到深入探讨。正如我们已经描述的那样,深度RL提供了一个基于智能体的框架,用于研究奖励塑造表征的方式,以及表征又如何塑造学习和决策的能力,这两个问题共同构成了神经科学最核心的内容。我们期待通过深度RL研究来增加对神经科学的投入。随着这种情况的发生,还有另一个机会。我们一直在关注深度RL如何帮助神经科学,但是从我们撰写的许多文章中应该可以清楚地看出,深度RL仍在发展中。从这个意义上讲,神经科学研究也有机会影响深度RL,延续数十年来将神经科学和AI联系在一起的协同“良性循环”(Hassabis et al., 2017)。