3、spark开发环境

第一步 在idea中创建maven项目

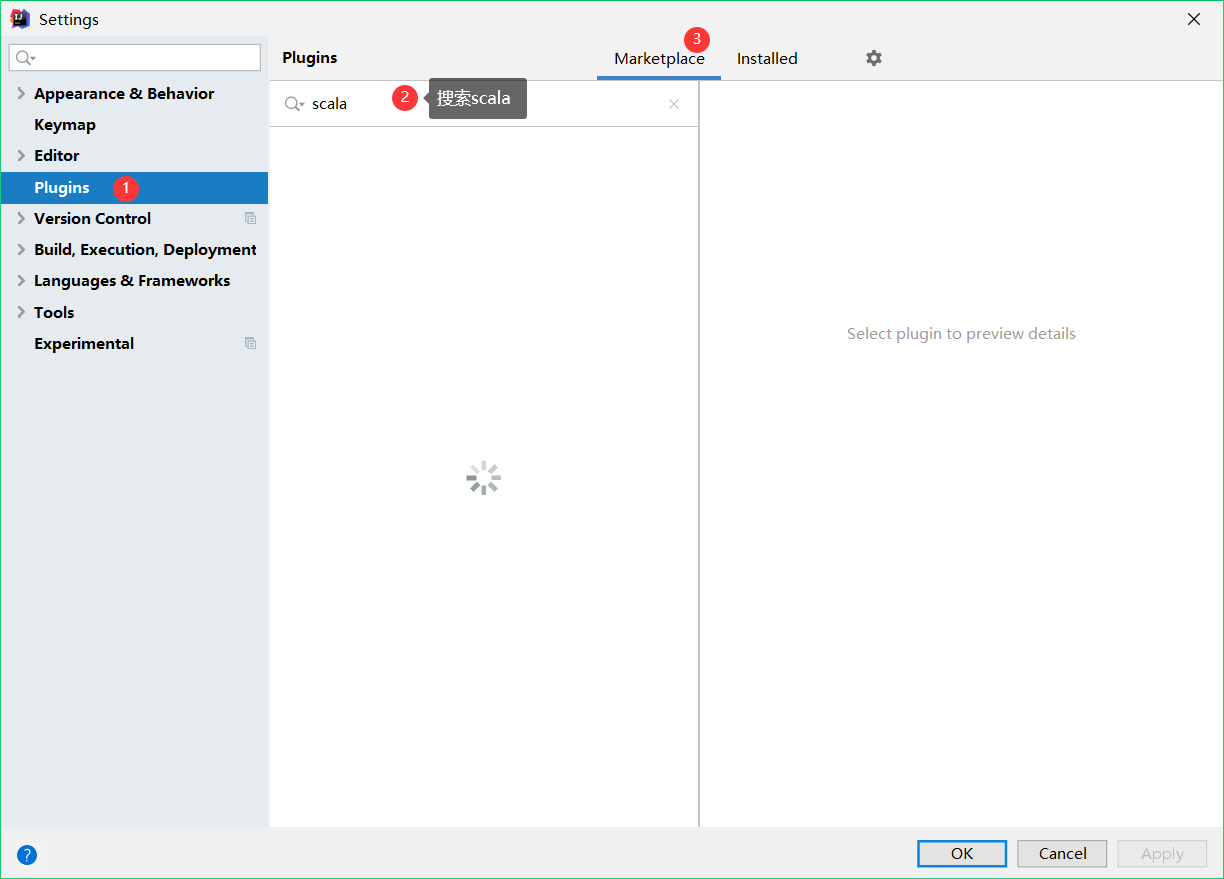

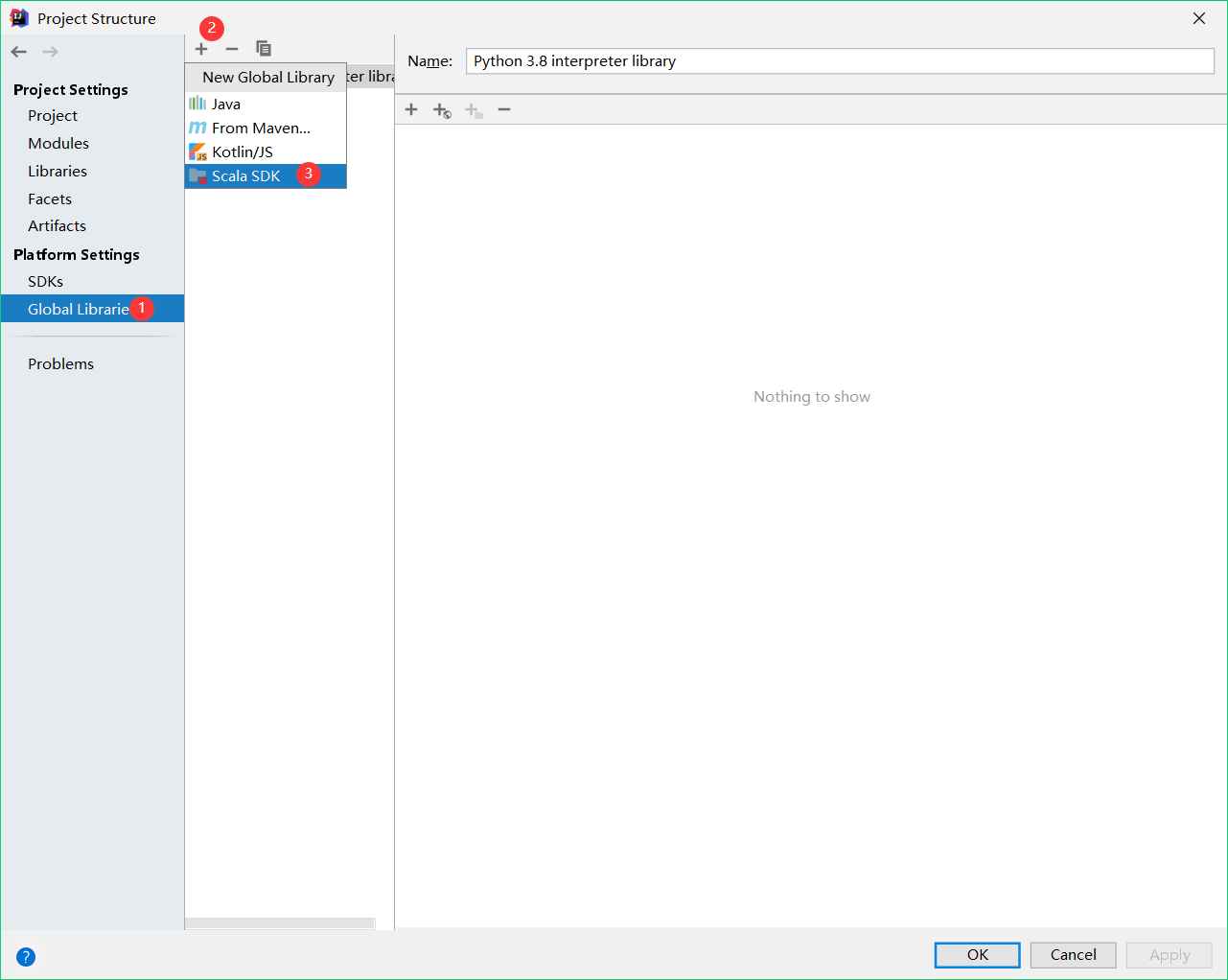

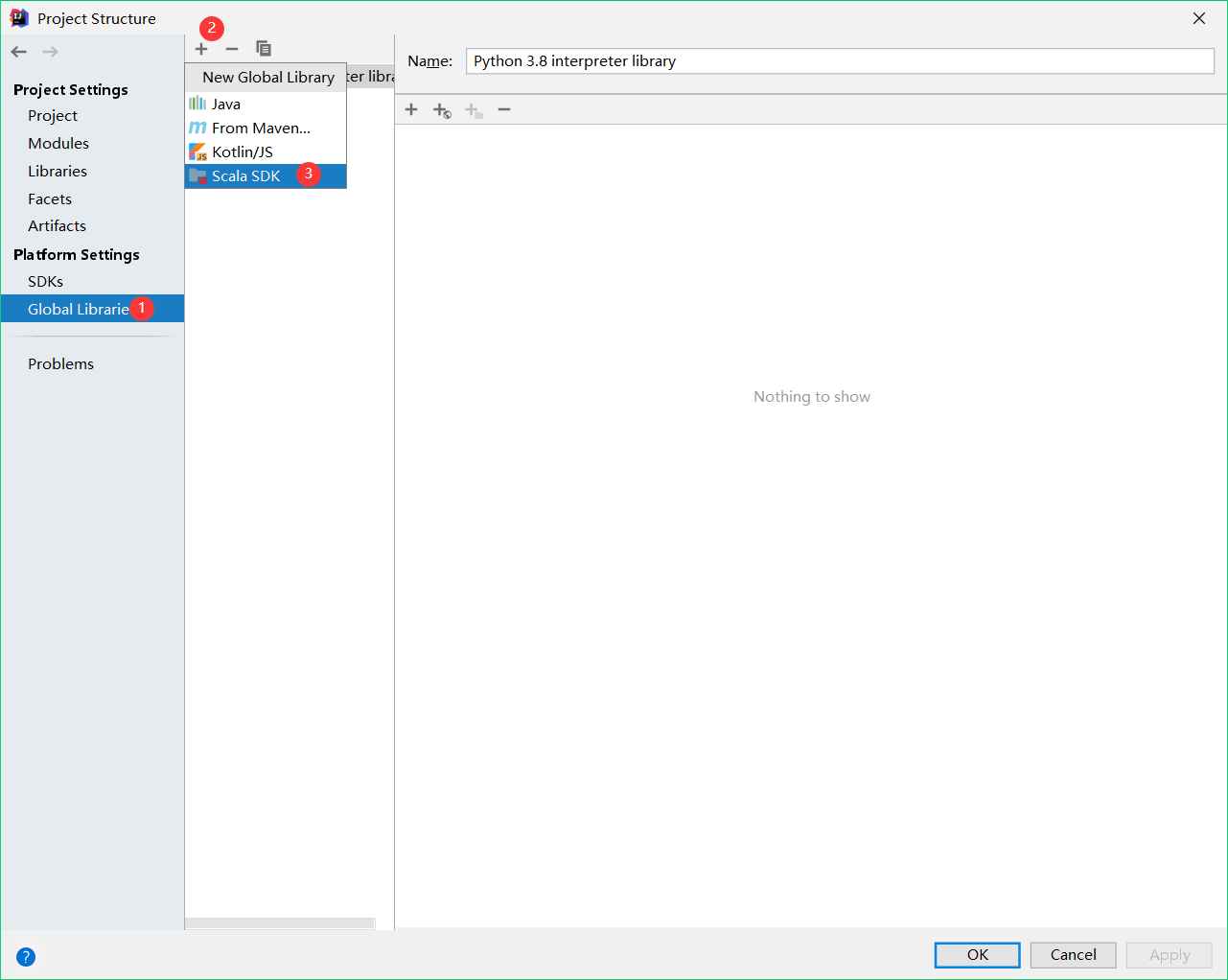

第二步 增加Scala插件

Scala插件

Spark由Scala语言开发,Spark版本为3.0.0,默认采用的Scala编译版本为2.12

idea中添加Scala插件

file--settings

我的解决办法是下载了一个加速器连外网

安装第一个scala插件,重启idea

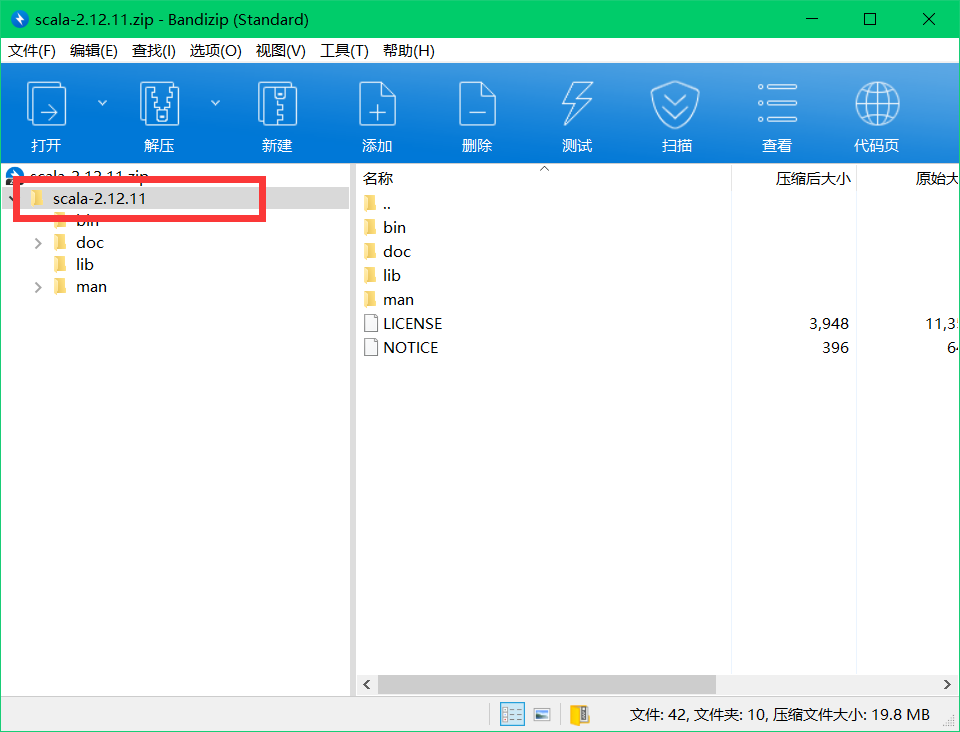

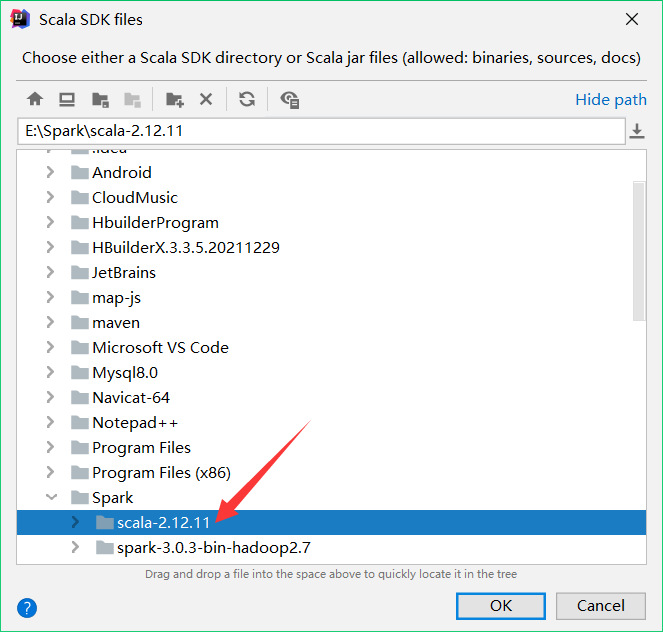

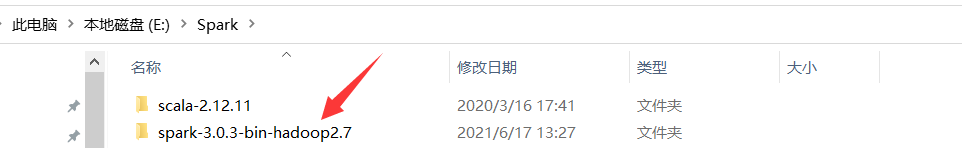

第三步 下载scala

在scala官网中下载

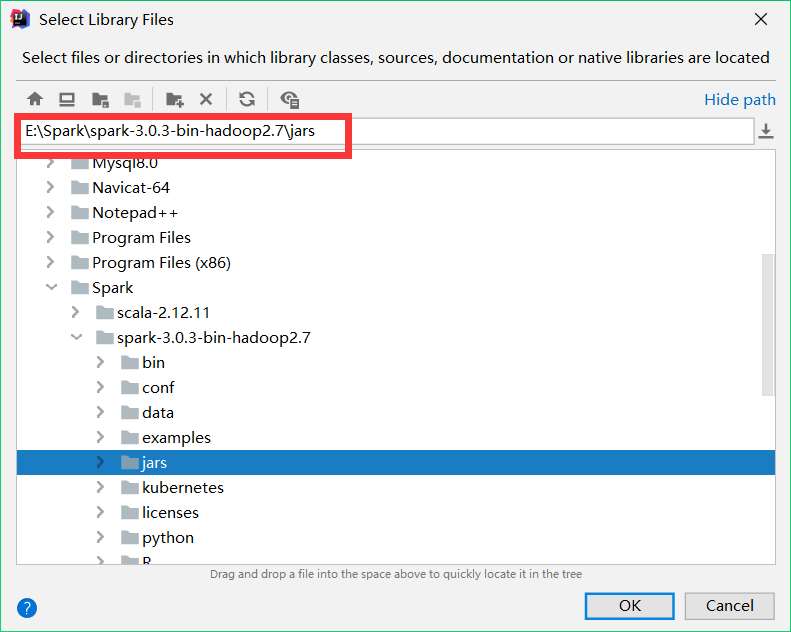

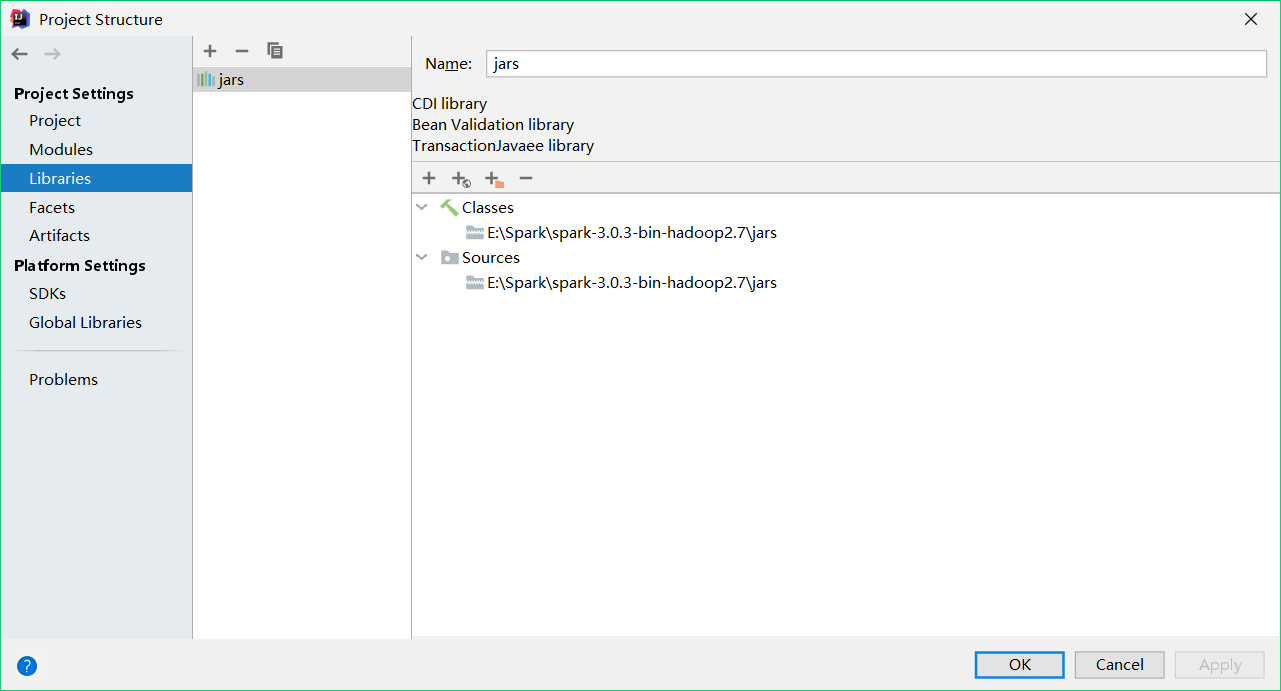

第四步 下载spark

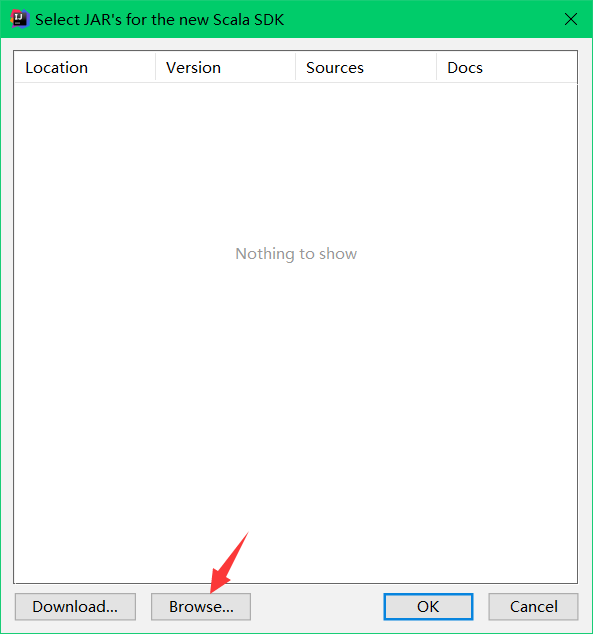

重复第三步增加库的操作

这步不同,选择java

一直ok

这里似乎还可以使用maven依赖,我没搞懂两种方式是否为二者选其一即可

<dependencies>

<dependency>

<groupId>org.apache.spark</groupId>

<artifactId>spark-core_2.12</artifactId>

<version>3.0.0</version>

</dependency>

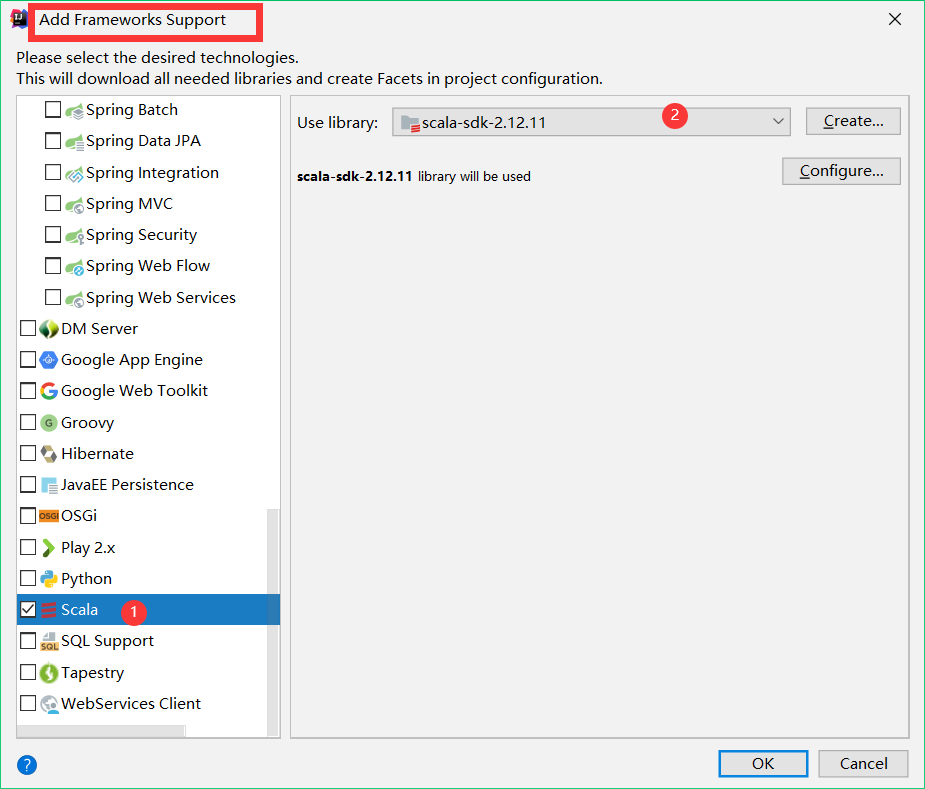

</dependencies>第五步 添加框架支持

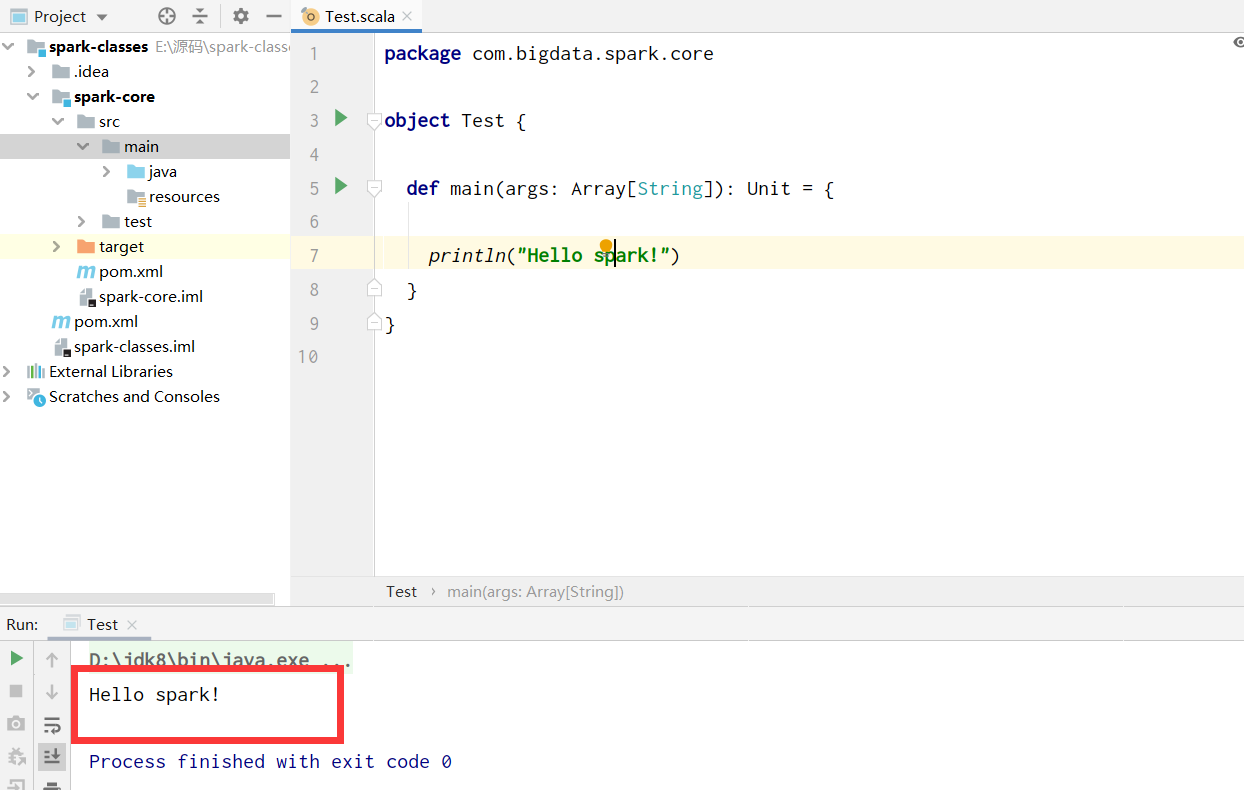

第六步 验证环境是否配置成功

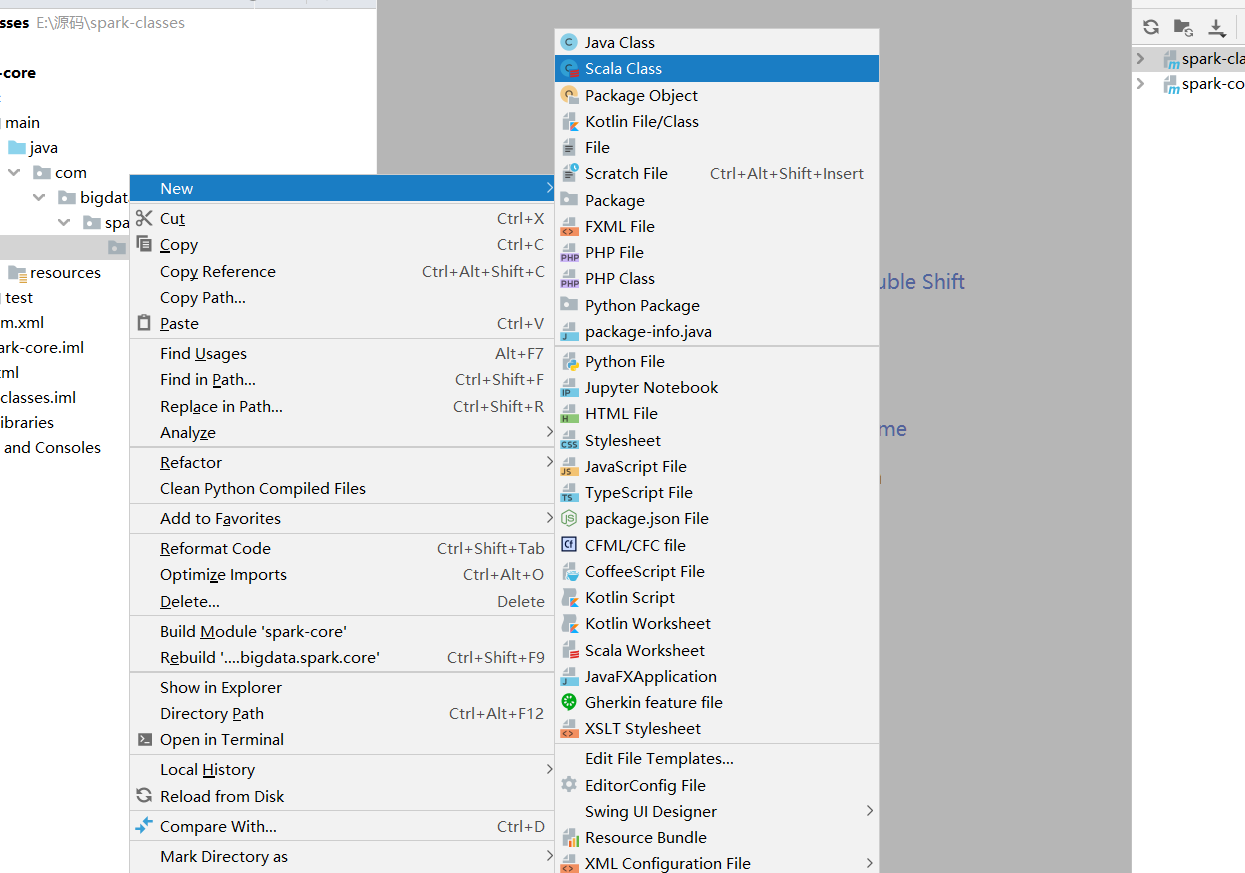

新建Scala class