2.安装Spark与Python练习

作业二:1.安装Spark 2.Python编程练习 3.根据自己的编程习惯搭建编程环境

1.安装Spark

- 检查基础环境hadoop,jdk

- 配置文件

vim /usr/local/spark/conf/spark-env.sh

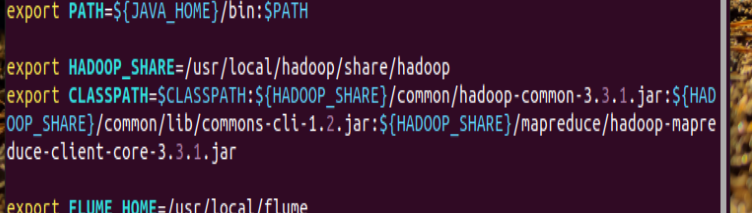

- 环境变量

-

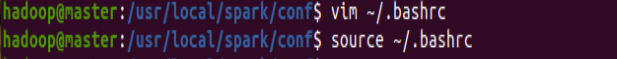

# 修改环境变量 vim ~/.bashrc # 加载修改后的设置,使之生效 source ~/.bashrc

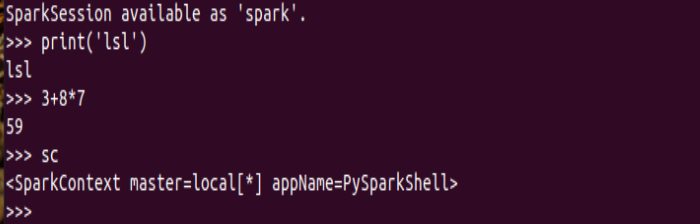

5.试运行Python代码。

(1)执行以下命令启动pyspark.

(2)运行python代码

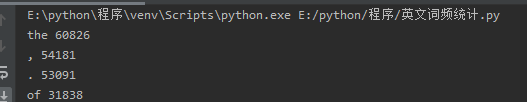

二、Python编程练习:英文文本的词频统计。

-