第三次作业

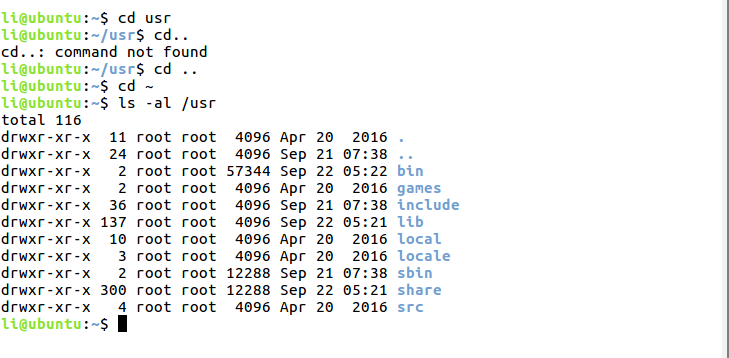

(1)切换到目录 /usr/local

(2)去到目前的上层目录

(3)回到自己的主文件夹

(4)查看目录/usr下所有的文件

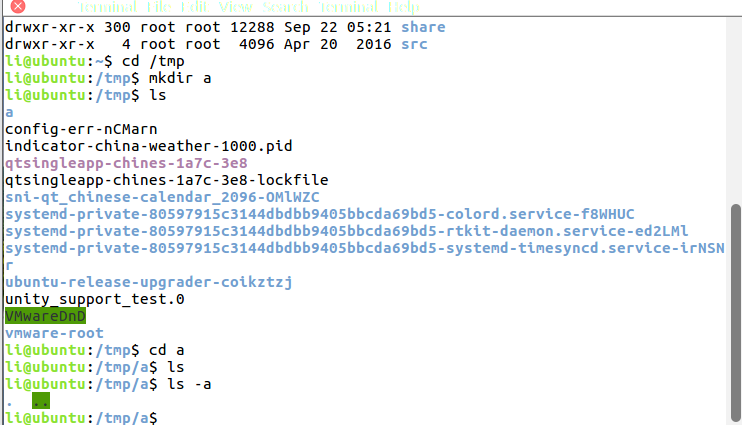

(5)进入/tmp目录,创建一个名为a的目录,并查看有多少目录存在

(6)创建目录a1/a2/a3/a4

(7)将上例创建的目录a(/tmp下面)删除

(8)删除目录a1/a2/a3/a4,查看有多少目录存在

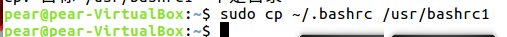

(9)将主文件夹下的.bashrc复制到/usr下,命名为bashrc1

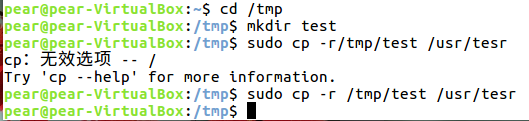

(10)在/tmp下新建目录test,再复制这个目录内容到/usr

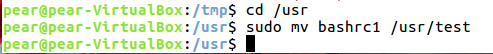

(11)将上例文件bashrc1移动到目录/usr/test

(12)将上例test目录重命名为test2

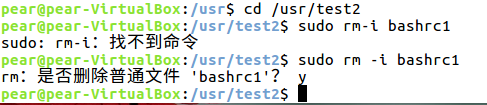

(13)将上例复制的bashrc1文件删除

(14)将上例的test2目录删除

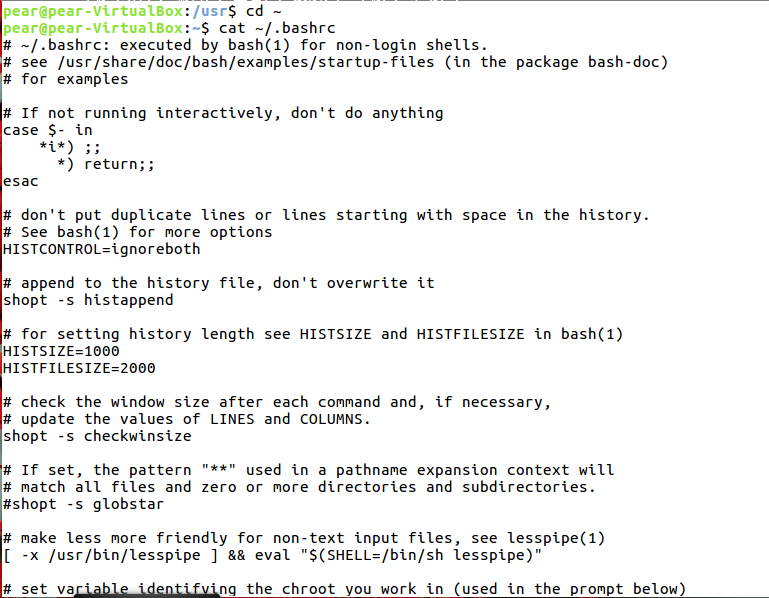

(15)查看主文件夹下的.bashrc文件内容

(16)反向查看主文件夹下.bashrc文件内容

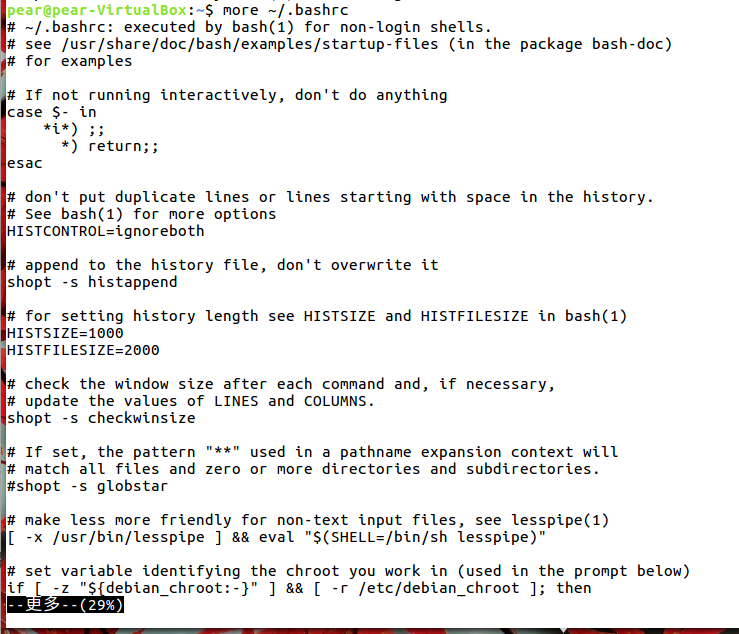

(17)翻页查看主文件夹下.bashrc文件内容

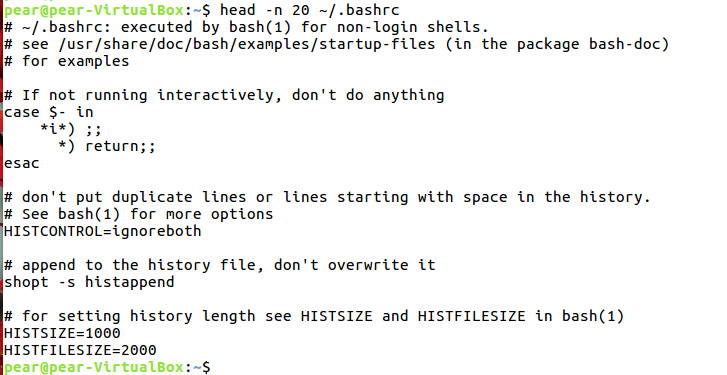

(18)查看主文件夹下.bashrc文件内容前20行

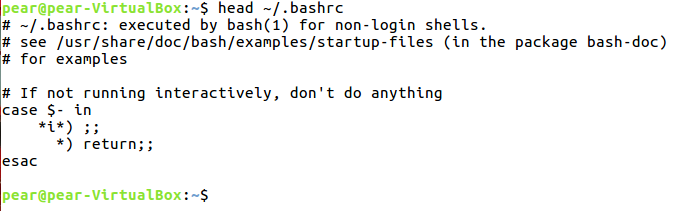

(19)查看主文件夹下.bashrc文件内容,后面50行不显示,只显示前面几行

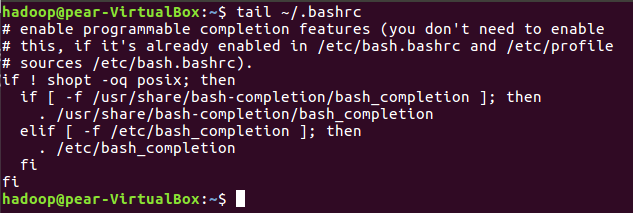

(20)查看主文件夹下.bashrc文件内容最后20行

(21)查看主文件夹下.bashrc文件内容,只列出50行以后的数据

(22)将hello文件所有者改为root帐号,并查看属性

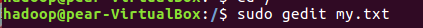

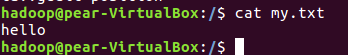

(23)在主文件夹下创建文本文件my.txt,输入文本保存退出。

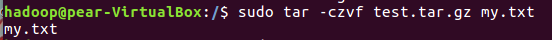

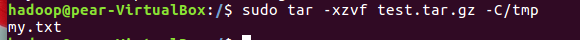

(24)将my.txt打包成test.tar.gz

(25)解压缩到~/tmp目录

(二)熟悉使用MySQL shell操作

( 26)显示库:show databases;

(27)进入到库:use 库名;

(28)展示库里表格:show tables;

(29)显示某一个表格属性:desc 表格名;

(30)显示某一个表格内的具体内容:select *form 表格名;

(31)创建一个数据库:create databases sc;

(32)在sc中创建一个表格:create table if not exists student( );

(33)向表格student中插入具体内容:insert into 表格名(名)values(value);

插入记录包含自己的学号姓名。

(33)显示表的内容。

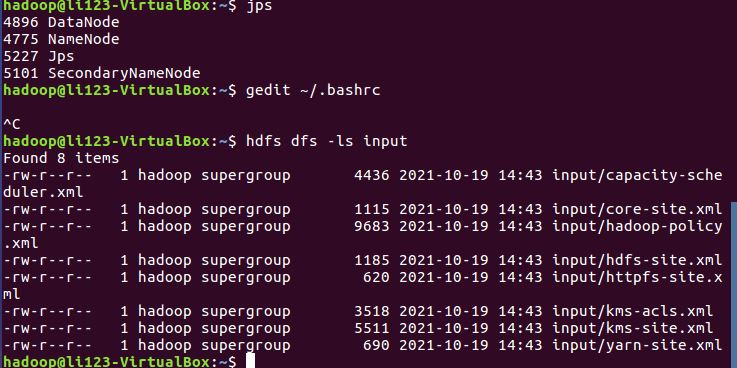

34.对比操作三个文件系统:分别用命令行与窗口方式查看windows,Linux和Hadoop文件系统的用户主目录。

localhost:50070

hdfs dfs -ls /

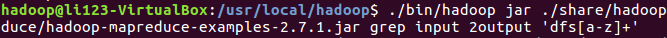

35.一个操作案例:

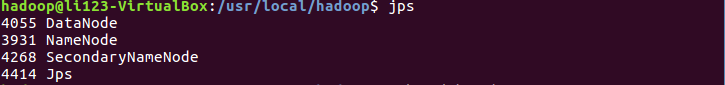

- 启动hdfs

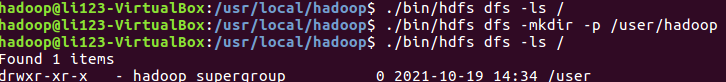

- 查看与创建hadoop用户目录。

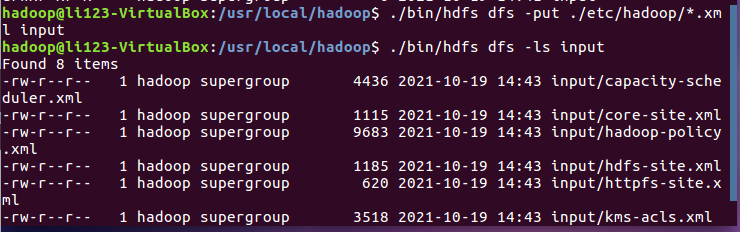

- 在用户目录下创建与查看input目录。

- 将hadoop的配置文件上传到hdfs上的input目录下。

-

运行MapReduce示例作业,输出结果放在output目录下。

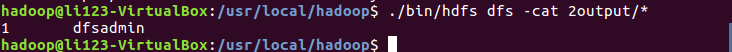

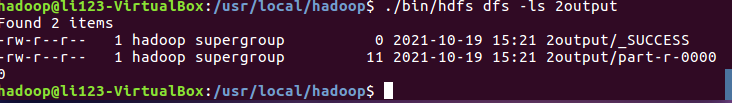

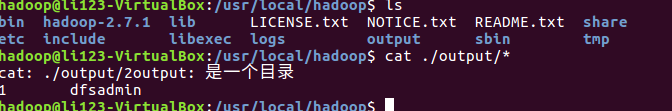

- 查看output目录下的文件。

- 查看输出结果

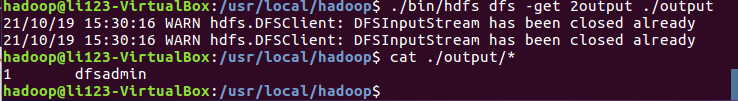

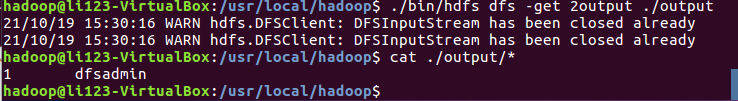

- 将输出结果文件下载到本地。

- 查看下载的本地文件。

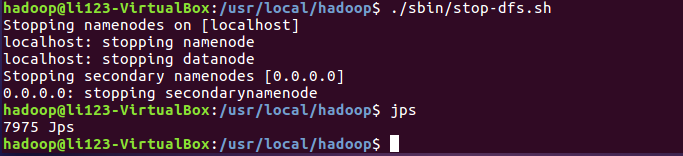

- 停止hdfs

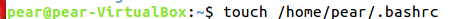

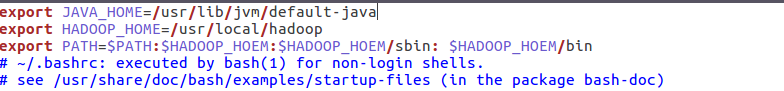

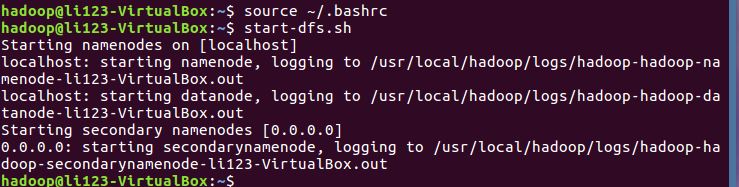

36.设置Hadoop环境变量,在本地用户主目录下启动hdfs,查看hdfs用户主目录,停止hdfs。

(2)让配置文件生效

(3)测试启停与命令不带路径