Anaconda如何安装Scrapy框架:

1、进入anaconda prompt

2、键入:conda install scrapy

3、Proceed ([y]/n)? y

4、等待安装成功

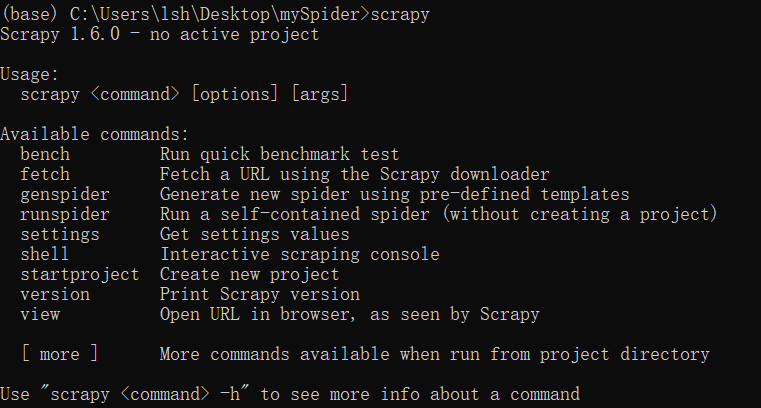

5、键入:scrapy

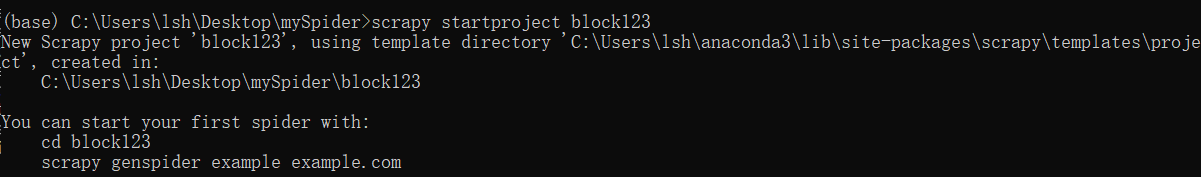

创建scrapy爬虫项目:

1、打开anaconda prompt

2、进入创建项目的目标目录

3、键入:scrapy startproject 项目名称

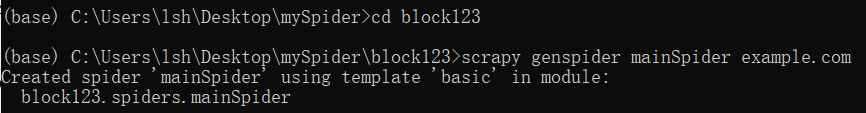

4、按照上面的提示,键入:

cd block123

scrapy genspider 爬虫文件名 网址 (注意:爬虫文件名与爬虫项目名不可重复)

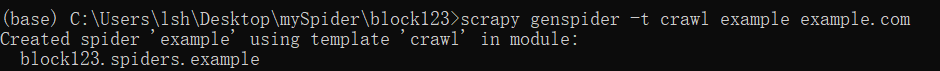

或者指定-t参数,即使用模板:

5、项目创建完成

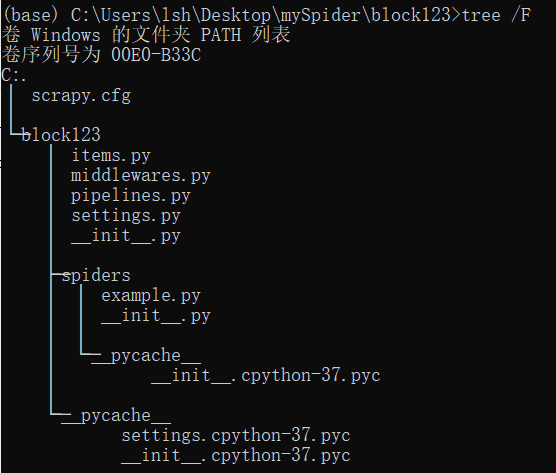

6、键入:tree /F,所需要的编辑的文件即为items.py,spiders/example.py,setting.py

items.py: # define the fields for your item here like:

class Block123Item(scrapy.Item):

item1 = scrapy.Field()

item2 = scrapy.Field()

setting.py: # Scrapy settings for block123 project

例如:USER_AGENT, ROBOTSTXT_OBEY 等等

spiders/example.py,spider1.py,spider2.py...

爬虫主体代码

7、爬虫写好之后,运行并输出到指定文件,键入:scrapy crawl example -o result.json