从逻辑回归到神经网络(一)

逻辑回归

本文主要是给神经网络基础做铺垫,因此只对相关内容进行涉及。主要参考周志华老师的西瓜书以及Andrew NG的深度学习课程。

机器学习领域中监督学习又分回归与分类,但逻辑回归名为回归实为分类算法。主要思想是根据现有数据对分类边界线建立回归公式,以此进行分类。

(1)逻辑回归的三大步

- 构造预测函数

- 建立代价函数

- 优化代价函数

(2)构造预测函数

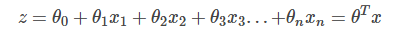

在线性回归中,我们试图学得一个通过属性的线性组合来进行预测的函数,即

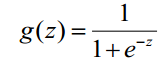

考虑二分类问题,其数据标记为1或0,而上面的线性回归模型产生的是实值,因此我们需要将实值转换为0/1值。而“sigmoid函数”能很好的满足要求

sigmoid fuction:

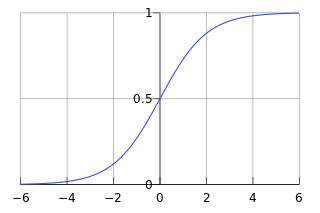

图形如下所示:

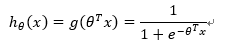

因此数据特征经线性化映射后再经sigmoid非线性映射得到

当h>=0.5时y=1,h<=0.5时y=0。

(3)建立代价函数

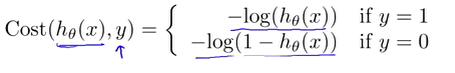

逻辑回归的损失函数(loss fuction)是

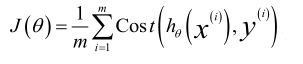

所以代价函数(cost funcition)为

损失函数是针对单个训练样本的;而代价函数是所有训练样本(m个样本)损失函数的平均值,针对整个数据集。

(4)优化代价函数

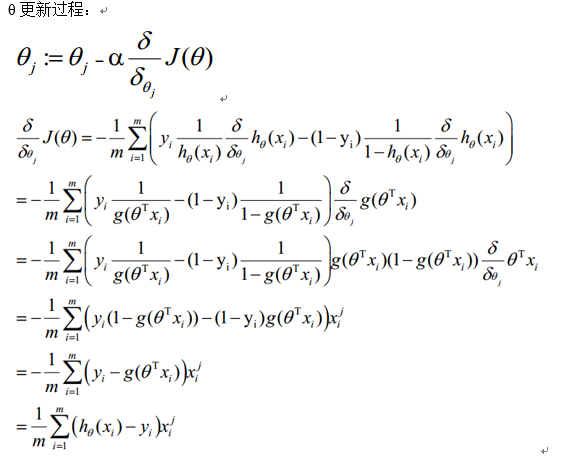

毫无疑问,我们想要做的是使代价函数最小,梯度下降算法可以达到目的。

梯度下降法就是对代价函数进行求梯度,然后不断沿着梯度下降的方向迭代,最终趋于最小值,此时的参数也就是我们寻找的最佳参数。 α为learning rate,步长。

α为learning rate,步长。