CDH5.9新增数据节点

1基础环境配置

操作系统:使用和原集群相同版本的系统作为节点服务器的操作系统。线上环境操作系统为readhat6.5。切忌不能跨操作系统,redhat6和readhat7操作系统无法兼容。

1.1 关闭防火墙和Selinux

1.关闭防火墙 #service iptables stop #service iptables status #chkconfig iptables off #chkconfig --list | grep iptables 2.关闭selinux #setenforce 0 #vi /etc/selinux/config SELINUX=disabled

1.2 ip设置

为了防止单点故障,所有服务器均要求做双网卡绑定,但目前均未设置。

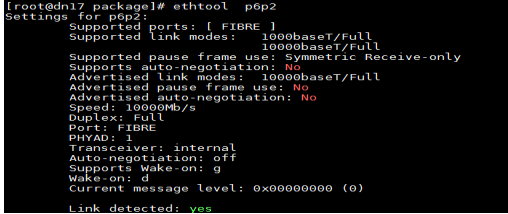

这里查看下网卡的设置;

#cat /etc/sysconfig/network-scripts/ifcfg-p6p2

#查看发现服务器的网卡为万兆网卡

# ethtool p6p2

1.3 配置本地yum源

# mkdir -pv /mnt/dvd #mount -o loop /home/package/Red\ Hat\ Enterprise\ 6.5\ x86_64.iso /mnt/dvd #echo "mount -o loop /home/package/Red\ Hat\ Enterprise\ 6.5\ x86_64.iso /mnt/dvd" >> /etc/rc.local #chmod +x /etc/rc.local #cd /etc/yum.repos.d #cat dvd.repo [cdrom] name=CDROM baseurl=file:///mnt/dvd enabled=1 gpgcheck=0 [HighAvailability] name=HA baseurl=file:///mnt/dvd/HighAvailability enabled=1 gpgcheck=0 [LoadBalancer] name=LB baseurl=file:///mnt/dvd/LoadBalancer enabled=1 gpgcheck=0 [ResilientStorage] name=RS baseurl=file:///mnt/dvd/ResilientStorage enabled=1 gpgcheck=0 [ScalableFileSystem] name=SF baseurl=file:///mnt/dvd/ScalableFileSystem enabled=1 gpgcheck=0 # yum clean all # yum repolist

1.4修改主机名

#vi /etc/sysconfig/network HOSTNAME=dn17 重启服务器生效 #添加/etc/hosts 192.168.121.10 nn01 192.168.121.11 nn02 192.168.121.32 dn17 192.168.121.33 dn18 192.168.121.34 dn19 192.168.121.35 dn20

1.5 ssh免密

如果安装系统时没有配置openssh服务,请按照以下步骤先安装。所有节点安装ssh其他服务,确保ssh-copy-id、scp命令可使用。

[root@nn01 ~]# ssh-copy-id dn17 [root@nn01 ~]# ssh-copy-id dn18 [root@nn01 ~]# ssh-copy-id dn19 [root@nn01 ~]# ssh-copy-id dn20

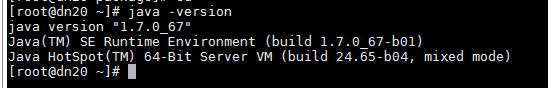

1.6安装jdk

1.先卸载系统自带的open jdk #rpm -qa | grep java 如果有因依赖包rpm卸载不掉的,可以使用yum remove卸载 2.安装oracle版本的jdk #yum install -y oracle-j2sdk1.7-1.7.0+update67-1.x86_64.rpm #配置环境变量 #vi /etc/profile export JAVA_HOME=/usr/java/jdk1.7.0_67-cloudera export CLASSPATH=.:$JAVA_HOME/jre/lib/rt.jar:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar export PATH=$PATH:$JAVA_HOME/bin #source /etc/profile #java -version

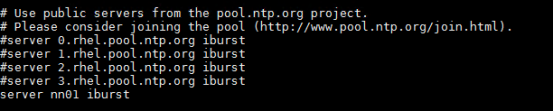

1.7 ntp服务设置

#yum -y install ntp 设置开机启动,并启动服务。 #chkconfig ntpd on #service ntpd start

#数据节点跟管理节点同步 #vi /etc/ntp.conf server nn01 iburst

#service ntpd restart

#由于ntp服务同步需要时间,请等待。

#ntpstat

1.8 系统设置

1.关闭大页面 #echo never > /sys/kernel/mm/transparent_hugepage/defrag #echo never > /sys/kernel/mm/transparent_hugepage/enabled #echo 'echo never > /sys/kernel/mm/redhat_transparent_hugepage/defrag '>> /etc/rc.local #echo 'echo never> /sys/kernel/mm/redhat_transparent_hugepage/enabled' >> /etc/rc.local #chmod +x /etc/rc.local 2.关闭swap,新加节点均需配置。 #echo 'vm.swappiness=0'>>/etc/sysctl.conf #sysctl -p

1.9 磁盘配置

1.根据盘符进行格式化,挂载,注意修改盘符;

#cat t1.sh

#!/bin/bash

for DiskNum in {b,i,s,k,h,d,t,m,c,l,e,f,q,n,a,g,j,u,r,p,o}

do

echo 'y'|mkfs.ext4 /dev/sd$DiskNum

mkdir /data$DiskNum

MOUNT="/dev/sd$DiskNum /data$DiskNum ext4 defaults 0 0"

echo $MOUNT >>/etc/fstab

echo "/dev/sd$DiskNum finished"

done

mount -a

2 数据节点agent部署

2.1 修改数据节点agent配置文件

1.解压安装包

根据线上环境,下载对应的版本,下载地址:

- Cloudera Manager

- 下载地址 : https://archive.cloudera.com/cm5/cm/5/

- CDH安装包

- 下载地址 : http://archive.cloudera.com/cdh5/parcels

#解压安装包

#tar xf /home/package/cloudera-manager-el6-cm5.9.0_x86_64.tar.gz -C /opt

2.增加CM管理用户

#useradd --system --home=/opt/cm-5.9.0/run/cloudera-scm-server/ --no-create-home --shell=/bin/false --comment "Cloudera SCM User" cloudera-scm

3.所有节点中均修改agent配置文件,指定server_host

#vi /opt/cm-5.9.0/etc/cloudera-scm-agent/config.ini

server_host=nn01

4.设置开机自启

#cp /opt/cm-5.9.0/etc/init.d/cloudera-scm-agent /etc/init.d/

#chkconfig cloudera-scm-agent on

#chkconfig --list |grep cloudera

# vim /etc/init.d/cloudera-scm-agent

CMF_DEFAULTS=${CMF_DEFAULTS:-/etc/default}改为=/opt/cm-5.9.0/etc/default

5.启动 cloudera-scm-agent

#/etc/init.d/cloudera-scm-agent start

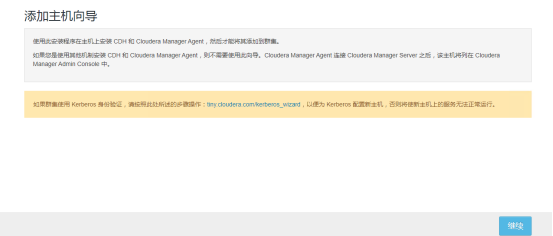

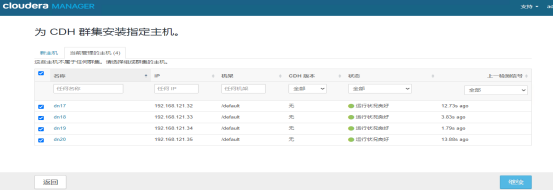

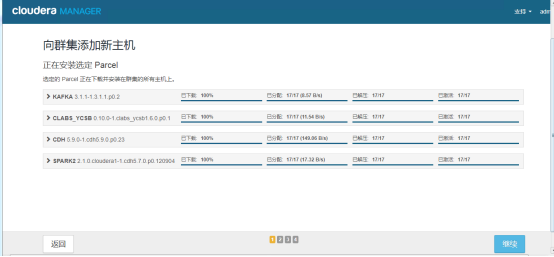

2.2 新加集群节点

登录cm界面

点击主机-->所有主机-->向集群添加新主机

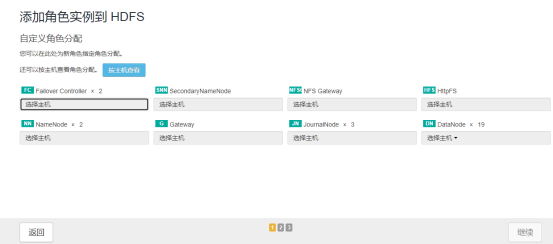

2.3 新增角色

选择需要安装的角色

如果需要其它角色,可以到相应地址上进行添加即可;