原创作品转载请注明出处 + https://github.com/mengning/linuxkernel/

学号 178

本次实验从整体上理解进程创建、可执行文件的加载和进程执行进程切换,重点理解分析fork、execve和进程切换。

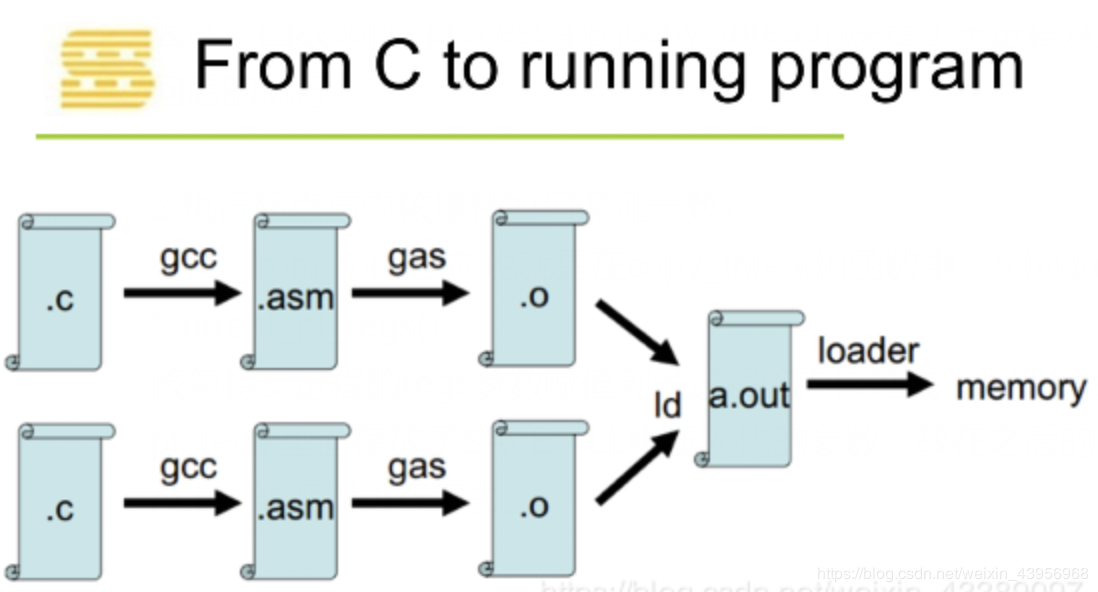

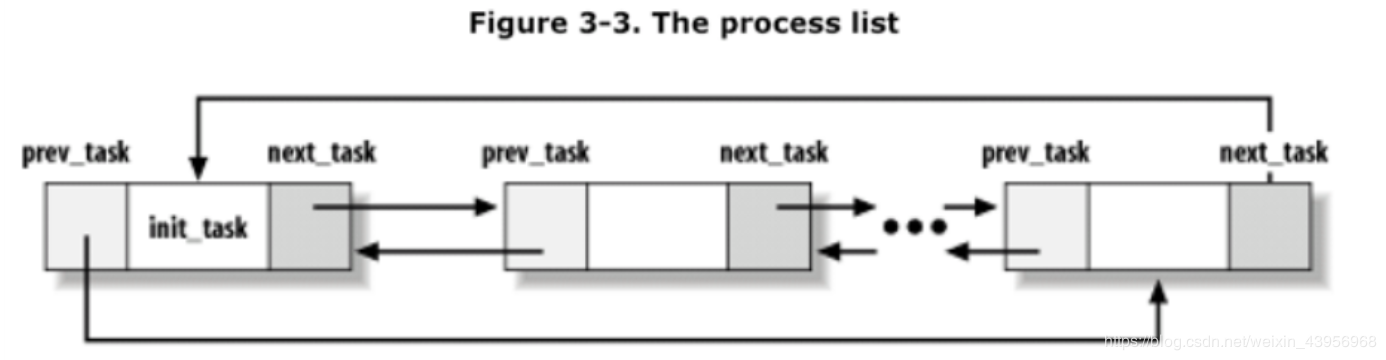

一、阅读理解task_struct数据结构

1、什么是进程

1、进程是程序的一个执行实例

2、进程是正在执行的程序

3、进程是能分配处理器并由处理器执行的实体

为了管理进程,操作系统必须对每个进程所做的事情进行清楚的描述,为此,操作系统使用数据结构来代表处理不同的实体,这个数据结构就是通常所说的进程描述符或进程控制块(PCB)。在Linux中,task_struct其实就是通常所说的PCB。该结构定义位于:/include/linux/sched.h。

2、操作系统的三大功能

1、进程管理

2、内存管理

3、文件系统

3、进程控制块PCB——task_struct

1、进程在TASK_RUNNING下是可运行的,但它有没有运行取决于它有没有获得cpu的控制权,即这个进程有没有在cpu上实际的执行

2、进程的标示pid

3、程序创建的进程具有父子关系,在编程时往往需要引用这样的父子关系。进程描述符中有几个域用来表示这样的关系

4、重要参数

1 volatile long state;//表示进程的当前状态: 2 unsigned long flags; //进程标志: 3 long priority; //进程优先级。 Priority的值给出进程每次获取CPU后可使用的时间(按jiffies计)。优先级可通过系统调用sys_setpriorty改变(在kernel/sys.c中)。 4 long counter; //在轮转法调度时表示进程当前还可运行多久。 5 unsigned long policy; //该进程的进程调度策略,可以通过系统调用sys_sched_setscheduler()更改(见kernel/sched.c)。

二、分析fork函数对应的内核处理过程do_fork

fork、vfork和clone三个系统调用都可以创建一个新进程,而且都是通过调用do_fork来实现进程的创建;

具体过程如下:fork() -> sys_clone() -> do_fork() -> dup_task_struct() -> copy_process() -> copy_thread() -> ret_from_fork()。

- 分析do_fork代码

1 long do_fork(unsigned long clone_flags, 2 unsigned long stack_start, 3 unsigned long stack_size, 4 int __user *parent_tidptr, 5 int __user *child_tidptr) 6 { 7 struct task_struct *p; 8 int trace = 0; 9 long nr; 10 11 // ... 12 13 // 复制进程描述符,返回创建的task_struct的指针 14 p = copy_process(clone_flags, stack_start, stack_size, 15 child_tidptr, NULL, trace); 16 17 if (!IS_ERR(p)) { 18 struct completion vfork; 19 struct pid *pid; 20 21 trace_sched_process_fork(current, p); 22 23 // 取出task结构体内的pid 24 pid = get_task_pid(p, PIDTYPE_PID); 25 nr = pid_vnr(pid); 26 27 if (clone_flags & CLONE_PARENT_SETTID) 28 put_user(nr, parent_tidptr); 29 30 // 如果使用的是vfork,那么必须采用某种完成机制,确保父进程后运行 31 if (clone_flags & CLONE_VFORK) { 32 p->vfork_done = &vfork; 33 init_completion(&vfork); 34 get_task_struct(p); 35 } 36 37 // 将子进程添加到调度器的队列,使得子进程有机会获得CPU 38 wake_up_new_task(p); 39 40 // ... 41 42 // 如果设置了 CLONE_VFORK 则将父进程插入等待队列,并挂起父进程直到子进程释放自己的内存空间 43 // 保证子进程优先于父进程运行 44 if (clone_flags & CLONE_VFORK) { 45 if (!wait_for_vfork_done(p, &vfork)) 46 ptrace_event_pid(PTRACE_EVENT_VFORK_DONE, pid); 47 } 48 49 put_pid(pid); 50 } else { 51 nr = PTR_ERR(p); 52 } 53 return nr; 54 }

- do_fork处理了以下内容:

1、调用copy_process,将当期进程复制一份出来为子进程,并且为子进程设置相应地上下文信息。

2、初始化vfork的完成处理信息(如果是vfork调用)

3、调用wake_up_new_task,将子进程放入调度器的队列中,此时的子进程就可以被调度进程选中,得以运行。

4、如果是vfork调用,需要阻塞父进程,知道子进程执行exec。 - 进程的创建

3.1 do_fork()流程

- 首先调用copy_process()为子进程复制出一份进程信息,如果是vfork()则初始化完成处理信息;

- 然后调用wake_up_new_task将子进程加入调度器,为之分配CPU,如果是vfork(),则父进程等待子进程完成exec替换自己的地址空间。

3.2 copy_process()流程

- 首先调用dup_task_struct()复制当前的task_struct,检查进程数是否超过限制;

- 接着初始化自旋锁、挂起信号、CPU 定时器等;

- 然后调用sched_fork初始化进程数据结构,并把进程状态设置为TASK_RUNNING,复制所有进程信息,包括文件系统、信号处理函数、信号、内存管理等;

- 调用copy_thread()初始化子进程内核栈,为新进程分配并设置新的pid。

3.3 dup_task_struct()流程

- 调用alloc_task_struct_node()分配一个 task_struct 节点;

- 调用alloc_thread_info_node()分配一个 thread_info 节点,其实是分配了一个thread_union联合体,将栈底返回给 ti;

- 最后将栈底的值 ti 赋值给新节点的栈。

3.4 copy_thread的流程

- 获取子进程寄存器信息的存放位置

- 对子进程的thread.sp赋值,将来子进程运行,这就是子进程的esp寄存器的值。

- 如果是创建内核线程,那么它的运行位置是ret_from_kernel_thread,将这段代码的地址赋给thread.ip,之后准备其他寄存器信息,退出

- 将父进程的寄存器信息复制给子进程。

- 将子进程的eax寄存器值设置为0,所以fork调用在子进程中的返回值为0.

- 子进程从ret_from_fork开始执行,所以它的地址赋给thread.ip,也就是将来的eip寄存器。

3.5 新进程从ret_from_fork处开始执行,子进程的运行是由这几处保证的

- dup_task_struct中为其分配了新的堆栈

- copy_process中调用了sched_fork,将其置为TASK_RUNNING

- copy_thread中将父进程的寄存器上下文复制给子进程,这是非常关键的一步,这里保证了父子进程的堆栈信息是一致的。

- 将ret_from_fork的地址设置为eip寄存器的值,这是子进程的第一条指令。

问题:如何创建一个新进程

- 通过调用do_fork来实现进程的创建;

- 复制父进程PCB–task_struct来创建一个新进程,要给新进程分配一个新的内核堆栈;

- 修改复制过来的进程数据,比如pid、进程链表等等执行copy_process和copy_thread

- 成功创建新进程

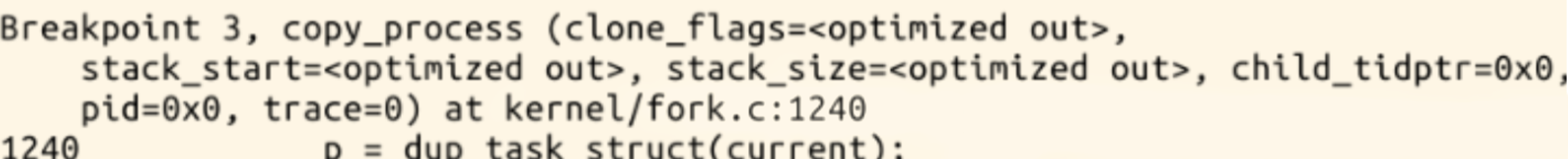

三、使用gdb跟踪分析一个fork系统调用内核处理函数do_fork

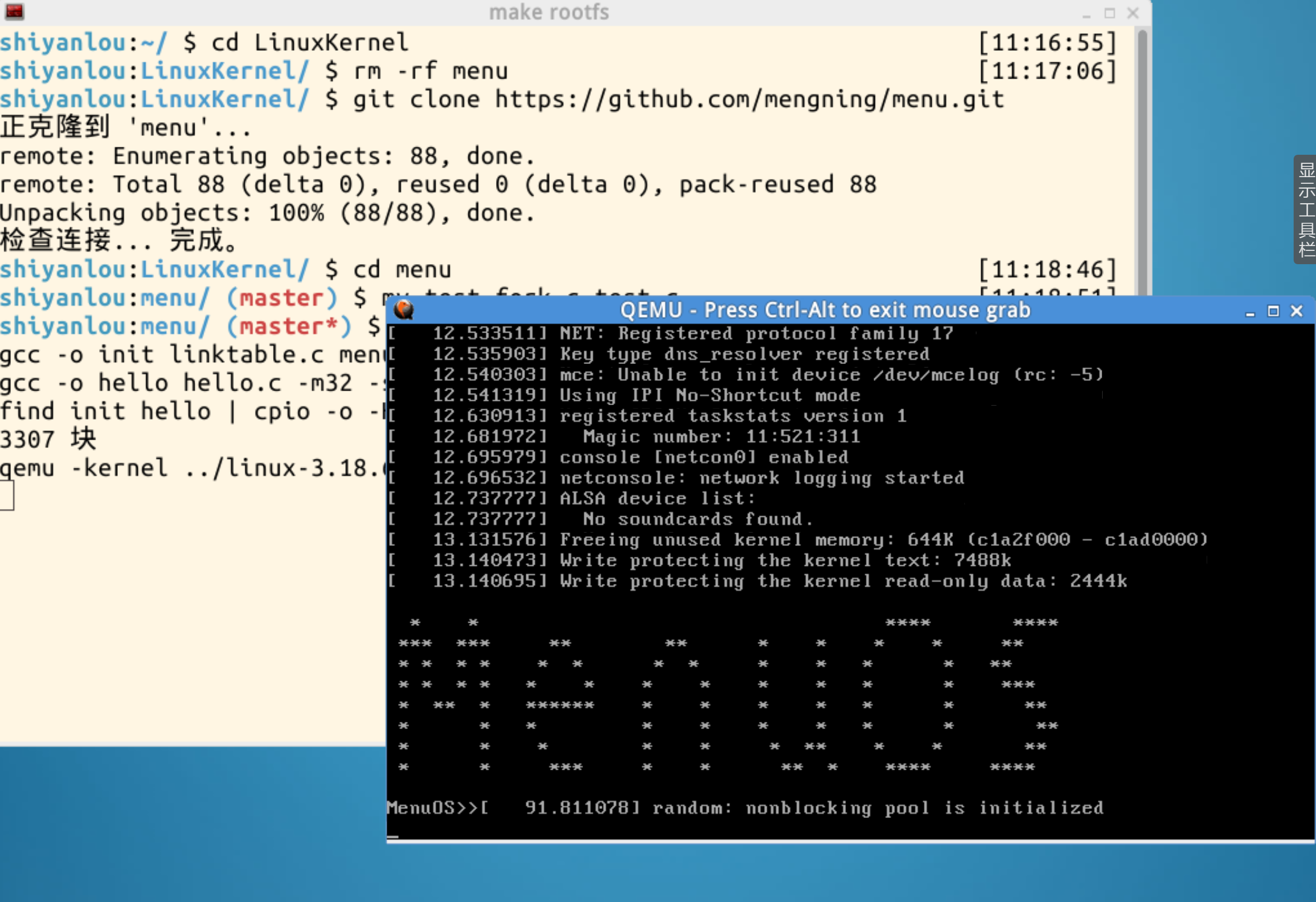

实验环境:实验楼

- 启动MenuOS

cd LinuxKernelrm -rf menugit clone https://github.com/mengning/menu.gitcd menumv test_fork.c test.cmake rootfs

2. 退回到LinuxKernel目录下,进入gdb调试模式(在LinuxKernel文件夹下执行以下命令)

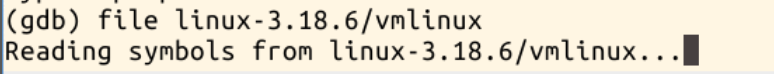

gdbfile linux-3.18.6/vmlinuxtarget remote:1234

- 在以下位置设置断点:

1 b sys_clone 2 b do_fork 3 b dup_task_struct 4 b copy_process 5 b copy_thread 6 b ret_from_fork

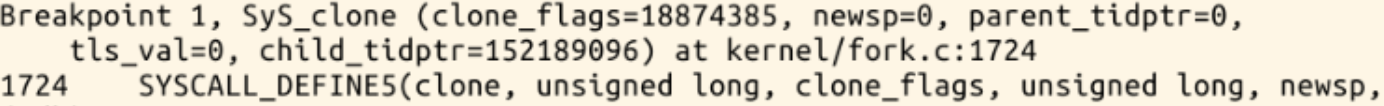

运行后首先停在sys_clone处:

然后到do_fork:

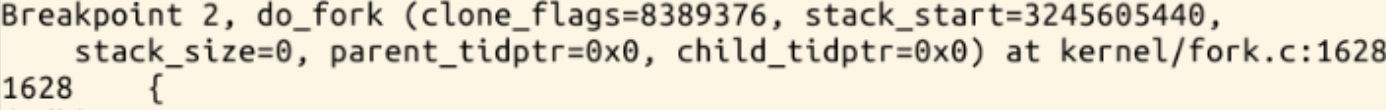

再到copy_process

进入copy_thread

在copy_thread中,我们可以查看p的

问题:新进程是从哪里开始执行的?为什么从哪里能顺利执行下去?执行起点与内核堆栈如何保证一致?

- 新进程是从哪里开始执行的?为什么从哪里能顺利执行下去?

函数copy_process中的copy_thread()

1 int copy_thread(unsigned long clone_flags, unsigned long sp, 2 unsigned long arg, struct task_struct *p) 3 { 4 ... 5 *childregs = *current_pt_regs(); 6 childregs->ax = 0; 7 if (sp) 8 childregs->sp = sp; 9 p->thread.ip = (unsigned long) ret_from_fork; 10 ... 11 }

childregs->ax = 0;这段代码将子进程的 eax 赋值为0

子进程执行ret_from_fork

1 ENTRY(ret_from_fork) 2 CFI_STARTPROC 3 pushl_cfi %eax 4 call schedule_tail 5 GET_THREAD_INFO(%ebp) 6 popl_cfi %eax 7 pushl_cfi $0x0202 # Reset kernel eflags 8 popfl_cfi 9 jmp syscall_exit 10 CFI_ENDPROC 11 END(ret_from_fork)

p->thread.ip = (unsigned long) ret_from_fork;这句代码将子进程的 ip 设置为 ret_form_fork 的首地址,因此子进程是从 ret_from_fork 开始执行的。

因此,函数copy_process中的copy_thread()决定了子进程从系统调用中返回后的执行。

2.执行起点与内核堆栈如何保证一致?

在ret_from_fork之前,也就是在copy_thread()函数中:*childregs = *current_pt_regs();

该句将父进程的regs参数赋值到子进程的内核堆栈,*childregs的类型为pt_regs,里面存放了SAVE ALL中压入栈的参数。故在之后的RESTORE ALL中能顺利执行下去。

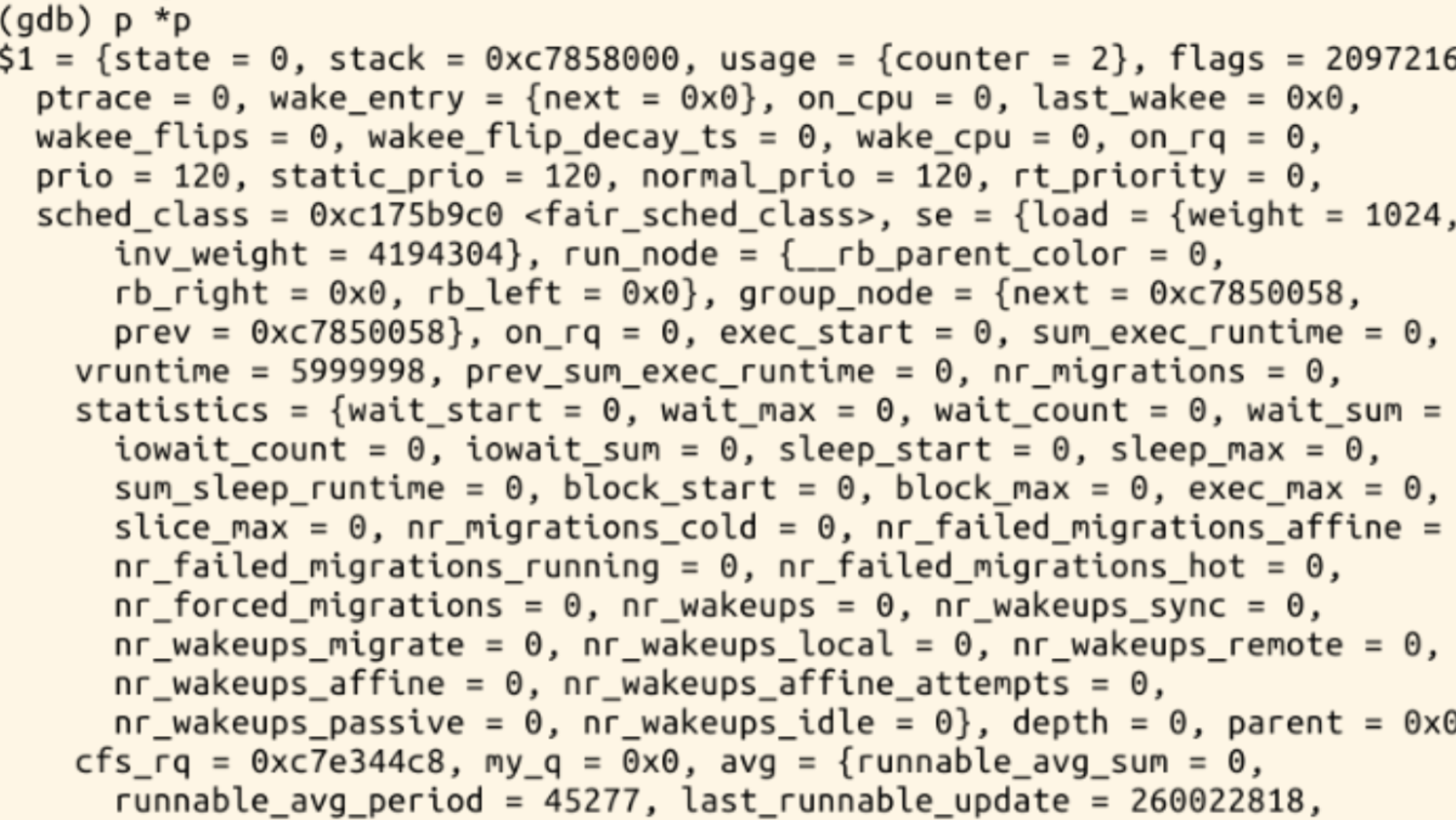

四、理解编译链接的过程和ELF可执行文件格式

1、编译链接的过程

2、ELF可执行文件格式

一个可重定位(relocatable)文件保存着代码和适当的数据,用来和其他的object文件一起来创建一个可执行文件或者是一个共享文件。

一个可执行(executable)文件保存着一个用来执行的程序;该文件指出了exec(BA_OS)如何来创建程序进程映象。

一个共享object文件保存着代码和合适的数据,用来被不同的两个链接器链接。

3、流程图:execve–> do——execve –> search_binary_handle –> load_binary

五、编程使用exec*库函数加载一个可执行文件,动态链接分为可执行程序装载时动态链接和运行时动态链接

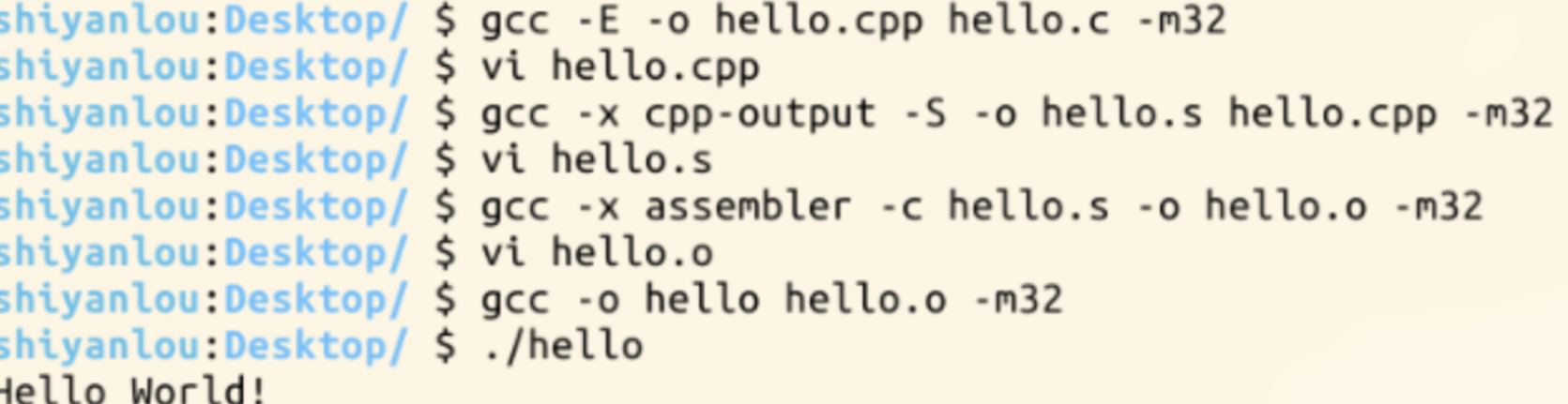

第一步:先编辑一个hello.c

1 #include <stdio.h> 2 #include <stdlib.h> 3 int main() 4 { 5 printf("Hello World!\n"); 6 return 0; 7 }

第二步:生成预处理文件hello.cpp(预处理负责把include的文件包含进来及宏替换等工作)

第三步:编译成汇编代码hello.s

第四步:编译成目标代码,得到二进制文件hello.o

第五步:链接成可执行文件hello,(它是二进制文件)

第六步:运行一下./hello

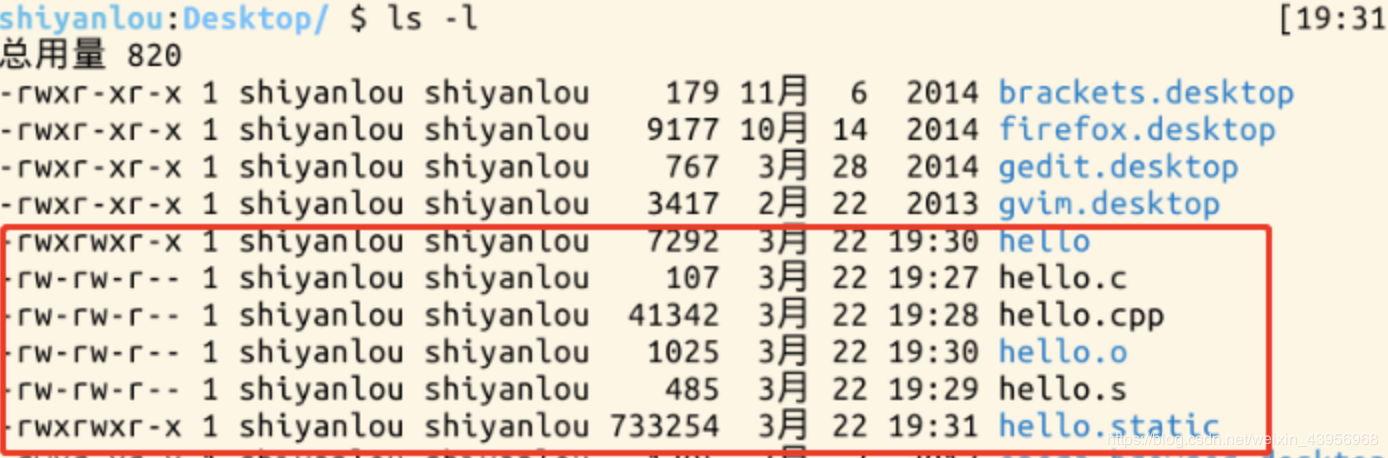

我们也可以静态编译,(是完全把所有需要执行所依赖的东西放到程序内部)

gcc -o hello.static hello.o -m32 -static

hello.static 也是ELF格式文件,运行一下hello.static ./hello.static

![]()

发现hello.static (733254)比 hello (7292)大的多。

- 静态链接方式:在程序运行之前完成所有的组装工作,生成一个可执行的目标文件

- 动态链接方式:在程序已经为了执行被装载入内存之后完成链接工作,并且在内存中一般只保留该编译单元的一份拷贝

动态链接库的两种链接方法:

- 装载时动态链接

- 运行时动态链接

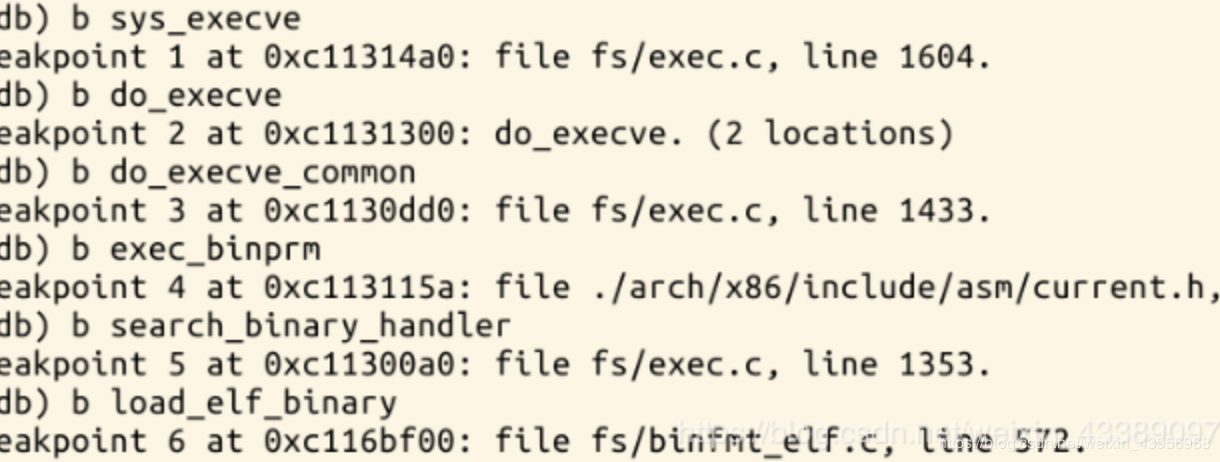

六、使用gdb跟踪分析一个execve系统调用内核处理函数do_execve ,验证您对Linux系统加载可执行程序所需处理过程的理解

1、设置断点

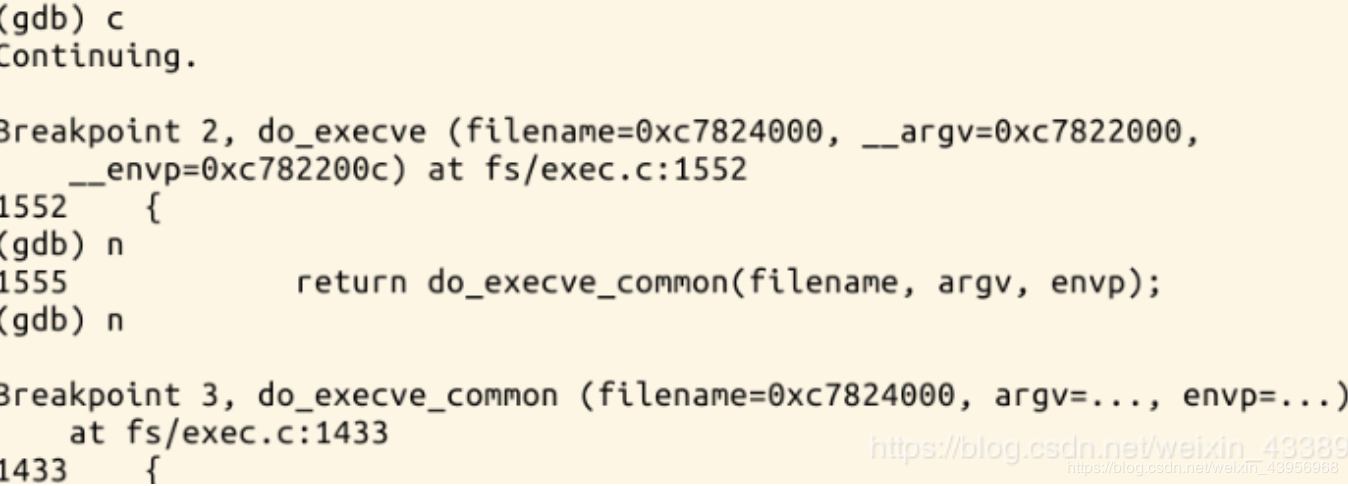

2、中断情况如下

do_execve代码如下:

1 int do_execve(struct filename *filename, 2 const char __user *const __user *__argv, 3 const char __user *const __user *__envp) 4 { 5 struct user_arg_ptr argv = { .ptr.native = __argv }; 6 struct user_arg_ptr envp = { .ptr.native = __envp }; 7 //调用do_execve_common 8 return do_execve_common(filename, argv, envp); 9 }

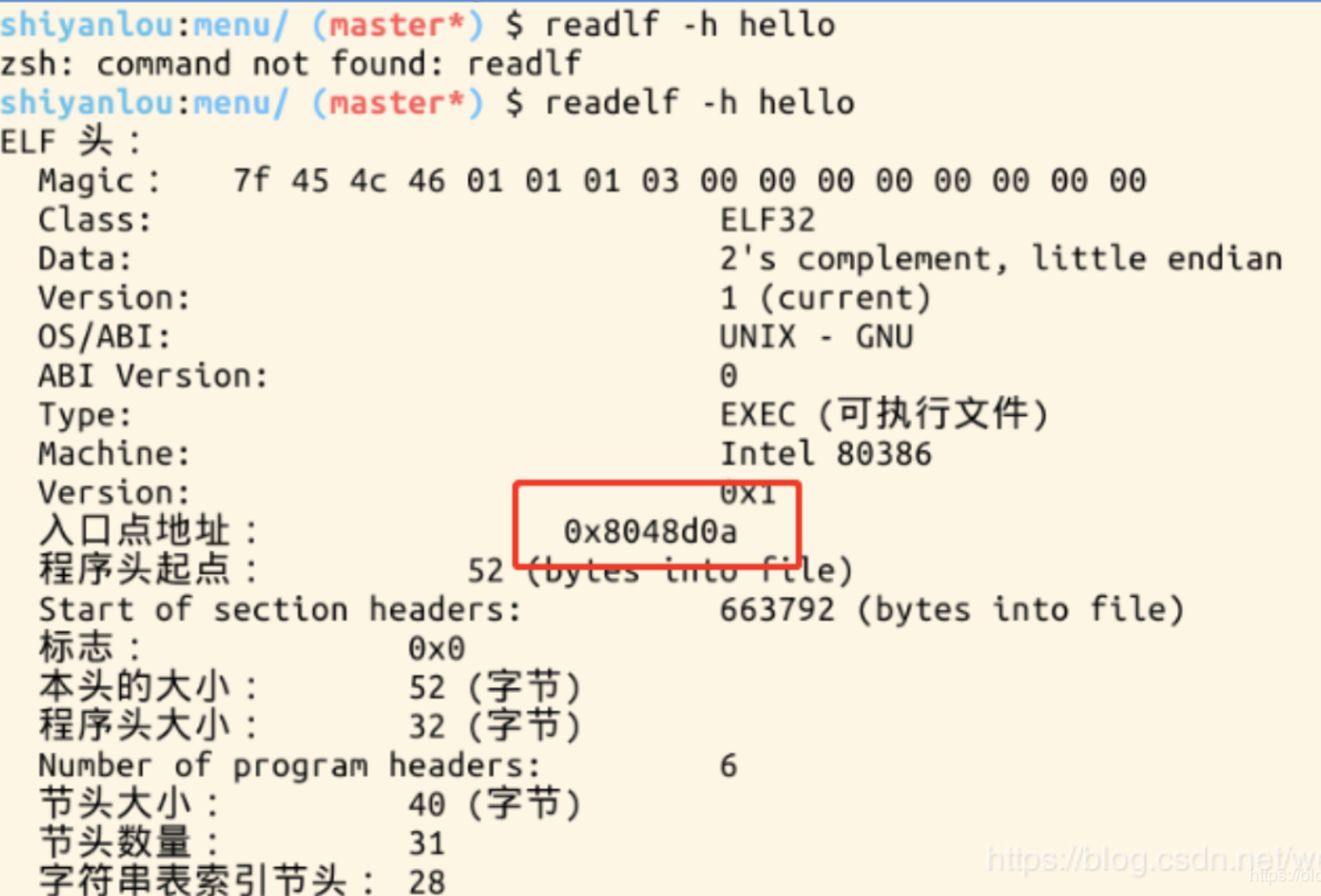

七、特别关注新的可执行程序是从哪里开始执行的?为什么execve系统调用返回后新的可执行程序能顺利执行?对于静态链接的可执行程序和动态链接的可执行程序execve系统调用返回时会有什么不同?

新的可执行程序通过修改内核堆栈eip作为新程序的起点,从new_ip开始执行后start_thread把返回到用户态的位置从int 0x80的下一条指令变成新加载的可执行文件的入口位置。

当执行到execve系统调用时,进入内核态,用execve()加载的可执行文件覆盖当前进程的可执行程序。当execve系统调用返回时,返回新的可执行程序的执行起点(main函数),所以execve系统调用返回后新的可执行程序能顺利执行。execve系统调用返回时,如果是静态链接,elf_entry指向可执行文件规定的头部(main函数对应的位置0x8048***);如果需要依赖动态链接库,elf_entry指向动态链接器的起点。动态链接主要是由动态链接器ld来完成的。

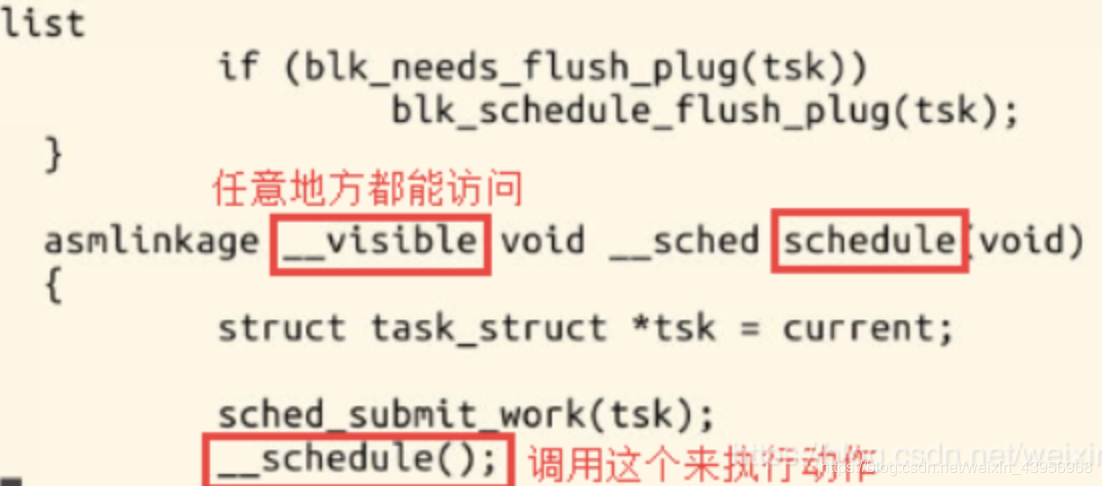

八、理解Linux系统中进程调度的时机,可以在内核代码中搜索schedule()函数,看都是哪里调用了schedule(),判断我们课程内容中的总结是否准确;

调用地方:

- 中断处理过程(包括时钟中断、I/O中断、系统调用和异常)中,直接调用schedule(),或者返回用户态时根据need_resched标记调用schedule()

- 内核线程可以直接调用schedule()进行进程切换,也可以在中断处理过程中进行调度,也就是说内核线程作为一类的特殊的进程可以主动调度,也可以被动调度;

- 用户态进程无法实现主动调度,仅能通过陷入内核态后的某个时机点进行调度,即在中断处理过程中进行调度。

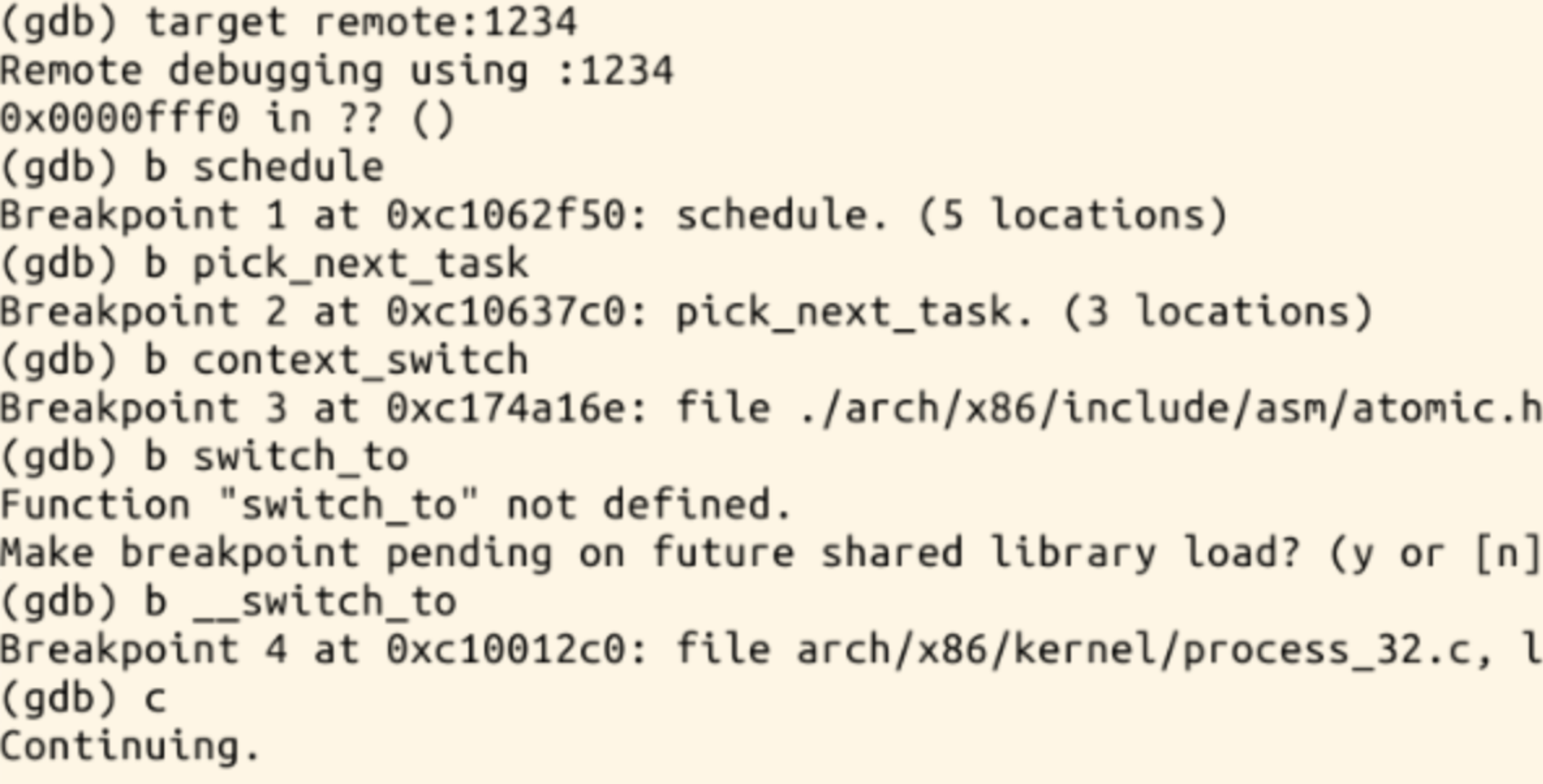

九、使用gdb跟踪分析一个schedule()函数 ,验证对Linux系统进程调度与进程切换过程的理解

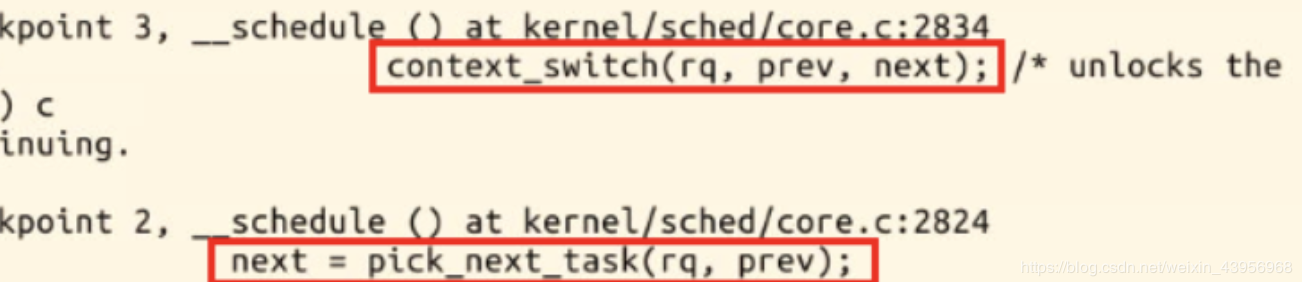

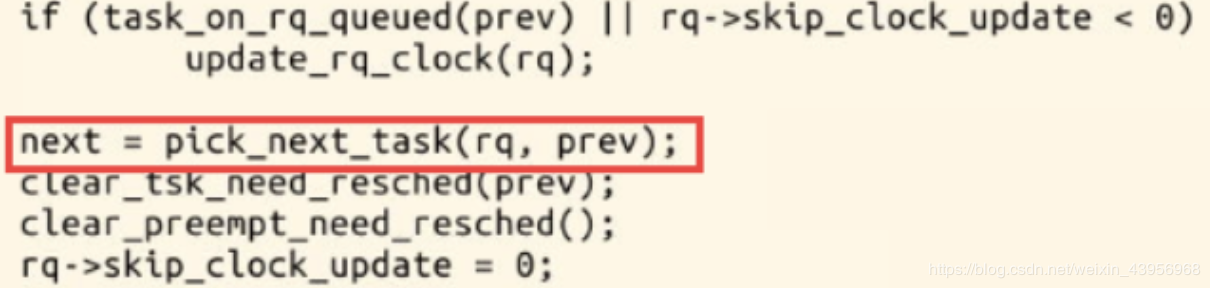

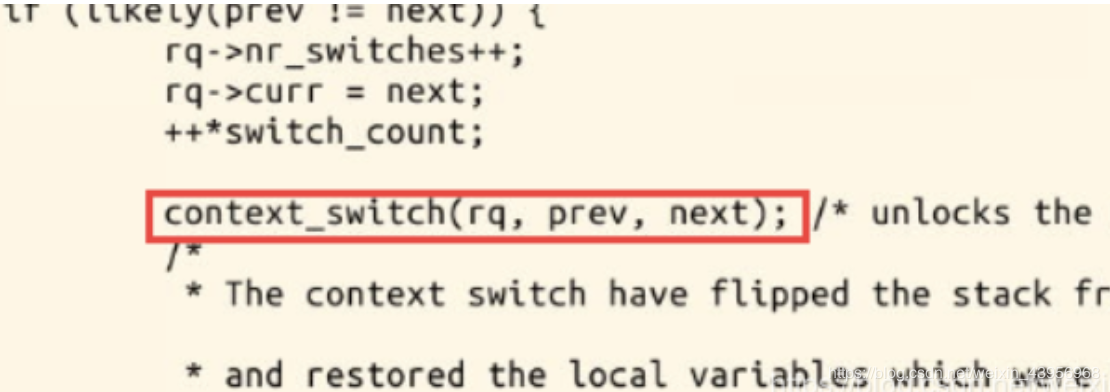

首先设几个断点分别是schedule,pick_next_task,context_switch,__switch_to

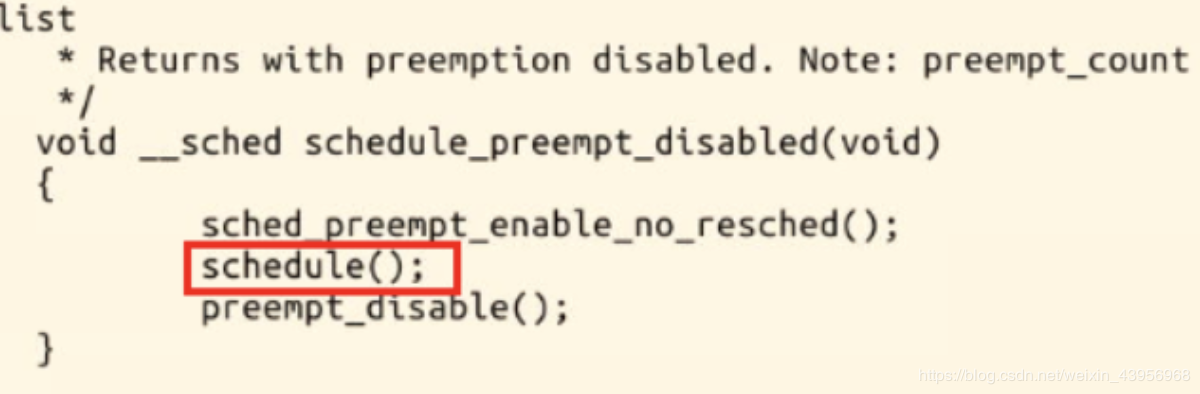

schdule调用和函数

两个重要的函数context_switch和pick_next_task函数都在__schedule函数中

pick_next_task

context_switch

十、分析switch_to中的汇编代码,理解进程上下文的切换机制,以及与中断上下文切换的关系

- 关键函数的调用关系

- schedule() --> context_switch() --> switch_to --> __switch_to()

2. 汇编代码分析:

1 asm volatile("pushfl\n\t" /* 保存当前进程的标志位 */ 2 "pushl %%ebp\n\t" /* 保存当前进程的堆栈基址EBP */ 3 "movl %%esp,%[prev_sp]\n\t" /* 保存当前栈顶ESP */ 4 "movl %[next_sp],%%esp\n\t" /* 把下一个进程的栈顶放到esp寄存器中,完成了内核堆栈的切换,从此往下压栈都是在next进程的内核堆栈中。 */ 5 6 7 "movl $1f,%[prev_ip]\n\t" /* 保存当前进程的EIP */ 8 "pushl %[next_ip]\n\t" /* 把下一个进程的起点EIP压入堆栈 */ 9 __switch_canary 10 "jmp __switch_to\n" /* 因为是函数所以是jmp,通过寄存器传递参数,寄存器是prev-a,next-d,当函数执行结束ret时因为没有压栈当前eip,所以需要使用之前压栈的eip,就是pop出next_ip。 */ 11 12 13 "1:\t" /* 认为next进程开始执行。 */ 14 "popl %%ebp\n\t" /* restore EBP */ 15 "popfl\n" /* restore flags */ 16 17 /* output parameters 因为处于中断上下文,在内核中 18 prev_sp是内核堆栈栈顶 19 prev_ip是当前进程的eip */ 20 : [prev_sp] "=m" (prev->thread.sp), 21 [prev_ip] "=m" (prev->thread.ip), //[prev_ip]是标号 22 "=a" (last), 23 24 /* clobbered output registers: */ 25 "=b" (ebx), "=c" (ecx), "=d" (edx), 26 "=S" (esi), "=D" (edi) 27 28 __switch_canary_oparam 29 30 /* input parameters: 31 next_sp下一个进程的内核堆栈的栈顶 32 next_ip下一个进程执行的起点,一般是$1f,对于新创建的子进程是ret_from_fork*/ 33 : [next_sp] "m" (next->thread.sp), 34 [next_ip] "m" (next->thread.ip), 35 36 /* regparm parameters for __switch_to(): */ 37 [prev] "a" (prev), 38 [next] "d" (next) 39 40 __switch_canary_iparam 41 42 : /* reloaded segment registers */ 43 "memory"); 44 } while (0)

switch_to实现了进程之间的真正切换:

- 首先在当前进程prev的内核栈中保存esi,edi及ebp寄存器的内容。

- 然后将prev的内核堆栈指针ebp存入prev->thread.esp中。

- 把将要运行进程next的内核栈指针next->thread.esp置入esp寄存器中

- 将popl指令所在的地址保存在prev->thread.eip中,这个地址就是prev下一次被调度

- 通过jmp指令(而不是call指令)转入一个函数__switch_to()

- 恢复next上次被调离时推进堆栈的内容。从现在开始,next进程就成为当前进程而真正开始执行

总结

对Linux系统的执行过程的理解:

- 在调度时机方面,内核线程可以直接调用schedule()进行进程切换,也可以在中断处理过程中进行调度,也就是说内核线程作为一类的特殊的进程可以主动调度,也可以被动调度。

- schedule()函数实现进程调度,context_ switch完成进程上下文切换,switch_ to完成寄存器的切换。

- 用户态进程无法实现主动调度,仅能通过陷入内核态后的某个时机点进行调度,即在中断处理过程中进行调度

参考博客:https://blog.csdn.net/weixin_43956968/article/details/88808503