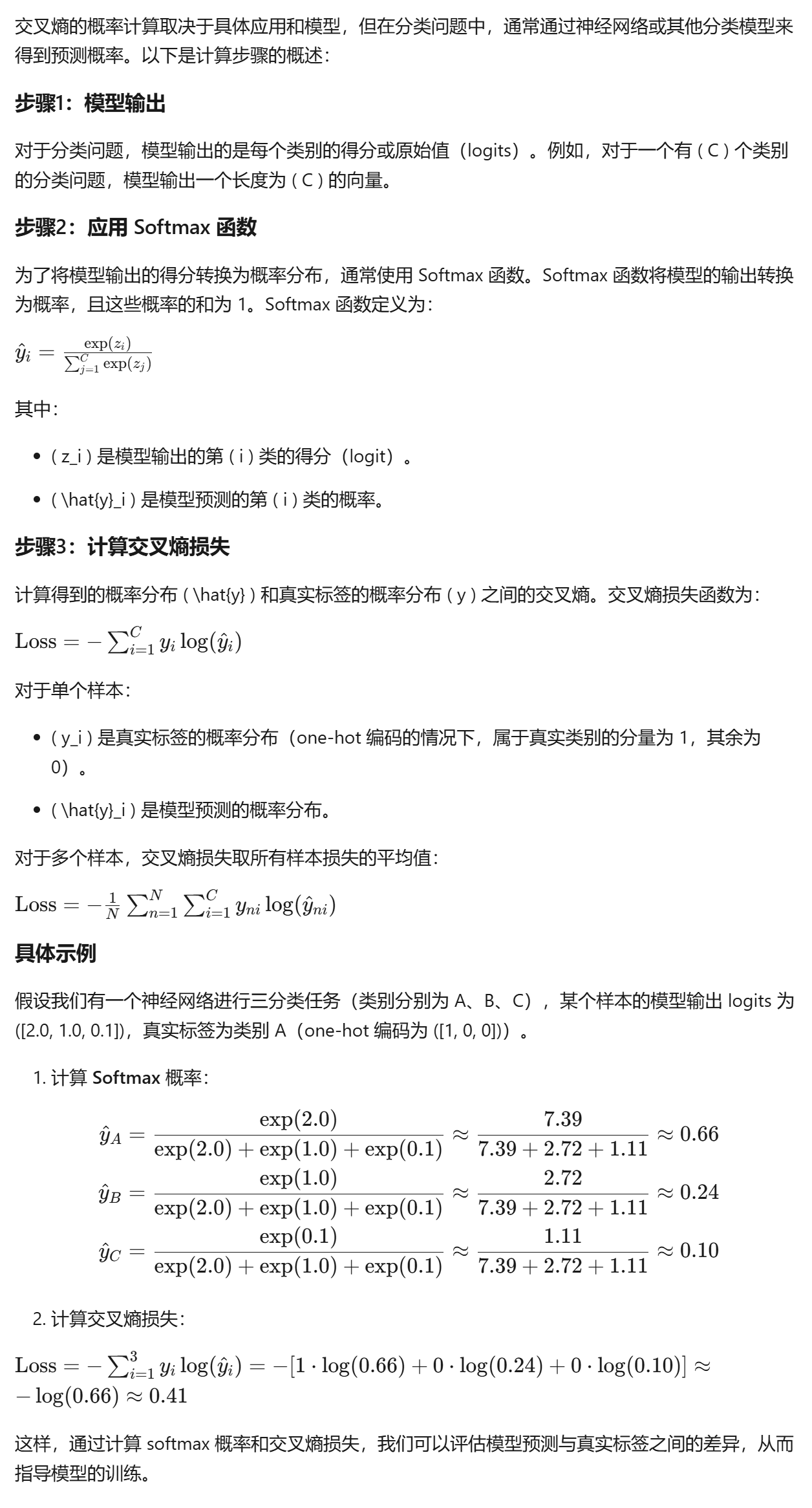

交叉熵的概率计算

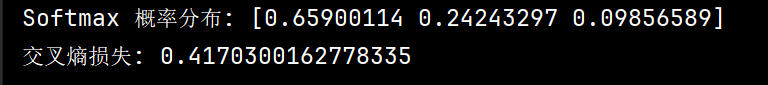

python代码如下:

import numpy as np def softmax(logits): """计算softmax概率分布""" exp_logits = np.exp(logits) return exp_logits / np.sum(exp_logits) def cross_entropy_loss(pred_probs, true_labels): """计算交叉熵损失""" return -np.sum(true_labels * np.log(pred_probs)) # 示例:三分类任务的logits和真实标签 logits = np.array([2.0, 1.0, 0.1]) true_labels = np.array([1, 0, 0]) # 类别 A 的 one-hot 编码 # 计算 softmax 概率分布 pred_probs = softmax(logits) print(f"Softmax 概率分布: {pred_probs}") # 计算交叉熵损失 loss = cross_entropy_loss(pred_probs, true_labels) print(f"交叉熵损失: {loss}")

运行结果如下:

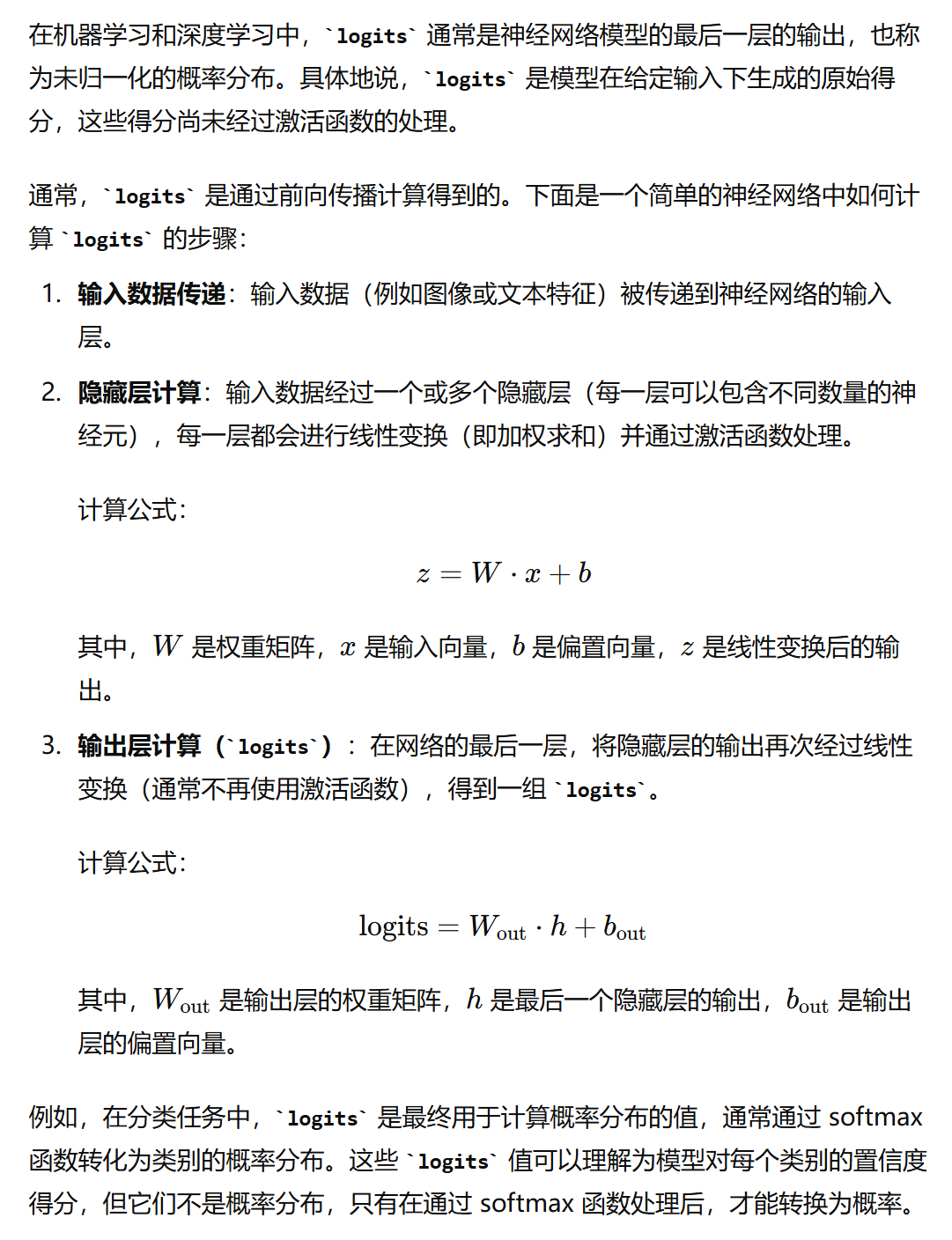

logits一般怎么计算

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 【译】Visual Studio 中新的强大生产力特性

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义