(2018, IJCAI, Yiping Song et al.)An Ensemble of Retrieval-Based and Generation-Based Human-Computer Conversation Systems笔记

论文提出了 :一种 检索式对话 与 生成式对话 结合的方法,主要用于单轮对话。

动机

把 检索式对话 与 生成式对话 优点结合起来。

* 检索式对话的优点是,只要语料库足够大,就能找到信息量丰富、对用户有帮助的回答,缺点是,它会受限于语料库的丰富程度,而且找到的回答是固定,不一定是一个正常的、合适的回答。

* 生成式对话的优点是,回答是生成的,比较灵活,缺点是,它容易生成一些通用的、没有什么信息的、对用户帮助不大的回答。

* 作者认为,检索式对话 与 生成式对话 可以相辅助,得到 灵活且对用户有帮助的回答

基本思路

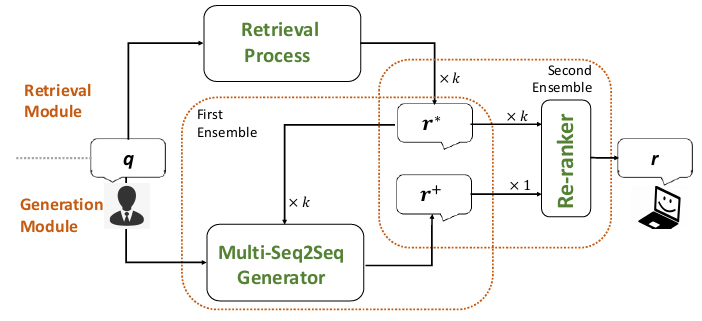

论文方法包括3个模块:检索模块Retrieval Process、生成模块Multi-Seq2Seq Generator、重排序模块Re-ranker,算法步骤是:

1. 检索模块Retrieval Process:通过 现成的检索系统lucene 检索出 \(k\)个问答对,这\(k\)个问答对的问题 与 用户问题最相近

2. 生成模块Multi-Seq2Seq Generator:\(k\) 个问答对的回答 与 用户问题 输入到一个end2end生成模型Multi-Seq2Seq Generator,生成回答

3. 重排序模块Re-ranker:对回答进行评分,选出最佳的回答。参加评分的回答包括 Retrieval Process中\(k\)个问答对的回答,和 Multi-Seq2Seq Generator生成的回答

生成模块Multi-Seq2Seq Generator

Multi-Seq2Seq Generator采用多源seq2seq的方式,并在其中加入两种attention机制、copy mechanism机制

- 多源seq2seq:用多个encoder,分别对 用户问题 与 \(k\)个问答对的回答 进行编码

- 两种attention机制分别是 句子级别的注意力sentence-level attention、字级别的注意力character-level attention

- 句子级别的注意力sentence-level attention:把 多个encoder 最后一个时间步的输出 进行线性变换,得到的向量作为 decoder的初始state

- 字级别的注意力character-level attention:对 多个encoder 每个时间步的输出 进行加权求和,得到的向量作为 decoder每个时间步的context

- copy mechanism机制:对 \(k\)个问答对的回答 进行编码的encoder 每个时间步的输出 进行 copy mechanism

重排序模块Re-ranker

对 回答 与 用户问题 进行评分,判断 回答 与 用户问题 的 合适程度。 主要思路是,对 回答 与 用户问题 进行特征工程,然后通过 GBDT进行 2分类,GBDT输出的概率越高,则表示 回答 越适合 用户问题 。

related work

检索式对话

目前大部分商用的对话系统 是检索式对话

- (2000, AAAI, Isbell et al.)Cobotin LambdaMOO: A social statistics agent

- 用信息检索的方法,从语料库中检索出 相关的 用户问题 和 对应的回答

- (2014, arXiv:1408.6988, Ji et al.)An information retrieval approach to short text conversation (引用量有41)

- 在query-reply matching中 使用 手工特征 和 神经网络

- (2016, SIGIR, Yan et al.)Learning to respond with deep neural networks for retrieval-based human-computer conversation system

- 在query-reply matching中 使用 手工特征 和 神经网络

- (2016, IJCAI, Li et al.)StalemateBreaker: A proactive content-introducing approach to automatic human-computer conversation

- 提出一个random walk-style algorithm,对候选回答进行排序

- 模型融合了其他知识,主要是从知识库中检索得到的、与context实体相关的知识

生成式对话

生成式对话越来越受到 学术界的重视

- (2011, EMNLP, Ritter et al.)Data-driven response generation in social media

- 将 query-reply transformation问题 视为 基于短语的机器翻译问题

- (2014, NIPS, Sutskeveret al.)Sequence to sequence learning with neural networks

- 首次提出 seq2seq模型的论文(发表单位:谷歌)

- (2015, arXiv:1506.05869, Vinyals and Le)A neural conversational model(引用量有292)

- 同样地,在对话系统中 使用了RNN

- (2015, NAACL-HLT, Sordoniet al.)A neural network approach to context-sensitive generation of conversational responses

- 同样地,在对话系统中 使用了RNN

- (2015, ACL, Shanget al.)Neural responding machine for short-text conversation

- 同样地,在对话系统中 使用了RNN

- (2016, AAAI, Serban et al.)Building end-to-end dialogue systems using generative hierarchical neural network models.

- 同样地,在对话系统中 使用了RNN

- (2016, NAACL-ACL, Zoph and Knight)Multi-source neural translation

- 使用 2个encoder 和 1个decoder,将 2种语言 翻译为 一种语言

普遍知道,RNN容易生成短小的、无意义的句子,所以有研究者在这个问题上进行探究

- (2016, NAACL, Li et al.)A diversity-promoting objective function for neural conversation models.

- 提出 一种基于互信息的优化目标,而不是用 传统的最大似然

- (2016, COLING, Mou et al.)Sequence to backward and forward sequences: A content-introducing approach to generative short-text conversation.

- 将 互信息最大的词 或 主题信息 等额外的内容 引入 对话生成中

- (2016, arXiv:1606.08340, Xing et al.) Topic augmented neural response generation with a joint attention mechanism.(引用量有34)

- 将 互信息最大的词 或 主题信息 等额外的内容 引入 对话生成中

- (2017, AAAI, Serban et al.)A hierarchical latent variable encoder-decoder model for generating dialogues.

- 采用变分编码器 捕获 用户问题的信息分布,在生成回答时 从这个信息分布中采样出一个向量,用于生成

- (2017, ACL, He et al.)Generating natural answers by incorporating copying and retrieving mechanisms in sequence-to-sequence learning.

- 在问答任务中使用 知识库

- (2017, ACL, Libovicky and Helcl)Attention strategies for multi-source sequence-to-sequence learning.

- 探索多源输入生成中的不同注意力策略