CRF基础知识以及如何实现Learning,Inference

CRF:Conditional Random Field,即条件随机场。

首先介绍一下基础背景知识。机器学习中的分类问题可以分为硬分类和软分类。硬分类常见的模型有SVM、PLA、LDA等。SVM可以称为max margin classifier,基于几何间隔进行分类。软分类一般分为logistic Regnesstion(概率判别模型)和 Naive Bayes(概率生成模型)。概率判别模型和概率生成模型的区别是,概率判别模型是对P(y|x)进行建模,概率生成模型是对P(x,y)进行建模。

1.概率生成模型

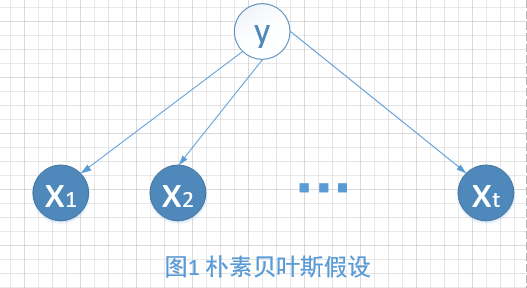

Naive即朴素贝叶斯假设,公式表示就是P(x|y=y0)=∏pi=1P(xi|y=y0),通俗的解释就是给定隐变量的条件下,观测变量之间相互独立,即xi⊥xj|y,i≠j,如图1所示。当y被观测时,阻断了观测变量之间的路径。

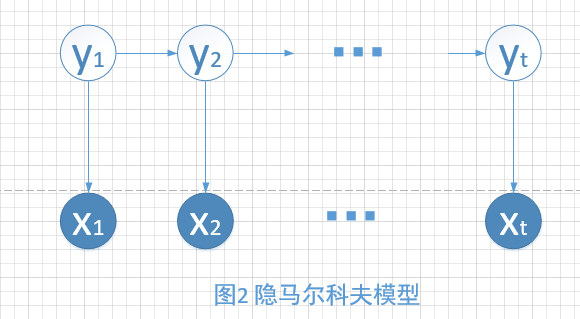

当隐变量一个line的时候,就是HMM(Hidden markov model)模型,如图2所示。

如果大家有学过概率图模型的话,肯定知道有向图中的d-分离。通过有向图的独立性假设,我们可以非常直观的得到HMM的两大假设。即齐次Markov假设和观测独立假设。这两个假设的表达式分别为:

齐次Markov假设:P(yt|y1:t−1,x1:t−1)=P(yt|yt−1)

观测独立假设:P(xt|y1:t,x1:t−1)=P(xt|yt)

2.概率判别模型

比如最大熵模型,采用最大熵思想。比如:给定方差和均值,高斯分布熵最大。。

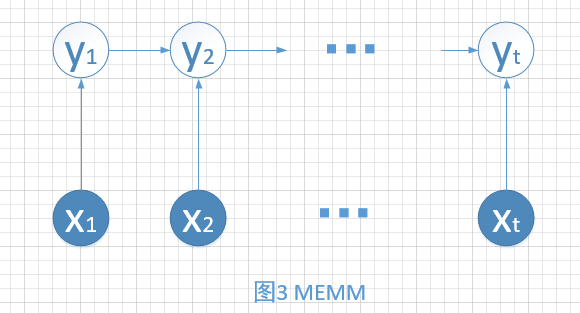

3.两者结合就出现了MEMM:Maximum Entropy Markov Model。这是一种概率判别模型。

进行独立性分析可以发现,该模型打破了HMM的观测独立假设,模型变得更加的合理了。比如,文本标注问题中,上下文对于标注会产生影响。

但是同样存在标注偏差问题,原因是局部归一化。John Lafferty的论文中讲解了该问题为什么存在。用一句话来概括就是:Conditional distribution with low entropy take less notice of observation.

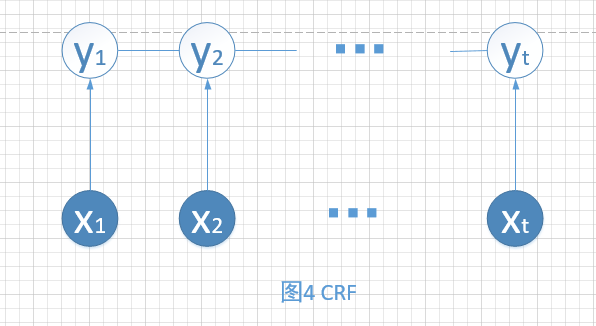

4.Chain-structure CRF

该模型克服了标注偏差问题,CRF的模型如下图4所示,隐变量之间变为无向边,所以是全局归一化。

接下来会写如何利用CRF实现Learning、Inference等任务。

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 开发者必知的日志记录最佳实践

· SQL Server 2025 AI相关能力初探

· Linux系列:如何用 C#调用 C方法造成内存泄露

· AI与.NET技术实操系列(二):开始使用ML.NET

· 记一次.NET内存居高不下排查解决与启示

· 被坑几百块钱后,我竟然真的恢复了删除的微信聊天记录!

· 没有Manus邀请码?试试免邀请码的MGX或者开源的OpenManus吧

· 【自荐】一款简洁、开源的在线白板工具 Drawnix

· 园子的第一款AI主题卫衣上架——"HELLO! HOW CAN I ASSIST YOU TODAY

· Docker 太简单,K8s 太复杂?w7panel 让容器管理更轻松!