[转] Hadoop入门系列(一)Window环境下搭建hadoop和hdfs的基本操作

转自:https://blog.csdn.net/qq_32938169/article/details/80209083

版权声明:本文为博主原创文章,遵循 CC 4.0 BY-SA 版权协议,转载请附上原文出处链接和本声明。 本文链接:https://blog.csdn.net/qq_32938169/article/details/80209083

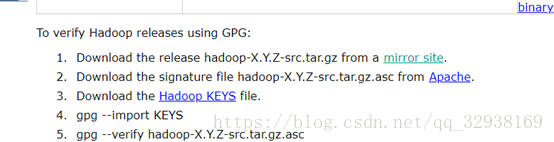

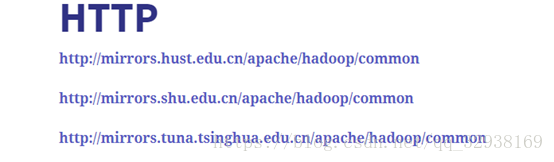

1.去官网下载hadoop。

1>选择镜像网站,选清华的镜像的网站。

2>找个自己喜欢版本的hadoop,下载好将压缩包解压。

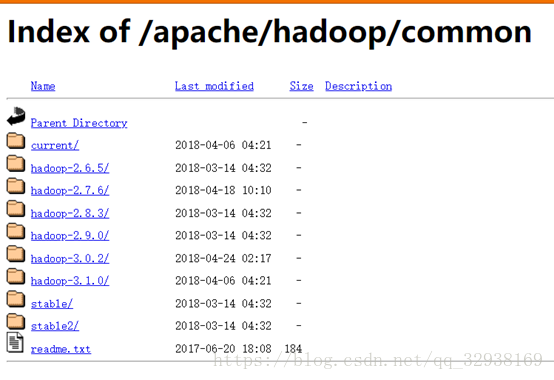

2.找对应版本的winutil。因为hadoop主要基于linux编写,这个winutil.exe主要用于模拟linux下的目录环境。因此hadoop放在windows下运行的时候,需要这个辅助程序才能运行。Github和csdn基本对应版本的都有。下载好解压放入hadoop的bin里,hadoop.dll放入window\Ssytem32\中。

csdn:

https://download.csdn.net/download/cpp_yangzuoshi/10164025

github:

https://github.com/steveloughran/winutils

3.配置hadoop相关xml。

1>首先确保环境变量中有JAVA_HOME,java相关程序,都会默认调用JAVA_HOME,注意“Program Files”因为有空格不被识别。可用PROGRA~1替代。

2>配置4个xml。先进入hadoop\etc\hadoop。

配置core-stie.xml。

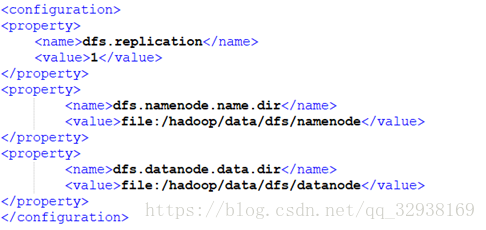

配置hdfs-site.xml。

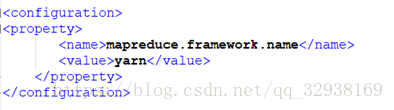

配置mapred-site.xml.template。

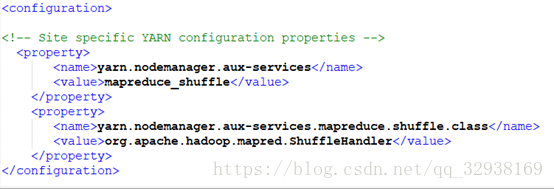

配置yarn-site.xml。

4.至此hadoop就可以用了。

1>将hadoop目录里的bin和sbin添加到环境变量中。

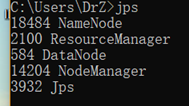

2>打开cmd。输入start-all.cmd,会启动hdfs和yarn服务。jps查看进程。stop-all.cmd停止服务。

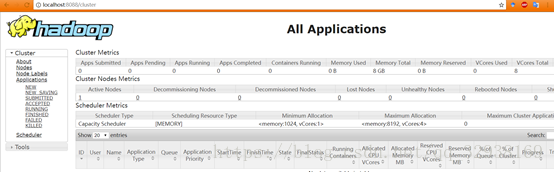

3>Localhost:50070和Localhost:8088查看。

5.注意事项:

1>我是使用的hadoop2.9.0依赖jdk8,jdk9和10均不能正常使用hadoop。

2>使用前hadoop namenode -format

3>jps无法查看java进程的问题。由于更换jdk导致,清除一下Appdata内的Tamp就好了

hdfs的基本操作:(和linux很想)

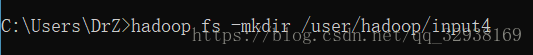

在hdfs中创建目录,注意user是根目录

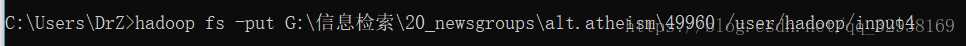

向hdfs上传文件

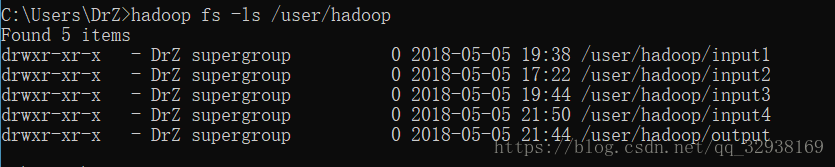

查看hdfs文件目录

以上是转载文章,供自己下次查看

---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------

可能会有的问题:

1、Localhost:50070访问失败

原因一:hadoop3.0相比2.0的端口有改变,请自行查询原文评论区或者官网文档

原因二:观察输入start-all.cmd后跳出的四个界面是否有报错shutdown的。

我的问题出在NameNode,第一次跳出rg.apache.hadoop.hdfs.server.common.InconsistentFSStateException: Directory C:\hadoop\data\dfs\namenode is in an inconsistent state: storage directory does not exist or is not accessible.

我在对应文件夹中创建了namenode后跳出了第二个问题:Namenode is not formatted。

解决方法:在命令行输入 hadoop namenode -format

2、创建目录时不可级联创建,必须一个个创建