Spark安装的配置相关步骤

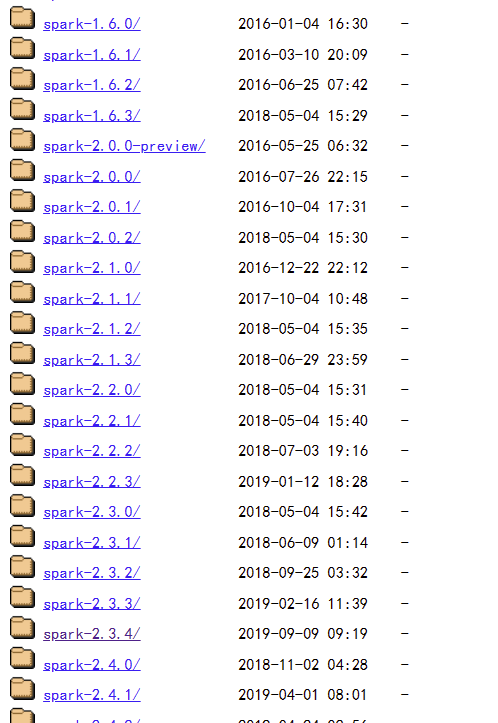

1、Spark下载地址:https://archive.apache.org/dist/spark/

选择自己适合的版本:

点击下载即可:

等待下载完成;

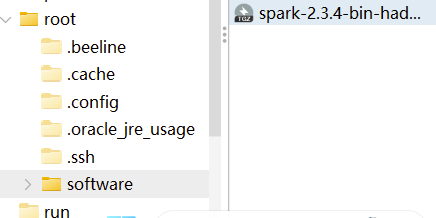

2、将下载好的压缩包放到虚拟机的/root/software文件目录下面

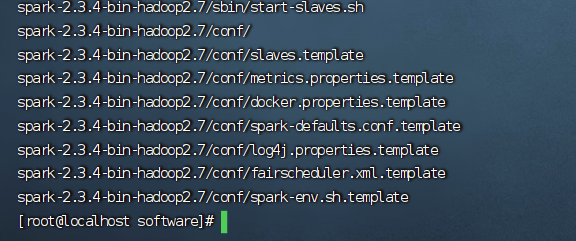

3、将放好位置的压缩包在该目录下解压

tar -zxvf spark-2.3.4-bin-hadoop2.7.tgz

解压成功:

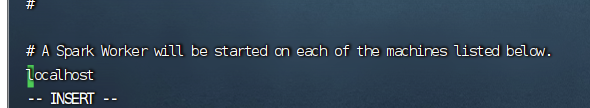

4、拷贝编辑spark文件夹目录下的conf目录下的slaves文件,进行编辑

cd conf

cp slaves.template slaves

vi slaves

进入到slaves文件(划到文件结尾):

若是需要有多个虚拟主机的话,可以在文件末尾的localhost这里,加上各个主机的ip地址,若是只有一个的话,直接localhost就好了!

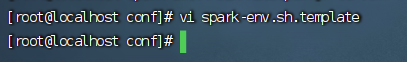

5、拷贝编辑spark-env.sh文件

cp spark-env.sh.template spark-env.sh

vi spark-env.sh

进入编辑模式,将下面的语句命令复制到spark-env.sh文件末尾:

export SPARK_MASTER_HOST=192.168.158.129 //主节点IP

export SPARK_MASTER_PORT=7077 //任务提交端口

export SPARK_WORKER_CORES=2 //每个worker使用2核

export SPARK_WORKER_MEMORY=3g //每个worker使用3G内存

export SPARK_MASTER_WEBUI_PORT=8888//修改spark监视窗口,默认8080

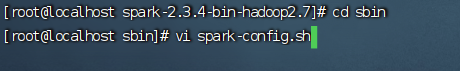

6、修改sbin目录下的spark-config.sh文件

vi spark-config.sh

修改jdk路径为:

export JAVA_HOME=/root/software/jdk180

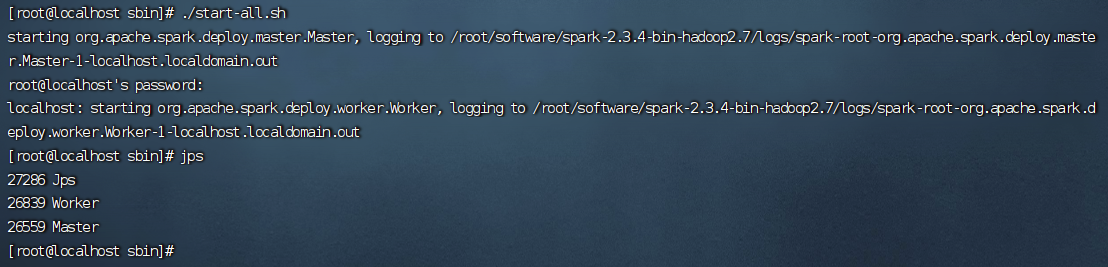

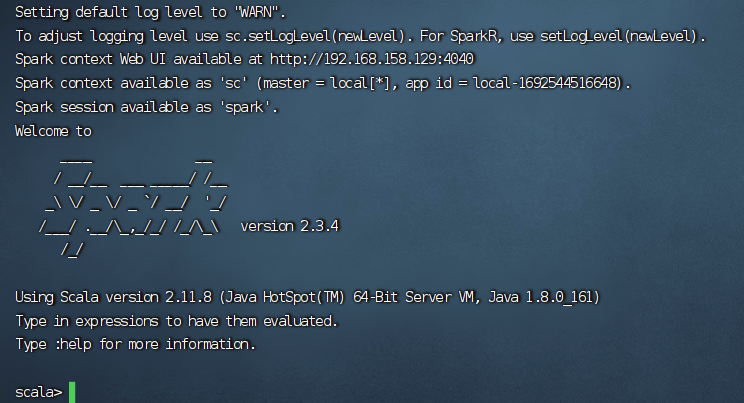

7、启动spark

进入到sbin目录,用这个命令启动spark:

./start-all.sh

然后,再切换到bin目录下,执行这个命令:

./spark-shell

8、网页实现spark

192.168.158.129:4040