MySQL 的 limit 深分页问题

MySQL 中一般使用 limit 子句实现分页功能,语法为limit offset, size

但是当 offset 值过大时,查询就会变得很慢,如limit 1000000, 10。

这是是因为 MySQL 是通过先查询出来 offset+size 条记录,然后再将前面 offset 丢弃,只取剩余部分来实现的。

那么前面的查询其实都是多余的操作,这就导致了性能的浪费。要解决深分页问题,主要考虑减少查询的浪费

一般有两种方案:

- 偏移值

- 覆盖索引 + 子查询

偏移值

偏移值是指采用 where 语句直接定位 offset 的值,然后只需要使用 limit size 子句获取数据

具体由两种做法:

1、是通过前端传递上次查询的主键最大值,

2、是根据前端传递的页码和页大小计算出来偏移值

缺点:

第一种:

要求偏移值字段必须是递增,且只能一页一页的查询,不能跨页,因为跨页时记录的上次最大值就不能用了(适用于 App 端)

第二种:

要求偏移值字段必须是递增且连续的,如果有断层计算就会错误

像这样:

select * from t_bigdata where id > 2000000 order by id asc limit 10;

覆盖索引 + 子查询

给查询条件创建一个辅助索引,通过辅助索引根据分页条件查询主键 id,辅助索引中包含了需要的数据可以直接使用覆盖索引,只深分页索引表,丢弃的只有索引字段,数据量小,性能不会很差。

而且具有一定的通用性,可以进行随机分页,数据字段也不要求连续

缺点:

需要创建辅助索引

sql 示例:

-- 由于版本问题子查询不能用到 limit 这里套了一层表 select * from t_bigdata where id in ( select t.id id from (select id from t_bigdata order by create_time limit 2000000, 10) t ) -- 耗时 3.97s

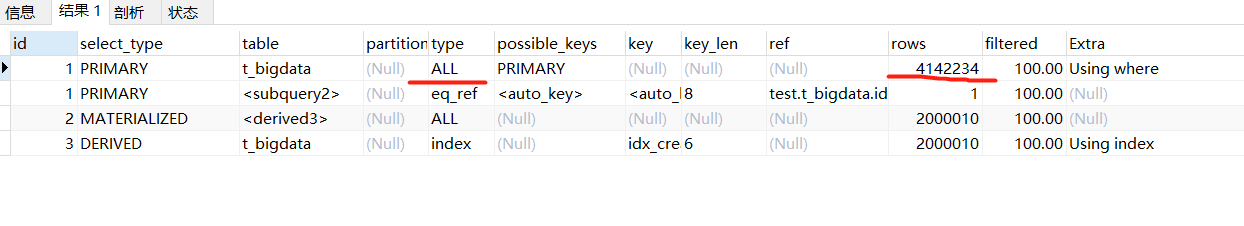

问题:这种写法会导致外层全表扫,比直接查主表还慢

解决方法,使用 join 关联

select * from t_bigdata tb join (select id from t_bigdata order by create_time limit 2000000, 10) t on tb.id = t.id -- 耗时:0.357s

分类:

MySQL

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 震惊!C++程序真的从main开始吗?99%的程序员都答错了

· winform 绘制太阳,地球,月球 运作规律

· 【硬核科普】Trae如何「偷看」你的代码?零基础破解AI编程运行原理

· 上周热点回顾(3.3-3.9)

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人