Spark学习之路- 基础概念

Spark产生背景

在大数据时代,数据有着两个显著的特点:庞大且多样。对于大数据的处理,始终离不开对海量数据的存储和计算问题,阿里云也正是在发展业务的同时解决了海量数据的存储和计算等相关技术难点,方才成为全球知名云厂商。Spark的出现主要解决两个问题:1. MapReduce执行效率低,业务代码编写复杂,学习成本较高,弥补MR自身的不足;2. 支持常见的数据处理模型,减少开发人员的工作量。

Spark基本概述

Apache Spark™是用于大规模数据处理的统一分析引擎。

Spark四特性

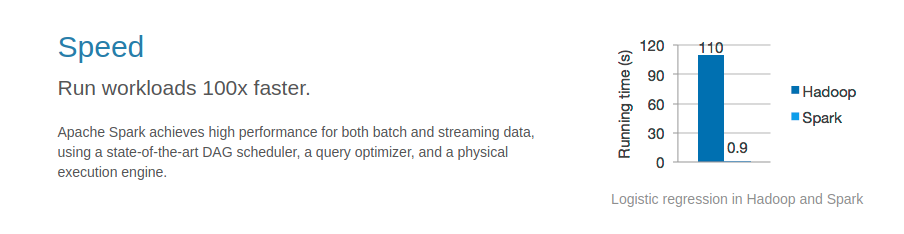

高效性

运行速度提高100倍。

Apache Spark使用最先进的DAG调度器、查询优化器和物理执行引擎,实现了批处理和流式数据的高效执行。

易用性

支持Java, Scala, Python, R, and SQL快速编写应用代码

Spark提供超过80多种高级操作使得可以轻松的并行构建应用程序,你也可以在Scala, Python, R和SQL shells中交互式的使用它所有的功能。

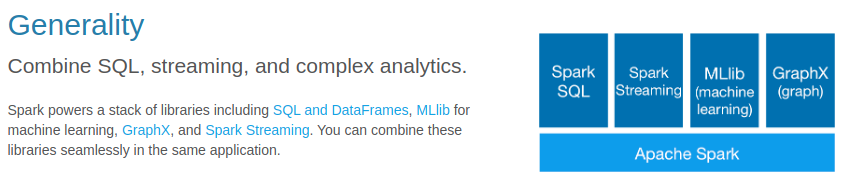

通用性

Spark提供了统一的解决方案。Spark可以用于处理批处理、交互式查询、实时流处理、机器学习和图计算。这些不同的处理都可以在同一个应用中无缝使用。Spark统一的解决方案非常具有吸引力,毕竟任何公司都想用统一的平台去处理遇到的问题,减少开发和维护的人力成本和部署平台的物力成本。

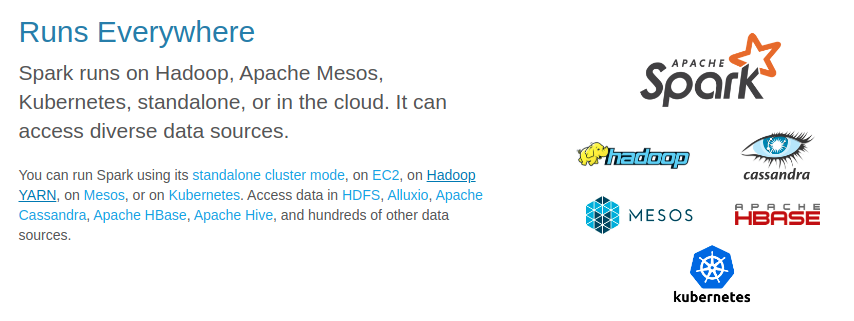

高兼容性

Spark可以非常方便地与其他的开源产品进行融合。比如,Spark可以使用Hadoop的YARN和Apache Mesos作为它的资源管理和调度器,器,并且可以处理所有Hadoop支持的数据,包括HDFS、HBase和Cassandra等。这对于已经部署Hadoop集群的用户特别重要,因为不需要做任何数据迁移就可以使用Spark的强大处理能力。Spark也可以不依赖于第三方的资源管理和调度器,它实现了Standalone作为其内置的资源管理和调度框架,这样进一步降低了Spark的使用门槛,使得所有人都可以非常容易地部署和使用Spark。此外,Spark还提供了在EC2上部署Standalone的Spark集群的工具。

Spark组成部分

Spark组成(BDAS):全称伯克利数据分析栈,通过大规模集成算法、机器、人之间展现大数据应用的一个平台。也是处理大数据、云计算、通信的技术解决方案。

它的主要组件有:

SparkCore:将分布式数据抽象为弹性分布式数据集(RDD),实现了应用任务调度、RPC、序列化和压缩,并为运行在其上的上层组件提供API。

SparkSQL:Spark Sql 是Spark来操作结构化数据的程序包,可以让我使用SQL语句的方式来查询数据,Spark支持 多种数据源,包含Hive表,parquest以及JSON等内容。

SparkStreaming: 是Spark提供的实时数据进行流式计算的组件。

MLlib:提供常用机器学习算法的实现库。

GraphX:提供一个分布式图计算框架,能高效进行图计算。

BlinkDB:用于在海量数据上进行交互式SQL的近似查询引擎。

Tachyon:以内存为中心高容错的的分布式文件系统。

应用场景

腾讯大数据精准推荐借助Spark快速迭代的优势,实现了在“数据实时采集、算法实时训练、系统实时预测”的全流程实时并行高维算法,最终成功应用于广点通pCTR投放系统上。

优酷土豆将Spark应用于视频推荐(图计算)、广告业务,主要实现机器学习、图计算等迭代计算