2.安装Spark与Python练习

一、安装Spark

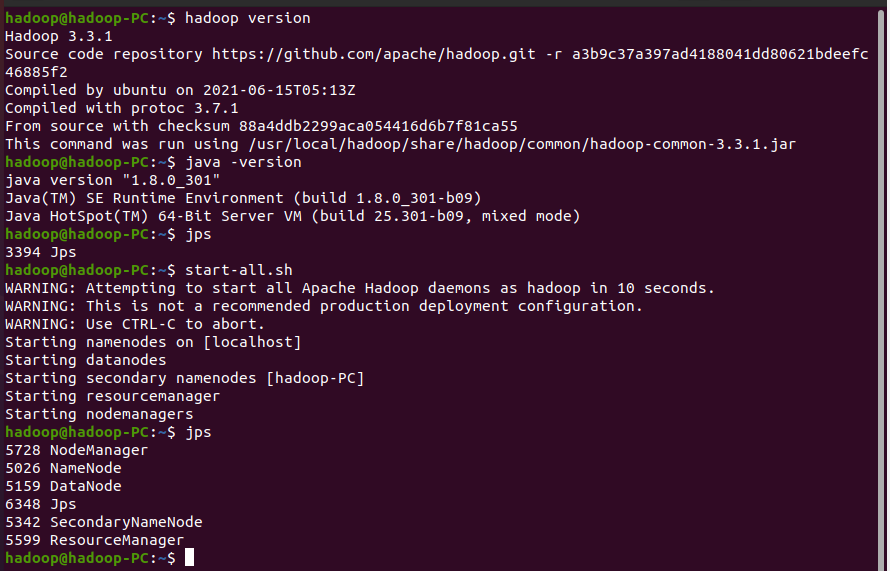

- 检查基础环境hadoop,jdk

- 配置文件、 环境变量

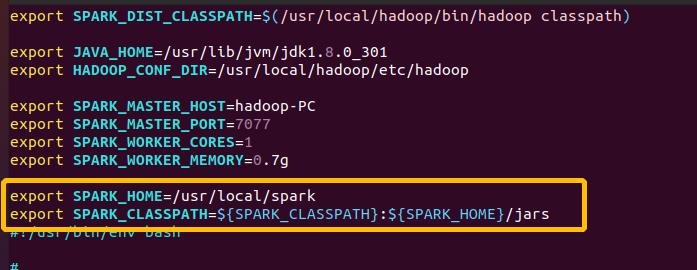

#配置环境 vim /usr/local/spark/conf/spark-env.sh

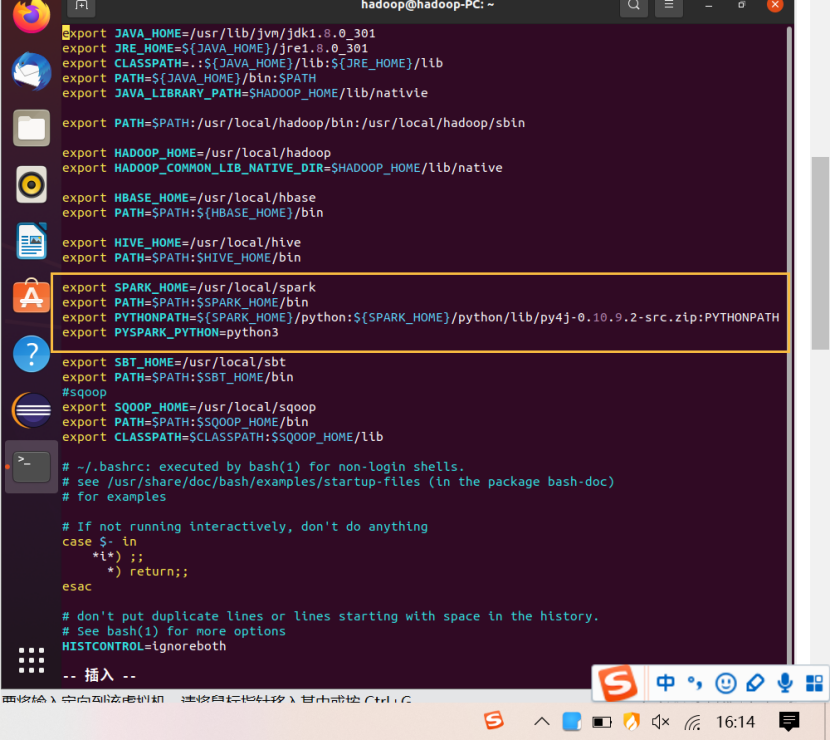

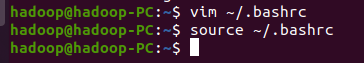

# 修改环境变量 vim ~/.bashrc # 生效 source ~/.bashrc

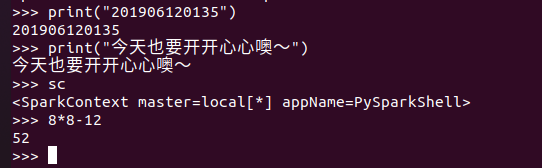

- 试运行python代码

二、Python编程练习:英文文本的词频统计

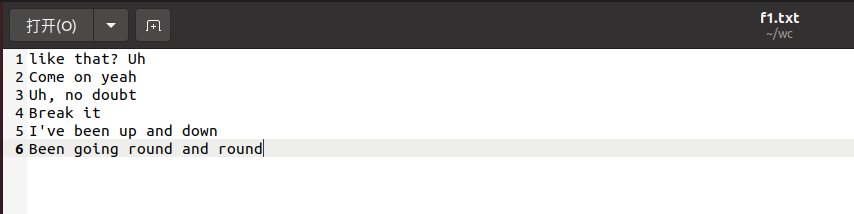

- 准备文本文件

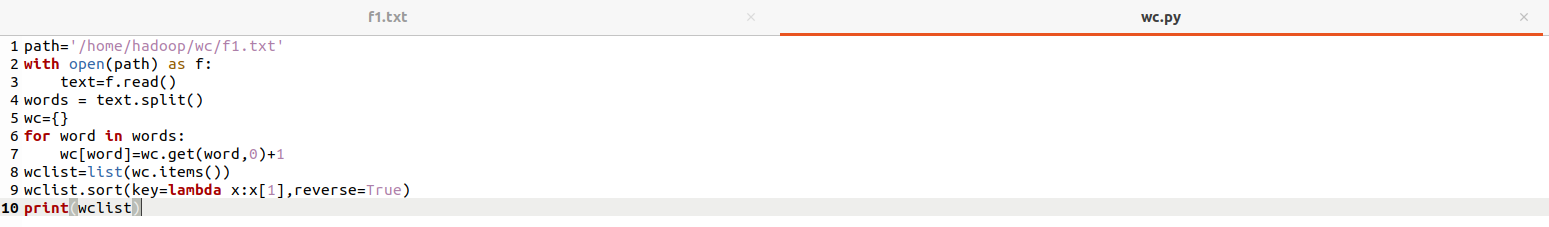

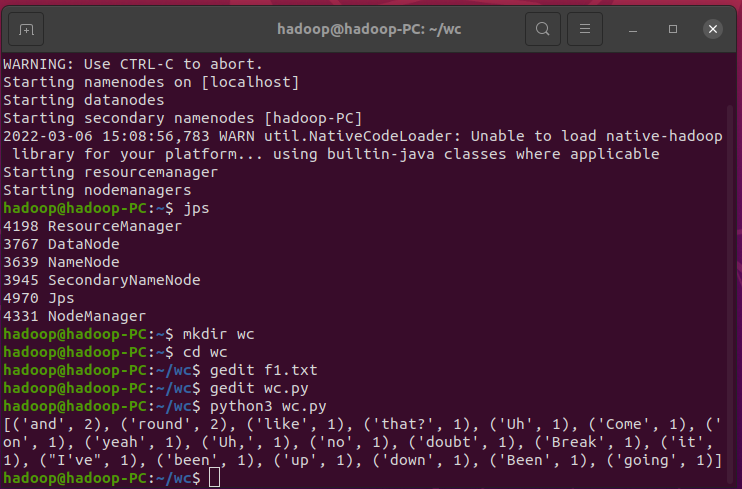

- 统计每个单词出现的次数

- 结果写文件

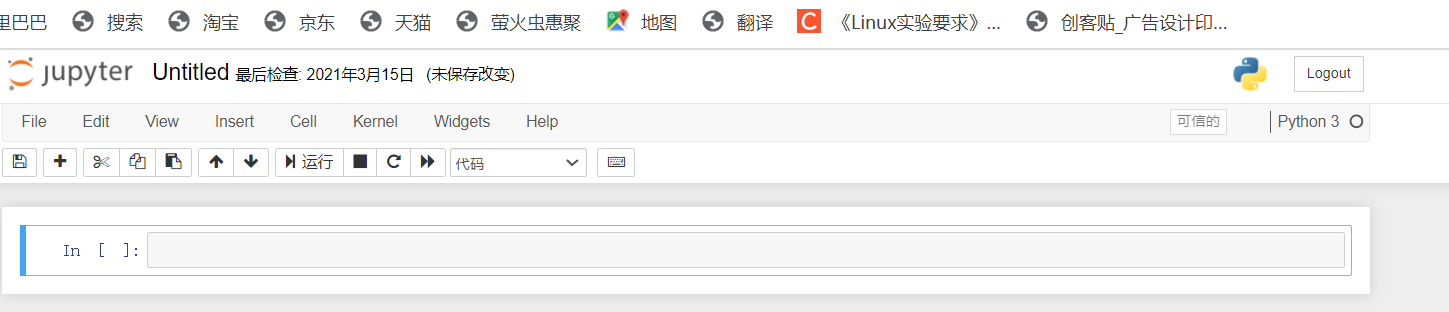

三、根据自己的编程习惯搭建编程环境(选做)

- 使用Jupyter Notebook调试PySpark程序:参考http://dblab.xmu.edu.cn/blog/2575-2/

- 使用PyCharm参考:Ubuntu 16.04 + PyCharm + spark 运行环境配置https://blog.csdn.net/zhurui_idea/article/details/72982598