支持向量机SVM

支持向量:支撑起超平面的样本点,里分界线最近

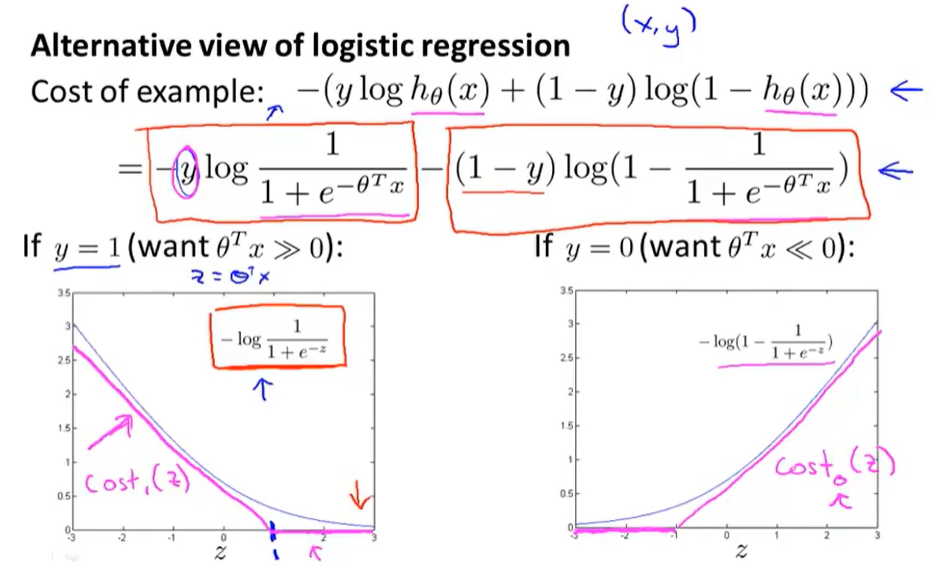

逻辑回归的代价函数

每个单独的训练样本 一起为逻辑回归总体目标做贡献

两条线段

在数学上的定义:

对于逻辑回归来说(》:远大于)

每个单独的训练样本 一起为逻辑回归总体目标做贡献(下面考虑单个样本的情况):?

y=1 就是标签为1,代价函数就是左边的图形,想要代价函数值越小的话,Z就得很大(Z足够大的时候,代价函数值近似0)

这里的log是以e为底

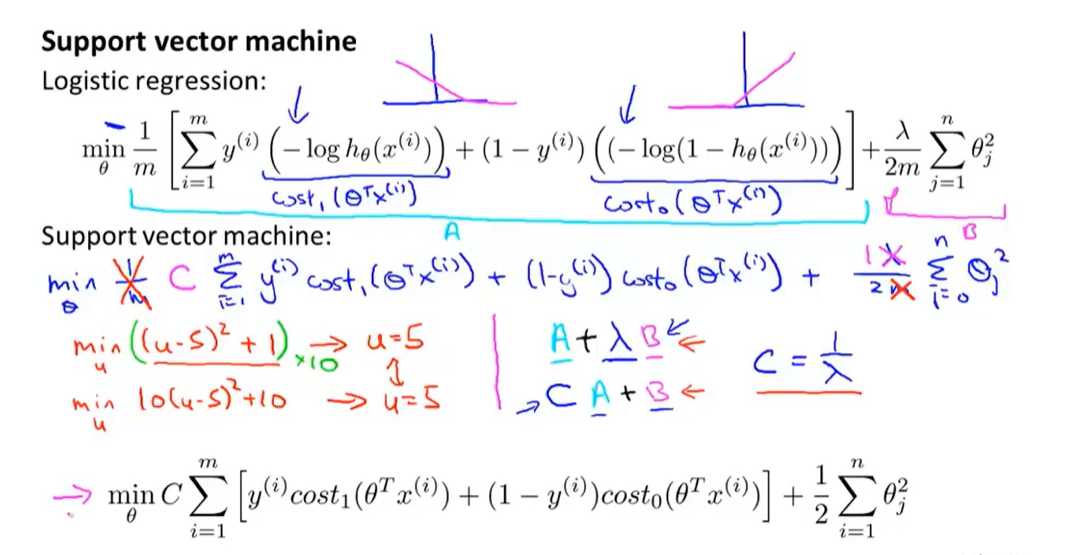

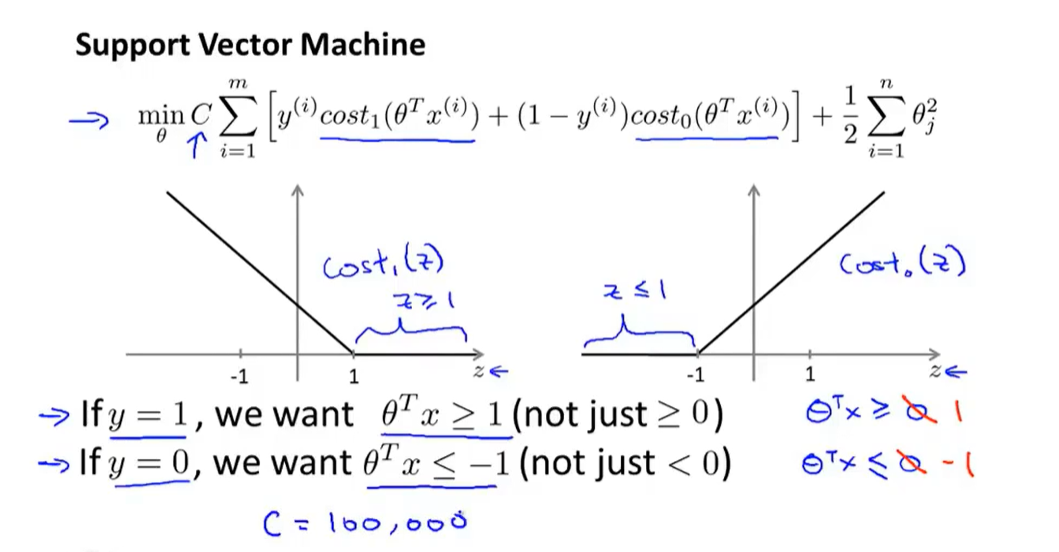

构建支持向量机,从这个代价函数开始,进行少量修改,变成两个线段组成的‘曲线’(洋红色),形状与原来逻辑回归的代价函数类似

其效果也类似,但是这样会使支持向量机拥有计算上的优势,并且使优化问题变得简单,更容易解决。

这样就得到两个新函数(洋红色):cost_1(z),cost_2(z)。然后带入原来的逻辑回归函数

λ和C都是为了控制权衡:更多的适应训练集还是更多的去保持正则化参数足够小

逻辑回归使用上面的,SVM使用下面的

最小化最终得到的函数,就得到了SVM学习得到的参数θ。

与逻辑回归不同的是,SVM并不会输出概率,而是通过优化这个代价函数得到的一个参数θ,然后进行直接的预测(0,1)

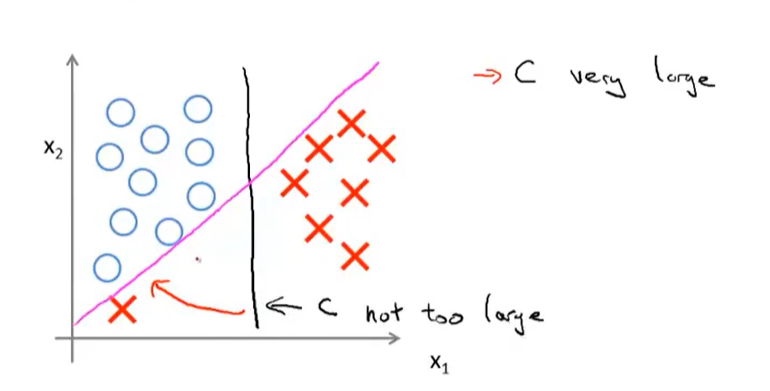

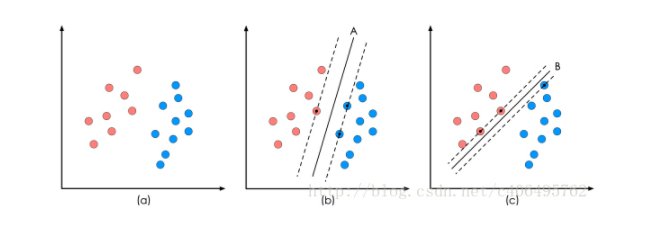

‘间距’初体验(比一般的逻辑回归有更大的‘间距’)

当把C值设定很大的时候,最小化整个代价函数,会使第一项值近似0(侧重于拟合参数),有异常点时候会得到下图的洋红界限

当C值设定不是很大的时候,有异常点时候会得到下图的黑色界限(更合理,间隔更大)

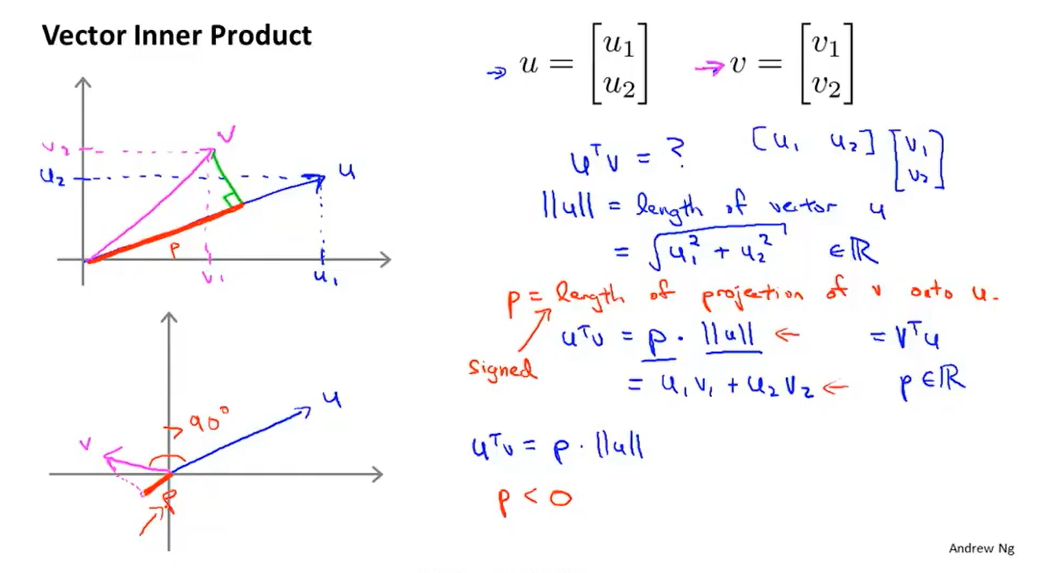

向量内积的性质

p就是向量V在向量U上投影的长度(是一个实数,有符号【正或者负】)

丨丨u 丨丨也是一个实数

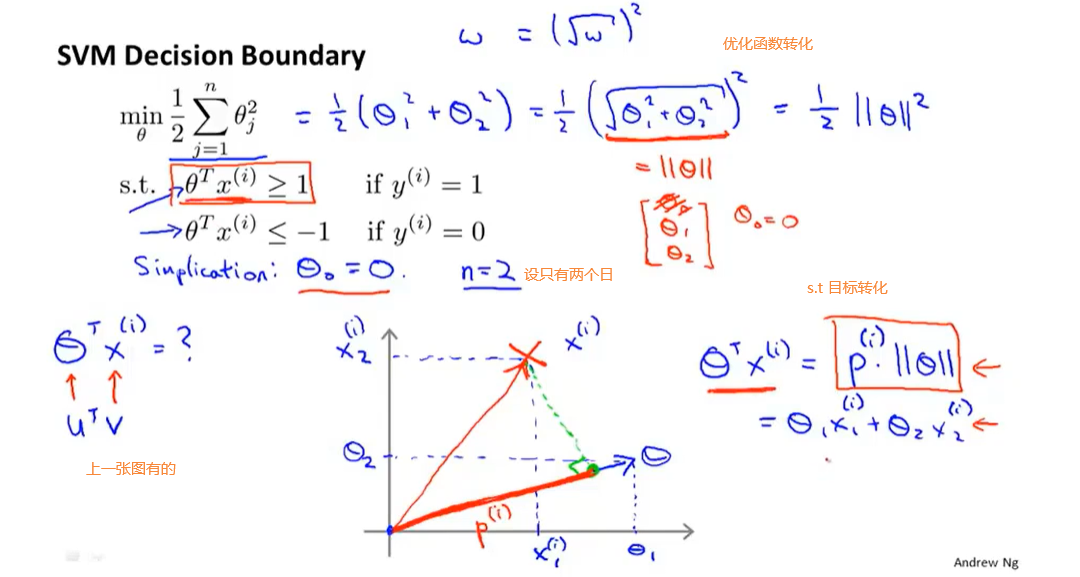

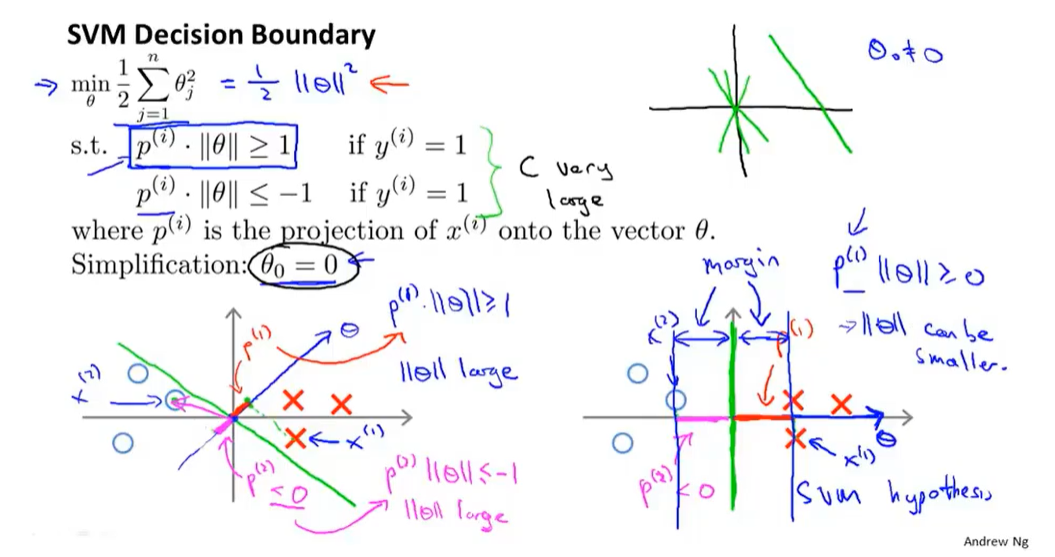

之前的优化目标函数(把C设置的很大的情况下)

参数向量θ与决策边界垂直。

希望正样本和负样本投影到θ的值足够大(决策边界距离周围得是大间距)

通过让p1 p2 p3 变大(最大化p的范数【训练样本到决策边界的距离】),SVM最终就会得到一个较小的θ的范数丨丨)

θ_0=0,决策边界通过原点

此模型对应着C值很大

· 10年+ .NET Coder 心语,封装的思维:从隐藏、稳定开始理解其本质意义

· .NET Core 中如何实现缓存的预热?

· 从 HTTP 原因短语缺失研究 HTTP/2 和 HTTP/3 的设计差异

· AI与.NET技术实操系列:向量存储与相似性搜索在 .NET 中的实现

· 基于Microsoft.Extensions.AI核心库实现RAG应用

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 10年+ .NET Coder 心语 ── 封装的思维:从隐藏、稳定开始理解其本质意义

· 【设计模式】告别冗长if-else语句:使用策略模式优化代码结构

· 字符编码:从基础到乱码解决

· 提示词工程——AI应用必不可少的技术