Spark踩坑日常

- Spark连接到HDFS报错:ConnectException:Call From to master:8020

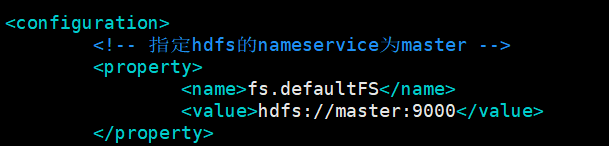

- 原因:Hadoop的master端口设置为9000,core-site.xml:

而Spark访问的默认端口为8020,端口不一致导致

- 解决方案:

- 修改core-site.xml

- 修改hdfs访问端口

- 原因:Hadoop的master端口设置为9000,core-site.xml:

- 若使用spark-submit去提交作业,若配置的core数量或者Memory没有节点能满足,则会导致作业卡在Driver下,无worker可用

- 提交作业报错:java.nio.file.NoSuchFileException: /mnt/hgfs/ShareWithUbuntu/gapsBatch.jar

- 解决方法:在cluster模式下,jar包需要放到集群可以访问的目录,如果是放在本地,需要在每个节点上都放置一份

- 通过Spark-submit提交Spark任务,报WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

- 解决方法:在环境变量增加export LD_LIBRARY_PATH=$HADOOP_HOME/lib/native:$LD_LIBRARY_PATH

【推荐】凌霞软件回馈社区,博客园 & 1Panel & Halo 联合会员上线

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步