MetaFormer,探索transformer网络结构【读论文,网络结构】

论文:MetaFormer is Actually What You Need for Vision,(CVPR,2021)

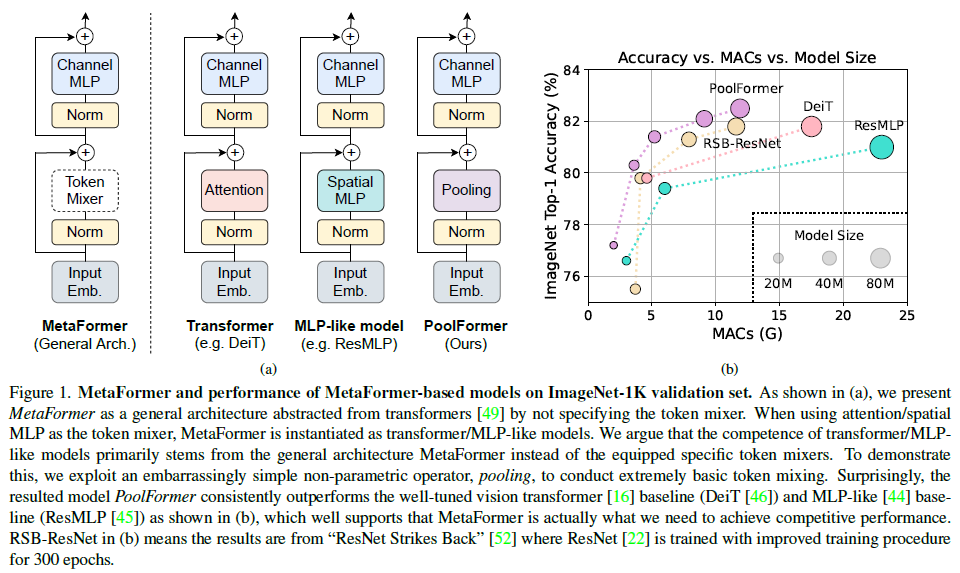

论点:transformer的网络结构而不是self-attention tocken mixer使得模型效果好;为了证明此论点,作者将attention模块换成令人尴尬简单的空间池化层(取名PoolFormer),在多个视觉任务上取得了相当的效果。因此,如何改进模型框架是研究重点。

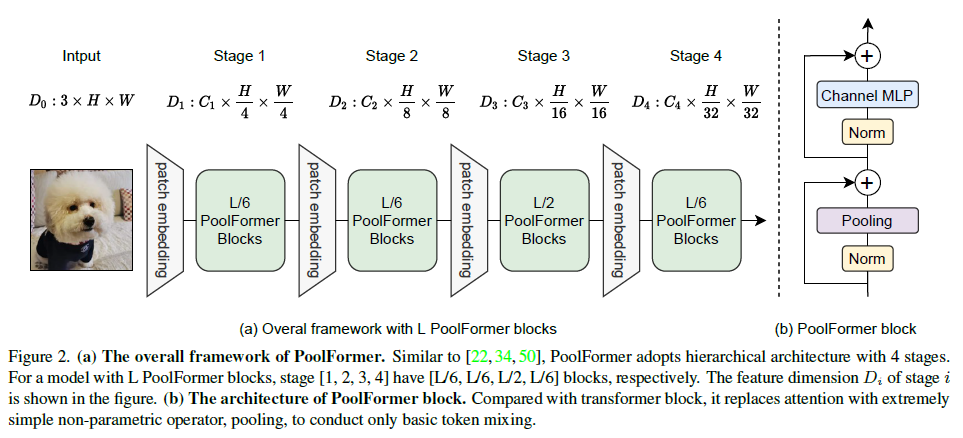

1. 网络结构

poolingformer对tocken做简单average pooling,参数少,计算复杂度底。

模型结构和swin transformer几乎一致;

2. 实验分析

poolingformer同等参数量下,效果不错;特别的,混合模型:1、2stage用pool mixer,3、4用attention,效果有提升。

3. 结论

结构更重要,attention tocken mixer。