生产环境Docker部署ELK跨区访问kafka不通问题的解决

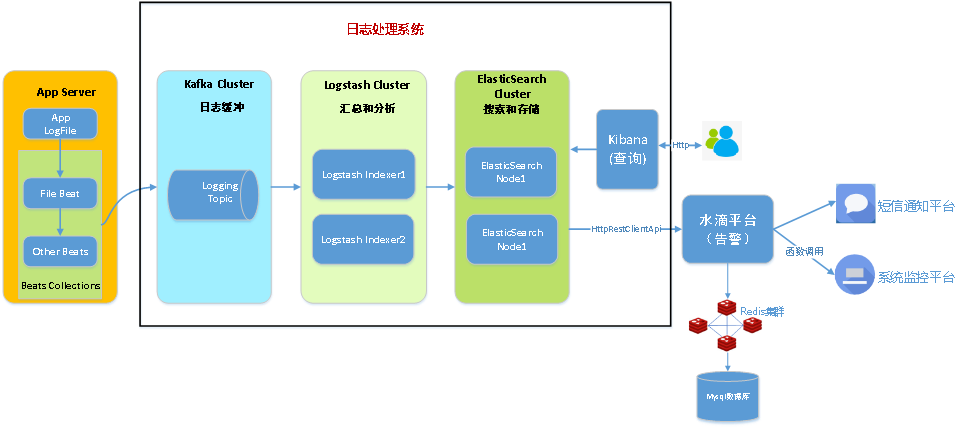

由于分布式系统的日志集中采集的需求非常强烈,我们组通过调研和实践搭建了一套基于Docker的日志收集系统Amethyst。

我们首先在测试环境搭建了一套基于Docker swarm集群的ELK分布式环境。

测试云

docker swarm 配置:

[elastic@host-10-191-51-44 ~]$ docker node ls ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION qjdc5dhfauxz9b6bxlj12k0b4 * host-10-191-51-44 Ready Active Reachable 18.09.4 sn0uy2i8rwfpk1z8jjwkmb3un host-10-191-51-45 Ready Active Reachable 18.09.4 rjsxhmbrstpxadw9vc4rzbc4e host-10-191-51-46 Ready Active Leader 18.09.4 xl24brlx3b6r1r9bm22nl3s95 host-10-191-51-47 Ready Active 18.09.4

四台linux主机配置各为:

Kernel Version: 3.10.0-327.el7.x86_64 Operating System: CentOS Linux 7 (Core) OSType: linux Architecture: x86_64 CPUs: 8 Total Memory: 15.51GiB

Docker swarm service包括

NAME SERVICES ORCHESTRATOR es 4 Swarm kafka 3 Swarm kibana 1 Swarm log 1 Swarm zk 3 Swarm

五种service关系如下图所示:

Filebeat主机和Amethyst处于同一个测试网网段,ip地址直接可以连接,状态一切正常,kibana里可以看见测试数据,所以我们测试两个月后便准备投入生产,从此记录从评审开始遇到的主要问题。

评审阶段:

关键词:网络如何限流

解决办法:kafka consumer配额,Filebeat的压力感知功能可以在kafka限流时降低自身发送日志的速率。

参考 https://www.cnblogs.com/huxi2b/p/8609453.html

也考虑过使用容器tc限流,但是发现tc只能对输出流量做限制,故放弃。

第一次发布:

关键词:1) filebeat 跨区跨防火墙连接kafka IP地址不通.

2) docker程序所属用户为manag

问题1:由于kafka的三个IP地址做了NAT映射,filebeat 中配置连接IP为kafka映射后的地址,连接kafka时,kafka会返回给filebeat注册到zookeeper的对外地址,也就是KAFKA_ADVERTISED_LISTENERS;这里出现一个问题:1)当我们把kafka集群中的KAFKA_ADVERTISED_LISTENERS配置为映射前地址,kafka集群状态正常但是,filebeat连接时会收到kafka返回的映射前地址,所以filebeat无法连接,导致i/o wait。2)当我们把kafka集群中的KAFKA_ADVERTISED_LISTENERS配置为映射后地址,会导致KAFKA集群之间无法通讯,从而集群状态异常。

解决办法:

网络通讯不使用IP地址的方式,通过主机名和/etc/hosts映射的方式通讯,当把KAFKA_ADVERTISED_LISTENERS配置为主机名后,kafka返回给filebeat的地址就是hostname:port,这里只要在Filebeat主机中在/etc/hosts 添加映射后的IP和hostname关系便可以让filebeat获得hostname后依然可以找到映射地址。

问题2:这是因为我们通过Docker启动进程时,默认会指定进程的uid为1000,而生产环境上uid=1000的用户正是manage用户,故docker启动的进程显示为manage所属。

解决办法:可以通过在docker swarm stack配置文件中指定服务uid来限定docker进程的名称。

第二次发布:

关键词:1) kafka集群状态异常导致

问题1: 当把kafka配置的KAFKA_ADVERTISED_LISTENERS修改为hostname后,发现各主机用hostname之间无法ping通,而在测试网中尝试均可以通过hostname ping通(后面了解应该是测试云的openstack内置的dns解析可以在openstack虚拟机外部解析hostname),这里想当然的修改elk集群中的/etc/hosts 各IP和主机映射;这时启动kafka集群状态还是异常。在尝试在物理机上部署kafka后,集群状态就正常了;正准备让logstash从kafka里消费数据时发现logstash也无法读取kafka配置文件中的hostname,这里想到其实最初在kafka集群中添加/etc/hosts的操作应该是在各Docker内部完成!此时配置uid=“0”,启动kafka_stack和logstash_stack,在容器内部添加/etc/hosts条目。

解决办法:在kafka和logstash内部添加/etc/hosts条目。

研究方向:

kafka通讯机制

docker的uid机制