循环神经网络-RNN

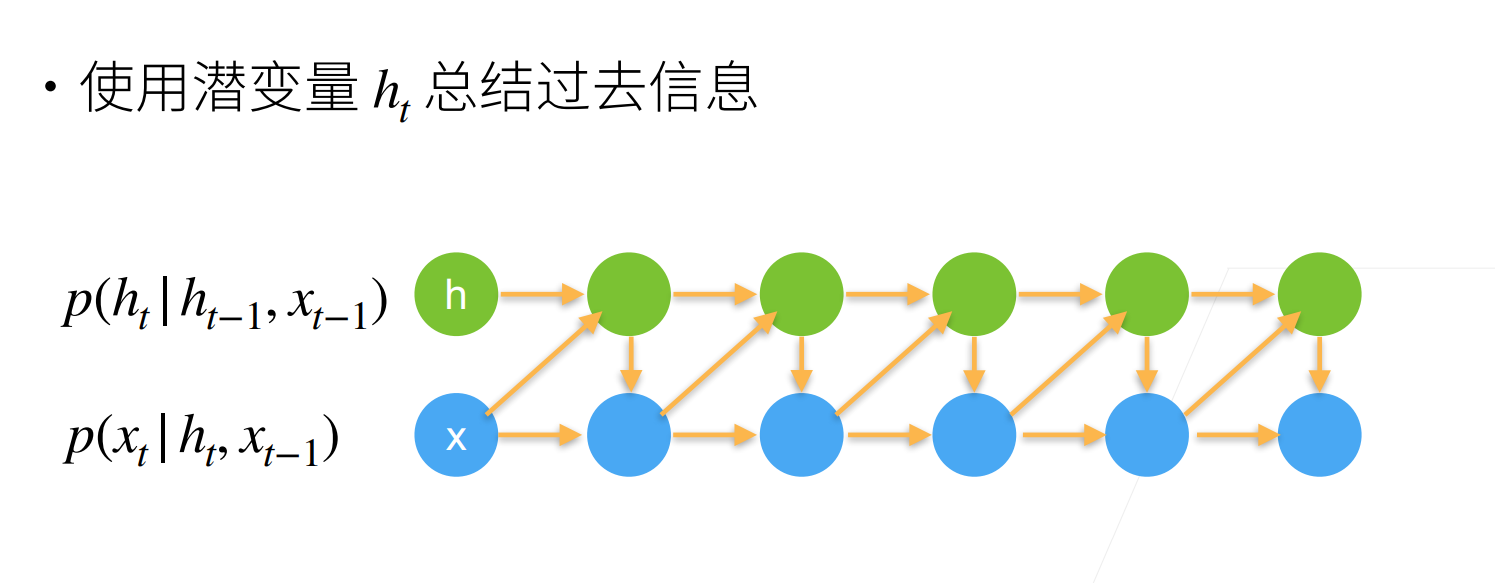

n元语法模型,其中单词在时间步t的条件概率仅取决于前面个单词。对于时间步之前的单词,如果我们想将其可能产⽣的影响合并到上,需要增加n,然而模型参数的数量也会随之呈指数增长,因为词表需要存储个数字,因此与其将模型化,不如使用隐变量模型:

其中是隐状态,也称为隐藏变量,它存储了到时间步的序列信息。通常,我们可以基于当前输入和先前隐状态来计算时间步t处的任何时间的隐状态:

对于函数f,隐变量模型不是近似值。毕竟是可以仅仅存储到目前为止观察到的所有数据,然而这样的操作可能会使计算和存储的代价都变得昂贵。其类似于潜变量自回归模型:

值得注意的是,隐藏层和隐状态指的是两个截然不同的概念。如上所述,隐藏层是在从输⼊到输出的路径上(以观测角度来理解)的隐藏的层,而隐状态则是在给定步骤所做的任何事情(以技术⻆度来定义)的输入,并且这些状态只能通过先前时间步的数据来计算。循环神经网络(RNs)是具有隐状态的神经⽹络。下面我们看一下无隐状态的神经网络,也就是多层感知机模型。

无隐状态的神经网络

让我们来看⼀看只有单隐藏层的多层感知机。设隐藏层的激活函数为,给定⼀个小批量样本,其中批量大小为n,输入维度为d,则隐藏层的输出通过下式计算:

我们拥有的隐藏层权重参数为,偏置参数为,以及隐藏单元的数目为h。接下来,将隐藏变量H用作输出层的输入。输出层由下式给出:

其中,是输出变量,是权重参数,是输出层的偏置参数。如果是分类问题,我们可以用softmax(O) 来计算输出类别的概率分布。并且通过自动微分和随机梯度下降能够学习⽹络参数就可以了。

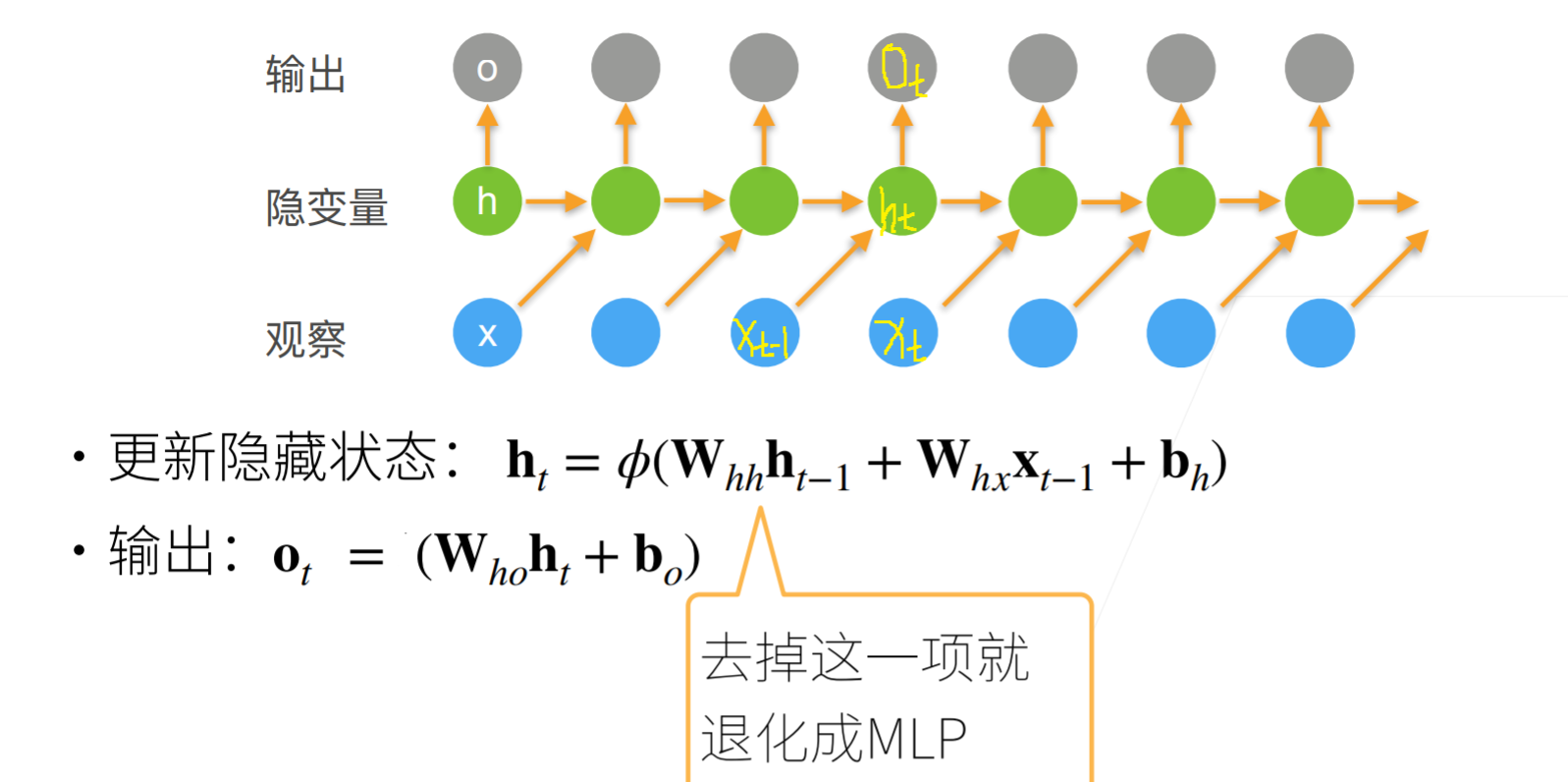

有隐状态的循环神经网络

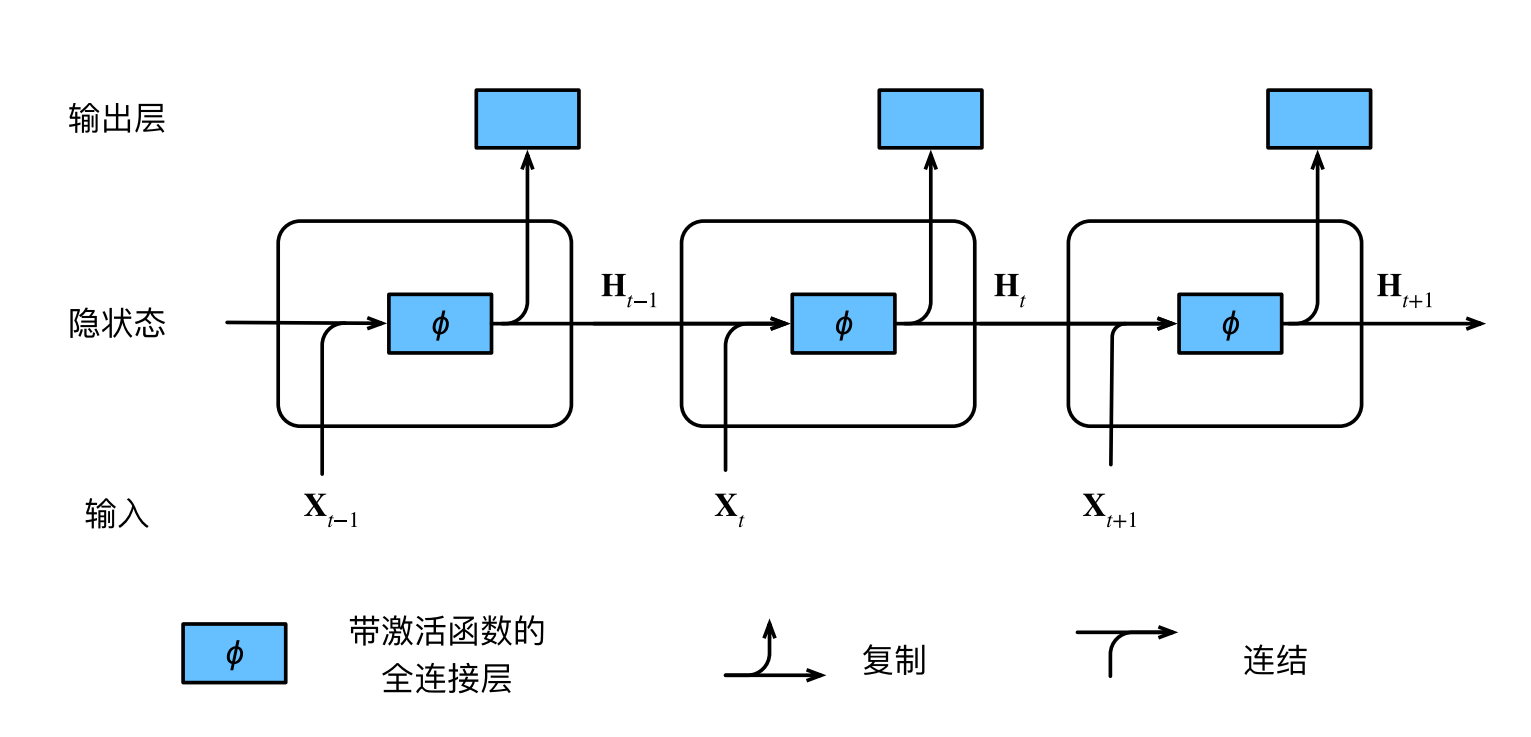

有了隐状态后,情况就完全不同了。假设我们在时间步t有小批量输入。换言之,对于n个序列样本的小批量,的每一行对应于来自该序列的时间步t处的⼀个样本。接下来,用表示时间步t的隐藏变量。与多层感知机不同的是,我们在这里保存了前⼀个时间步的隐藏变量,并引入了⼀个新的权重参数,来描述如何在当前时间步中使用前⼀个时间步的隐藏变量。具体地说,当前时间步隐藏变量由当前时间步的输入与前⼀个时间步的隐藏变量⼀起计算得出:

从相邻时间步的隐藏变量H_t和H_{t−1}之间的关系可知,这些变量捕获并保留了序列直到其当前时间步的历史信息,就如当前时间步下神经网络的状态或记忆,因此这样的隐藏变量被称为隐状态。由于在当前时间步中,隐状态使用的定义与前⼀个时间步中使用的定义相同,因此该公式的计算是循环的。于是基于循环计算的隐状态神经网络被命名为循环神经网络。在循环神经网络中执行计算的层称为循环层。

对于时间步t,输出层的输出类似于多层感知机中的计算:

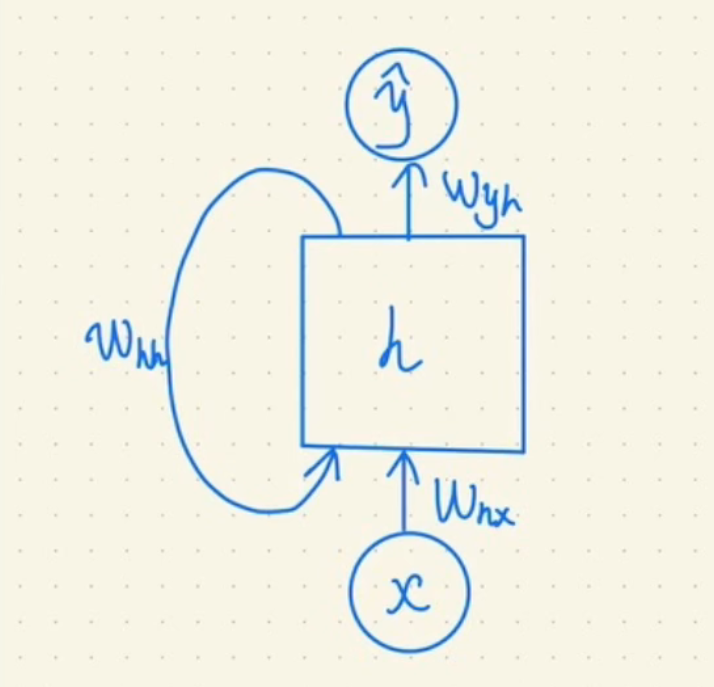

循环神经网络的参数包括隐藏层的权重, W_{hh} \in R_{h×h}和偏置,以及输出层的权重和偏置。值得⼀提的是,即使在不同的时间步,循环神经网络也总是使用这些模型参数。因此,循环神经网络的参数开销不会随着时间步的增加而增加。

在任意时间步t,隐状态的计算可以被视为:

- 拼接当前时间步t的输⼊和前⼀时间步的隐状态;

- 将拼接的结果送入带有激活函数的全连接层。全连接层的输出是当前时间步的隐状态。

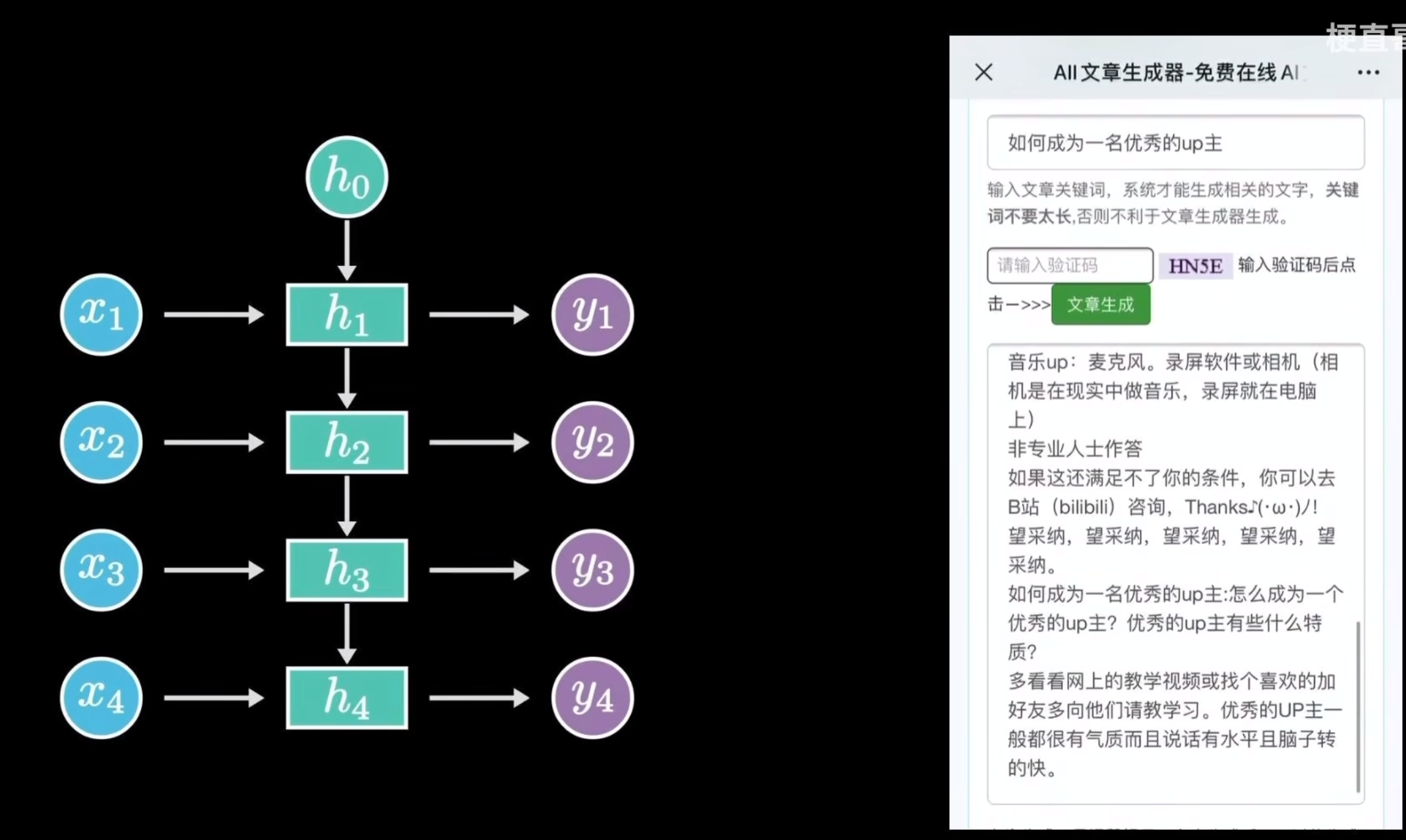

用一个图表示就是:

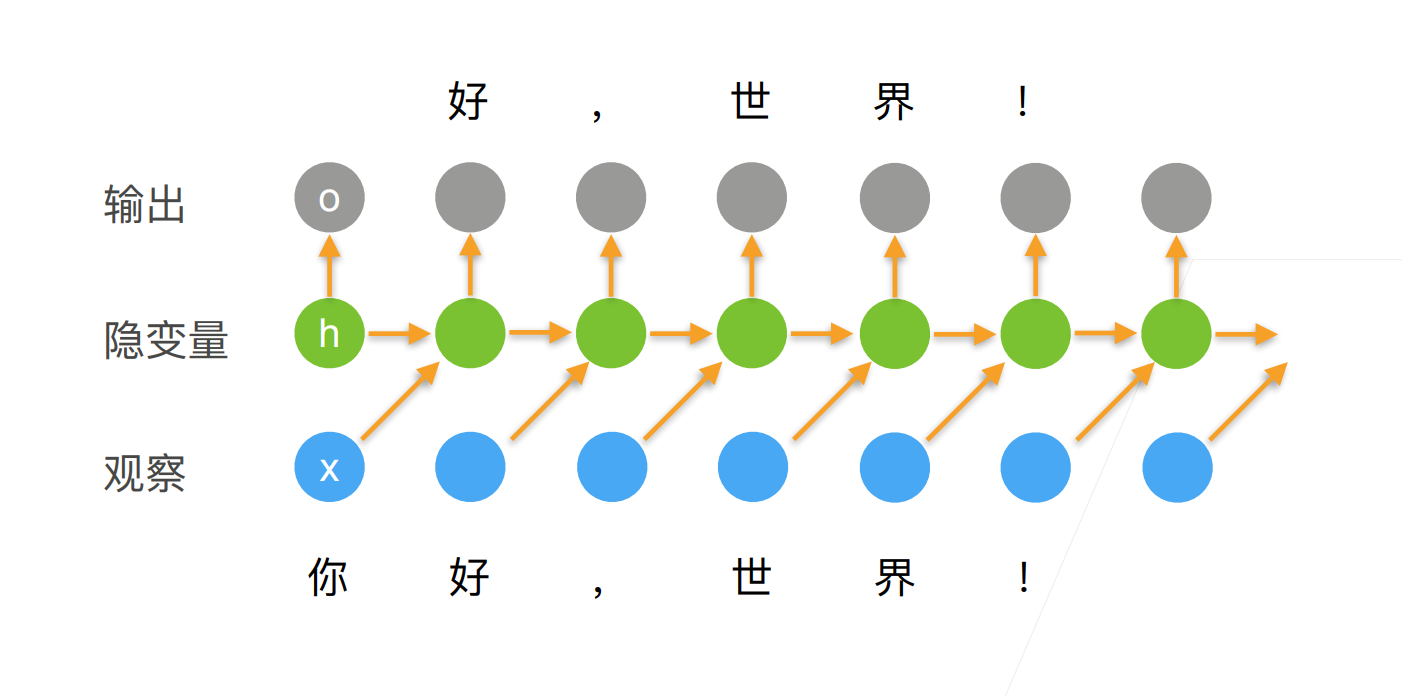

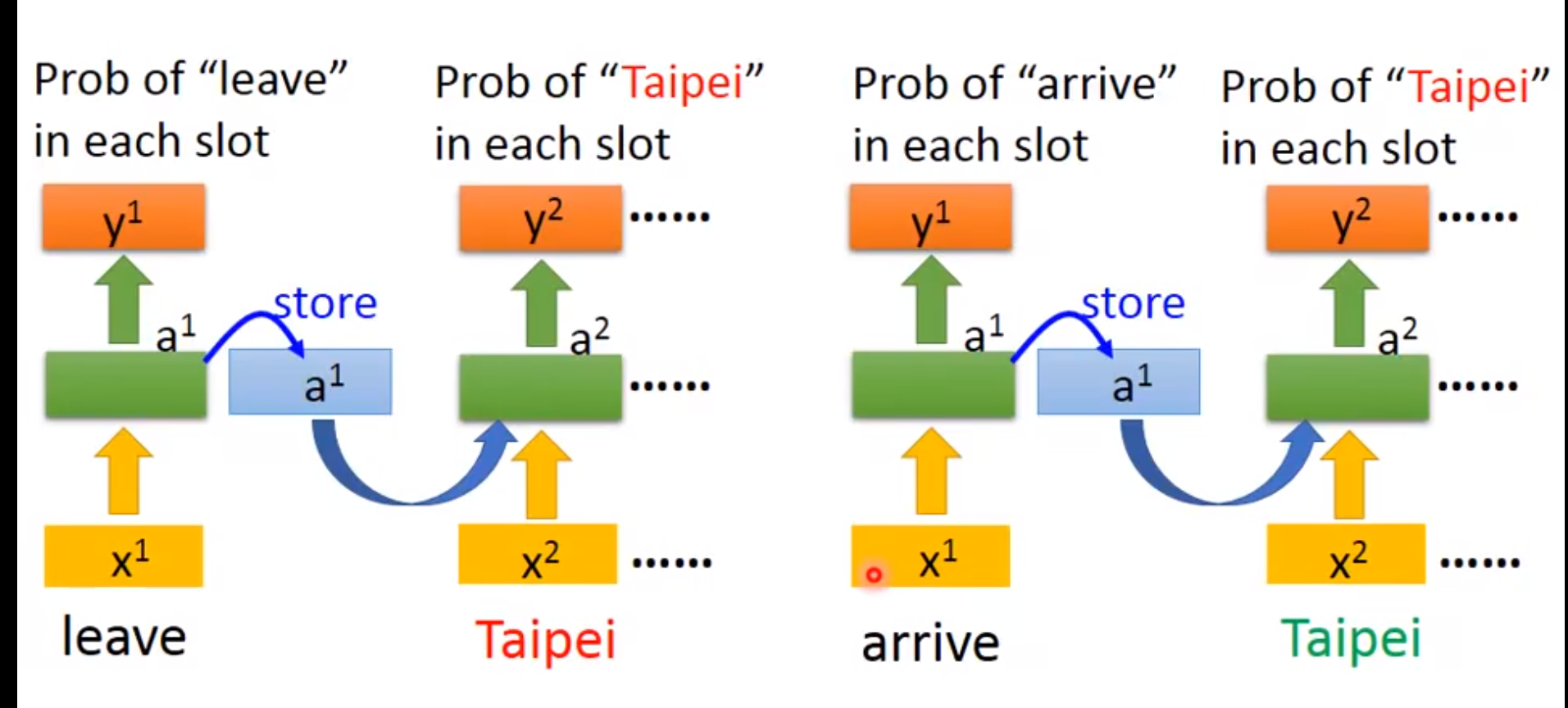

这里需要注意的是算损失的是,也就是说是预测值,是真实值,其实是把时序信息存起来。例如,我们是使用它预测的时候:

或者看这个:

或者说看看这个视频

视频

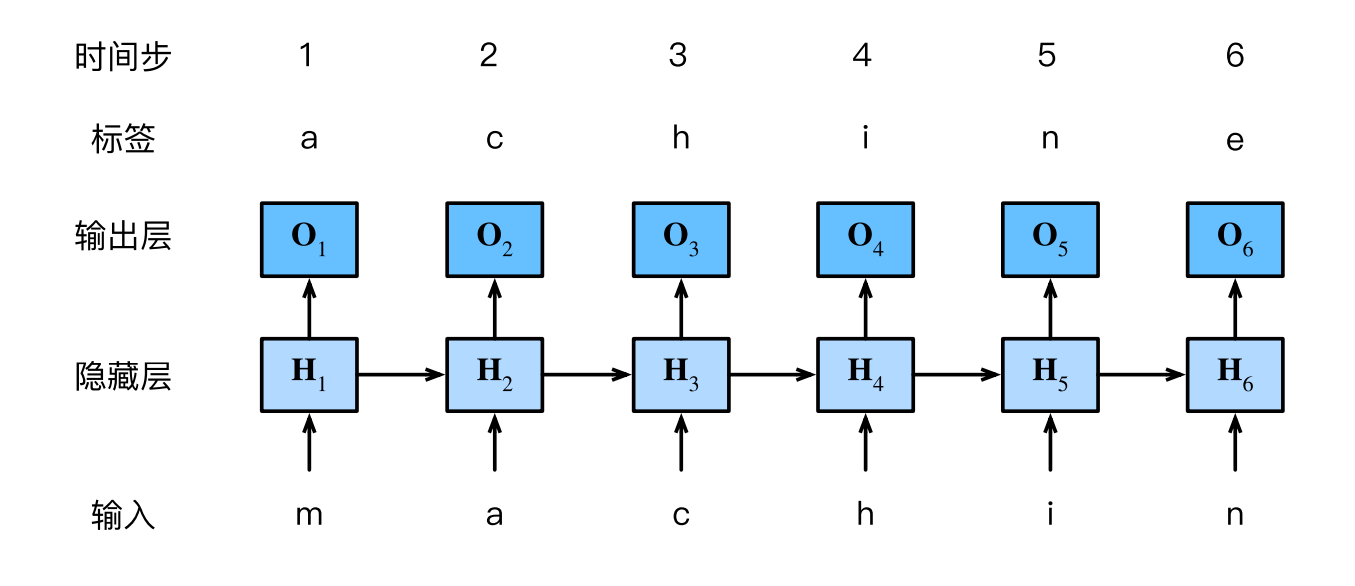

基于循环神经网络的字符级语言模型

我们之前说过语言模型,我们的目标是根据过去的和当前的词元预测下⼀个词元,因此我们将原始序列移位⼀个词元作为标签。Bengio等人首先提出使用神经网络进行语言建模。接下来,我们看⼀下如何使用循环神经网络来构建语言模型。设小批量大小为1,批量中的文本序列为"machine"。为了简化后续部分的训练,我们考虑使用字符级语言模型,将文本词元化为字符而不是单词。下图演示了如何通过基于字符级语⾔建模的循环神经网络,使用当前的和先前的字符预测下⼀个字符。

我们将上面这个错开一位其实和我们上面那个一样的。

在训练过程中,我们对每个时间步的输出层的输出进行softmax操作,然后利用交叉熵损失计算模型输出和标签之间的误差。由于隐藏层中隐状态的循环计算,上图中的第3个时间步的输出由⽂本序列"m""a"和"c"确定。由于训练数据中这个文本序列的下⼀个字符是"h",因此第3个时间步的损失将取决于下⼀个字符的概率分布,而下⼀个字符是基于特征序列"m""a""c"和这个时间步的标签"h"生成的。

在实践中,我们使用的批量大小为,每个词元都由⼀个d维向量表示。因此,在时间步t输入将是⼀个矩阵.

困惑度

让我们讨论如何度量语言模型的质量,这将在后续部分中用于评估基于循环神经网络的模型。一个好的语言模型能够用高度准确的词元来预测我们接下来会看到什么。考虑⼀下由不同的语⾔模型给出的对“It is raining …”(“…下⾬了”)的续写:

- “It is raining outside”(外面下雨了);

- “It is raining banana tree”(⾹蕉树下雨了);

- “It is raining piouw;kcj pwepoiut”(piouw;kcj pwepoiut下⾬了)。

就质量而言,例1显然是最合乎情理、在逻辑上最连贯的。虽然这个模型可能没有很准确地反映出后续词的语

义,比如,“It is raining in San Francisco”(旧金山下⾬了)可能才是更完美的合理扩展,但该模型已经能够捕捉到跟在后面的是哪类单词。例2则要糟糕得多,因为其产生了⼀个⽆意义的续写。尽管如此,至少该模型已经学会了如何拼写单词,以及单词之间的某种程度的相关性。最后,例3表明了训练不⾜的模型是⽆法正确地拟合数据的。我们可以通过计算序列的似然概率来度量模型的质量。然而这是⼀个难以理解、难以比较的数字。毕竟,较短的序列⽐较长的序列更有可能出现,因此评估模型产生托尔斯泰的巨著《战争与和平》的可能性不可避免地会比产生圣埃克苏佩里的中篇小说《小王⼦》可能性要小得多。而缺少的可能性值相当于平均数。

我们可以通过⼀个序列中所有的n个词元的交叉熵损失的平均值来衡量:

其中P由语言模型给出,是在时间步t从该序列中观察到的实际词元。这使得不同长度的文档的性能具有了可比性。由于历史原因,自然语⾔处理的科学家更喜欢使用⼀个叫做困惑度的量。也就是上面那个式子的指数:

就是比如说这个困惑度等于1的话,就是下面这个词就是正确的那个,假如困惑度等于2的话,就是下面两个词都有可能是正确的。1表示完美匹配,无穷大就表示最差的情况。

困惑度的最好的理解是“下⼀个词元的实际选择数的调和平均数”。我们看看⼀些案例。

• 在最好的情况下,模型总是完美地估计标签词元的概率为1。在这种情况下,模型的困惑度为1。

• 在最坏的情况下,模型总是预测标签词元的概率为0。在这种情况下,困惑度是正无穷大。

梯度裁剪

对于长度为T的序列,我们在迭代中计算这T个时间步上的梯度,将会在反向传播过程中产生长度为O(T)的矩阵乘法链。当T较大时,它可能导致数值不稳定,例如可能导致梯度爆炸或梯度消失。因此,循环神经网络模型往往需要额外的方式来支持稳定训练。

有时梯度可能很大,从而优化算法可能无法收敛。我们可以通过降低的学习率来解决这个问题。但是如果我们很少得到大的梯度呢?在这种情况下,这种做法似乎毫无道理。一个流行的替代方案是通过将梯度投影回给定半径(例如)的球来裁剪梯度。如下式:

通过这样做,我们知道梯度范数永远不会超过,并且更新后的梯度完全与的原始方向对齐。它还有一个值得拥有的副作用,即限制任何给定的小批量数据(以及其中任何给定的样本)对参数向量的影响,这赋予了模型一定程度的稳定性。梯度裁剪提供了⼀个快速修复梯度爆炸的方法,虽然它并不能完全解决问题,但它是众多有效的技术之⼀。

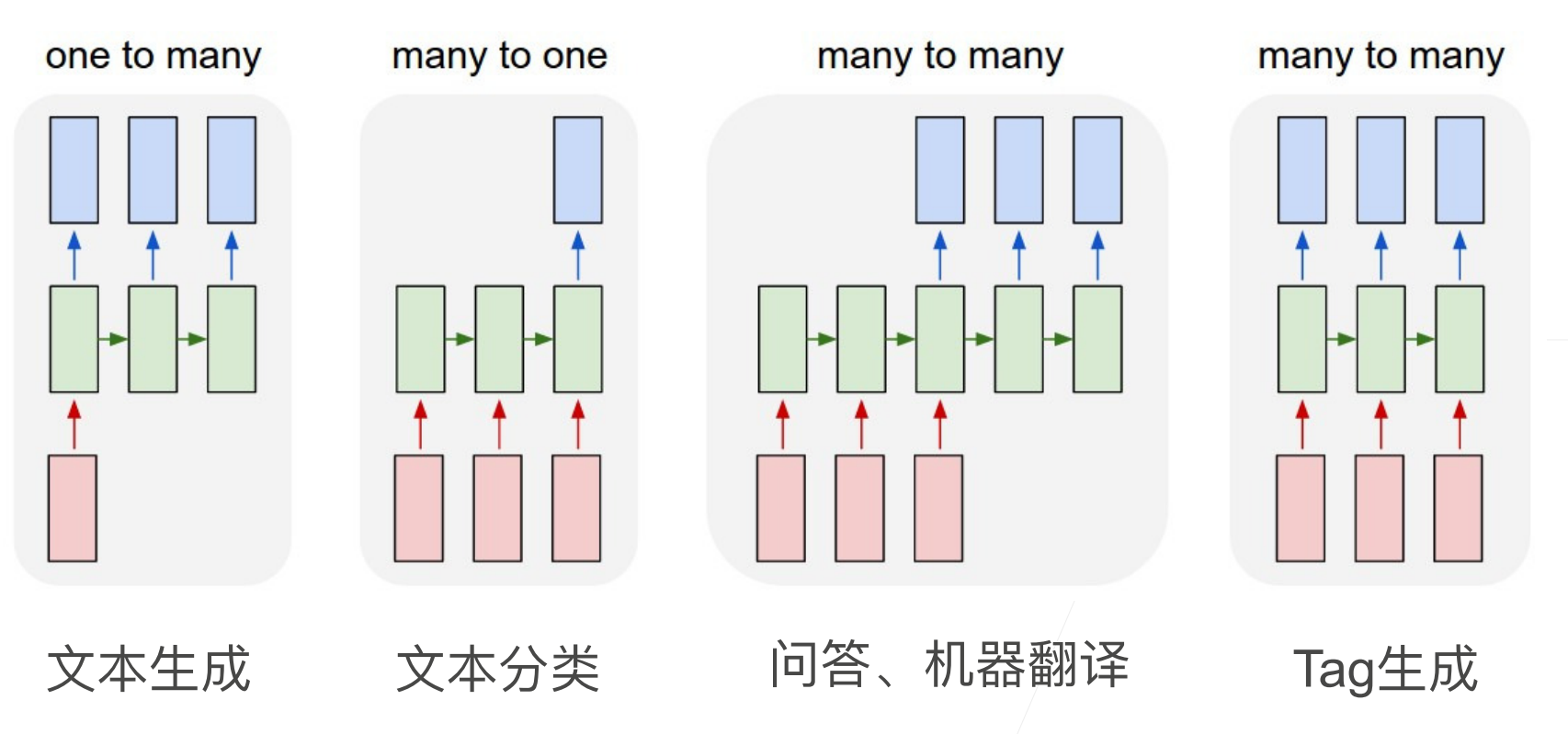

RNN的应用

1对多

可以应用在文本生成上,也就是给你一个开始的词,它可以生成一篇文章。或者利用它也可以实现看图说话,放音乐的功能。

多对一

它可以应用于文本分类,或者情感判定

多对多

它可以是问答,机器翻译,或者给你一句话,每个词判断它的词性等等。

总结

- 循环神经网络的输出取决于当下输入和前一时间的隐变量

- 应用到语言模型中时,循环神经网络根据当前词预测下一次时刻词

- 通常使用困惑度来衡量语言模型的好坏

循环神经网络的从零开始实现

读取数据集

%matplotlib inline

import math

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2l

batch_size, num_steps = 32, 35

train_iter, vocab = d2l.load_data_time_machine(batch_size, num_steps)

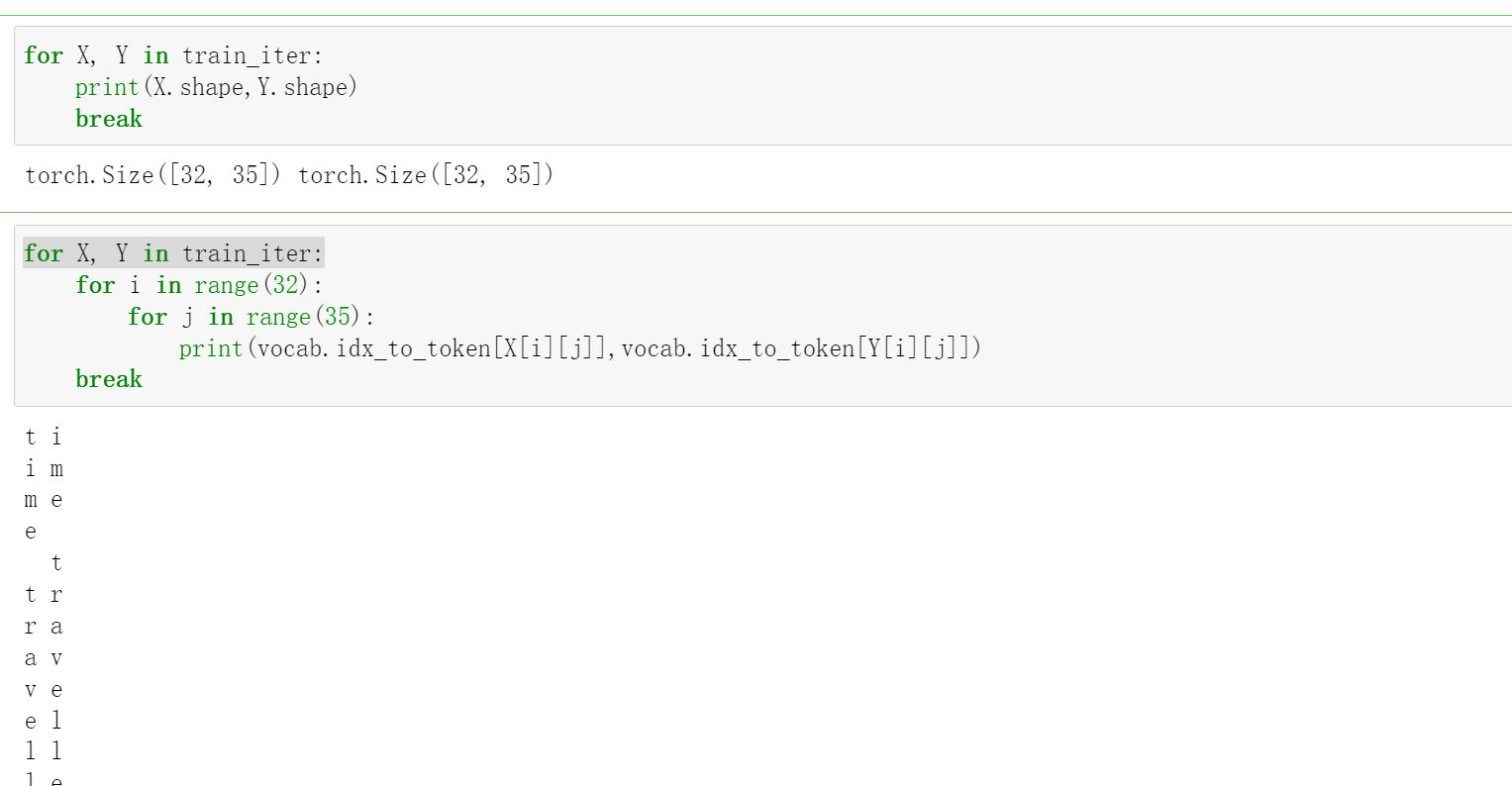

对于这个返回的train_iter,我们看看里面是什么:

独热编码

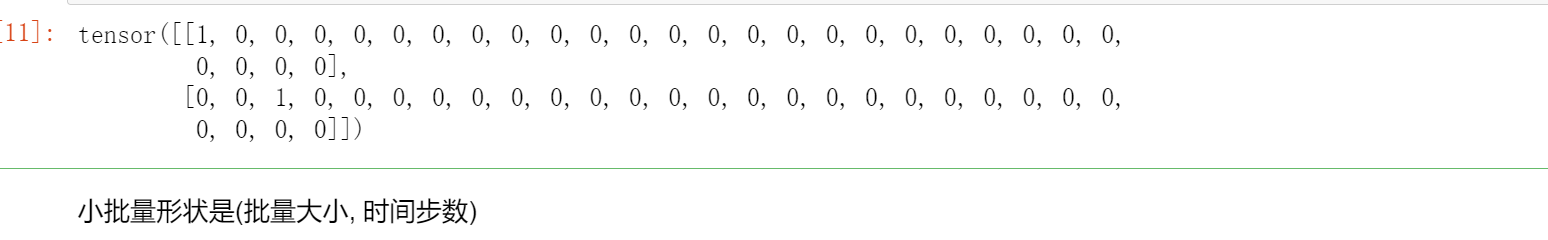

回想⼀下,在train_iter中,每个词元都表示为一个数字索引,将这些索引直接输入神经网络可能会使学习变得困难。我们通常将每个词元表示为更具表现力的特征向量。最简单的表示称为独热编码,简言之,将每个索引映射为相互不同的单位向量:假设词表中不同词元的数码为N(即len(vocab)),词元索引的范围为0到N − 1,这个可以看成N分类,也就是输出的结果是[0,N-1],对应词元中的一个词。如果词元的索引是整数i,那么我们将创建⼀个长度为N的全0向量,并将第i处的元素设置为1。此向量是原始词元的⼀个独热向量。索引为0和2的独热向量如下所示:

F.one_hot(torch.tensor([0, 2]), len(vocab))

我们每次采样的小批量数据形状是二维张量:(批量大小,时间步数)。one_hot函数将这样⼀个小批量数据转换成三维张量,张量的最后一个维度等于词表大小(len(vocab))。我们经常转换输入的维度,以便获得形状为(时间步数,批量大小,词表大小)的输出。这将使我们能够更方便地通过最外层的维度,一步一步地更

新小批量数据的隐状态。这里取了一个X.T,X的维度是(时间步,批量大小,词表大小),每次训练一个batch的时候是按照时间步的维度提取词元。假设批量大小=2,时间步大小=5,共10个词元。那么每次训练的时候按时间维度提取2个词元,共提取5次。

其实转置就是为了每次训练同一个批量下的同一时间步,如果第0维是批量大小,那么假如每次取一个样本 即(x1 x2 x3...)这样根据rnn计算规则,先算预测的x2 然后后才能算x3, 这样只能一个个算,不便于程序的并行执行。如果第0纬换成了时间序列,那么每拿一个出来,得到的就是(第一个x1 第二个x1...)这些是可以并行计算的,转置一下的好处就是把能够并行计算的东西 使得他们在空间存储上尽量相邻 提高计算效率。

X = torch.arange(10).reshape((2, 5))

F.one_hot(X.T, 28).shape

注意这里的5是时间长度也就是一个句子的长度,2是批量长度。

torch.Size([5, 2, 28])

初始化模型参数

接下来,我们初始化循环神经网络模型的模型参数。隐藏单元数num_hiddens是⼀个可调的超参数。当训练语言模型时,输入和输出来自相同的词表。因此,它们具有相同的维度,即词表的大小。

def get_params(vocab_size, num_hiddens, device):

num_inputs = num_outputs = vocab_size

def normal(shape):

return torch.randn(size=shape, device=device) * 0.01

# 隐藏层参数

W_xh = normal((num_inputs, num_hiddens))

W_hh = normal((num_hiddens, num_hiddens))

b_h = torch.zeros(num_hiddens, device=device)

## 输出层参数

W_hq = normal((num_hiddens, num_outputs))

b_q = torch.zeros(num_outputs, device=device)

#附加梯度

params = [W_xh, W_hh, b_h, W_hq, b_q]

for param in params:

param.requires_grad_(True)

return params

循环神经网络模型

为了定义循环神经网络模型,我们首先需要⼀个init_rnn_state函数在初始化时返回隐状态。这个函数的返回是⼀个张量,张量全用0填充,形状为(批量大小,隐藏单元数)。

def init_rnn_state(batch_size, num_hiddens, device):

return (torch.zeros((batch_size, num_hiddens), device=device),)

下面的rnn函数定义了如何在⼀个时间步内计算隐状态和输出。循环神经网络模型通过inputs最外层的维度实现循环,以便逐时间步更新小批量数据的隐状态H。此外,这里使用tanh函数作为激活函数。

当元素在实数上满足均匀分布时,tanh函数的平均值为0。

def rnn(inputs, state, params):

# inputs的形状:(时间步数量,批量⼤⼩,词表⼤⼩)

W_xh, W_hh, b_h, W_hq, b_q = params

H, = state

outputs = []# 每一个时刻都输出

# X的形状:(批量⼤⼩,词表⼤⼩)

for X in inputs:

H = torch.tanh(torch.mm(X, W_xh) + torch.mm(H, W_hh) + b_h)

Y = torch.mm(H, W_hq) + b_q

outputs.append(Y)

return torch.cat(outputs, dim=0), (H,)

定义了所有需要的函数之后,接下来我们创建⼀个类来包装这些函数,并存储从零开始实现的循环神经⽹络模型的参数。

class RNNModelScratch:

"""从零开始实现的循环神经网络模型"""

def __init__(self, vocab_size, num_hiddens, device, get_params,

init_state, forward_fn):

self.vocab_size, self.num_hiddens = vocab_size, num_hiddens

self.params = get_params(vocab_size, num_hiddens, device)

self.init_state, self.forward_fn = init_state, forward_fn

def __call__(self, X, state):

X = F.one_hot(X.T, self.vocab_size).type(torch.float32)

return self.forward_fn(X, state, self.params)

def begin_state(self, batch_size, device):

return self.init_state(batch_size, self.num_hiddens, device)

让我们检查输出是否具有正确的形状。例如,隐状态的维数是否保持不变。

num_hiddens = 512

net = RNNModelScratch(len(vocab), num_hiddens, d2l.try_gpu(), get_params,

init_rnn_state, rnn)

state = net.begin_state(X.shape[0], d2l.try_gpu())

Y, new_state = net(X.to(d2l.try_gpu()), state)

Y.shape, len(new_state), new_state[0].shape

# (torch.Size([10, 28]), 1, torch.Size([2, 512]))

这里的10,是因为前面的[2,5,28],也就是两个批量,每个批量5个词。

我们可以看到输出形状是(时间步数×批量大小,词表大小),而隐状态形状保持不变,即(批量大小,隐藏单元数)。

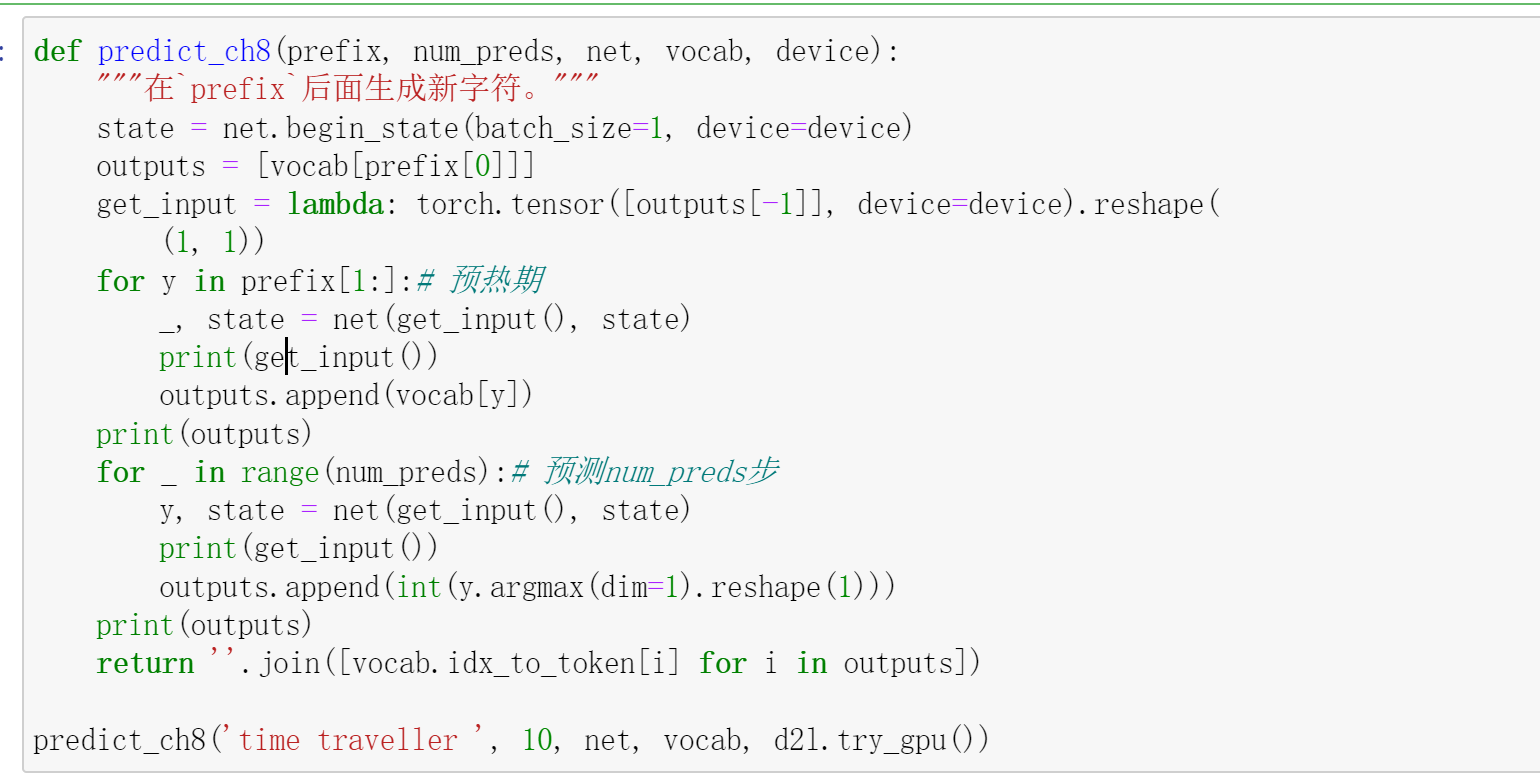

预测

让我们首先定义预测函数来生成prefix之后的新字符,其中prefix是⼀个用户提供的包含多个字符的字符串。在循环遍历prefix中的开始字符时,我们不断地将隐状态传递到下⼀个时间步,但是不生成任何输出。这被称为预热(warm-up)期,因为在此期间模型会自我更新(例如,更新隐状态),但不会进行预测。预热期结束后,隐状态的值通常比刚开始的初始值更适合预测,从⽽预测字符并输出它们。

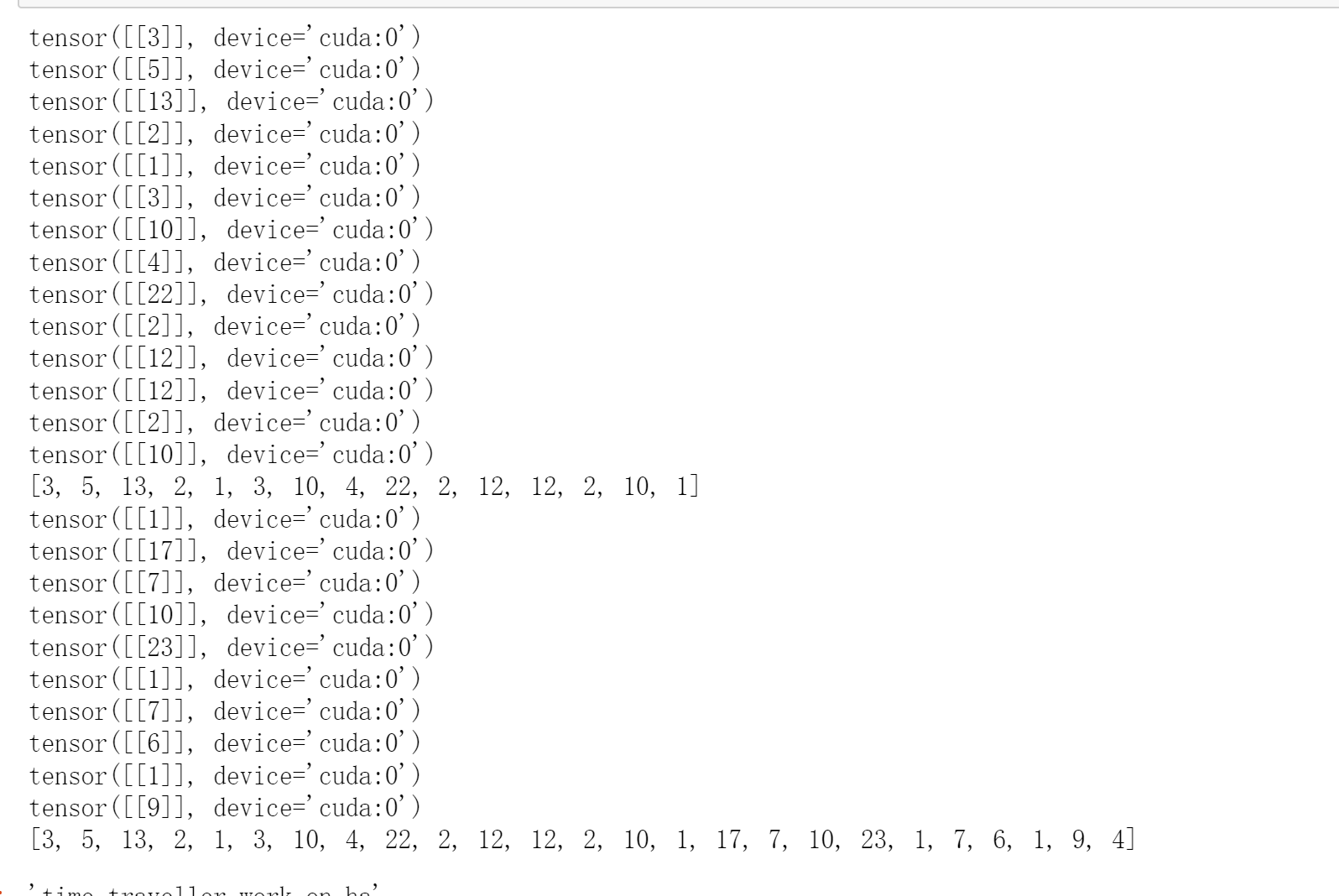

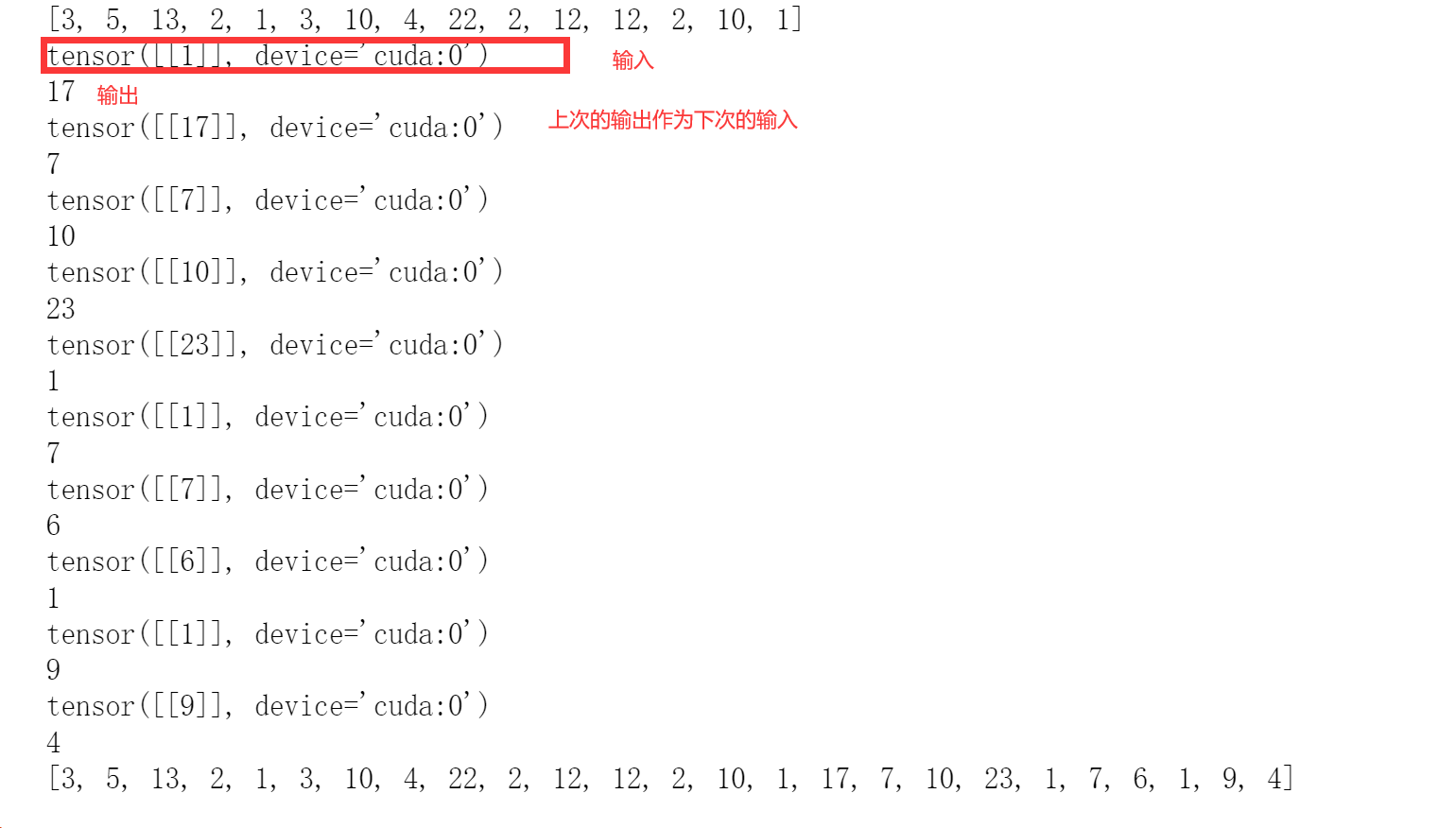

我们来看一下这个:

比如说你输入“你好,”来预测后面的,这个“你好”是给了的,我们用这个“你好”来预热机器,保存它的state,所以在预热期,我们outputs中append的是真实值,后面,在进行预测。注意在进行预测的时候,这次的预测会作为下次的输入。比如说“你好,世界”,我们预测了“你好,世”,然后这个“世”会当成下次的输入,进行预测“界”。

def predict_ch8(prefix, num_preds, net, vocab, device):

"""在`prefix`后面生成新字符。"""

state = net.begin_state(batch_size=1, device=device)

outputs = [vocab[prefix[0]]]

get_input = lambda: torch.tensor([outputs[-1]], device=device).reshape(

(1, 1))

for y in prefix[1:]:# 预热期

_, state = net(get_input(), state)

#print(get_input())

outputs.append(vocab[y])#这个是真实值,也就是这个是用已知的来预热机器,下面的才是预测

#print(outputs)

for _ in range(num_preds):# 预测num_preds步

# print(get_input())

y, state = net(get_input(), state)

outputs.append(int(y.argmax(dim=1).reshape(1)))

#print(int(y.argmax(dim=1).reshape(1)))

# print(outputs)

return ''.join([vocab.idx_to_token[i] for i in outputs])

现在我们可以测试predict_ch8函数。我们将前缀指定为time traveller,并基于这个前缀生成10个后续字符。鉴于我们还没有训练⽹络,它会⽣成荒谬的预测结果。

predict_ch8('time traveller ', 10, net, vocab, d2l.try_gpu())

# 'time traveller work on ha'

梯度裁剪

def grad_clipping(net, theta):

"""裁剪梯度。"""

if isinstance(net, nn.Module):

params = [p for p in net.parameters() if p.requires_grad]

else:

params = net.params

norm = torch.sqrt(sum(torch.sum((p.grad**2)) for p in params))

if norm > theta:

for param in params:

param.grad[:] *= theta / norm

训练

在训练模型之前,让我们定义⼀个函数在⼀个迭代周期内训练模型。它与我们之前训练的方式有三个不同之处。

- 序列数据的不同采样方法(随机采样和顺序分区)将导致隐状态初始化的差异。

- 我们在更新模型参数之前裁剪梯度。这样的操作的⽬的是,即使训练过程中某个点上发⽣了梯度爆炸,也能保证模型不会发散。

- 我们用困惑度来评价模型,这样的度量确保了不同长度的序列具有可⽐性。

具体来说,当使用顺序分区时(也就是比如说你的一篇文章,你的上一个小批量数据和下一个小批量数据在文章中是连着的,就是能接起来),我们只在每个迭代周期的开始位置初始化隐状态。由于下⼀个小批量数据中的第i个子序列样本与当前第i个子序列样本相邻,因此当前小批量数据最后一个样本的隐状态,将用于初始化下⼀个小批量数据第⼀个样本的隐状态。这样,存储在隐状态中的序列的历史信息可以在⼀个迭代周期内流经相邻的子序列。然而,在任何⼀点隐状态的计算,都依赖于同⼀迭代周期中前面所有的小批量数据,这使得梯度计算变得复杂。为了降低计算量,在处理任何⼀个小批量数据之前,我们先分离梯度,使得隐状态的梯度计算总是限制在⼀个小批量数据的时间步内。当使用随机抽样时,因为每个样本都是在⼀个随机位置抽样的,因此需要为每个迭代周期重新初始化隐状态。与 的 train_epoch_ch3函数相同,updater是更新模型参数的常用函数。它既可以是从头开始实现的d2l.sgd函数,也可以是深度学习框架中内置的优化函数。

use_random_iter是指的是你的上一个样本和你的下一个样本是不是相邻的,就是能不能接的上。

def train_epoch_ch8(net, train_iter, loss, updater, device, use_random_iter):

"""训练模型一个迭代周期(定义见第8章)。"""

state, timer = None, d2l.Timer()

metric = d2l.Accumulator(2)# 训练损失之和,词元数量

for X, Y in train_iter:

if state is None or use_random_iter:

# 在第⼀次迭代或使⽤随机抽样时初始化state,这里看看是不是样本是不是连着的,就是和上一个epoch是不是相邻的

state = net.begin_state(batch_size=X.shape[0], device=device)

else:

if isinstance(net, nn.Module) and not isinstance(state, tuple):

# state对于nn.GRU是个张量

state.detach_()

else:

for s in state:

# state对于nn.LSTM或对于我们从零开始实现的模型是个张量

s.detach_()

y = Y.T.reshape(-1)

X, y = X.to(device), y.to(device)

y_hat, state = net(X, state)

l = loss(y_hat, y.long()).mean()

if isinstance(updater, torch.optim.Optimizer):

updater.zero_grad()

l.backward()

grad_clipping(net, 1)

updater.step()

else:

l.backward()

grad_clipping(net, 1)

# 因为已经调⽤了mean函数

updater(batch_size=1)

metric.add(l * y.numel(), y.numel())

return math.exp(metric[0] / metric[1]), metric[1] / timer.stop()

循环神经⽹络模型的训练函数既⽀持从零开始实现,也可以使⽤⾼级API来实现。

def train_ch8(net, train_iter, vocab, lr, num_epochs, device,

use_random_iter=False):

"""训练模型(定义见第8章)。"""

loss = nn.CrossEntropyLoss()

animator = d2l.Animator(xlabel='epoch', ylabel='perplexity',

legend=['train'], xlim=[10, num_epochs])

# 初始化

if isinstance(net, nn.Module):

updater = torch.optim.SGD(net.parameters(), lr)

else:

updater = lambda batch_size: d2l.sgd(net.params, lr, batch_size)

predict = lambda prefix: predict_ch8(prefix, 50, net, vocab, device)

# 训练和预测

for epoch in range(num_epochs):

ppl, speed = train_epoch_ch8(net, train_iter, loss, updater, device,

use_random_iter)

if (epoch + 1) % 10 == 0:

print(predict('time traveller'))

animator.add(epoch + 1, [ppl])

print(f'困惑度 {ppl:.1f}, {speed:.1f} 标记/秒 {str(device)}')

print(predict('time traveller'))

print(predict('traveller'))

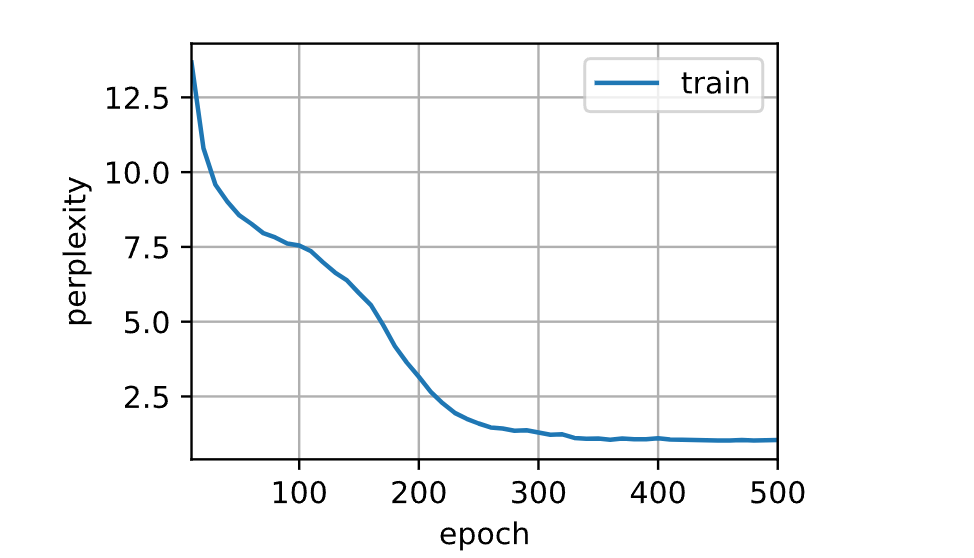

现在,我们训练循环神经网络模型。因为我们在数据集中只使⽤了10000个词元,所以模型需要更多的迭代周期来更好地收敛。

num_epochs, lr = 500, 1

train_ch8(net, train_iter, vocab, lr, num_epochs, d2l.try_gpu())

困惑度 1.0, 43332.2 标记/秒 cuda:0

time travelleryou can show black is white by argument said filby

travelleryou can show black is white by argument said filby

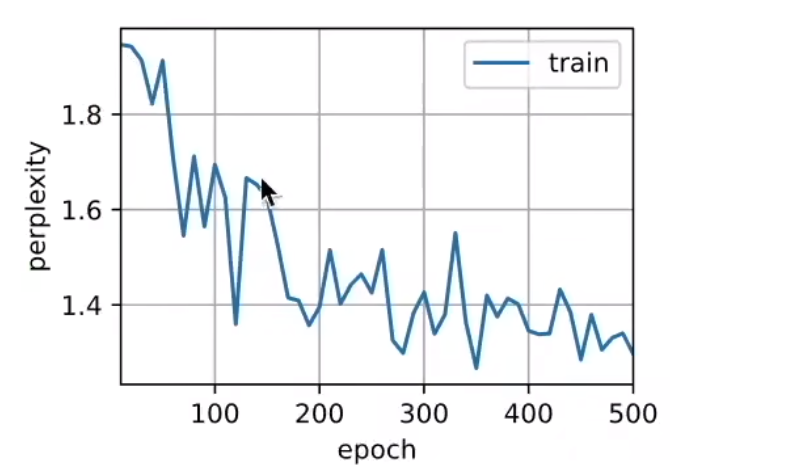

最后,让我们检查⼀下使⽤随机抽样⽅法的结果。

也就是在文章中不连着的,随机取样。上一个和下一个没有关系,随机取样。然后困惑度会高一点,训练更加难一点。其实也没有什么区别,因为这个文本太小了。

net = RNNModelScratch(len(vocab), num_hiddens, d2l.try_gpu(), get_params,

init_rnn_state, rnn)

train_ch8(net, train_iter, vocab, lr, num_epochs, d2l.try_gpu(),

use_random_iter=True)

困惑度 1.4, 70725.7 词元/秒 cuda:0

time travellerit s against reason said filbywhan seane of the fi

travellerit s against reason said filbywhan seane of the fi

• 我们可以训练⼀个基于循环神经网络的字符级语言模型,根据用户提供的文本的前缀生成后续文本。

• 一个简单的循环神经网络语言模型包括输入编码、循环神经网络模型和输出生成。

• 循环神经网络模型在训练以前需要初始化状态,不过随机抽样和顺序划分使用初始化方法不同。

• 当使用顺序划分时,我们需要分离梯度以减少计算量。

• 在进行任何预测之前,模型通过预热期进行自我更新(例如,获得比初始值更好的隐状态)。

• 梯度裁剪可以防止梯度爆炸,但不能应对梯度消失。

循环神经网络的简洁实现

加载数据

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2l

batch_size, num_steps = 32, 35

train_iter, vocab = d2l.load_data_time_machine(batch_size, num_steps)

定义模型

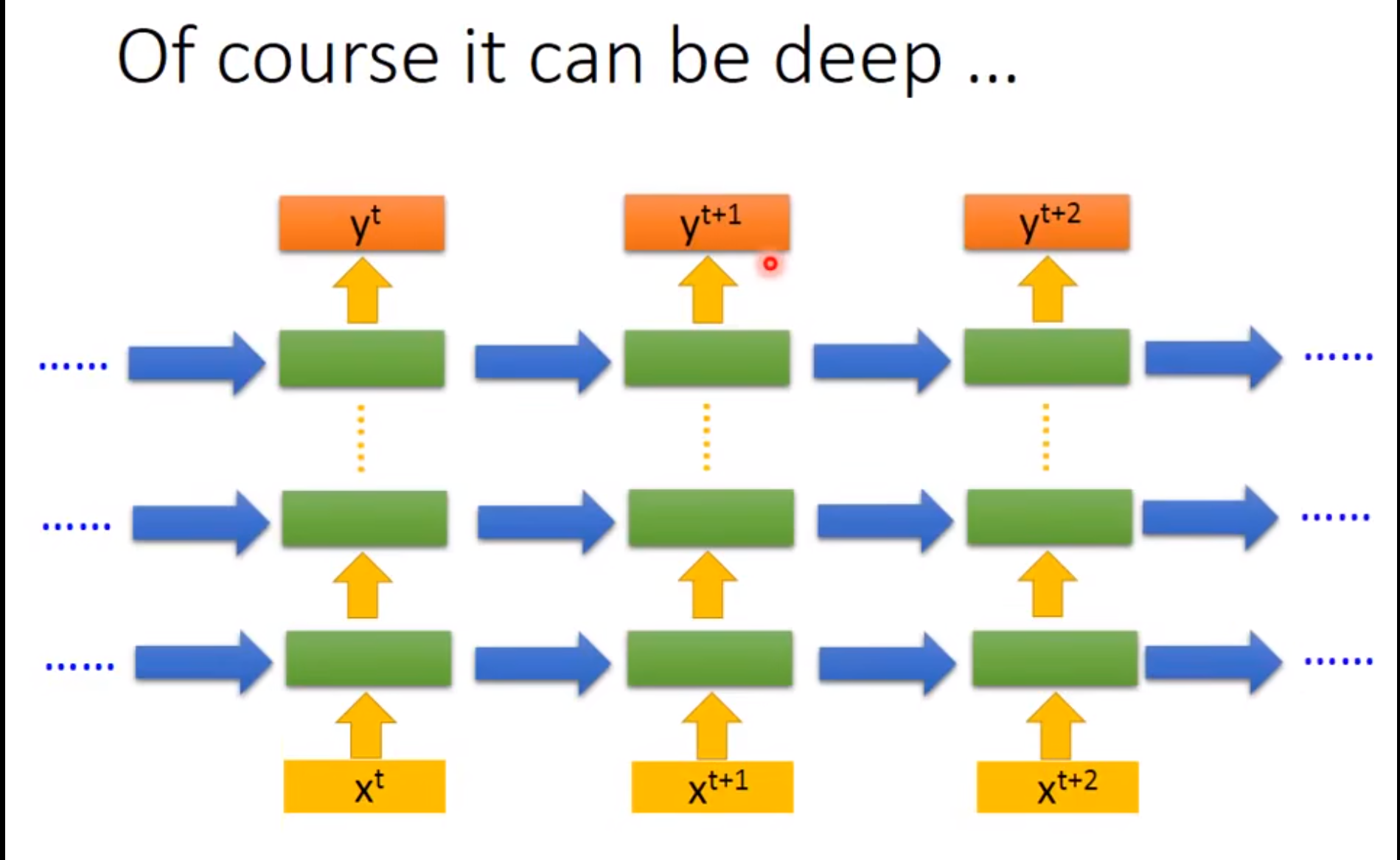

高级API提供了循环神经网络的实现。我们构造⼀个具有256个隐藏单元的单隐藏层的循环神经网络层rnn_layer。事实上,我们还没有讨论多层循环神经网络的意义。现在仅需要将多层理解为⼀层循环神经网络的输出被用作下⼀层循环神经网络的输入就足够了。

num_hiddens = 256

rnn_layer = nn.RNN(len(vocab), num_hiddens)

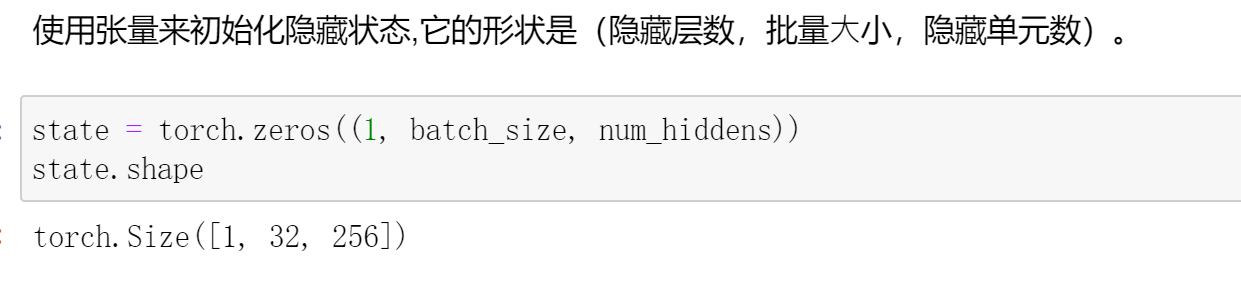

我们使用张量来初始化隐状态,它的形状是(隐藏层数,批量⼤小,隐藏单元数)。

state = torch.zeros((1, batch_size, num_hiddens))

state.shape

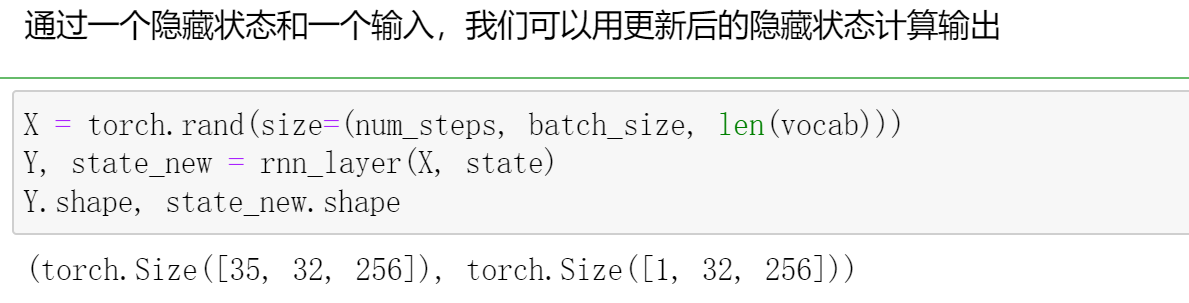

通过⼀个隐状态和⼀个输入,我们就可以用更新后的隐状态计算输出。需要强调的是,rnn_layer的“输出”(Y)不涉及输出层的计算:它是指每个时间步的隐状态,这些隐状态可以用作后续输出层的输入。

# 通过一个隐藏状态和一个输入,我们可以用更新后的隐藏状态计算输出

X = torch.rand(size=(num_steps, batch_size, len(vocab)))

Y, state_new = rnn_layer(X, state)

Y.shape, state_new.shape

# (torch.Size([35, 32, 256]), torch.Size([1, 32, 256]))

# 返回的是(时间,批量,输出)

我们为⼀个完整的循环神经⽹络模型定义了⼀个RNNModel类。注意,rnn_layer只包含隐藏的循环层,我们还需要创建⼀个单独的输出层。这里我们输出层用了一个全连接层,num_hiddens=>vocab_size,也就是self.linear = nn.Linear(self.num_hiddens, self.vocab_size)

class RNNModel(nn.Module):

"""循环神经网络模型。"""

def __init__(self, rnn_layer, vocab_size, **kwargs):

super(RNNModel, self).__init__(**kwargs)

self.rnn = rnn_layer

self.vocab_size = vocab_size

self.num_hiddens = self.rnn.hidden_size

# 如果RNN是双向的(之后将介绍),num_directions应该是2,否则应该是1

if not self.rnn.bidirectional:

self.num_directions = 1

self.linear = nn.Linear(self.num_hiddens, self.vocab_size)

else:

self.num_directions = 2

self.linear = nn.Linear(self.num_hiddens * 2, self.vocab_size)

def forward(self, inputs, state):

X = F.one_hot(inputs.T.long(), self.vocab_size)

X = X.to(torch.float32)

Y, state = self.rnn(X, state)

# 全连接层⾸先将Y的形状改为(时间步数*批量⼤⼩,隐藏单元数),因为这里没有输出层,所以我们用一个全连接层

#全连接层就是(num_hiddens=> vocab_size)

# 它的输出形状是(时间步数*批量⼤⼩,词表⼤⼩)。

output = self.linear(Y.reshape((-1, Y.shape[-1])))

return output, state

def begin_state(self, device, batch_size=1):

if not isinstance(self.rnn, nn.LSTM):

# nn.GRU以张量作为隐状态

return torch.zeros((self.num_directions * self.rnn.num_layers,

batch_size, self.num_hiddens), device=device)

else:

# nn.LSTM以元组作为隐状态

return (torch.zeros((self.num_directions * self.rnn.num_layers,

batch_size, self.num_hiddens),

device=device),

torch.zeros((self.num_directions * self.rnn.num_layers,

batch_size, self.num_hiddens),

device=device))

训练与预测

在训练模型之前,让我们基于⼀个具有随机权重的模型进行预测。

device = d2l.try_gpu()

net = RNNModel(rnn_layer, vocab_size=len(vocab))

net = net.to(device)

d2l.predict_ch8('time traveller', 10, net, vocab, device)

'time travelleruuuuuuuuuu'

很明显,这种模型根本不能输出好的结果。接下来,我们定义的超参数调⽤train_ch8,并且使用高级API训练模型

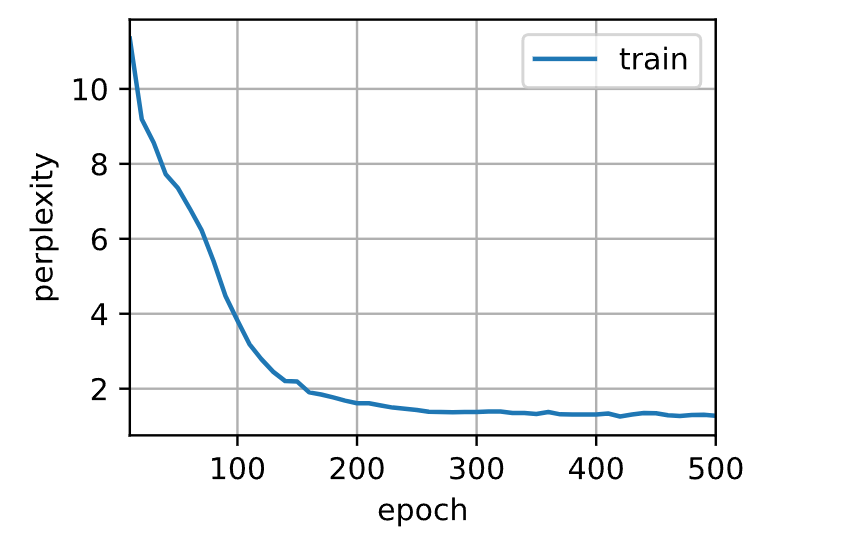

num_epochs, lr = 500, 1

d2l.train_ch8(net, train_iter, vocab, lr, num_epochs, device)

perplexity 1.3, 321771.4 tokens/sec on cuda:0

time traveller trme the limine said the time travellerit would b

traveller throf has it and pind foimon in a forenty timple

• 高级API的循环神经⽹络层返回⼀个输出和⼀个更新后的隐状态,我们还需要计算整个模型的输出层。

• 相⽐从零开始实现的循环神经⽹络,使⽤⾼级API实现可以加速训练。

ps:注意这里预测的是字符而不是单词,因为单词太多了,而字符就26个英文字母+空格和None

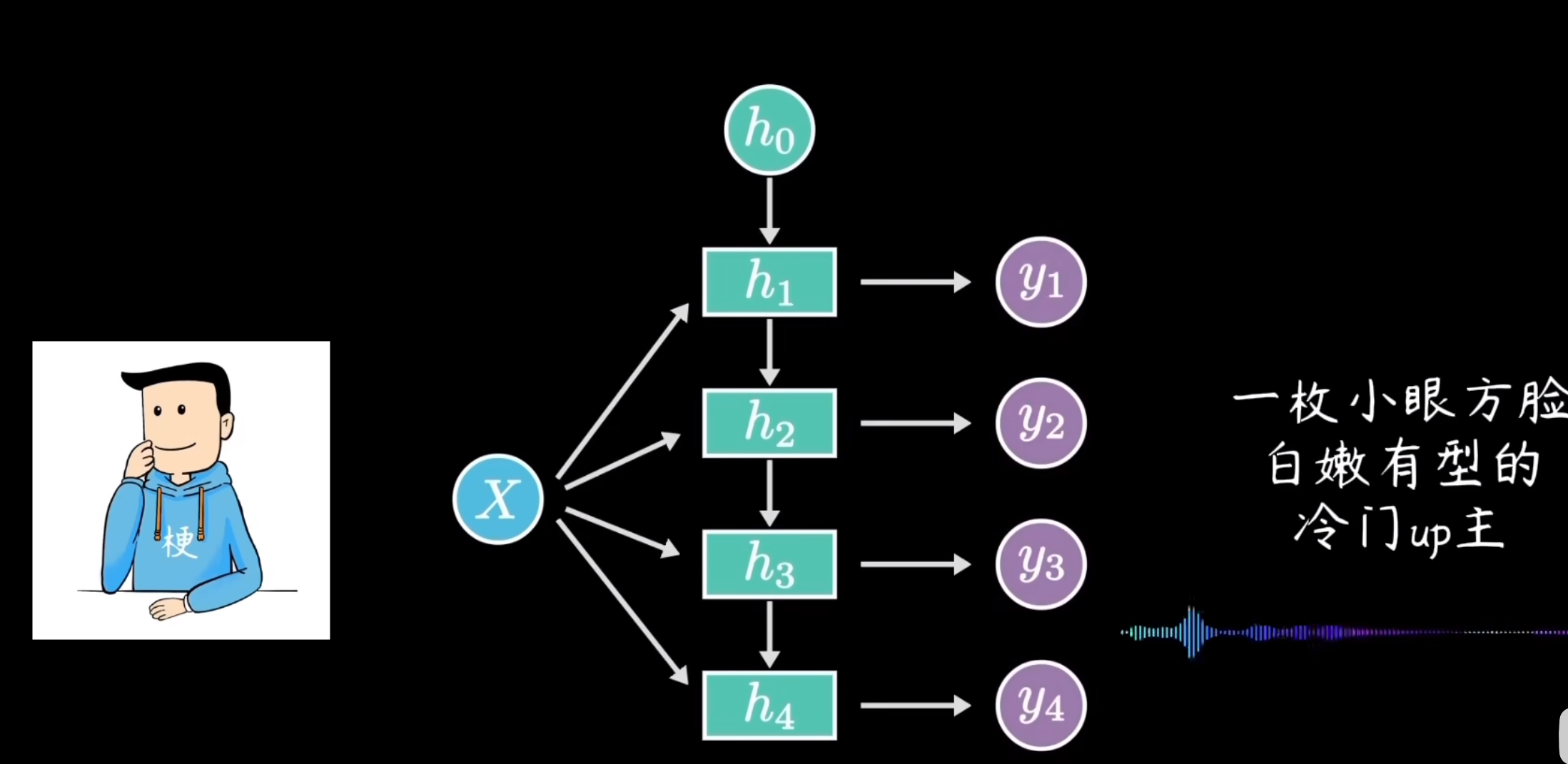

李宏毅的一个图片理解一下RNN

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· 阿里巴巴 QwQ-32B真的超越了 DeepSeek R-1吗?

· 如何调用 DeepSeek 的自然语言处理 API 接口并集成到在线客服系统

· 【译】Visual Studio 中新的强大生产力特性

· 2025年我用 Compose 写了一个 Todo App