TensorFlow09 神经网络-动量、学习率(优化网络的技巧)

▪ momentum(动量,惯性)

▪ learning rate decay

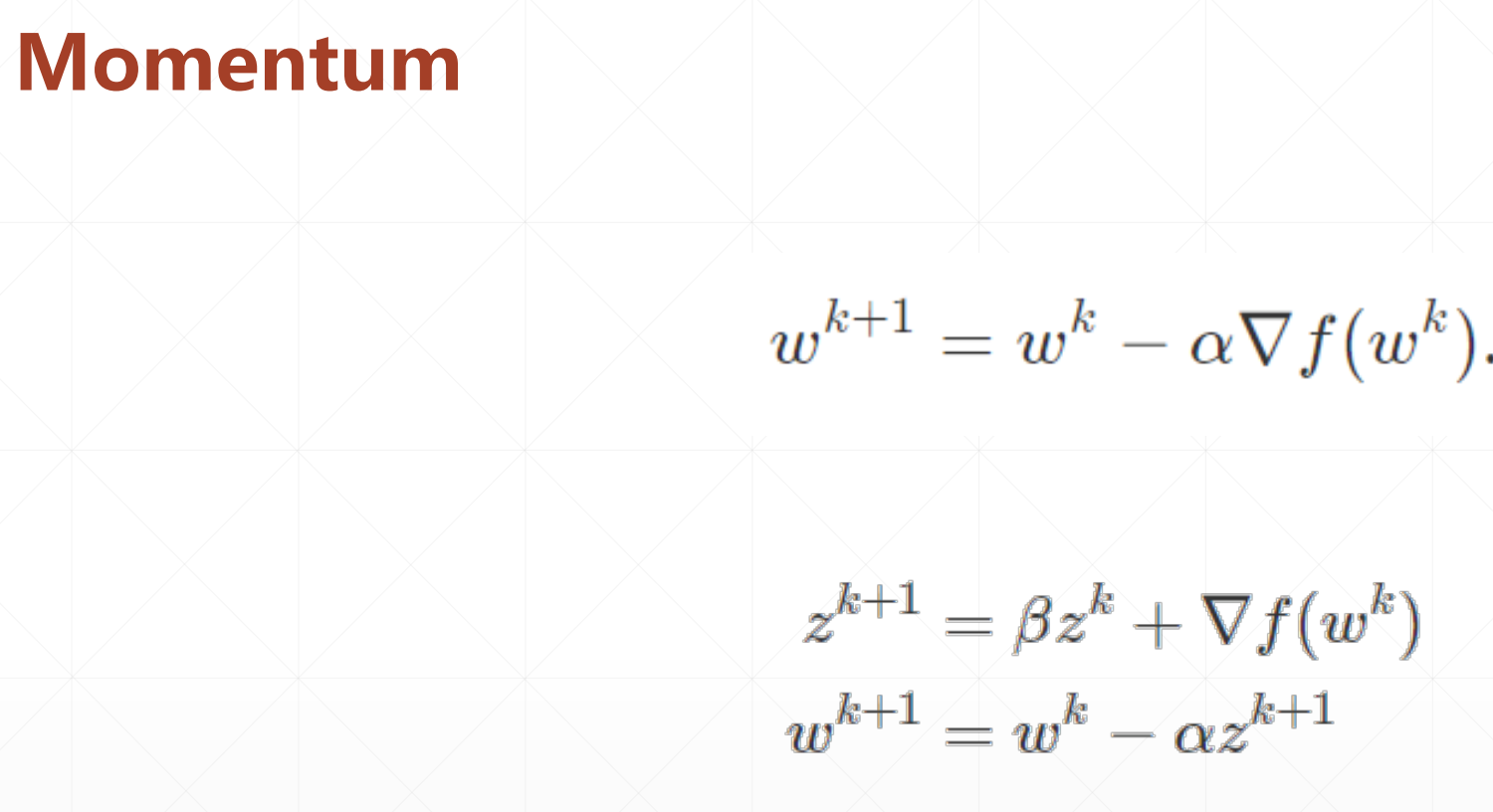

1 momentum

分析这个公式,我们新的位置不仅考率了其梯度,还考虑了它上一次的位置。

我们这里有两种情况:

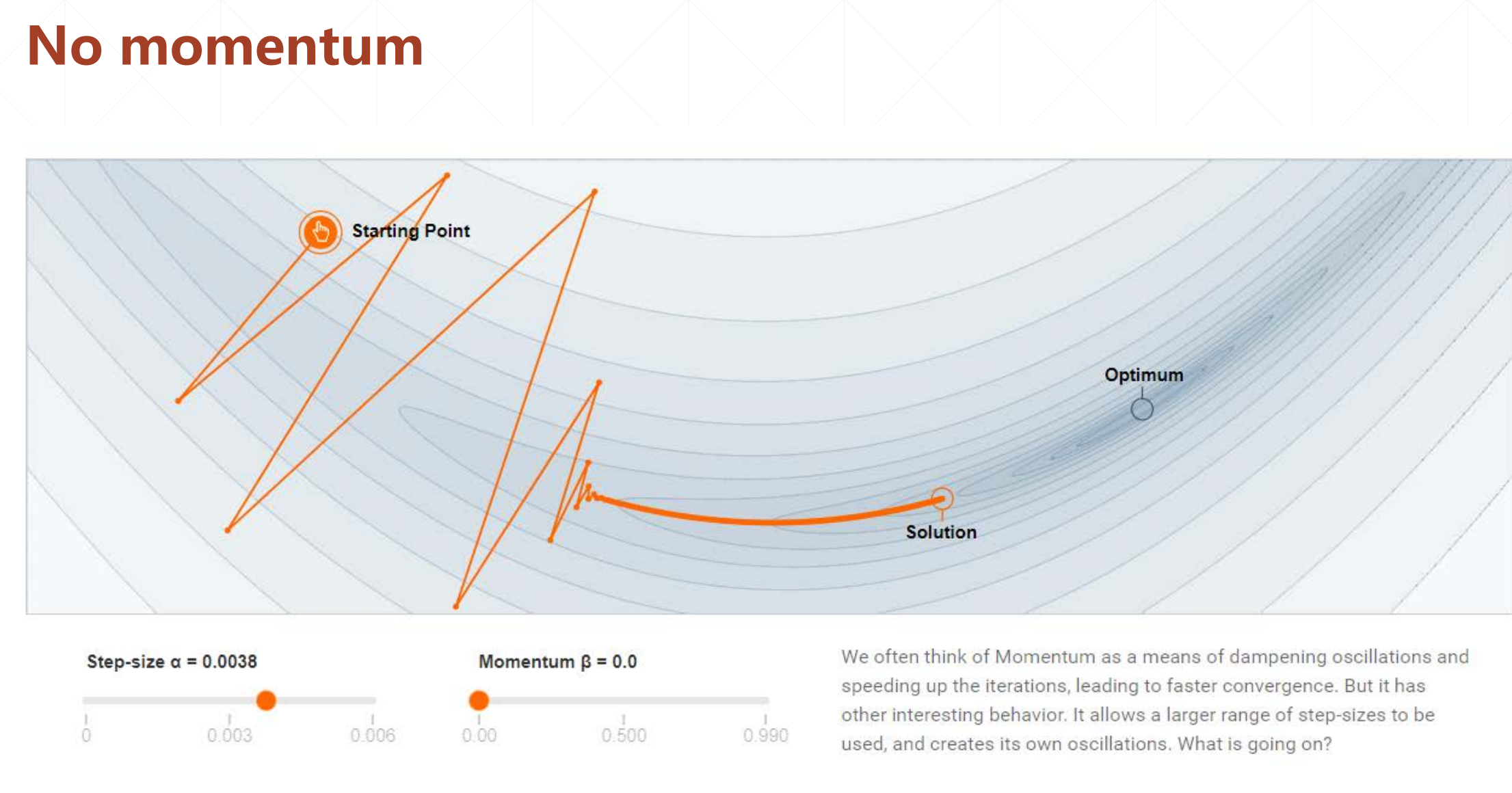

1。没有动能

我们发现它只是找到了极小值

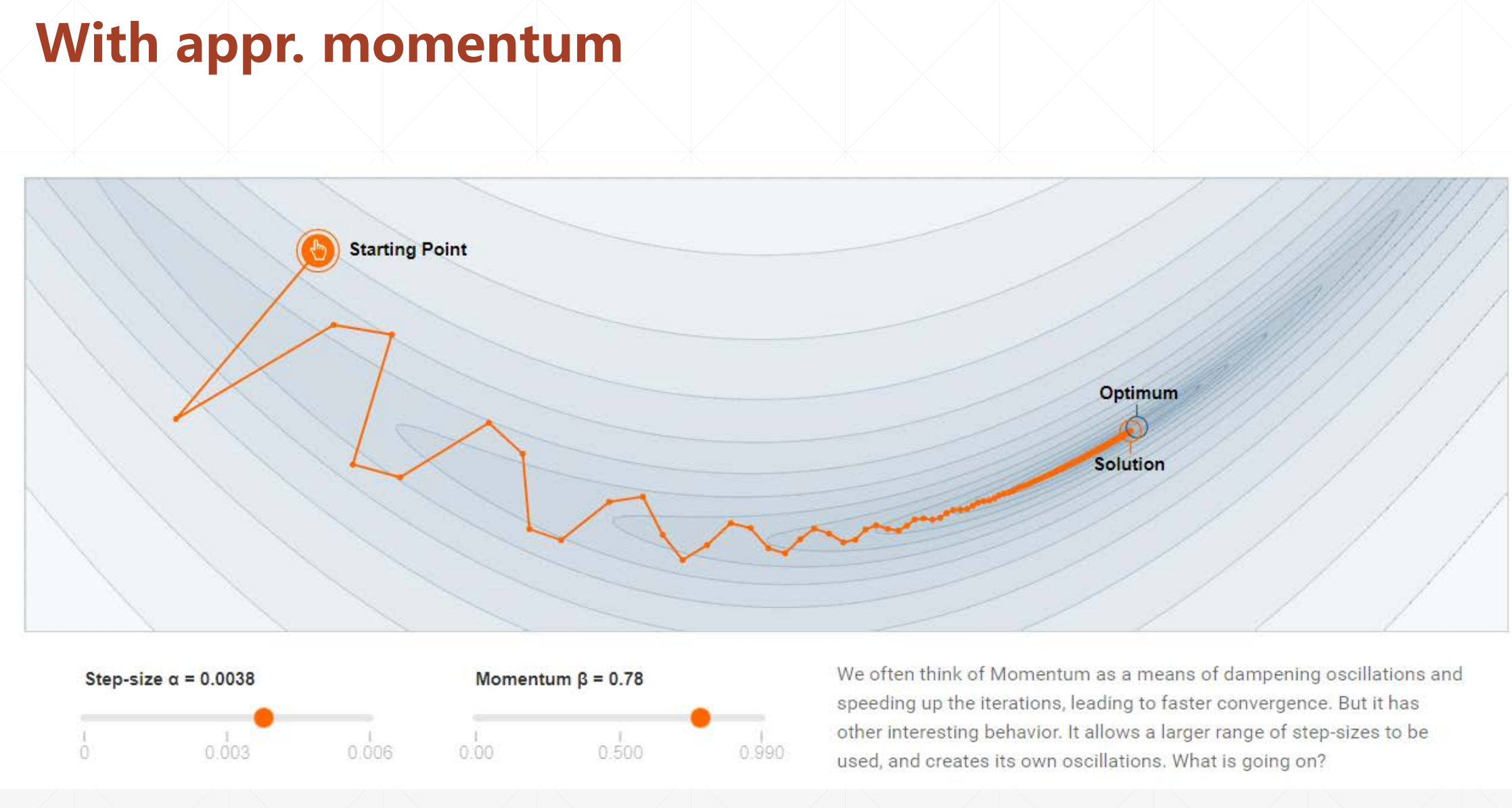

2。有动能

这个最主要的是我们发现它能找到最小值,因为它有一个动能,我们找到极小值之后我们不会立马停止,因为他有动能。

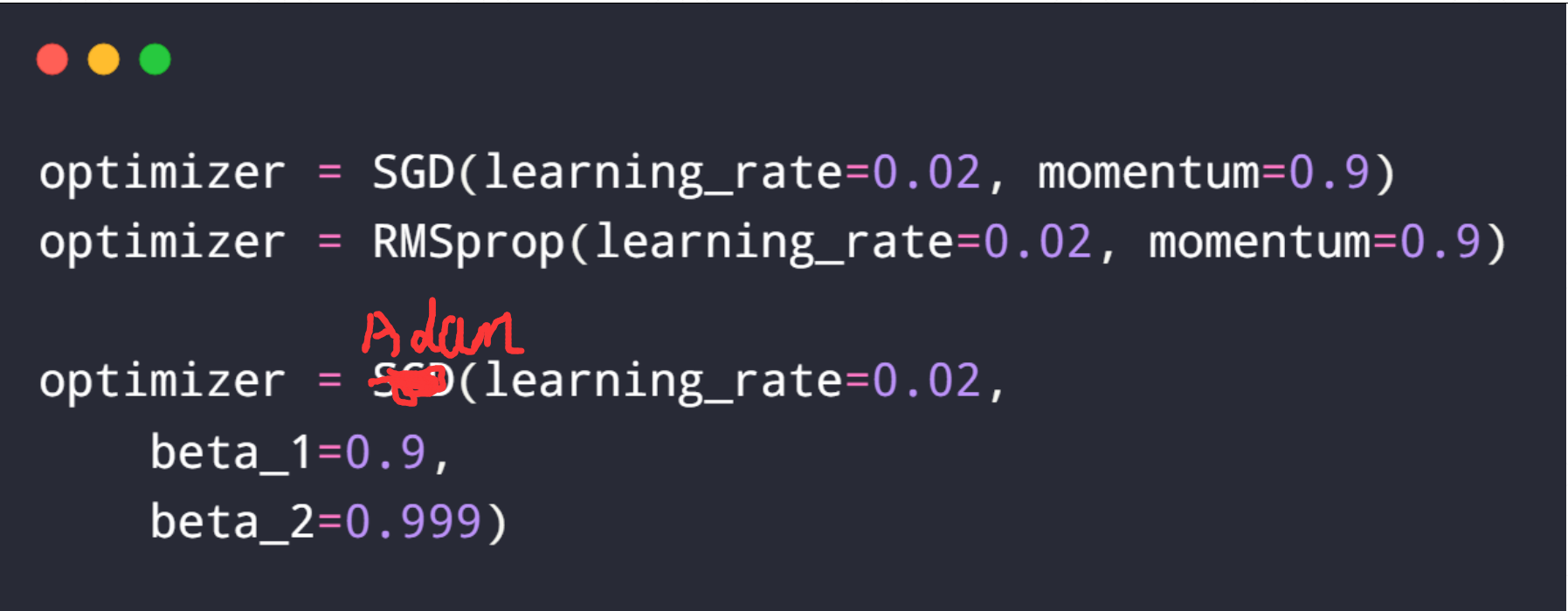

实现:

我们比较常见的momentum=0.9

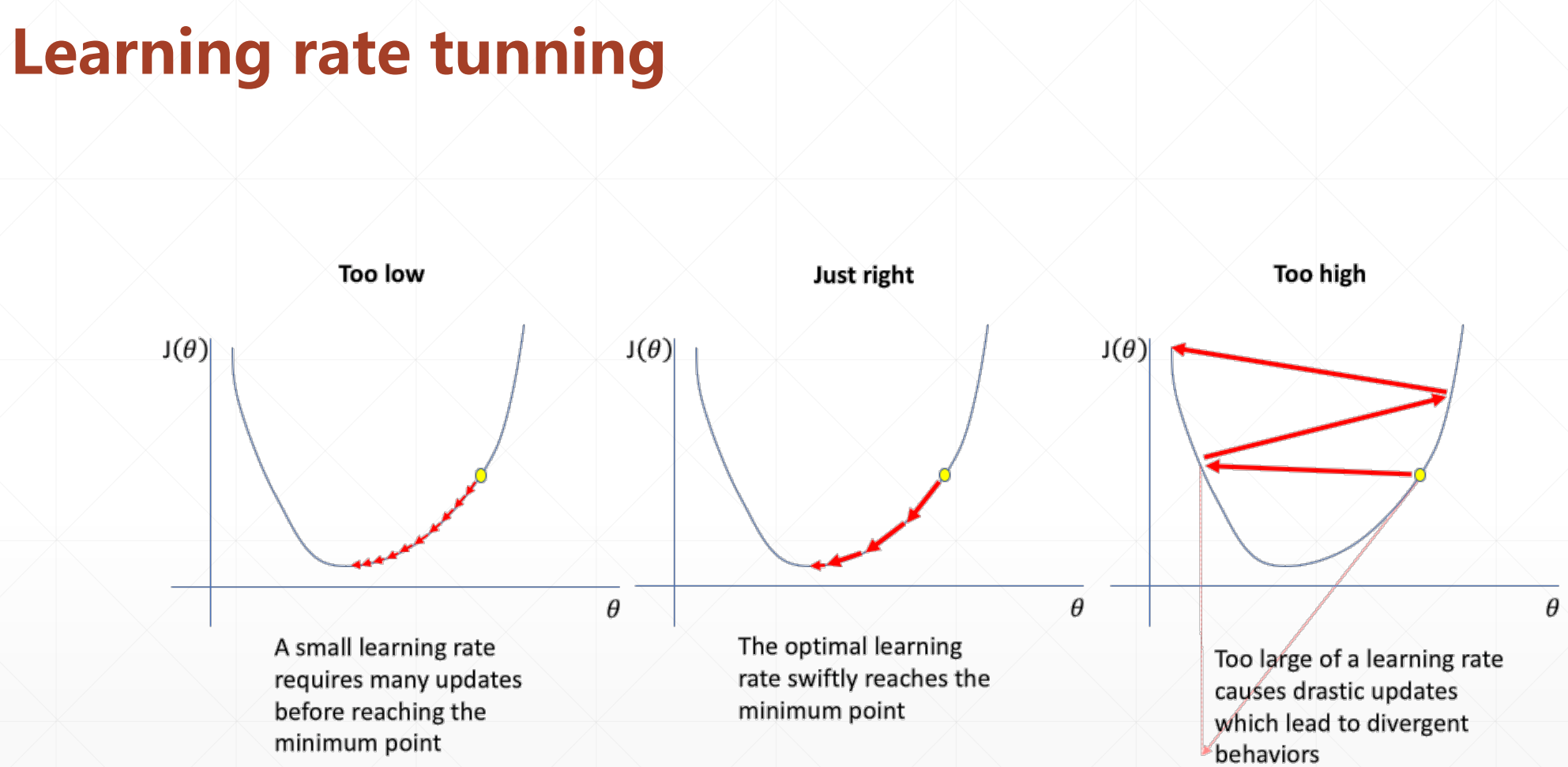

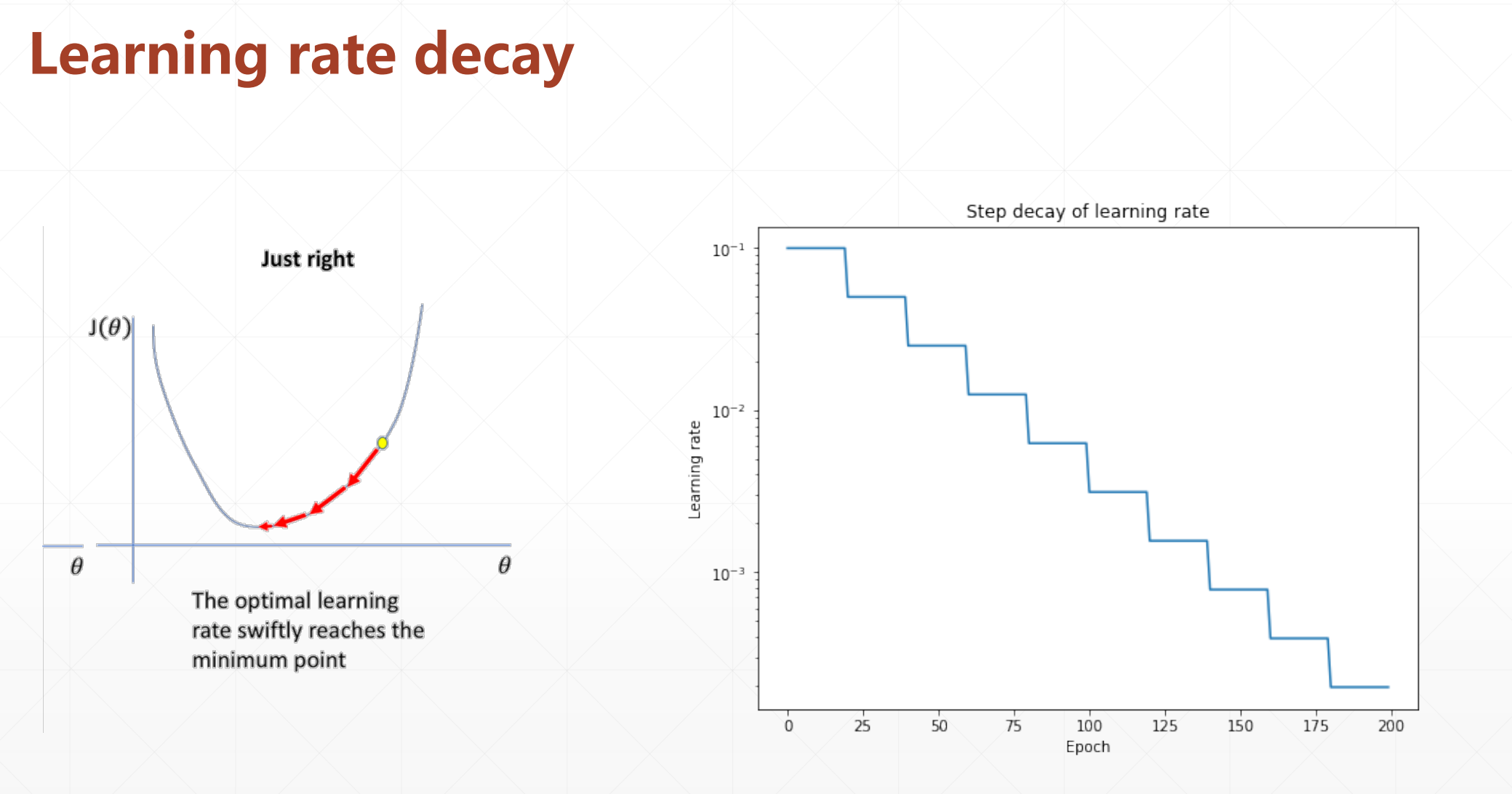

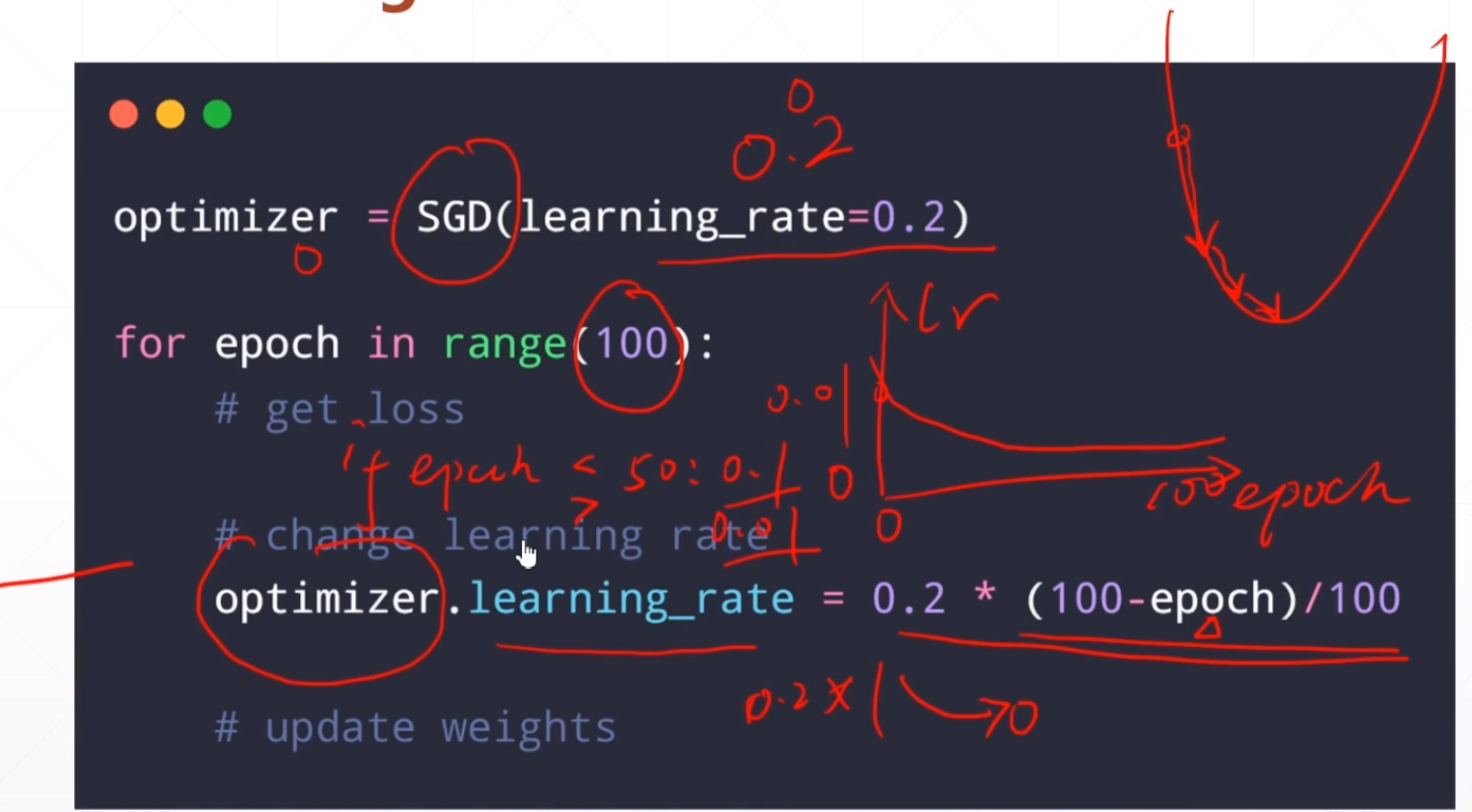

2 learning rate decay

learning rate decay

我们这里讨论的动态的learining rate。

在这里我们就是希望我们的learning rate在开始的时候可以大一点,但是随着epoch的增大让他的学习率更大一点。

浙公网安备 33010602011771号

浙公网安备 33010602011771号