随笔分类 - 深度学习&机器学习&机器学习 / 深度学习-TensorFlow

摘要:# Tokenizer Tokenizer可以将文本进行向量化: 将每个文本转化为一个整数序列(每个整数都是词典中标记的索引); 或者将其转化为一个向量,其中每个标记的系数可以是二进制值、词频、TF-IDF权重等 ``` keras.preprocessing.text.Tokenizer(num_

阅读全文

摘要:# 1 数据介绍  首先看看这个数据,是从2005年到2008年的每一个小时的电力消耗值。 # 2 实现

阅读全文

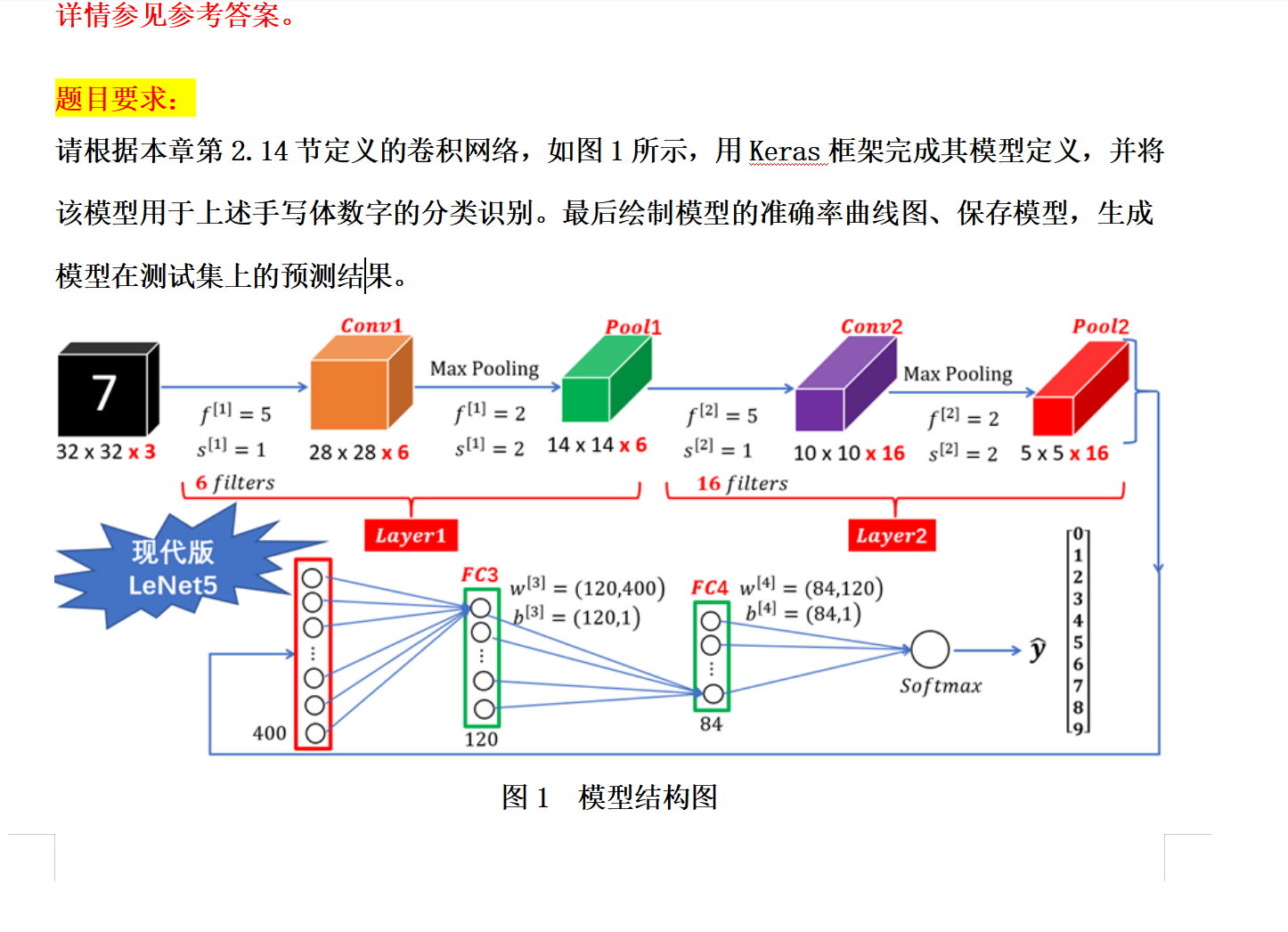

摘要:# 1.手写数字识别   要想实现这个结构有两种方案: Simpl

阅读全文

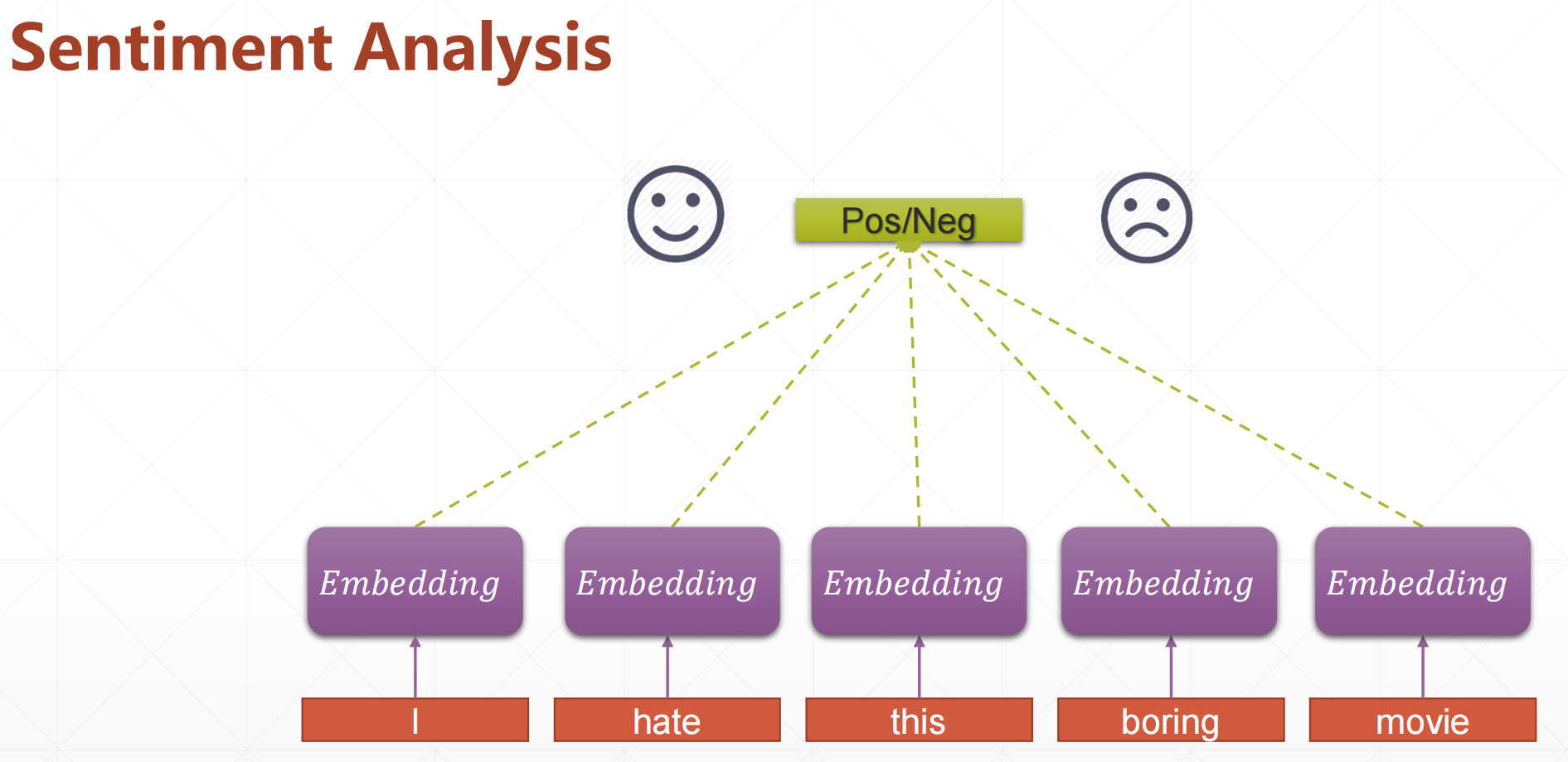

摘要:# 循环神经网络 Sentiment Analysis(情感分析)  类似于淘宝的好评还是差评,我们比较直

阅读全文

摘要:在自然界中除了位置相关的信息(图片)以外,还用一种存在非常广泛的类型,就是时间轴上的数据,比如说序列信号,语音信号,聊天文字。就是有先后顺序。 对于下面这个: 不如说我们输入有10个句子,每个句子都有4个单词,然后我们怎么把这些句子转化为具体的数值呢。如果一个表示方法能够很好的表示这个单词的特性的话

阅读全文

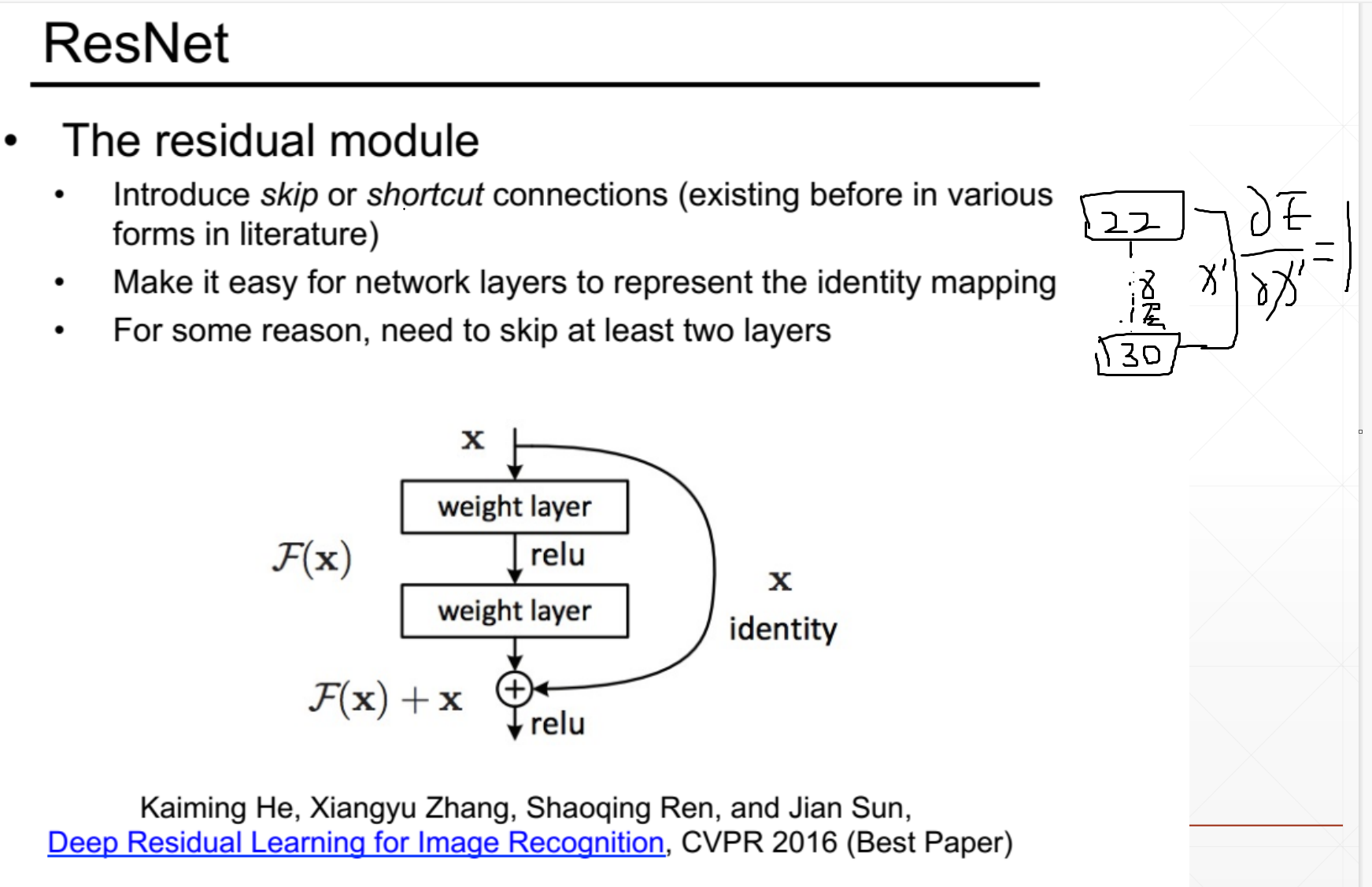

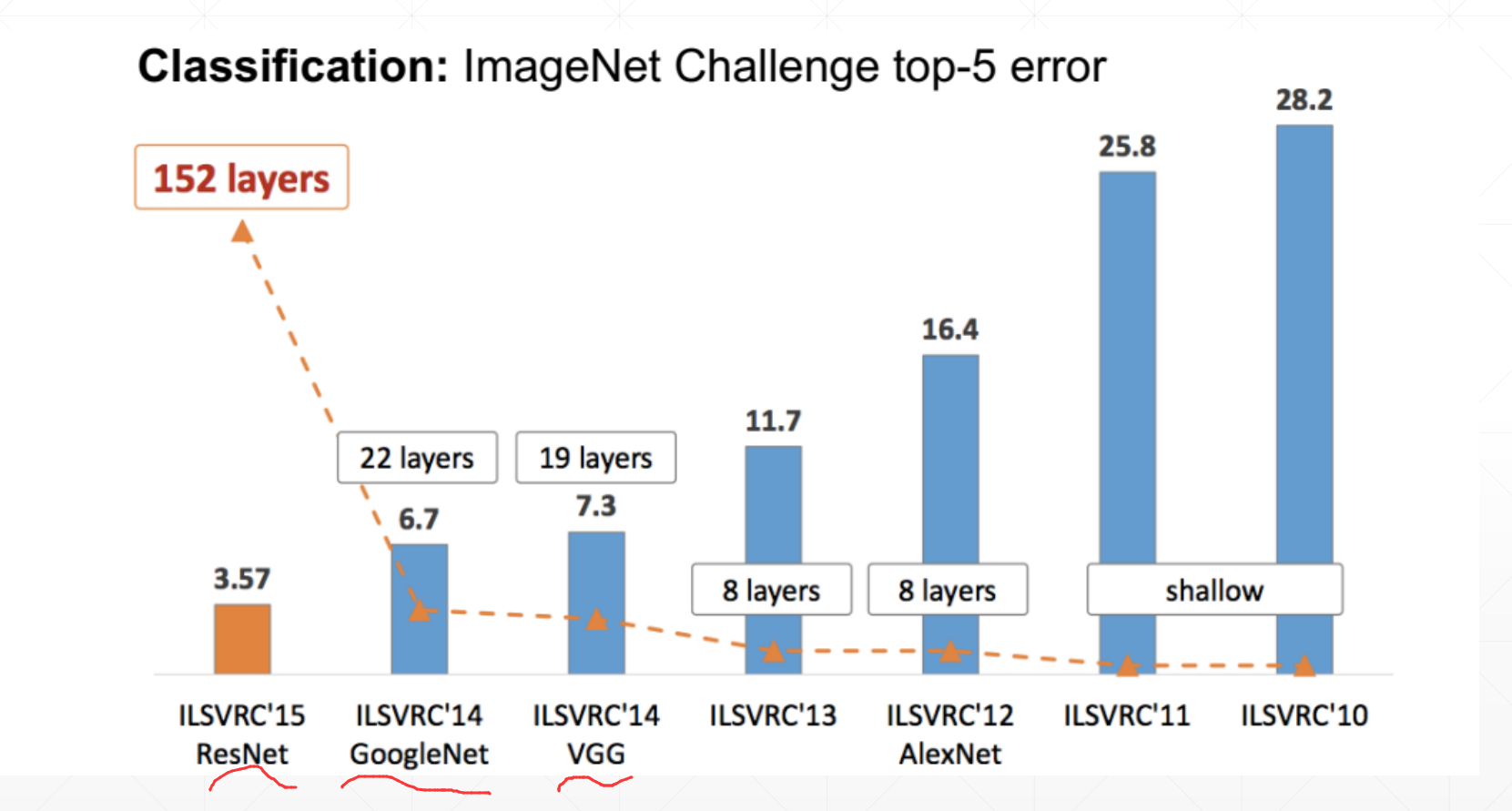

摘要:# 1 ResNet  我们是实验发现在我们堆叠更多的网络结构的时候,我们并不能又一个很好的结果,就是它

阅读全文

摘要:我们发现这个sigmoid函数在小于-4或者大于4的时候他的导数趋近于0。然后我们送进去的input的值在[-100,100]之间,这样很容易引起梯度弥散的现象。所以我们一般情况下使用ReLU函数,但是我们有时候又不得不使用sigmoid函数。这个时候我们在送到下一层的时候我们应该先经过Normal

阅读全文

摘要: # LeNet-5  ▪ Load datasets ▪ Build Network ▪ Train ▪ Test

阅读全文

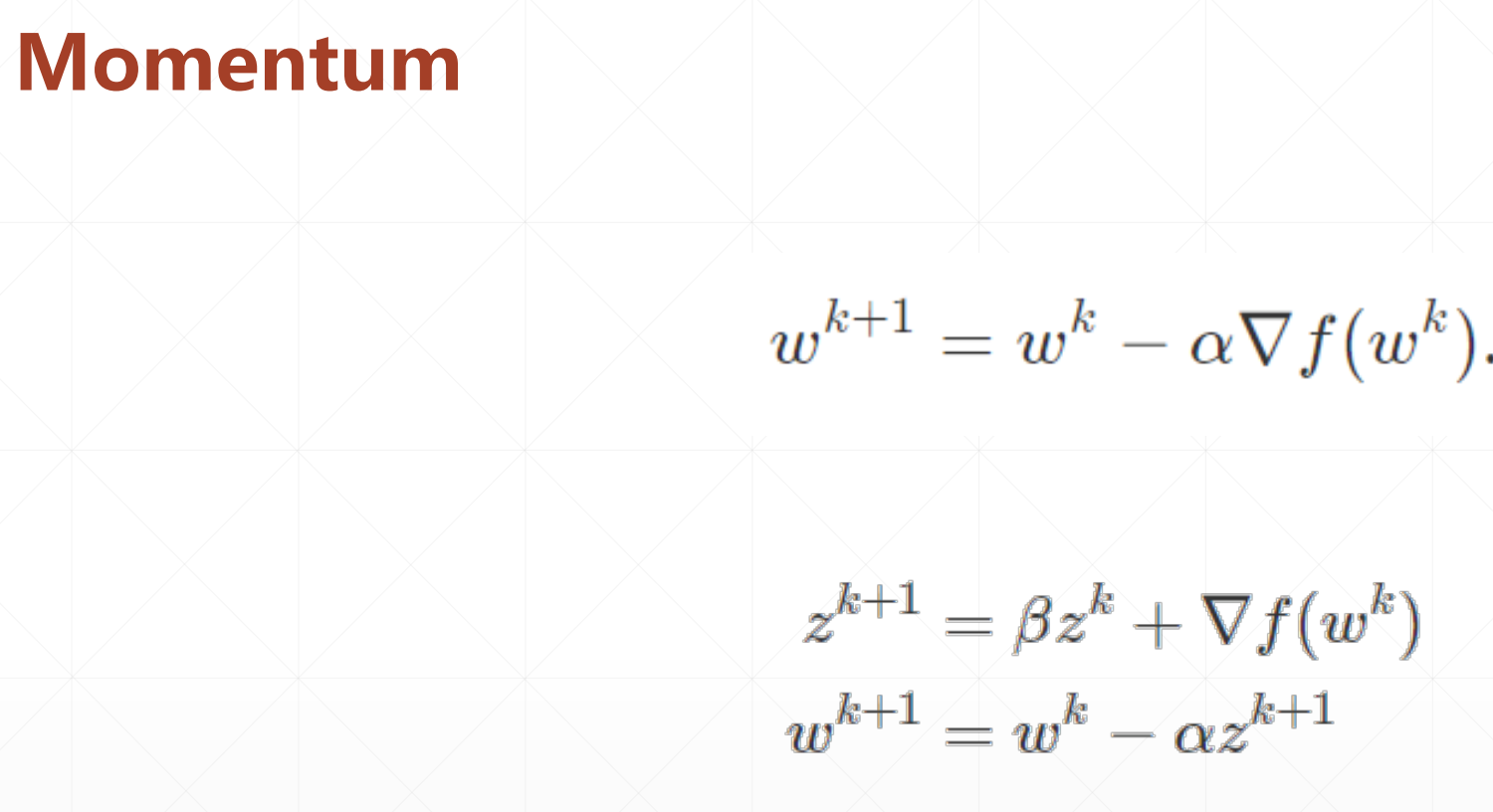

摘要:Tricks ▪ Early Stopping ▪ Dropout ▪ Stochastic Gradient Descent # 1 Early stopping 我们走到最大指的时候我们可以提交stop掉,防止它overfitting。  ▪ learning rate decay # 1 momentum  分

阅读全文

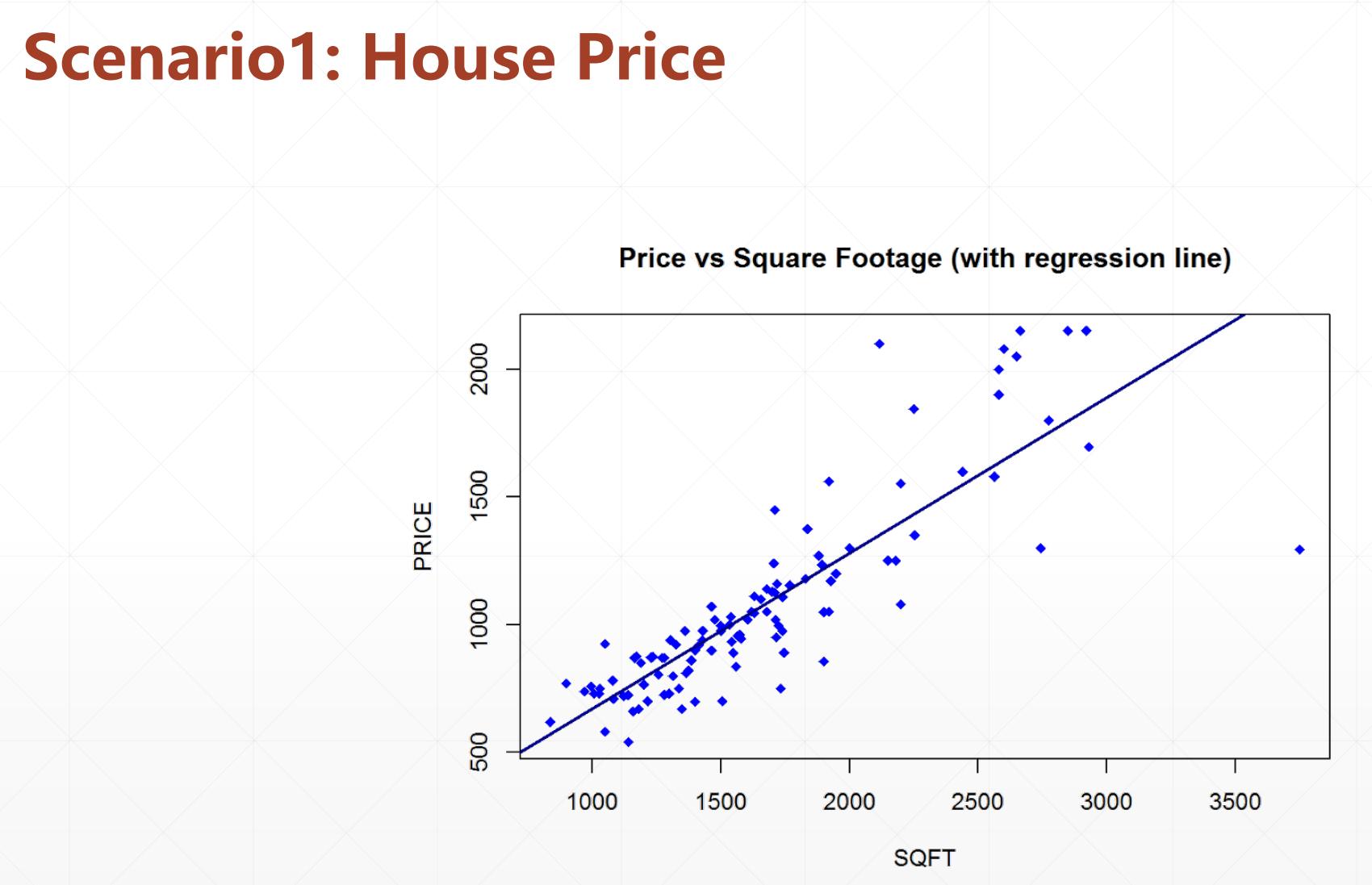

摘要:# 1 过拟合和欠拟合 线性模型  非线性模型  这个照片很模糊,大小只有[32,32],所以我们预测的结果也不是很好。 # 2 自定义

阅读全文

摘要:一般情况下有三种方式: ▪ save/load weights(只保存网络的参数,状态不管) ▪ save/load entire model(把所有的状态都保存) ▪ saved_model(交给工厂的时候可以用,可以跨语言) # 1 save/load weights 比如说你的网络里面有[w1

阅读全文

摘要:▪ keras.Sequential ▪ keras.layers.Layer ▪ keras.Model # 1 keras.Sequential