SSUL: Semantic Segmentation with Unknown Label for Exemplar-based Class-Incremental Learning 论文阅读笔记

SSUL: Semantic Segmentation with Unknown Label for Exemplar-based Class-Incremental Learning 论文阅读笔记

摘要

之前对于类增量语义分割的算法无法完全解决导致灾难性遗忘的关键问题:背景漂移以及多标签预测。因此,作者提出了SSUL,其主要贡献分为三个方面:(1) 在背景类中定义未知类以帮助学习未来类(帮助可塑性),(2)冻结主干网络和过去的分类器,使用二元交叉熵损失和伪标签来克服灾难性遗忘(帮助稳定性),(3)在CISS中首次利用小范例记忆来提高可塑性和稳定性。

提出方法

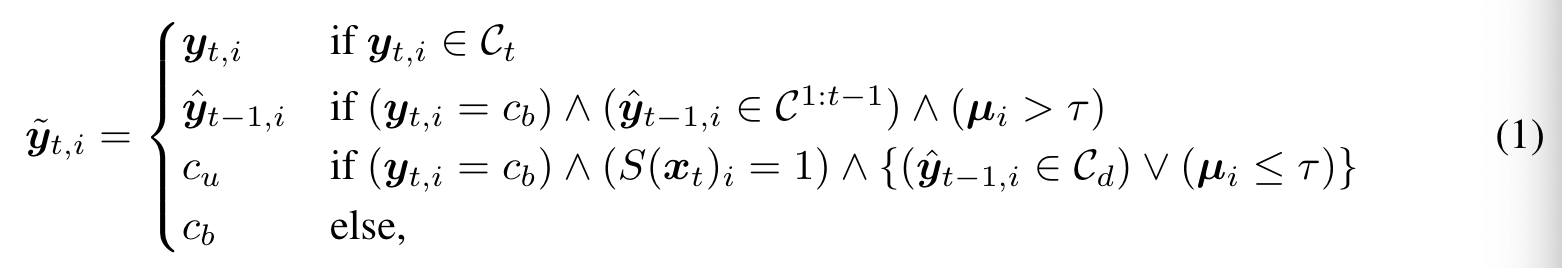

贡献1:背景类标签增强

针对当前背景中可能出现未来类对象的情况,作者提出使用一个新的未定义的类标签,用来指定不属于当前类的任何前景对象。这里作者使用了现成的显著性物体检测器对输入图像进行检测,之后对显著性但在背景中的像素分配作为标签。作者指出这个未知类标签起着至关重要的作用,这样特征提取器可以区分潜在的未来类对象和真实背景的表示。

伪标签的使用与PLOP论文类似,将伪标签(即来自先前模型的预测)分配给仅当预测为具有足够置信度的过去对象类(不包括 cb 和 cu)时背景类的像素,在此不做过多介绍。

综上,增强后的目标标签计算方式如下:

贡献2:稳定分数学习

作者发现如果单纯用增强后的目标标签训练带有softmax输出层的可能导致输出的结果非常不稳定。原因在于增强后的标签含有噪声,同时softmax是通过一种相对的方式去计算预测概率的。这对于多标签预测是一个比较严重的问题。为了应对这个问题,作者提出如下三种策略:

模型冻结

作者选择冻结特征提取层以及之前类的分类器,仅学习的卷积核滤波器以及。这可以避免灾难性遗忘,同时因为设置类,使模型的可塑性得以保持。

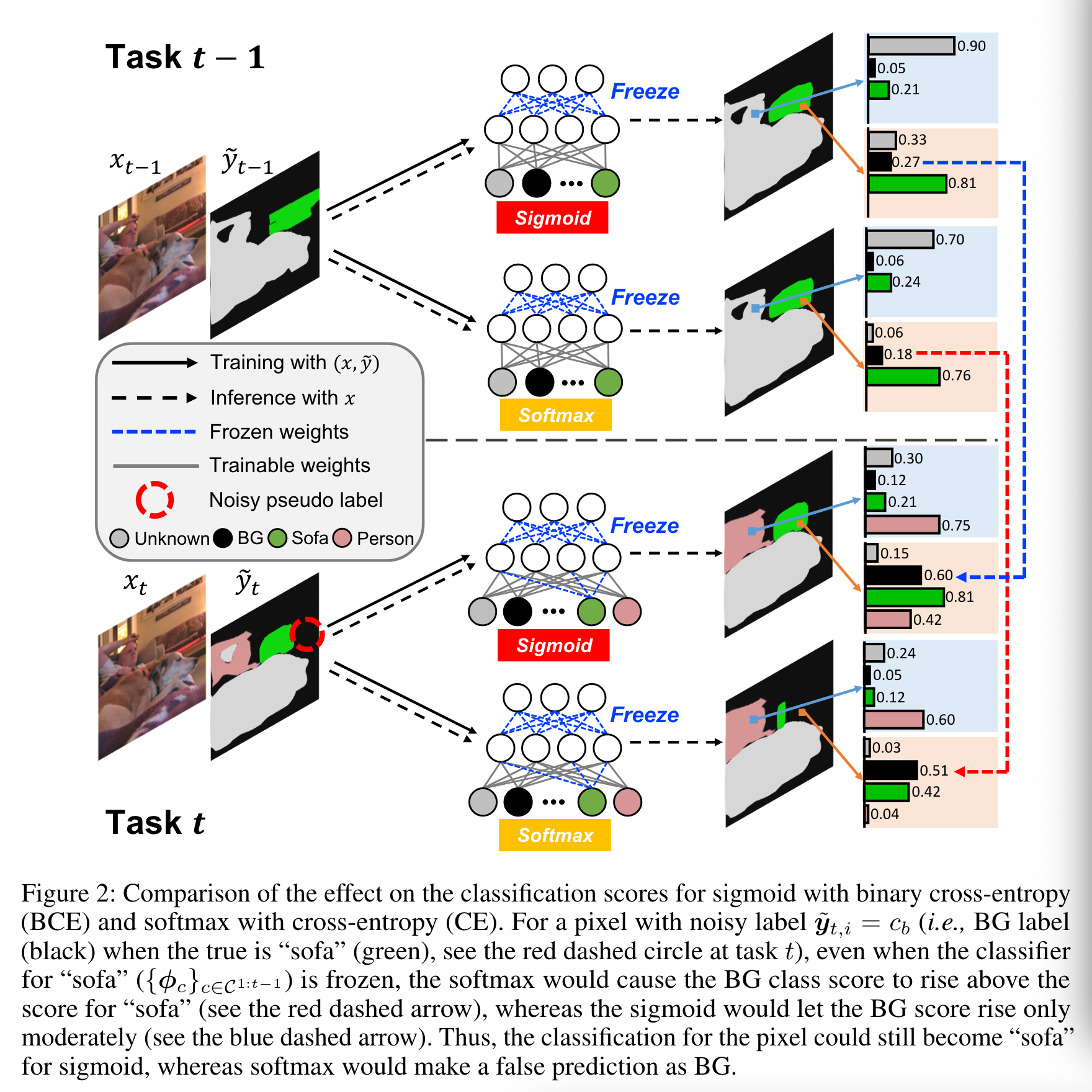

sigmoid / BCE

作者发现当模型把属于之前类的像素归类为或者时,使用softmax+交叉熵会引起灾难性遗忘的问题,因为梯度下降会使或者比更高(注意过去的类的分类器已经被冻结了)。因此,作者考虑对于每个类,独立地使用sigmoid和二元交叉熵损失函数,这样不论其他类的分数如何,背景类或者未知类的分数只会增加到一定水平。

如上图,如果一个标签含有噪声的话,即本应属于沙发的像素被错误的标记为背景,那么使用softmax+CE就会导致背景类的分数超越沙发的分数(红色虚线箭头),而sigmoid+BCE只会使背景类的分数适度增加,不至于产生很明显错误的分类结果。

未知类分类器的权重转移

使用上一个step中类的分类器初始化当前step中新类的分类器。这样可以使学习过程更加稳定,并且有一定的加速作用。

贡献3:小范例记忆

作者使用exemplar-memory来存储过去训练数据的一小部分,确保在当前的训练集中包含 C1:t-1 中每个类别的至少一个具有正确 GT 标签的样本。因为尽管设置了伪标签,有可能当前图像并不含有旧的类别,因此对于一个像素而言如果新类的置信度足够高,那么还是可能遗忘旧类的知识从而造成灾难性遗忘的现象。(这里有一个问题,之前看到说)

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· 阿里最新开源QwQ-32B,效果媲美deepseek-r1满血版,部署成本又又又降低了!

· 单线程的Redis速度为什么快?

· SQL Server 2025 AI相关能力初探

· AI编程工具终极对决:字节Trae VS Cursor,谁才是开发者新宠?

· 展开说说关于C#中ORM框架的用法!

2020-09-09 生成字符画