Res2Net学习笔记

Res2Net

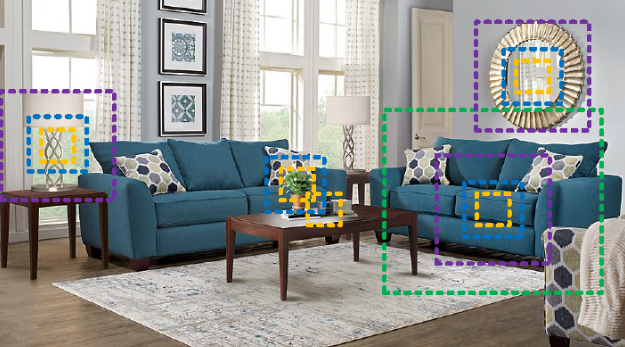

在自然场景中,视觉模式经常表现多尺寸特征。如下图所示,(1)一张图片中可能会存在不同尺寸的物体。比如,沙发及被子的大小是不同的。(2)一个物体自身的上下文信息可能会覆盖比自身更大范围的区域。比如,依赖于桌子的上下文信息,进而判断桌子上的黑色斑点是杯子还是笔筒。(3)不同尺寸的感知信息对于像细粒度分类及分割等对于理解目标物局部信息的任务十分重要。

简介

为了获得多尺寸表示能力,要求特征提取可以以较大范围的感受野来描述不同尺寸的 object/part/context。

CNN通过简单的堆叠卷积操作得到coarse-to-fine的多尺寸特征。

VGG,Alex通过简单的堆积卷积让多尺寸信息成为了可能。

Inception系列通过组合不同大小的卷积核来获得多尺寸信息。

作为backbone的CNN表现更高效,多尺寸的表征能力更强。

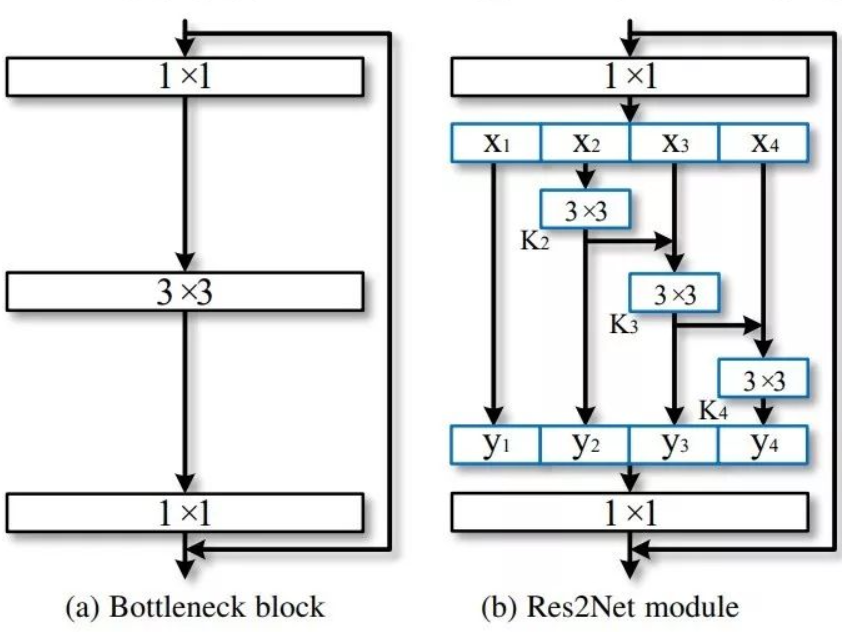

Res2Net是简单高效的多尺寸模块,不同于以前的模型提高layer-wise的多尺寸表征能力,以更精细的水平提高模型的多尺寸表征能力。

将\(3\times 3\times n\)的卷积核替换为\(3\times3\times w\)的group filters,其中,\(n = w \times s\)

更小的filter group通过类似于残差连接的方式进行连接,从而提高输出的表示数量。在计算力相同的条件下获得更强的多尺寸表征信息。

具体步骤

将输入分成几部分,一组filter从对应的一组输入feature map中提取信息。前面得到的信息送到另一组filter中作为输入。重复此操作,直到处理完所有输入feature map。最后,每组输出的feature map通过拼接操作送入1x1的卷积中用于进行特征融合。

值得注意的是,每个3x3的卷积核可以接受来自该层前面的所有分离的特征\({x_j, j\leq i}\),每次分类特征经过3x3的卷积处理后,其输出的感受野要比输入更大,由于不同的组合方式,Res2Net的输出包含不同大小及数量的感受野。