petals环境搭建

首先挂上colab网址:这里.

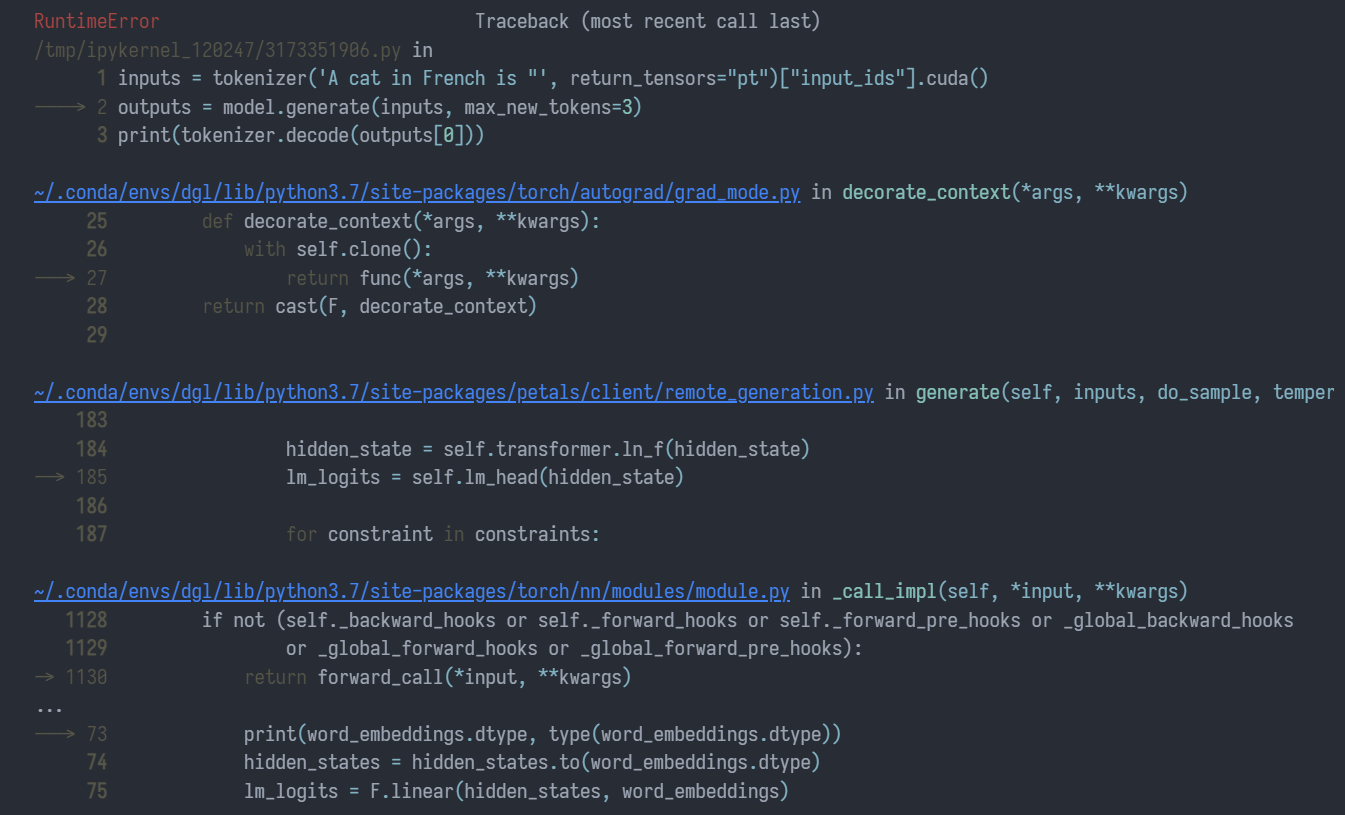

果不其然刚开始就出现了问题.

inputs = tokenizer('A cat in French is "', return_tensors="pt")["input_ids"].cuda()

outputs = model.generate(inputs, max_new_tokens=3)

print(tokenizer.decode(outputs[0]))

报错是:RuntimeError: at::cuda::blas::gemm: not implemented for N3c108BFloat16E.简单来说,就是torch.bfloat16类型的矩阵乘在cublas中还没实现...

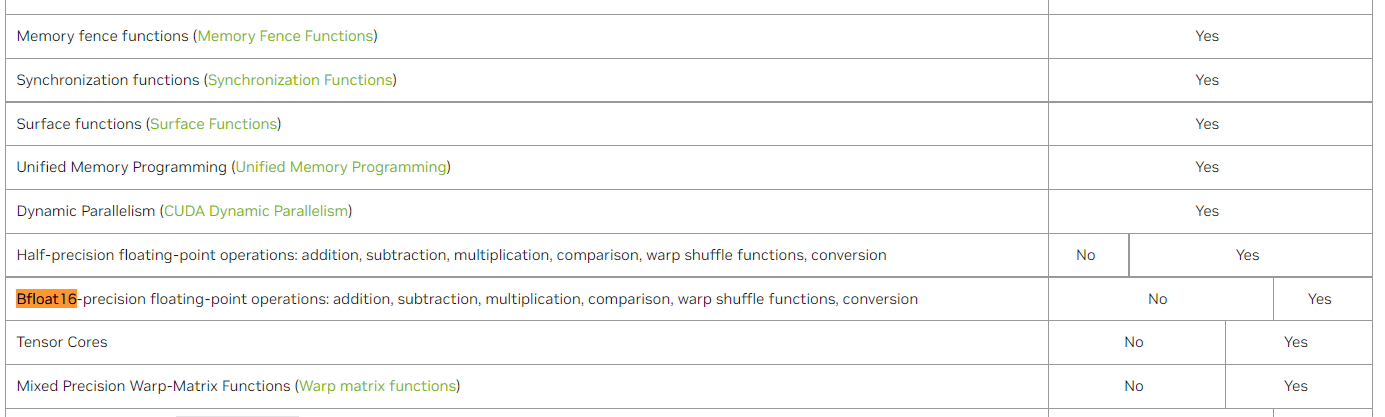

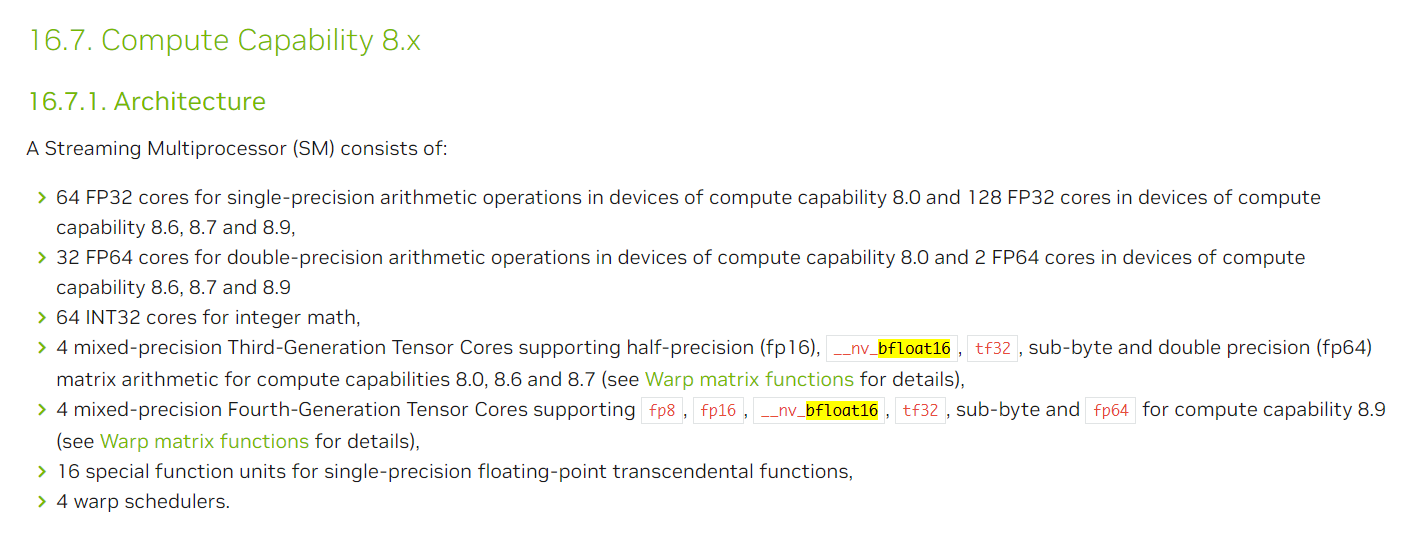

不过后来经过我的仔细搜索,在CUDA官方文档的这里发现可能是硬件的问题.如图:

另外提供一个检查cublas版本的方法:cat /usr/local/cuda/include/cublas_api.h | grep CUBLAS_VER.相信聪明的你肯定知道输出的内容是什么意思!

【推荐】国内首个AI IDE,深度理解中文开发场景,立即下载体验Trae

【推荐】编程新体验,更懂你的AI,立即体验豆包MarsCode编程助手

【推荐】抖音旗下AI助手豆包,你的智能百科全书,全免费不限次数

【推荐】轻量又高性能的 SSH 工具 IShell:AI 加持,快人一步

· winform 绘制太阳,地球,月球 运作规律

· 超详细:普通电脑也行Windows部署deepseek R1训练数据并当服务器共享给他人

· TypeScript + Deepseek 打造卜卦网站:技术与玄学的结合

· AI 智能体引爆开源社区「GitHub 热点速览」

· 写一个简单的SQL生成工具